DeepMind科学家Trask2019著作《图解深度学习》图书及代码,16章带你无障碍深度学习,高中生数学就ok

【导读】Andrew Trask 是DeepMind的科学家,同时也是OpenMinded的负责人。他著作的《Grokking Deep Learning》(《图解深度学习》),由Manning出版社出版,并采用MEAP(订阅更新方式),从2016年8月开始,一直采用不定期更新的方式放送。时至今日,这本书终于完本啦,完结撒花

《Grokking Deep Learning》(《图解深度学习》)书稿下载

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知)

后台回复“GDLB” 就可以获取《图解深度学习》的下载链接~

专知2019年1月将开设《深度学习:算法到实战》课程,欢迎关注报名!

作者简介:

Andrew Trask 博士 是DeepMind 的一位科学家,同时是他也是OpenMinded的负责人,博士毕业于牛津大学,个人主页是:https://iamtrask.github.io/

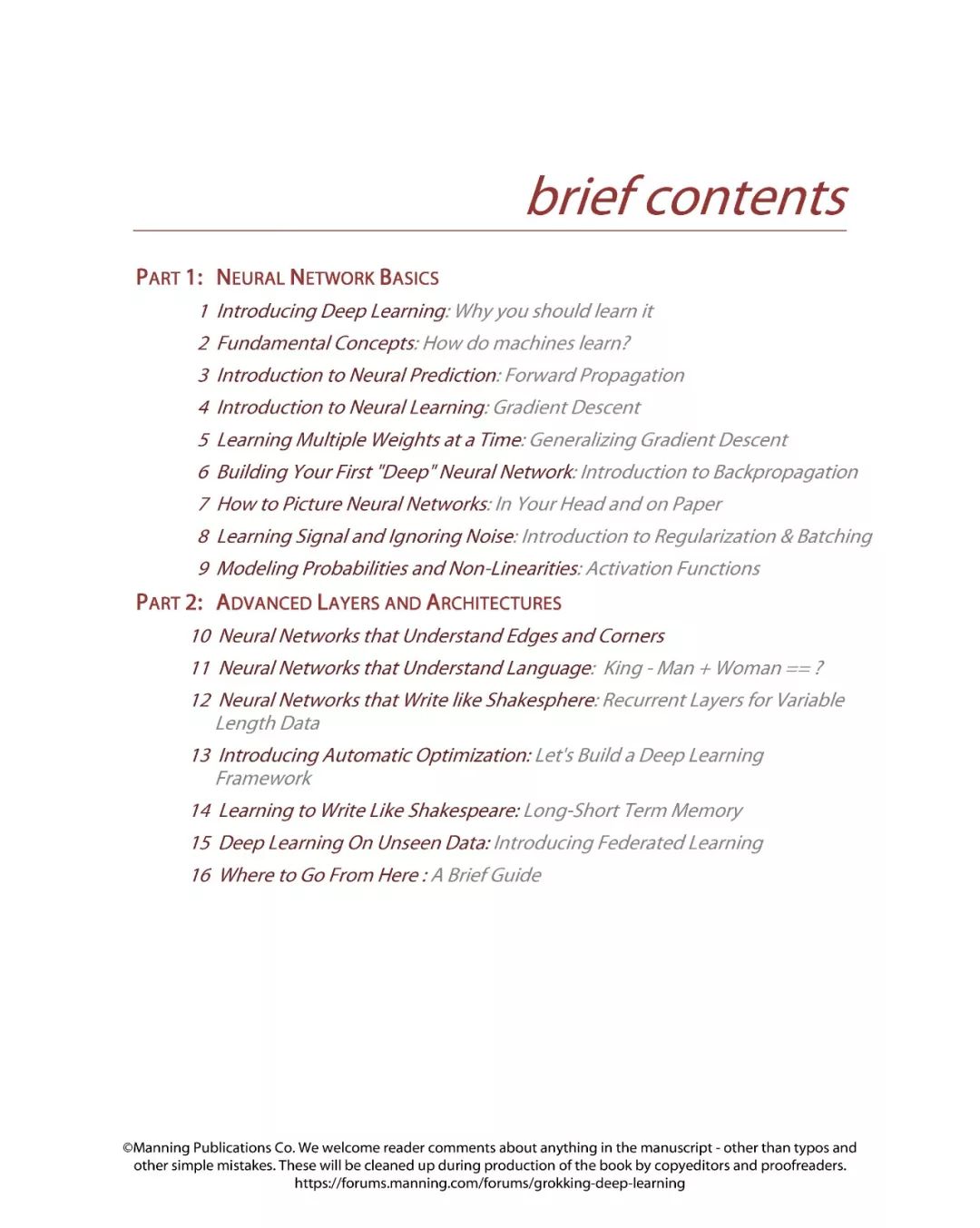

Grokking Deep Learning

人工智能是本世纪最令人兴奋的技术之一,深度学习在很多方面都是世界上最强大人工智能系统背后的“大脑”。这些系统模仿人类大脑内部的神经元行为,正迅速赶上人类创造者的智力水平,打败世界围棋冠军,在视频游戏、驾驶汽车、翻译语言、有时甚至帮助执法部门打击犯罪方面取得超人的表现。深度学习是一场正在改变全球每个行业的革命。

探索深度学习,更深入地挖掘深度学习的世界。这本书和视频组合涵盖一切,你需要真正探索这个令人兴奋的世界。

这本书将帮助您真正理解如何从头开始构建深度学习算法。你将理解深度学习是如何在比人类更高的层次上学习的。你将能够理解最先进的人工智能背后的“大脑”。此外,与其他假定具有高级微积分知识并利用复杂数学符号的课程不同,如果您是通过高中代数考试的Python黑客,那么您已经准备好了。到最后,你甚至可以造一个人工智能来学习在经典的雅达利游戏中打败你。

地址:

https://livebook.manning.com/#!/book/grokking-deep-learning/chapter-10/v-12/7

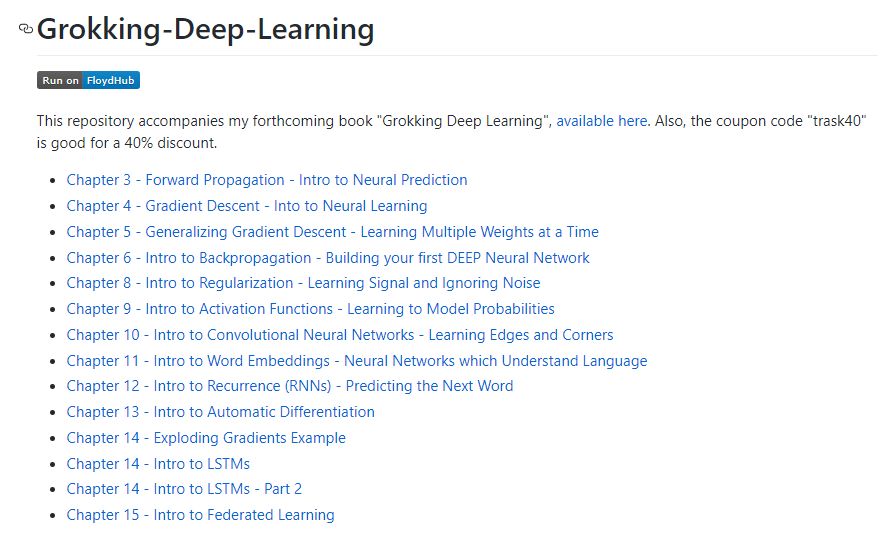

代码地址:

https://github.com/iamtrask/Grokking-Deep-Learning

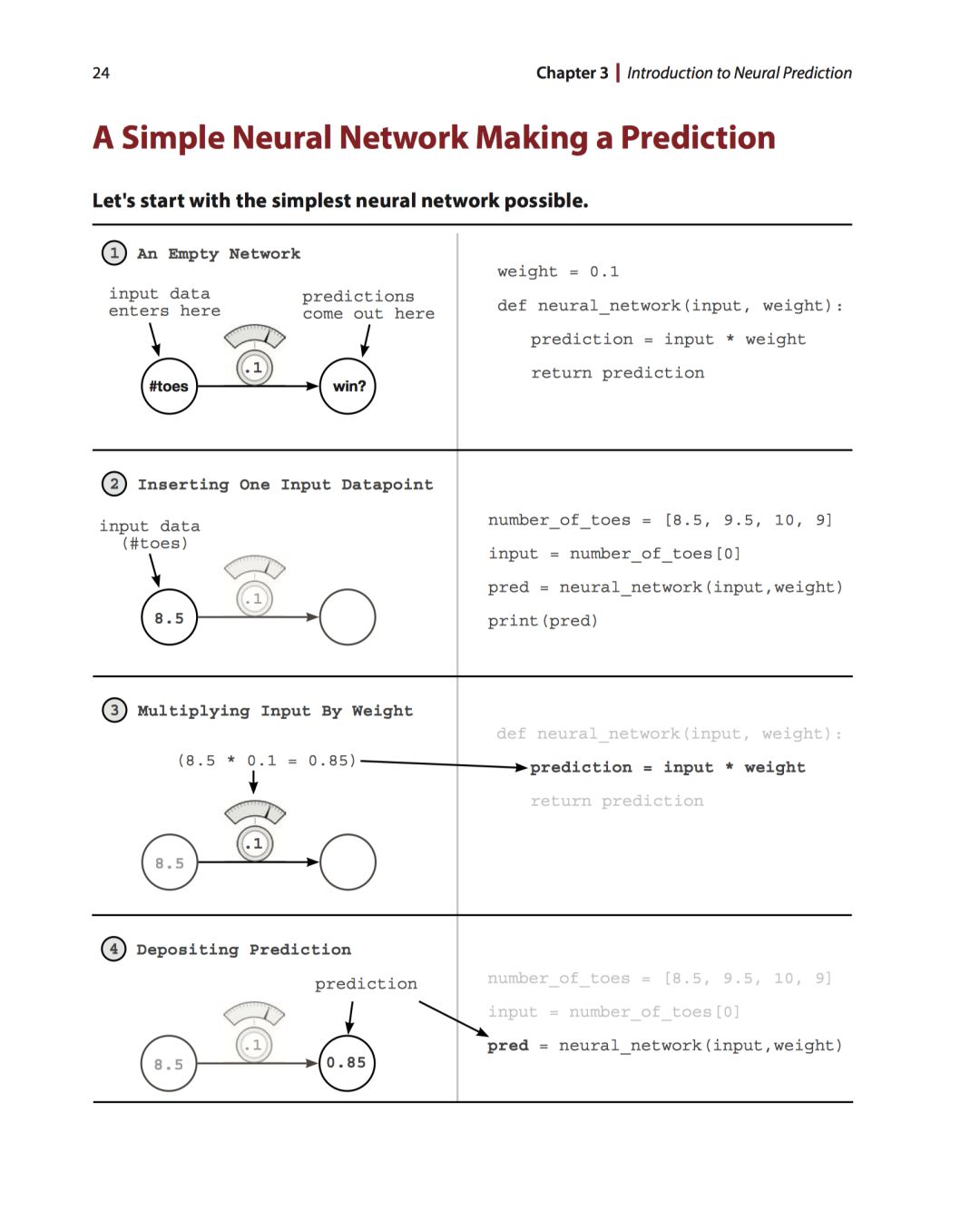

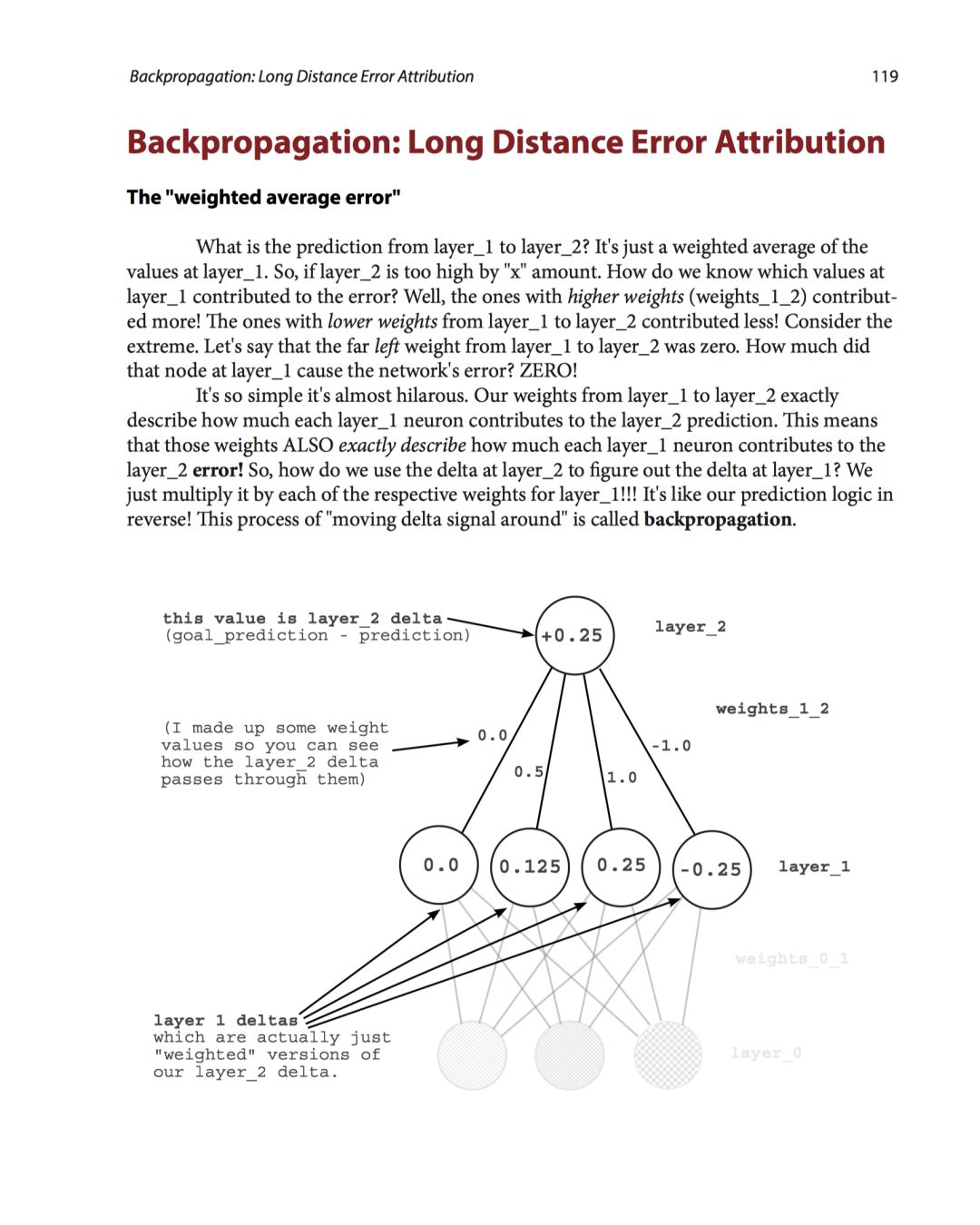

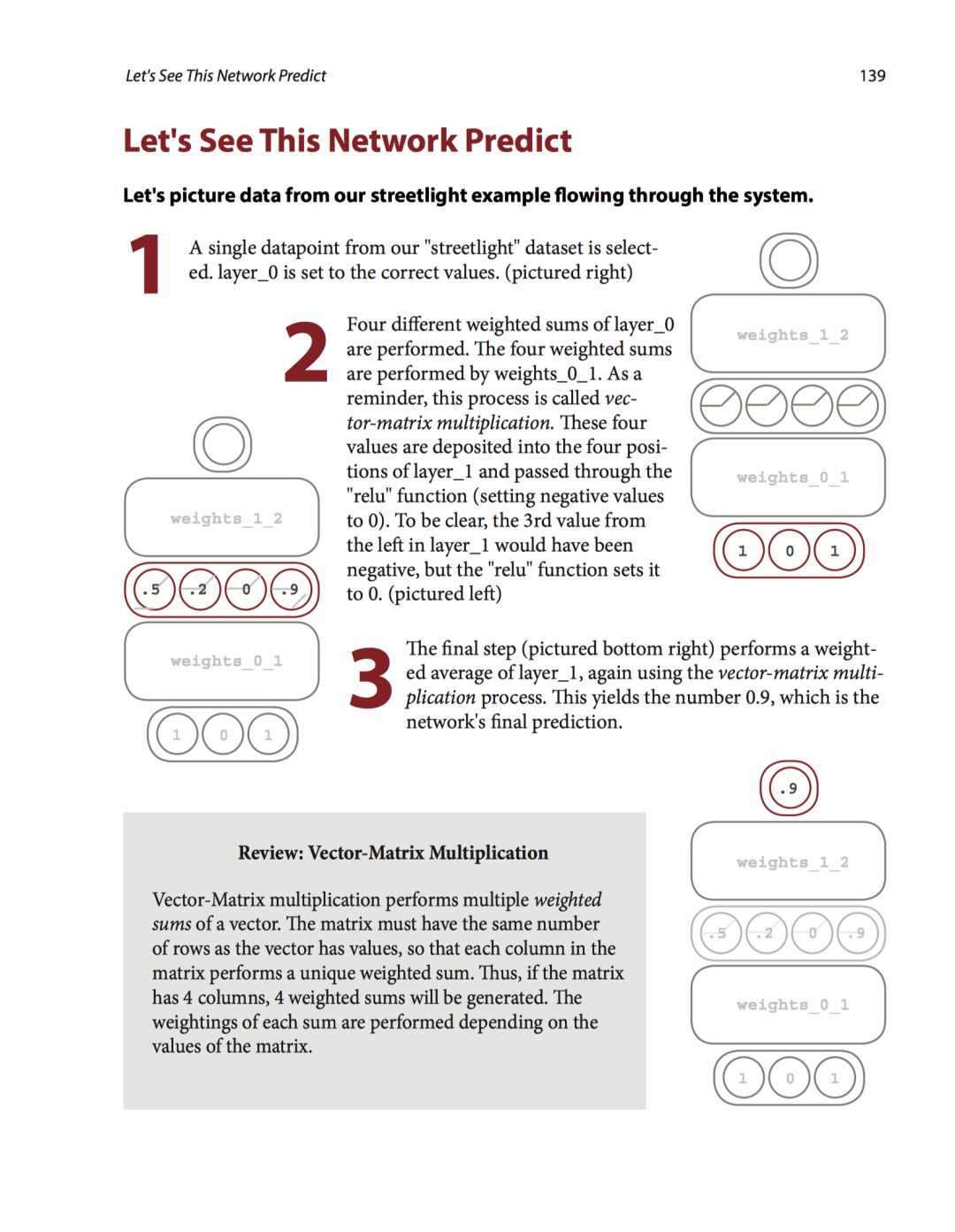

部分书稿:

-END-

专 · 知

专知《深度学习: 算法到实战》课程正在开讲! 中科院博士为你讲授!

请加专知小助手微信(扫一扫如下二维码添加),咨询《深度学习:算法到实战》参团限时优惠报名~

欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程