你以为线性回归和逻辑回归是一回事吗?

【导读】逻辑回归到底是回归还是分类?逻辑回归和线性回归是一回事儿吗?它们有什么区别和联系?其实它们从输出到公式,再到残差分布,都不一样。本文将认真“探讨”关于以上问题的一些思考。

作者 | Rakshith Vasudev

编译 | 专知

翻译 | Yongxi, Hujun

How are Logistic Regression & Ordinary Least Squares Regression (Linear Regression) Related?

Why the “Regression” in Logistic?

如果你和我一样,觉得“逻辑回归”的真实名称应该是“逻辑分类”,本文给出了关于此类问题的一些思考。

对逻辑回归与线性回归的解释

逻辑回归通过一组预测器变量,可以很有效的预测特征与输出结果。这与线性回归很相似,但更适用于二分类问题。方程系数可以用来估计模型中的自变量的比率,这适用于更广泛的问题模型,另一方面,可以将逻辑回归用于确定某个事件的可能性,输出值为0或1。

在逻辑回归中不仅可以解决二分类问题,也可以求解多分类问题,只不过它常被用来做二分类。

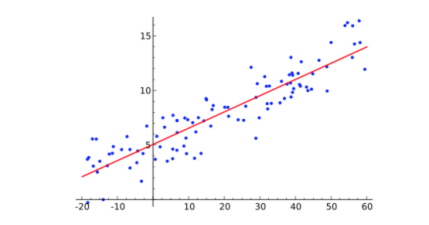

线性回归:通过估计线性方程中的系数,包括一个或多个独立变量,进而给出最佳的预测结果。例如,可以通过年龄、教育背景、工作年份等特征预测销售员全年的销售情况。

线性回归求解的是连续问题,而逻辑回归求解的是离散问题。

更多连续vs离散变量的对比可以点击查看:

https://hackernoon.com/continuous-vs-discrete-variables-in-the-context-of-machine-learning-15d9005e2525

他们是如何相关的呢?

逻辑回归通过估计输出的可能性。把事件编码为二进制变量,1代表目标事件发生,0代表不发生。

线性回归也通过线性概率模型,建模为二进制变量。线性回归可以给出超过(0,1)范围的预测值,但该方法对于分类与假设检验仍然是非常有用的。

逻辑回归模型把事件概率作为自变量函数,让y表示case i中的因变量,并令相同case中的自变量k表示为x(j=l,k)。假设Y是二元变量,来衡量某个组合的相关度。令y=l代表该组合包括某成员值,反之y=0。令p为y=1的概率值,则y=1的可能性为p/(1-p)。log概率函数或p的logit等于p/(1-p)的自然对数。逻辑回归将对数比值作为自变量的线性组合。

Logit(p) = B0 + B1X2 + …… + BkXk

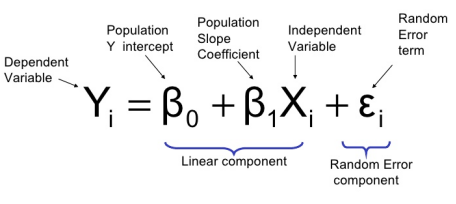

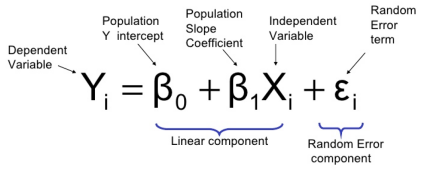

线性回归利用自变量集合与因变量间的关系建模。因变量的值等于自变量线性相加后再加上一个误差ϵ。

Y = B0 + B1X1 + B2X2+ ……. + BkXk + ϵ

其中(BO…Bk)是回归的系数,Xs是自变量(列向量),ϵ是误差值。

逻辑回归通常被用于建模二元因变量,逻辑回归模型的结构被设计为输出二元信息。

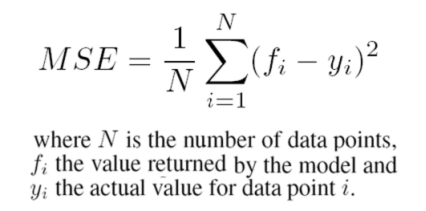

线性回归不是为了解决二元分类问题,而逻辑回归则很擅长解决数据点的分类,逻辑回归用的是对数损失函数,而线性回归用的是最小平方误差。

它们的相关性在哪呢?

线性规划使用通用的线性公式:Y=b0+∑(biXi)+ϵ,其中Y是连续的因变量,Xi是自变量。ϵ是难以解释的偏差值。当因变量值通过Yj表示,进而公式变为:Yj=b0+∑(biXij)+ϵj。

输出为:

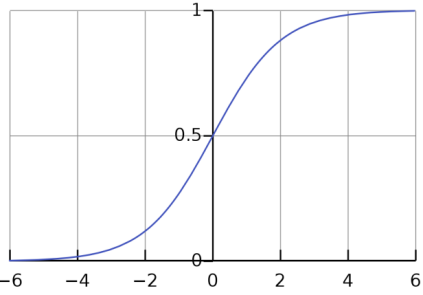

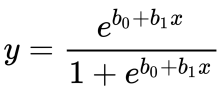

逻辑回归是另一个常见的线性模型(GLM),使用了相似的线性公式,但将连续的y替换为一组分类概率输出。最简单的模式中,这意味着,我们只需要考虑一个输出的二元值,或0或1。

Y=1概率的公式如下:

P(Y=1)=1/(1+e−^(b0+∑(biXi)))

变量的解释与上文中的相同。

自变量Xi可以使连续的或二值的,回归系数bi可以取幂值来放大Y与Xi间的相关变化情况。

输出的sigmoid曲线如下所示:

这两种都是线性模型,然而:

逻辑回归的重点不是分类,它只是在预测概率的基础上加了一个决策规则。逻辑回归是一个回归模型因为它利用特征的多重线性变换来预测每一类出现的概率。

这可能会使我们认为其不应该被称为逻辑回归,而应该称为逻辑分类。

为了回答这个问题,我们必须回到19世纪逻辑回归刚刚被提出时说起。它当时被广泛用于发现人口增长和化学自动催化反应的过程中。http://papers.tinbergen.nl/02119.pdf

可以看出,“逻辑回归”这一名词比“监督学习”等相关名词的出现早了太多年。而且,“回归”并不仅仅意味着输出总是连续的,这里有篇文章指出了这一问题。http://papers.tinbergen.nl/02119.pdf

线性回归通常被用来解决最小化方差问题,因而较大的误差会被抵消。

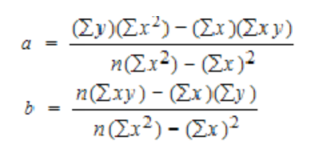

FYI:下面线性回归的损失函数:

使用logistic损失函数会导致较大的误差被惩罚为渐近常数(asymptotic constant)。

分析{0,1}分类中的线性回归过程,可以看到为什么会出现这一问题。对于值67,如果模型预测置信度是1时,损失函数不是很大。线性回归将尝试减少67,而逻辑回归则不会,也就是说,在连续输出上使用逻辑回归,无法减少更多的损失。它会认为损失值并不大,换句话说,逻辑回归并没有惩罚损失,这使得输出结果根本不是“最佳拟合线”。

逻辑回归结果在许多方面都可以与线性回归结果对比,可以发现对于结果概率给出了更准确的预测,而线性回归则能准确地从因变量中预测连续值。

从上面的分析中可以发现,“回归”是一个抽象词条,随着上下文的变化,有着不同的解释。

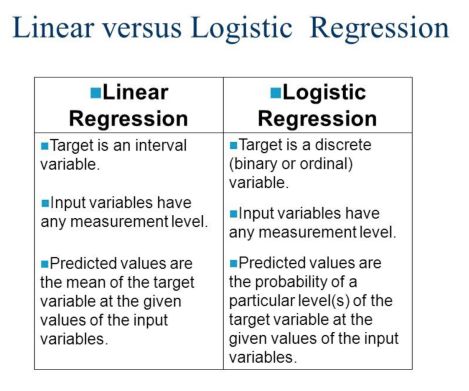

逻辑与线性回归对比如下:

为了总结,我们一起来分析下两类方法中的各个属性。

输出:

线性回归:连续值,两个以上的输出。

逻辑回归:离散值,通常两类输出{0,1},但也可以有多类,通过四舍五入的方式得到。

系数解释:

线性回归:线性回归的系数表示因变量对某个单元自变量变化的相关性加权。换句话说,当保持其他的变量值不变,增加某个变量,因变量预计会变化多少。

逻辑回归:系数与概率因素有关,直观理解可以查看如下链接:https://www.youtube.com/watch?v=eX2sY2La4Ew

公式:

线性回归:线性回归是对两个变量间关系建模的方法。可以把方程看做是斜率公式,Y=a+bX,其中Y是因变量,X是自变量,b是斜率,a是截距。

错误项表示为ϵ。

逻辑回归:逻辑回归的公式和线性回归非常像。输入值x结合线性权重来预测输出值。与线性回归的关键区别在于所建模输出值为二元数值(0,1),而不是连续数值。

误差公式

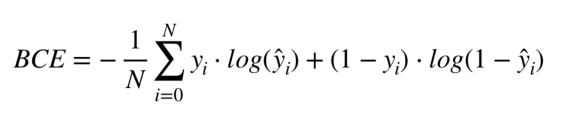

逻辑回归:输出是被分类的概率。常用损失函数是“分类交叉熵”,与神经网络中的很像。

线性关系

线性回归:需要自变量与因变量间的线性关系。

逻辑回归:不需要自变量与因变量间的线性关系。

残差分布(Distribution of Residuality:):

线性回归:要求误差服从正态分布。

逻辑回归:不要求误差服从正态分布。

原文链接:

https://towardsdatascience.com/how-are-logistic-regression-ordinary-least-squares-regression-related-1deab32d79f5

-END-

专 · 知

人工智能领域主题知识资料查看与加入专知人工智能服务群:

【专知AI服务计划】专知AI知识技术服务会员群加入与人工智能领域26个主题知识资料全集获取。欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请加专知小助手微信(扫一扫如下二维码添加),加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

请关注专知公众号,获取人工智能的专业知识!

点击“阅读原文”,使用专知