ICASSP最佳学生论文:深度对抗声学模型训练框架

【导读】自动化所智能交互团队刘斌、聂帅、刘文举等针对语音识别系统在噪声环境下识别性能下降的问题,提出了深度对抗声学模型训练框架,有效减小了噪声环境语音数据和真实训练数据的分布差异,提升了声学模型的鲁棒性。该框架不需要一一对应的带噪数据和纯净数据,可作为通用训练框架提升已有声学模型。同时,相关研究论文获得了ICASSP2018最佳学生论文。

转载自中国科学院自动化研究所

作者:刘斌、聂帅、刘文举等

在互联网和移动互联网时代,以PC和智能手机为载体的图形视觉交互是最主要的人机交互方式,占据了绝大部分用户流量入口。而在智能设备更为复杂的物联网时代,除触屏之外,语音交互被公认最可能成为下一代信息、内容以及服务的核心入口。

目前,“语音交互”这一赛道已经汇集了互联网巨头、知名硬件企业、传统家电厂商、电商平台以及各类人工智能初创公司;近年来以智能音箱为代表的语音交互产品在国内外的火爆,更是极大地刺激了语音交互技术的应用与发展。此外,深度学习技术的突破也极大地促进了语音识别技术的发展。

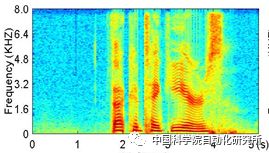

当前,语音识别系统在近场环境下已呈现出相当好的性能,甚至超过了人类水平。然而在真实环境中,语音信号不可避免会受到噪声和混响的干扰;特别是在远场条件下,由于声波在传播过程中能量随传播距离呈指数衰减,语音信号受到噪声和混响的干扰更加严重,极大地影响了语音识别等语音交互应用的性能。下图分别展示一段纯净语音和带噪语音的语谱图,可以看出,带噪语音的信号已被严重干扰,因此很难直接得到令人满意的语音识别效果。

图1 纯净和带噪语音的语谱图对比

传统解决模式及其弊端

为了提高语音识别系统的噪声鲁棒性,最直接的手段就是收集大量真实环境的语音数据进行带噪训练。这种方法虽然简单,但真实环境复杂多变,数据收集和训练的代价比较大,很难覆盖所有应用场景,性能提升比较有限。

另一种重要方法是采用“语音增强”作为语音识别系统的前端处理模块。但此种方法一方面会导致处理流程和计算消耗的增加,甚至可能增加硬件成本(基于麦克风阵列的多通道语音增强);另一方面,语音增强算法一般会基于自身的优化准则,并不会直接优化语音识别目标,消除噪声的同时可能会造成语音畸变。

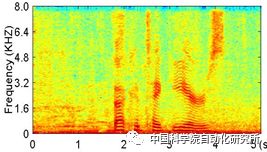

简言之,语音识别模型的噪声鲁棒性问题主要来源于纯净训练数据和带噪测试数据的分布差异。下图2(a)示意纯净语音数据的分布;带噪语音的分布可能是图2(b);语音增强,例如基于二值掩蔽的语音增强,可以消除一定程度的噪声,但同时也会带来降噪语音分布的不连续性,如图2(c)。显然,以更大尺度、直接从整体上连续调整带噪语音数据的分布可能是更好的方法。

图2 纯净、带噪、增强的语音分布示意图

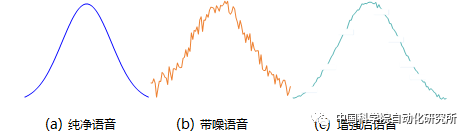

无监督生成模型:GAN

生成式对抗网络(GAN, Generative Adversarial Networks)是最近极为流行的无监督生成模型。通过对抗训练的方式,它能够连续逼近指定的数据分布。GAN通常由生成器和判别器组成,生成器用来生成样本,判别器用来判断样本是否来自真实训练集;二者进行对抗训练,使得生成器生成的样本尽可能逼近真实训练数据,如图3所示。GAN不仅在图像领域取得了巨大的成功,在语音领域也有许多应用,例如语音转换、合成、增强等。

图3 生成式对抗网络结构示意图

联合训练框架:多种问题,一种对策

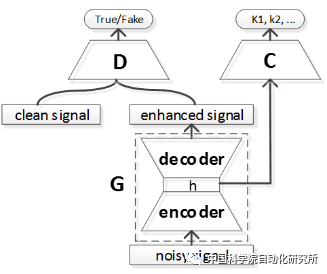

针对语音识别系统在噪声环境下识别性能下降的问题,本文提出了深度对抗和声学模型联合训练的框架。该框架由生成器(G)、判别器(D)以及分类器(C)组成:生成器用来把带噪语音数据分布变成纯净语音;判别器用来判定语音信号是否来自真实纯净训练集;声学模型作为分类器,指导生成器提取区分性特征。生成器、判别器和声学模型进行联合对抗训练,三者相互配合相互促进。

图4 深度对抗训练框架

深度对抗的联合训练策略有效减小了噪声环境语音数据和真实训练数据的分布差异,提升了声学模型的鲁棒性。相较于语音增强方法,该框架没有增加计算的流程和复杂度,并且不需要一一对应的带噪数据和纯净数据,可作为通用训练框架提升已有声学模型的噪声鲁棒性。

我们将提出的方法在Chime-4数据集上进行实验,评价标准为词错误率。结果显示:测试集上超过了基线系统(29.29 vs 33.11),效果良好,验证了该方法的有效性。

此外,刘文举研究组在基于深度对抗训练的领域自适应问题上进行了系列深入研究,目前已在OCR、鲁棒性语音识别和语音增强等领域取得多项优秀成果。

参考文献

[1]Bin Liu, Shuai Nie*, Yaping Zhang, Dengfeng Ke, Shan Liang, Wenju Liu, “Boosting Noise Robustness of Acoustic Model via Deep Adversarial Training,”ICASSP, 2018.(Best Student Paper Award)

[2]Zhang, Y., Liang, S., Nie, S*., Liu, W., & Peng, S,“Robust offline handwritten character recognition through exploring writer-independent features under the guidance of printed data,”Pattern Recognition Letters, 2018,106, 20-26.

[3]Ian J. Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville, and Yoshua Bengio, “Generative adversarial nets,”NIPS, 2014, pp. 2672–2680.

[4]Bajibabu Bollepalli, Lauri Juvela, and Paavo Alku, “Generative adversarial network-based glottal waveform model for statistical parametric speech synthesis,”INTERSPEECH, 2017.

[5] Xudong Mao, Qing Li, Haoran Xie, Raymond Y. K Lau, Zhen Wang, and Stephen Paul Smolley, “Least squares generative adversarial networks,” ICCV,2016.

本文为专知转载,转载请注明原文出处。

-END-

专 · 知

人工智能领域主题知识资料查看与加入专知人工智能服务群:

【专知AI服务计划】专知AI知识技术服务会员群加入与人工智能领域26个主题知识资料全集获取

点击上面图片加入会员

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请扫一扫如下二维码关注我们的公众号,获取人工智能的专业知识!

点击“阅读原文”,使用专知