【干货】33页最新《自然语言处理中神经注意力机制综述》论文

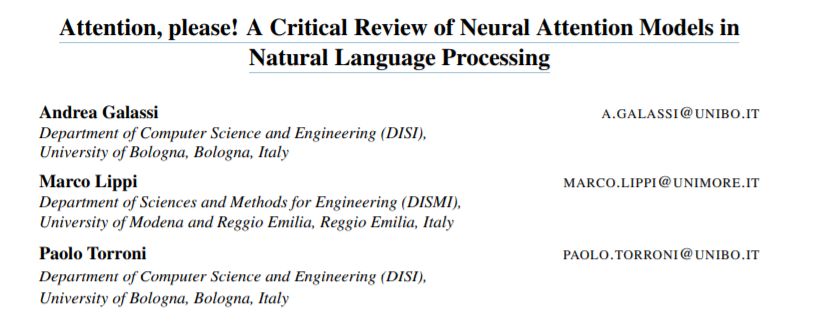

【导读】Attention, please! 近年来,注意力(Attention)机制被广泛应用到基于深度学习的自然语言处理(NLP)各个任务中。最近来自意大利博洛尼亚大学研究者Andrea Galassi等人在Arxiv上发表了关于自然语言处理中的神经注意力模型的综述论文《Attention, please! A Critical Review of Neural Attention Models in Natural Language Processing》,详述了最近几年NLP任务中使用注意力的工作。

Attention, please!

摘要:

注意力是一种在广泛的神经结构中使用的越来越流行的机制。由于这一领域的快速发展,仍然缺乏对注意力的系统概述。在本文中,我们定义了用于自然语言处理的注意力体系结构的统一模型,重点介绍了用于文本数据的向量表示的体系结构。我们讨论了以往工作的不同方面,注意力机制的可能用途,并描述了该领域的主要研究工作和公开挑战。

论文地址:

http://www.zhuanzhi.ai/paper/67faddca8944501936a568598b63c71b

导读:

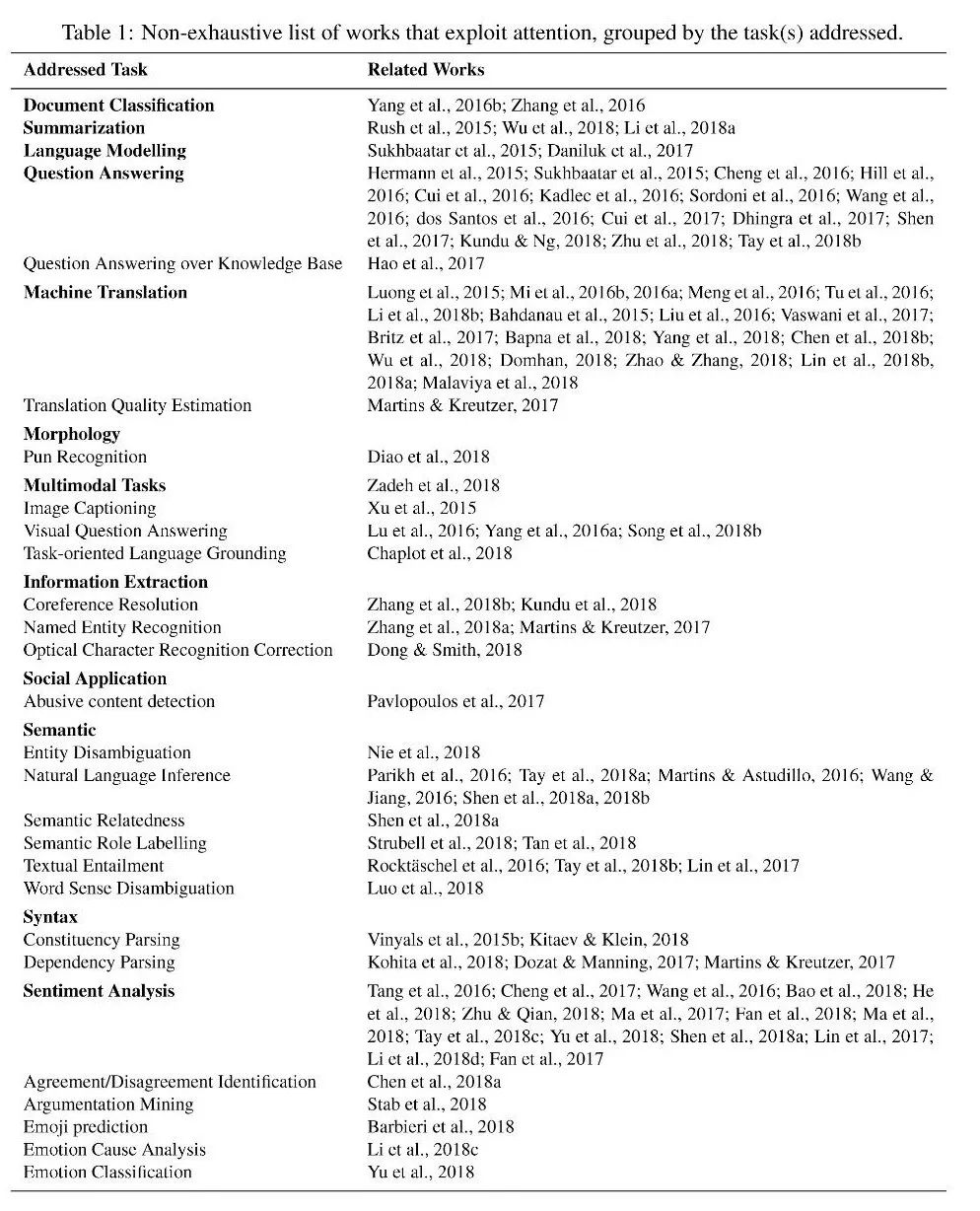

近年来自然语言处理中注意力应用工作

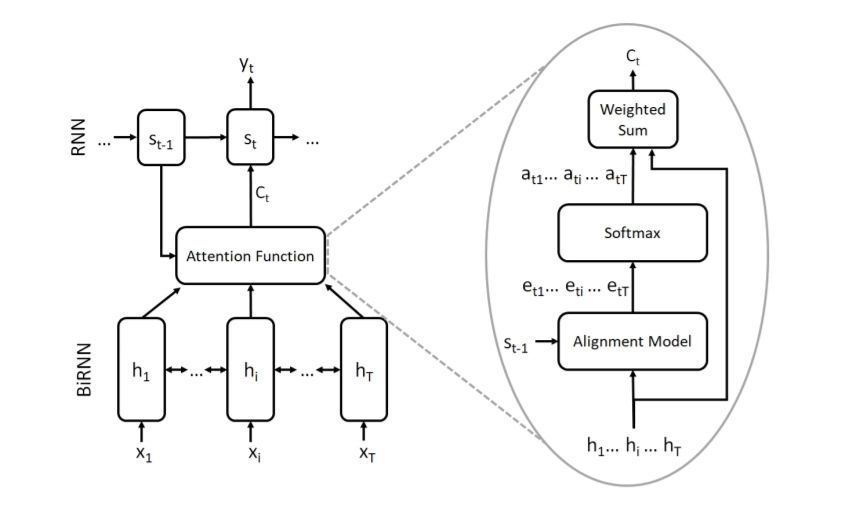

RNN架构以及对应的注意力机制模型

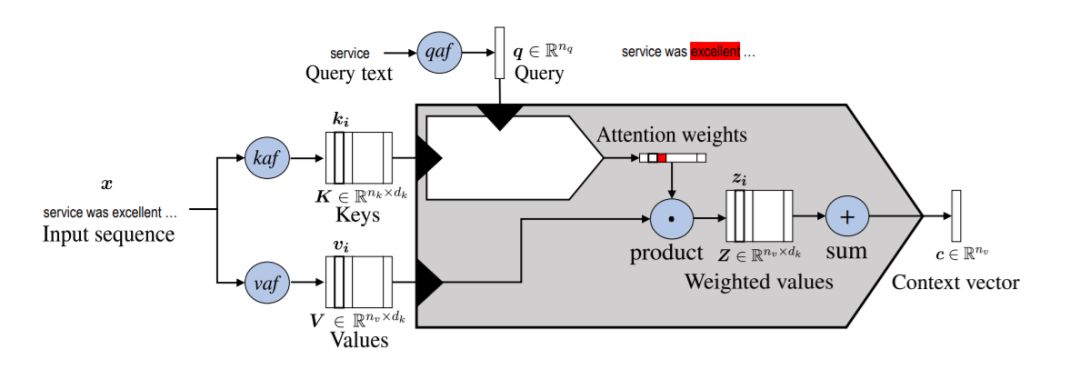

通用注意力模型

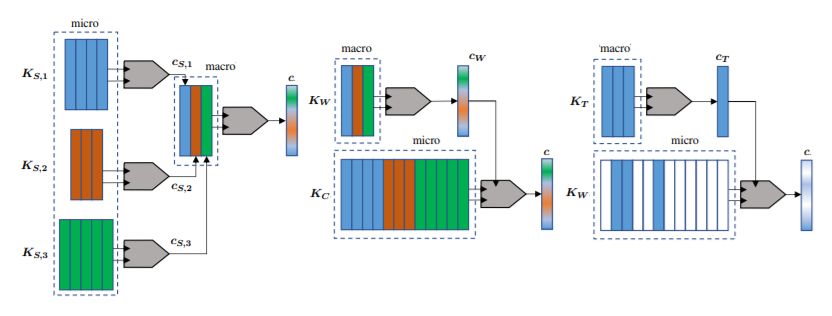

层次输入注意力模型

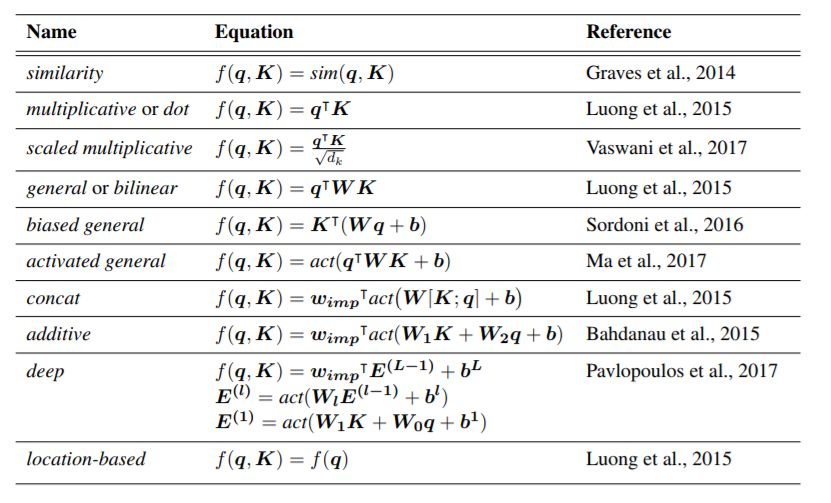

Compatibility 函数

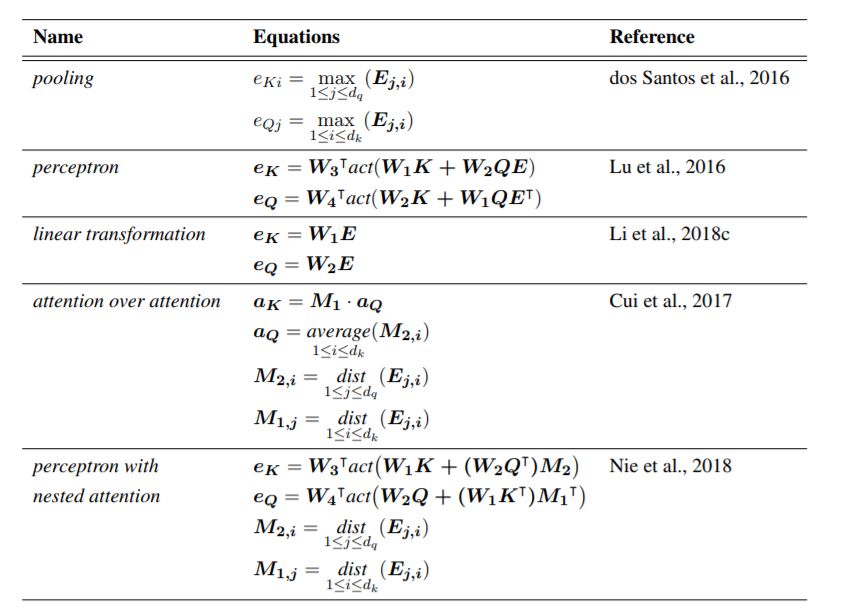

聚合函数

【论文便捷下载】

请关注专知公众号(点击上方蓝色专知关注)

后台回复“注意力” 就可以获取《自然语言处理中神经注意力机制综述》的下载链接~

-END-

专 · 知

专知《深度学习:算法到实战》课程全部完成!470+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

请加专知小助手微信(扫一扫如下二维码添加),咨询《深度学习:算法到实战》参团限时优惠报名~

欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程