【重温经典】吴恩达机器学习课程学习笔记十:正则化

【导读】前一段时间,专知内容组推出了春节充电系列:李宏毅2017机器学习课程学习笔记,反响热烈,由此可见,大家对人工智能、机器学习的系列课程非常感兴趣,近期,专知内容组推出吴恩达老师的机器学习课程笔记系列,重温机器学习经典课程,希望大家会喜欢。

【重温经典】吴恩达机器学习课程学习笔记二:无监督学习(unsupervised learning)

【重温经典】吴恩达机器学习课程学习笔记三:监督学习模型以及代价函数的介绍

【重温经典】吴恩达机器学习课程学习笔记六:特征处理与多项式拟合

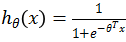

【重温经典】吴恩达机器学习课程学习笔记七:Logistic回归

【重温经典】吴恩达机器学习课程学习笔记八:Logistic回归续

吴恩达机器学习课程系列视频链接:

http://study.163.com/course/courseMain.htm?courseId=1004570029

吴恩达课程学习笔记十:正则化

1、 正则化代价函数

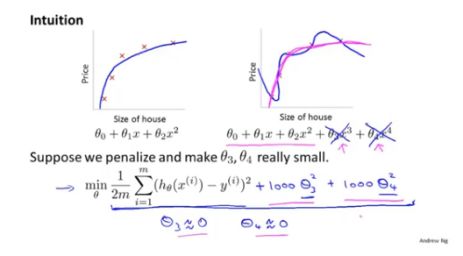

如下右半图,当我们用四次多项式去拟合数据的时候,会出现过拟合的现象。现在想到的策略是给代价函数加上惩罚项(1000+1000),目的是为了让,最小。(如下图,为了使代价函数最小,则需要使与尽量小,近似为0,则四次多项式近似退化为二次多项式,从而可以对数据进行较好的拟合)

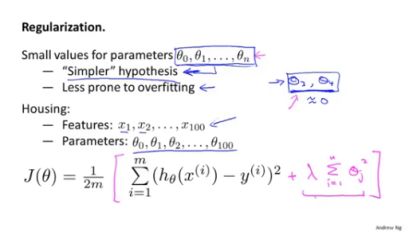

如下图,例如前面提到的房价问题,假设影响房价的特征有一百个,为了使参数尽可能小,在代价函数里增加,注意这里i从1开始(在后面的总结中会再次提到)

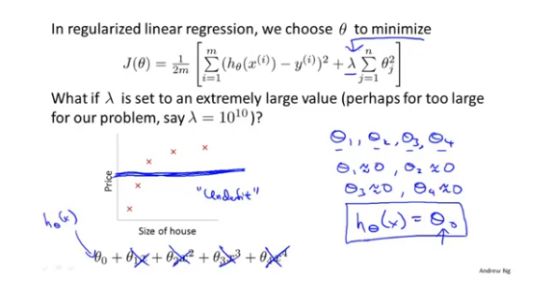

上面的总结中提到了正则化(涉及参数),那么当过大时,则会导致除外的其余参数都近似为0,这样预测函数近似变为图中的一条水平线,可以很明显的看出这样的拟合效果是极差的。

2、 线性回归的正则化

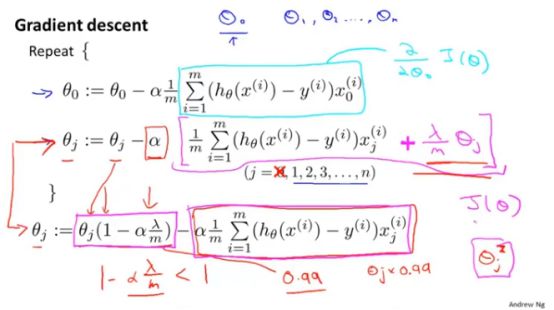

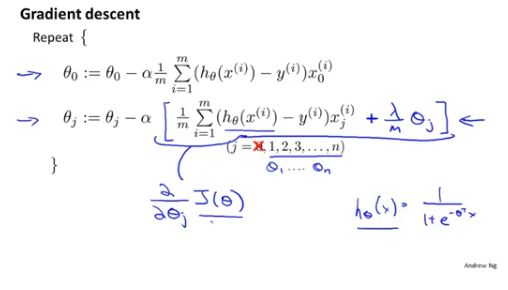

梯度下降算法:

如前面所述,i从1(这里是j)开始,所以将j=0的情况单独拿出来。对于j=1之后的参数的更新,增加一项

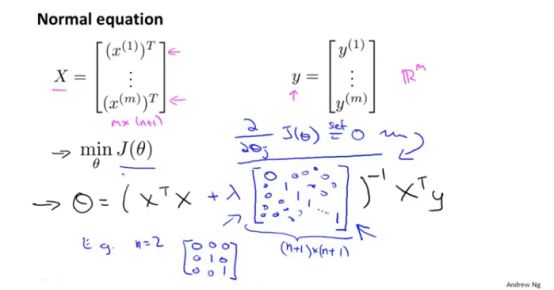

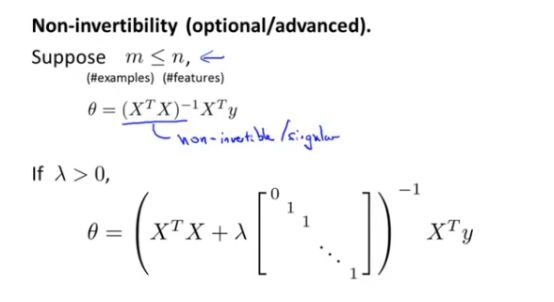

正规方程法:

对于求解线性回归问题的最优化,可以使用常规方程法。对于正则化之后,只需要在求逆之前,对

前面的课程总结中曾经提到过有可能不可逆(当样本数少于数据集的特征数时就有可能会出现不可逆的情况),但是值得注意的是对线性回归运用正则化后,(求逆的部分)一定是可逆的。

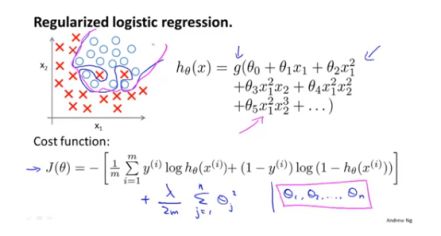

3、 logistic回归的正则化

前面的总结内容中我们同样介绍过logistic的代价函数,正则化后,需要在代价函数后面加上一项

同样,这里给出logistic回归的参数在梯度下降算法下的更新过程。如下图,似乎与线性回归的更新过程一样,但是值得注意的是这里的

下一次课程的总结中,我们将开始一个新的部分,即神经网络的学习。期待与你一起。

参考链接:

http://study.163.com/course/courseMain.htm?courseId=1004570029

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知),

后台回复“NGML2018” 就可以获取 吴恩达机器学习课程下载链接~

-END-

专 · 知

人工智能领域主题知识资料查看获取:【专知荟萃】人工智能领域26个主题知识资料全集(入门/进阶/论文/综述/视频/专家等)

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请扫一扫如下二维码关注我们的公众号,获取人工智能的专业知识!

请加专知小助手微信(Rancho_Fang),加入专知主题人工智能群交流!加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

投稿&广告&商务合作:fangquanyi@gmail.com

点击“阅读原文”,使用专知