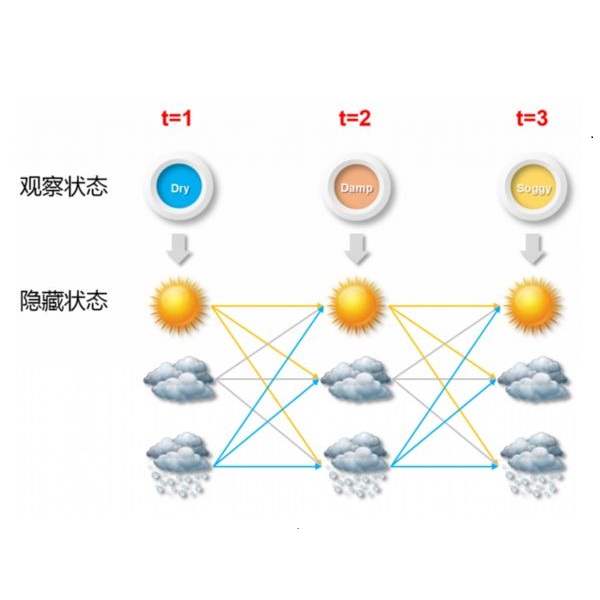

Wearable devices including accelerometers are increasingly being used to collect high-frequency human activity data in situ. There is tremendous potential to use such data to inform medical decision making and public health policies. However, modeling such data is challenging as they are high-dimensional, heterogeneous, and subject to informative missingness, e.g., zero readings when the device is removed by the participant. We propose a flexible and extensible continuous-time hidden Markov model to extract meaningful activity patterns from human accelerometer data. To facilitate estimation with massive data we derive an efficient learning algorithm that exploits the hierarchical structure of the parameters indexing the proposed model. We also propose a bootstrap procedure for interval estimation. The proposed methods are illustrated using data from the 2003 - 2004 and 2005 - 2006 National Health and Nutrition Examination Survey.

翻译:在现场收集高频人类活动数据时,正在越来越多地使用包括加速计在内的可穿戴装置,收集高频人类活动数据;在利用这些数据为医疗决策和公共卫生政策提供信息方面,存在着巨大的潜力;然而,这种数据的建模具有挑战性,因为它们是高维的、多元的,而且缺乏信息,例如,在参加者移除该装置时,没有读数;我们建议采用灵活和可扩展的连续时间隐藏的Markov模型,以便从人类加速计数据中提取有意义的活动模式;为了便利利用大量数据进行估算,我们采用了一种有效的学习算法,利用拟议模型参数的等级结构编制索引;我们还提议了一个间隔估计的探险程序;我们利用2003-2004年和2005-2006年全国健康和营养调查的数据,对拟议方法进行了说明。