自动驾驶近期行为预测和规划的一些文章介绍(附录)

继续讨论一些驾驶行为规划和预测的文章,作为附录吧。这里强化学习、生成对抗网络和LSTM的概念和方法会频繁出现。

DESIRE: Distant Future Prediction in Dynamic Scenes with Interacting Agents

这是一个深度随机逆最优控制(IOC)RNN编码器-解码器框架DESIRE,用于动态场景中交互代理的未来预测。DESIRE以几个方式预测目标在多个场景中的未来位置:1)考虑预测的多模性(即,相同的上下文可能会有不同的未来),2)预见未来的结果并进行战略性预测,3)推理不仅来自过去的运动历史,而且还来自场景上下文以及代理之间的交互。另外,在单个端到端可训练的NN模型中DESIRE计算高效。

首先,该模型用条件变分自动编码器(CVAE,conditional variational auto-encoder)获得各种假设的未来预测样本集,并以RNN评分-回归模块(scoring-regression module)排名和细化。通过核算累积的未来奖励对样本进行评分,实现类似于IOC框架的长期战略决策。

另外,RNN的场景上下文融合模块(scene context fusion module)共同捕获过去的运动历史、语义的场景上下文(semantic scene context)以及多代理交互。采用反馈机制迭代地执行排序和细化,提高预测的准确性。

如图所示,(a)驾驶场景:白色货车可能会试图向左或右转向,以免与其他运动代理发生碰撞。 DESIRE处理未来预测的多模态,同时考虑到丰富的静态和动态场景上下文,以此生成未来准确的预测(蓝色路径);(b)DESIRE生成各种各样的假设预测样本,然后深层IOC网络进行排名和细化。

下图是DESIRE概述图:首先,DESIRE通过基于CVAE的RNN编码器-解码器(样本生成模块)生成多个合理的预测样本Yˆ;然后,随后的模块作为IOC框架,在每个时间步长依次为预测样本分配奖励,并学习位移矢量ΔYˆ去回归预测假设(排名和优化模块);回归的预测样本通过迭代反馈进行细化;最终预测是具有最大的累积未来奖励样本。

下面介绍一下样本生成模块(Sample Generation Module)。

未来的预测可能是本身模糊的,并且存在不确定性,因为可以在相同的以前情况解释多种可能场景(例如,驶向十字路口的车辆可能以不同方向转弯);因此,学习从过去的轨迹直接映射到未来的轨迹的确定性函数f不足以表示潜在的预测空间,并且很容易过拟合训练数据。而且,一个带简单的损失函数计算的单纯训练网络,会产生各种可能输出平均化的预测。

而该样本生成模块,通过有效结合CVAE和RNN编码器-解码器,产生一系列能捕获预测任务的多模态性至关重要的假设。

RNN使用门控递归单元(GRU,gated recurrent units)来学习长期依赖关系,也很容易地用其他流行的RNN(比如LSTM)代替。CVAE模块基于过去的轨迹生成各种未来轨迹。这里有两个损失项:重建损失(Recon)和K-L发散损失(KLD)。

接着是排名和优化模块(Ranking and Refinement Module)。

与较近的未来相比,预测遥远的未来可能更具挑战性。为了解决这个问题,在强化学习(RL)中采用决策过程概念,在学习中对代理训练其选择一个最大化实现其目标的长期奖励的动作。但是,IOC不是手动设计,而是学习未知的奖励函数。

它设计了一个RNN模型,该模型将奖励分配给每个预测假设,并根据累积的长期奖励来衡量其优劣。此后,通过另一个FC层学习实际预测的位移,也可以直接细化预测假设。最后,该模块从回归预测中接收迭代反馈,并不断进行调整,最终生成精确的预测。

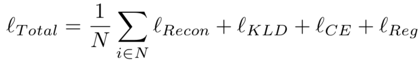

培训IOC排名和优化模块有两个损失条件:交叉熵损失(CE)和回归损失(Reg)。所以加上前面样本生成模块的损失,总损失函数是:

最后是场景上下文融合(Scene Context Fusion,SCF)模块。

为了提供为预测评分和细化适当的隐表示,RNN必须包含以下信息:1)各自过去运动上下文,2)语义场景上下文,3)多代理之间交互。该模块实现了类似于Social LSTM(注:以后在“行人的行为建模和预测”的讨论中会分析)中基于空间网格的S-池化层。另外,取代最大池,直接操作矩形网格,并采用平均池的对数极点网格。结合CNN功能,SCF模块为RNN解码器提供了静态和动态场景信息。它也学习代理和场景语义之间的一致性,这样实现更可靠的预测。如图所示是SCF模块细节,注意每个时间步GRU单元的输入都集成了多个线索(即,代理的动力学、场景上下文以及代理之间的交互)。

下图中,KITTI数据的一些结果(上3行):( b)中1和2行显示RNN ED-SI的高反应性(即,预测在接近不可驾驶区域时转向);相反,DESIRE考虑潜在的未来回报显示其长期预测能力;有其他车辆的情况下,DESIRE-SI会产生更令人信服的预测。另外Stanford Drone数据结果(下3行):第4行显示预测问题的多模性;骑自行车的人右转时,有可能绕过环岛(用箭头表示);DESIRE-SI会预测这样相同可能未来作为最高预测,同时涵盖前10个预测值中的真实未来;第5&6行表明,DESIRE-SI对静态和动态场景上下文进行推理,提供了出色的预测。

INFER: INtermediate representations for FuturE pRediction

在城市驾驶场景中,预测周围车辆的未来轨迹至关重要。尽管有一些解决该问题的方法提出,但是性能最好的方法往往需要极其详细的输入表示(例如图像序列)。但是,这种方法不能推广到未训练的数据集。

这里提出的是特别适合未来预测的中间表示。与使用纹理(颜色)信息相反,它依赖于语义并训练自动回归(AR)模型以准确预测交通参与者(车辆)的未来轨迹。使用语义信息可以大大提高像素灰度/视差技术的性能。

其设计理念是基于知识表示系统的三个特征:

- 1)代表性是否足够:足以代表与任务相关的信息。

- 2)推理充分性:推理出无法从原始未处理数据得到的特质。

- 3)泛化:必须推广到其他数据分布(用于同一任务)。

该模型将场景语义的中间表示作为输入(中间意味着,既不太原始,如原始像素灰度,也不太抽象,例如速度和转向角)。用这些中间表示预测感兴趣的车辆(VoI)的合理未来位置。这种中间表示形式在很大程度上不依赖于摄像机视角,因为数据集中摄像机安装参数(高度和视角等)是不同的,并且这种方法对其具有鲁棒性。

如图是INFER的示意图:首先,单目图像与深度信息融合(立体图像或激光雷达获得)生成中间表示,单目图像获得语义和实例分割,然后正投影到鸟瞰图。 生成的中间表示通过网络馈送,最后,它预测在传感器坐标系中记录的目标车辆轨迹。

INFER将轨迹预测公式表示为占用网格的逐单元回归。它使用中间表示来简化目标并帮助网络更好地泛化。它会训练一个自动回归(AR)模型,该模型以先前的中间表示为条件,输出VoI在占有网格的位置。INFER使用卷积LSTM连接的简单编码器-解码器模型来学习时域动态性能。它在相应的编码器和解码器分支之间添加跳连接。INFER所提出的轨迹预测方案将一系列中间表示作为输入,并产生一个单通道输出的占用栅格。这里训练目标包括两项:重建损失和安全损失。

下图是KITTI验证集的定性结果,证明了INFER-Skip用中间表示法预测复杂轨迹的功效。 例如,在最左图,网络能够准确地预测轨迹中看不见的第二条曲线(预测的轨迹和真实轨迹分别以红色和蓝色显示)。 绿色和红色3D边框分别指示预处理的开始和感兴趣车辆(VoI)的预测开始。 值得注意的是,预测的轨迹很好地位于车道(深灰色)和道路区域(青色)之内,同时避免与障碍物(洋红色)碰撞。

Deep Imitative Models for Flexible Inference, Planning, and Control

模仿学习产生的行为策略灵活性有限,无法在测试时适应新的目标。相比之下,基于模型的强化学习(MBRL,model-based reinforcement learning)可以从数据中学到预测动力学模型(predictive dynamics model),并规划任意的目标。

本文提出了“模仿模型”,结合模仿学习和MBRL的优势。模仿模型是概率性预测模型,能够规划实现任意目标的可解释的类似专家的轨迹。在MBRL中,对其推断类似于轨迹优化,对其学习类似于模仿学习。

该方法的性能在动态模拟的自动驾驶任务中性能明显优于六个直接模仿学习方法和MBRL方法,并且它可以从一组固定的专家操作高效地学习而无需在线收集其他数据。

如图所示,该算法应用于自动驾驶仿真模拟工具CARLA的导航场景。 左:描绘当前场景的图像,其中光线最近从绿色变为红色。 左中:显示代理的激光雷达观测、从路线规划器收到的目标以及该方法生成的规划。 根据专家行为的先验条件,该模型在目标之间平滑选择。这里静态的代理选择加速跟随前方车辆。 右中:描绘交叉路口场景的图像。 右:激光雷达观测值、目标、模拟坑洼的成本图以及该方法生成的各种规划,不同规划器的选择对应颜色的不同。 尽管该模拟模型从未观察到避免坑坑洼洼的行为,它能通过测试-时间成本图规划其围绕的合理道路,首选方案是进入交叉路口路并绕着一个坑洼转向。

强化学习(RL)算法,通过最少的工程设计自动从原始的传感器输入中学习所需的行为;但是,RL通常需要在线学习:代理必须使用其最新策略收集更多数据来更新模型并反复这个过程。但是,在现实的自主系统上部署部分受训练的策略可能很危险。学习行为应从专家演示中离线进行。

如何将这种演示集成到自动驾驶汽车中执行各种任务?

一种是模仿学习(IL),即与专家分布保持一致的学习政策。

另一个是基于模型的方法,该方法可以用数据来拟合动力学模型,原则上可以与规划算法一起使用以实现用户指定的任何目标。

但是,基于模型(MB)和无模型(MF)的RL算法很容易受到分布漂移的影响:根据学习的模型或策略行动时,代理访问与训练时不同的状态,无法确定有效的行动方案。事实上,当数据有意排除不良事件(例如崩溃)时,这是有问题的做法。因此,MBRL算法通常需要在线的数据收集和训练。

如图所示,一是针对目标(goals)的模拟计划:多目标航点计划可实现对计划的细粒度控制。

下图展示的是,可以将成本分配给仅在测试时看到的“坑洼(potholes)”; 专家演示中从未观察到坑洼。规划者更喜欢围绕坑洼的路线。

IL算法使用专家演示的数据,尽管存在类似的漂移缺点,但有时候,无需在线数据收集就可以学习有效的策略。但是,标准的IL几乎没有任务灵活性,因为它只能预测低级行为。尽管一些研究通过条件目标化(goal conditioning)增强IL,但这些目标必须在训练过程中预先指定,通常也是很简单的那种(例如,左或右转)。

我们的目标是设计一种算法,该算法结合了IL和MBRL的优点,有实现新用户目标的灵活性以及离线数据的学习能力。通过从专家数据中学习深度的条件概率预测模型,这种身份无需使用人工设计的奖励函数就能捕获专家行为的分布。

为了规划这个目标,此法在模型所导致的后验分布和指定任务的目标分布下,推断最可能的专家状态轨迹。结合基于模型的表示,该方法可以轻松规划先前未见过的用户指定目标,同时表现与专家相似的效果,并且无需任何额外的训练,可灵活地执行各种测试任务。

下图是应用于自动驾驶的说明图。 该方法从专家示例数据集中训练出一个模仿模型。 之后,将模型重新用作模仿规划。 测试时,路线规划器会向模仿规划器提供航路点,后者会计算出通往每个目标的如专家一样的路径。 根据规划目标,选择最佳规划提供给低级PID控制器,产生转向和油门动作。

下图展示如何容忍错误的航路点。 规划人员在专家行为的分布(位于合理距离的道路上)中偏爱航路点。 第1-2栏:用½诱饵航(decoy)航路点进行规划。 第3-4栏:在道路的错误一侧规划所有航路点。

下图告诉的是,规划选择坑洼周围转向。接着的表是鲁棒性对航路点噪声和测试-时间坑洼的适应。 该方法对于道路错误一侧的航路点是鲁棒的,对于诱饵(decoy)航路点是相当鲁棒的。 该方法具有足够的灵活性,可以通过合并测试-时间成本安全地产生未演示的行为(避开坑洼)。 每个城市收集十剧集。

Multi-Agent Tensor Fusion for Contextual Trajectory Prediction

准确预测其他参与者的轨迹对于自动驾驶至关重要。轨迹预测具有挑战性,因为它需要推理代理过去的运动、不同数量和种类的代理之间的社会互动、场景上下文的限制以及人类行为的随机性。

本文方法在多代理张量融合(MATF,Multi-Agent Tensor Fusion)网络中对这些交互和约束联合建模。具体来说,该模型将多个代理的过去轨迹和场景上下文编码为多代理张量,然后应用卷积融合捕获多代理交互,同时保留代理和场景上下文的空域结构。该模型用对抗性损失(adversarial loss)学习随机预测,递归地解码出多代理未来轨迹。作者在高速公路驾驶和行人数据集上做实验,这里仅仅取高速公路(该方法适用于行人轨迹预测,在“行人行为建模和预测”讨论中会再举例分析)。

MATF体系结构有两个并行编码流。一个单代理LSTM编码器独立地编码每个单独的代理xi的过去轨迹,另一个CNN编码静态场景上下文图像c。每个LSTM编码器共享相同的参数集,因此体系结构对场景中代理的数量具有不变性。LSTM编码器的输出是没有时域结构的一维代理状态向量{x'1,x'2,..,x'n}。场景上下文编码器CNN的输出是一个缩放的特征图c',保留鸟瞰静态场景上下文图像的空域结构。

接着,将两个编码流空间上串联成一个多代理张量(MAT)。代理编码{ x'1,x'2,..,x'n}合并成一个鸟瞰空间张量,该张量初始化为0,并且与编码的场景图像c'的形状(宽度和高度)相同。

编码的维度轴适合张量的通道轴。代理编码放在空间张量中,相对于其过去轨迹在最后时间步的位置。然后,该张量与通道维的编码场景图像连接,获得组合张量。如果多个代理因为离散化放置在张量的同一单元,则执行逐元最大池化。

多代理张量(MAT)被馈送到全卷积层,这些层学习多个代理之间以及代理与场景上下文之间的交互,同时保留空域局部性,可生成融合的多代理张量(MATF)。具体来说,这些层采用类似U-Net模型的体系结构在不同空间尺度上对交互进行建模。该融合模型c''的输出特征图在宽度和高度上具有与c'完全相同的形状,保留编码的空域结构。

如下图所示,从开销的角度来看,多代理张量编码是场景上下文和多代理的空间特征图,包括代理通道(上方)和上下文通道(下方)。 单个代理LSTM编码器输出的代理特征向量(红色)在空间上相对代理坐标放置,形成代理通道。代理通道在空间上与场景上下文编码层输出的上下文通道(上下文特征图)对齐,保留空间结构。

为了解码每个代理的预测轨迹,每个代理{x1'',x2'',..,xn''}根据融合多代理张量输出c''的坐标,切出(slice out)具有代理交互特征的的特定表示。然后,将这些特定表示形式作为残差添加到原始编码代理矢量中,形成最终的代理编码矢量{x1'+ x1'',x2'+ x2'',...,xn'+ xn''},其中编码来自代理自身的过去轨迹、静态场景上下文以及多代理之间的交互特征等信息。

这种方法使每个代理都可以专注于自身而获得不同的社交和上下文嵌入。重要的是,该模型不是对n个代理进行n次操作,而是使用共享特征提取器,为多个代理获取这些嵌入。最后,对于场景中的每个代理,其最终矢量xi'+ xi''由LSTM解码器解码为未来轨迹预测yiˆ。类似于每个代理编码器,共享参数确保当场景中代理数量变化时网络仍然能很好地泛化。如图是多代理张量融合(MATF)架构图。

下图给出马萨诸塞州驾驶数据集(Massachusetts driving dataset)一些定性结果。 以不同的颜色显示每辆车过去的轨迹,然后是100个采样的未来轨迹。 真实未来轨迹以黑色显示,车道中心以灰色显示。 (a)涉及五辆车的复杂情况; MATF可以准确预测所有目标的轨迹和速度曲线。 (b)MATF正确预测红车将换道。 (c)MATF记录红车是否会驶入高速公路出口的不确定性。 (d)紫车一旦通过高速公路出口,MATF会预测它不会从该出口驶出。 (e)在此,MATF未能预测精确的真实轨迹; 但是,预计红车会在极少数的采样轨迹中换道。

AGen: Adaptable Generative Prediction Networks for Autonomous Driving

在高度互动的驾驶场景中,准确预测其他道路参与者,对自动驾驶车的安全高效导航至关重要。由于难以对各种驾驶行为进行建模或学习此类模型,因此预测具有挑战性。

本文的模型应该是交互式的,并反映出各自的差异。模仿学习方法,如参数共享生成对抗式模仿学习(PS-GAIL,parameter sharing generative adversarial imitation learning),能够学习交互式模型。但是,学习的模型会平均个体差异。当用于预测单个车辆的轨迹时,这些模型是有偏差的。

本文自适应的生成预测框架(AGen,An adaptable generative prediction framework)对离线学习的模型进行在线调节,可恢复个体差异以进行更好的预测。特别是,将递归最小二乘-参数自适应算法(RLS-PAA,recursive least square parameter adaptation algorithm)与PS-GAIL的离线学习模型相结合。RLS-PAA有解析解法,能够有效地为每辆单车在线调整模型。

驾驶员之间的异质性(Heterogeneity)需要明确考虑,才能提高实际场景的预测准确性。 如前所述,为每辆车配备一个策略网络是很棘手的。为了使异构预测具有可扩展性,将离线模型学习与在线模型调整相结合。离线模型学习提取平均驾驶行为的特征。在线模型调整会扰动平均模型,以适应特定驾驶员在特定时间的行为。特别是,将PS-GAIL的离线预训练策略网络用作平均驾驶行为的特征提取器,同时用RLS-PAA在线调整单个车辆的行为。

如下是AGen算法的伪代码实现:

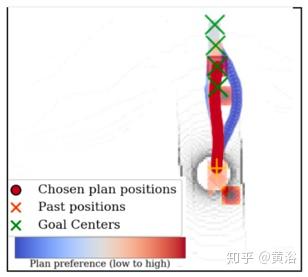

下面图(a)-(b)给出模型的工作示意图:(a)用PS-GAIL离线训练;批评者(Critic)计算专家轨迹和从策略网络推出(roll-out)的轨迹之间差异。 PS-GAIL作为行动者迭代更新策略最小化差异,而批评者最大化差异。(b)用RLS-PAA在线适应;批评者计算专家轨迹和从策略网络推出轨迹的范数-2差异。 RLS-PAA作为行动者更新策略网络最小化差异。可采用1步或2步自适应。

如图是在自适应3 s后, 22个代理的2 s轨迹预测图。

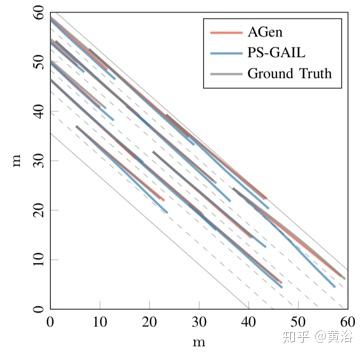

而下图是22个代理随着时间推移的平均位置RMSE结果比较。

Conditional Generative Neural System for Probabilistic Trajectory Prediction

对环境的有效了解和对周围动态障碍物的准确轨迹预测,对智能系统(例如自动驾驶汽车和轮式移动机器人)在复杂场景的导航实现安全、高质量的决策、运动规划和控制至关重要。由于未来的不确定性,一般从概率的角度进行推断,而不是确定性的预测。本文提出用于条件轨迹预测的条件生成神经系统(CGNS,conditional generative neural system),它近似数据分布,从而对现实的、可行和多样的未来轨迹假设进行采样。

该系统结合了条件潜空间学习(conditional latent space learning)和变分发散最小化(variational divergence minimization)的优势,并利用静态上下文、交互信息以及软注意力机制。它还提出了一种正则化方法,引入软约束到带可微分屏障(barrier)函数的深层神经网络,该方法可以调节并将生成的样本推入可行的区域。

如图所示,典型的城市交通场景具有较大的不确定性以及多个代理之间的相互作用。 阴影区域表示可能轨迹的可到达集合。 (a)具有四路让路信号的无信号转盘处; (b)具有四路停车标志的无信号交叉口。

生成多样的、真实的未来轨迹的要求有:

- 1)上下文感知:系统应该能够预测可穿越区域内的轨迹,并且不会与环境中的静态障碍物发生碰撞。例如,当车辆在回旋处行驶时,需要沿着弯道前进并避免与道路边界发生碰撞。

- 2)交互-觉察:系统需要生成符合交通或社会规则的合理轨迹,并考虑多个代理之间的交互和反应。例如,当车辆接近无信号交叉路口时,他们需要预见其他车辆可能的意图和动作,以及他们自己的行为对周围代理的影响。

- 3)可行性-觉察:系统应预测符合车辆运动学或动力学约束的自然和物理可行的轨迹,由于行人运动灵活性大,这些约束可以忽略。

- 4)概率预测:由于未来充满不确定性,因此系统应该能够学习接近数据分布的未来轨迹近似分布,并生成代表各种可能行为模式的各种样本。

下图即条件生成神经系统(CGNS)的概图,包括四个关键贡献:(a)具有软注意力机制的深层特征提取器,从场景上下文图像序列和轨迹中提取多级特征; (b)编码器,用于学习条件潜空间表示; (c)生成器(解码器),用于采样未来的轨迹假设; (d)区分预测轨迹和真实轨迹的鉴别器。

下图是上下文图像掩码和轨迹块注意掩码的可视化。 尤其是,在轨迹掩码中,场景中有四行代表4个历史时间步长,有6列代表6辆车。 第一列对应于预测车辆,其他列对应于周围车辆。 颜色越亮,表示注意的权重越大。 预测车辆用红色边框指示。 在所有情况下,图像掩码在预测车辆及其行驶方向区域周围具有较大权重。 在前三种情况下,仅给预测车辆的历史轨迹分配较大的注意权重,这意味着其他车辆在这些情况下影响很小。 但是,在后三种情况下,由于存在强大的交互作用,增加了相互依赖性,因此更多地注意了其他车辆。

Coordination and Trajectory Prediction for Vehicle Interactions via Bayesian Generative Modeling

对多代理的交互行为建模时,未来轨迹的协调识别(Coordination recognition)和精细模式预测(subtle pattern prediction)将发挥重要作用。由于未来演进中不确定性的本质属性,确定性预测器不够安全和可靠。为了解决多个交互式代理的概率预测任务,作者提出了一种协调和轨迹预测系统(CTPS,coordination and trajectory prediction system),该系统具有包括宏观协调识别模块和微观细微模式预测模块的分层结构,去求解一个概率生成任务。

协调变量有两种表示形式:分类(categorized)和实值(real-valued)。贝叶斯深度学习应用到生成模型中生成多样化的预测假设。该系统在各种交通情况下在多个驾驶数据集上进行了测试,从一组评估指标看,该系统的性能优于基准方法。

与实值协调相比,分类协调可以更好地捕获多模态并生成更多的样本,而后者可以产生误差较小的预测假设,但牺牲了样本多样性。具有权重不确定性的神经网络能够生成具有更大方差和多样性的样本。

下图是两个或多个代理相互协调和交互的典型高速公路和城市驾驶场景。 阴影区域表示考虑了多模式的未来可能的运动。 (a)高速公路情景下的匝道合并和换道行为; (b)无信号转盘,有让路标志; (c)带有停车标志的无信号交叉口。 尽管上下文不同,但是可以将它们视为广义的车道合并场景。

交互式代理未来轨迹的多模式条件分布可以分解为分类的和实数值的。这种分解自然将系统分为协调识别模块(宏级)和微妙的模式预测模块(微级)。协调c不仅可以分类而代表有意义的语义,而且可以是实值向量来编码表示。如果对c进行分类,则微模块通过独热编码(one-hot encoding)将c作为指标; 如果c是实值变量,则微模块将c用作附加的输入特征。宏模块基于变分递归神经网络(VRNN),后面接一个概率分类器。微模块基于协调贝叶斯条件生成对抗网络(C-BCGAN)。

下图就是CTPS概图:(a)协调识别模块:协调变量可以是离散类别或连续实值向量。 概率分类器基于VRNN提取的潜特征,获得分类协调的离散分布。 通过基于VAE样式的模型最大化相互信息来获得实值协调的连续分布。 根据目标和对特定任务的重视程度,选择任一种表达方式; (b)细微模式预测模块:该模型基于C-BCGAN,其中生成器将历史信息、协调器指示符以及正态分布的噪声作为输入。 权重不确定性会并入生成器网络(G)和鉴别器网络(D)。

最后,如图是公路场景中预测结果可视化。 (a)带学习协调的生成; (b)产生具有实际价值的协调。 注意,仅预测周围车辆的纵向运动,而要同时预测中心车辆的纵向和横向运动。 这就是为什么周围车辆的预测轨迹没有横向偏差的原因。

Interaction-aware Multi-agent Tracking and Probabilistic Behavior Prediction via Adversarial Learning

为了实现智能系统(例如机器人技术和自动驾驶汽车)的高质量决策和运动规划,对周围的交互目标进行准确的概率预测是至关重要的前提。尽管许多研究致力于对单个代理进行预测,但同时预测多个交互式代理的未来行为仍然是一个公开挑战。

这项工作,利用分布式对抗网络(GAN)的分布式学习能力,并提出一个通用的多代理概率预测和跟踪框架,该框架将多个代理之间的交互考虑在内,其中所有个体作为一个整体都得到了处理。

由于GAN很难训练,因此需要进行实证研究,并通过数值案例研究介绍训练性能与超参数值之间的关系。实验结果表明,所提出的模型可以捕获真实分布的均值、方差和多模态。此外,提出的方法用于现实世界中的车辆行为预测任务,证明了其有效性和准确性。

与传统的监督学习训练的模型相比,通过对抗学习训练的这个模型可以实现更好的预测性能,最大化数据的似然。训练有素的模型还可以用作基于粒子滤波的贝叶斯状态估计的隐式提议分布(proposal distribution)。

如图就是模型总图,由生成器网络和鉴别器网络组成。

下图研究一种典型的高速公路情景,其中灰色车是自车,旨在预测其周围车辆(红色,绿色和黄色车)的未来运动。 可以通过车载传感器获得对环境的观测。 该方法也可以在基于摄像机的高架交通监控系统中采用。

最后是实验例子可视化图。 (a)左转车道; (b)右转车道。 红色虚线是真实轨迹。

参考文献

略。