图注意力网络 了解一哈

本周分享的论文是

对,我已经深深的钻进注意力网络中无法自拔了^-^。之所以来搬砖《Graph Attention Networks》是因为这里面既有我想学的图数据处理内容(以后会慢慢写成笔记给大家分享)也有希望继续研究的attention。

简单说下图

图结构数据跟以往常见的数据不同,我们以前看到的数据都是欧式结构数据,也就是网格数据。就像图片数据、语音数据等都是标准的欧式结构数据。而图结构数据,如图一所示,常见的社交网络,万维网,知识图,等等这些都是图结构。

GAT网络综述

文章提出一种GAT(graph attention networks)网络,处理的是图结构数据。它与先前方法不同的是,它使用了带masked的self-attention层。原来的图卷积网络所存在的问题需要使用预先构建好的图。而在本文模型中,图中的每个节点可以根据邻节点的特征,为其分配不同的权值。讲道理,结构很简单,另一方面证实了attention机制真的很强大。文章的实验证明,GAT模型可以有效地适用于基于图的归纳学习问题与转导学习问题。

相关工作

对于图结构的数据,从最早的基于深经网络框架的GNN到将卷积引入图数据中,说实话卷积还真是个好东西。引入卷积的这类算法又被分为谱方法(spectral approaches)和非谱方法(non-spectral approaches)两类。谱方法是基于图的谱表征,通过图拉普拉斯算子的特征分解,在傅里叶域中定义的卷积运算需要进行密集的矩阵计算和非局部空间的滤波(计算)。在此基础上,GCN很有效地对节点的一阶邻域进行处理,从为避免复杂的矩阵运算。但是GCN依赖于图的结构信息,这就导致了在特定图结构上训练得到的模型往往不可以直接被使用到其他图结构上。非谱方法是直接在图上进行卷积而不是在图的谱上。这种方法的挑战之一是如何找到一个或者定义一个运算来处理可变大小的邻域并保证参数共享机制。

本文的GAT是一种基于attention进行节点分类的网络,基本思想是通过每一个节点的在邻近节点的attention值来更新节点表示。优点很明显,同时处理多个不同度的节点和高度并行化计算,不需要依赖图结构信息,泛化能力强。

模型结构

本文的GAT网络很简单,直接介绍他的核心层--graph attentional layer。

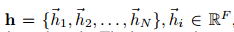

每个节点的特征向量集为:

N是节点的个数,F表示特征向量的维度。

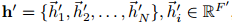

跟新后的节点的特征向量集为:

接下来是graph attentional layer的结构:

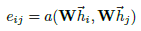

工作机制是graph attentional layer首先根据输入的节点特征向量集,进行self-attention处理如图2左侧所示,计算公式如下:

a 是一个 \mathbb{R}^{F'}\times\mathbb{R}^{F'}\to\mathbb{R} 的映射, W\in\mathbb{R}^{F'\times F} 是一个权值矩阵。为了保证不丢失结构信息,本文使用了一种masked attention的方式,也就是说仅仅将注意力分配到节点 i 的邻节点集上。因为当进行self-attention计算时,会将注意力分配到图中所有的节点上,这样就导致丢失结构信息。下面是归一化self-attention:

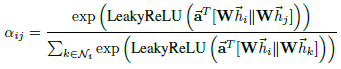

而在本文中 a 使用单层的前馈神经网络实现。计算过程如下:

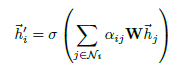

其中, \vec{a}^{T}\in \mathbb{R}^{2F'} 为前馈神经网络 a 的参数, LeakyReLU 为激活函数。此时就可以得到 \vec{h}'_{i} 了:

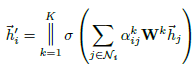

借鉴Attention is all you need的多抽头注意力方法来提高模型的表征能力,在本文中同时使用多个 W^{k} 计算 self-attention, 然后将各个 W^{k} 计算得到的结果合并:

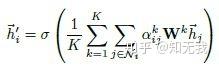

其中, || 表示连接, a_{ij}^{k} 与 W^{k} 表示第 k 个抽头得到的计算结果。当然也可以采取求和的方式来得到 \vec{h}_{i}' :

在后面

这种GAT与其他的GCN相比来说,相似的地方感觉是局部网络运算。因为GAT它是根据分配不同的注意力值来进行跟新节点的表示,而带来masked后就成了局部网络,无需了解图结构信息。不同的也是他们节点更新方式不一样。

图深度学习确实很有趣,像最近DeepMind、Google大脑、MIT各大研究机构相继发表了一系列关于图深度学习的论文,并且牵扯到了因果推断问题,那么图深度学习会不会成为AI的下一个算法热点,老哥们怕是真的好奇那。不过暂时没有精力搞图深度了,因为实验室项目原因,以后几周会不断学习目标检测的东西,同时学习笔记也会跟新。还是一句话,生命不息,搬砖不止!