2019-07-15

【1】2019-07-12 Learning Self-Correctable Policies and Value Functions from Demonstrations with Negative Sampling

作者来自:普林斯顿大学、伯克利、斯坦福大学

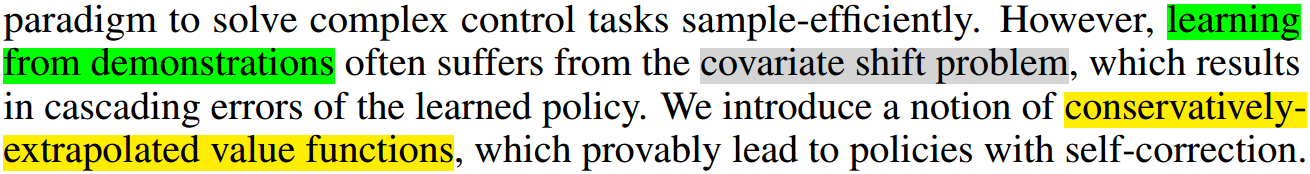

待解决的问题:

解决方法:

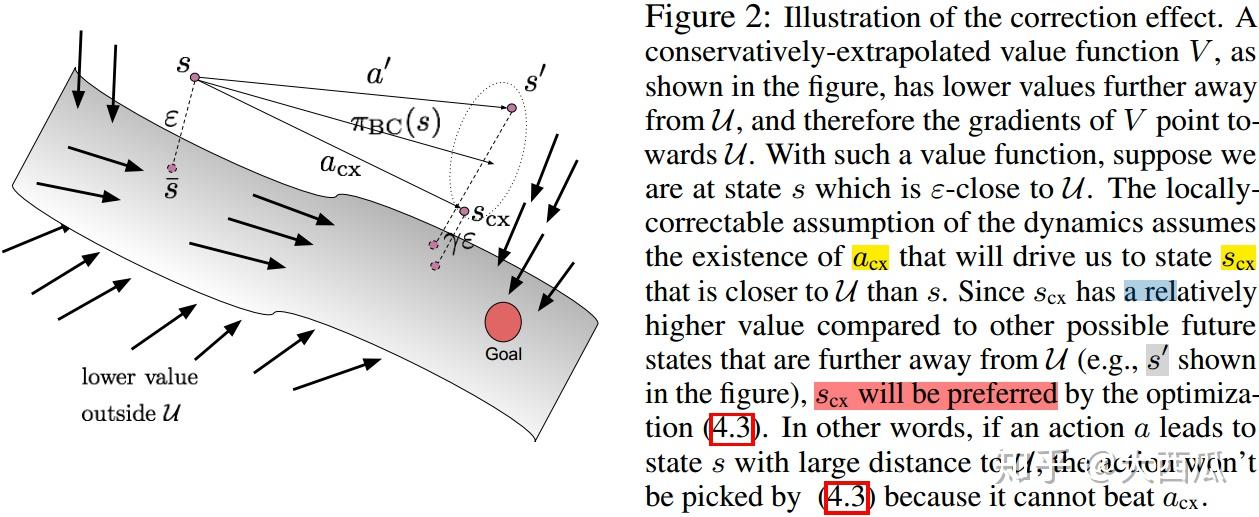

1) 基本思路:

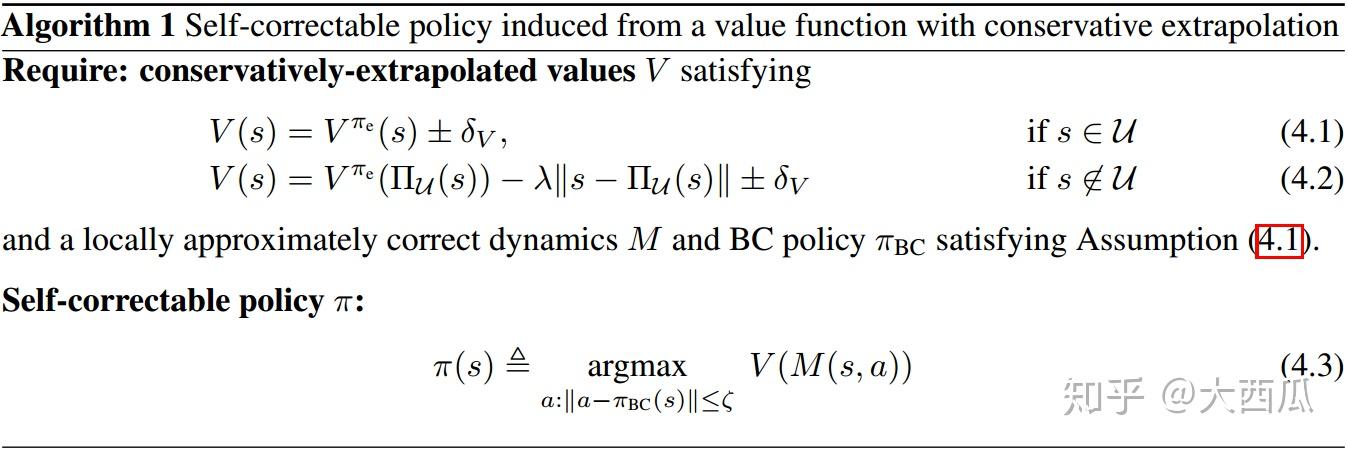

2)可自我修正的策略

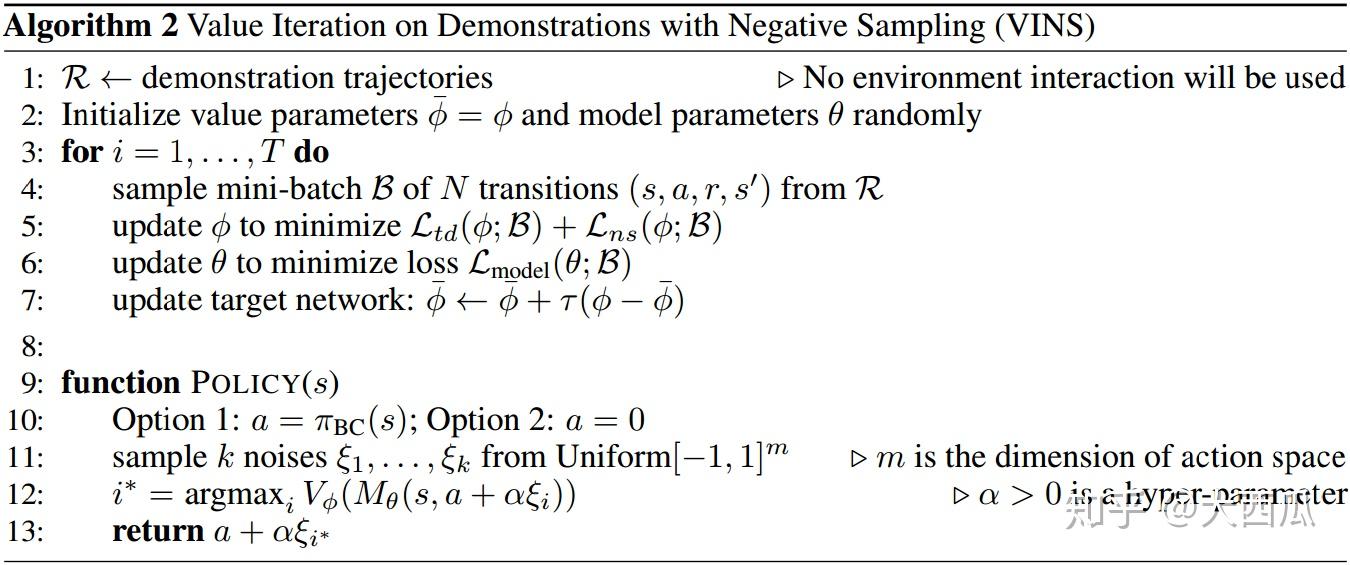

3) 整体算法如下:

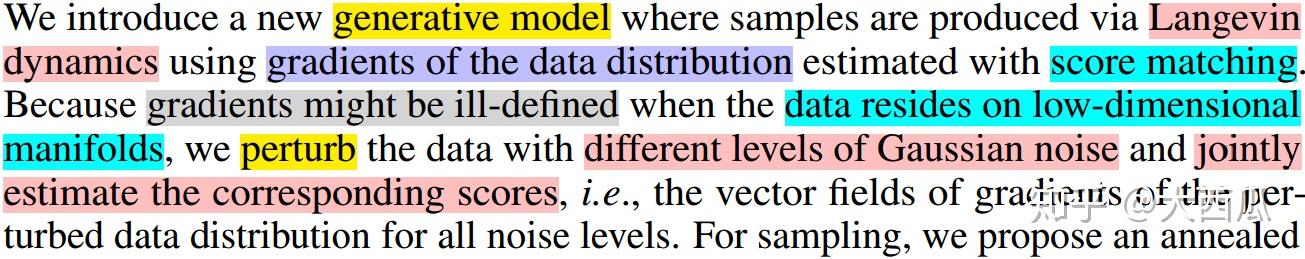

【2】2019-07-12 Generative Modeling by Estimating Gradients of the Data Distribution

作者来自:斯坦福大学

待解决的问题:

解决方法:

1) 基本思路:

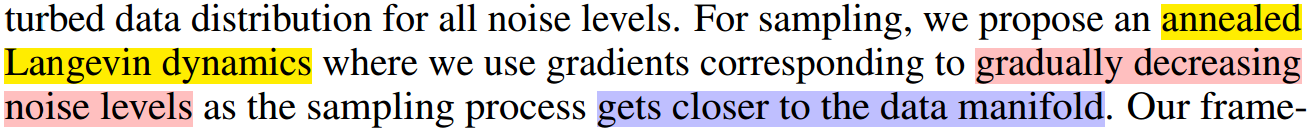

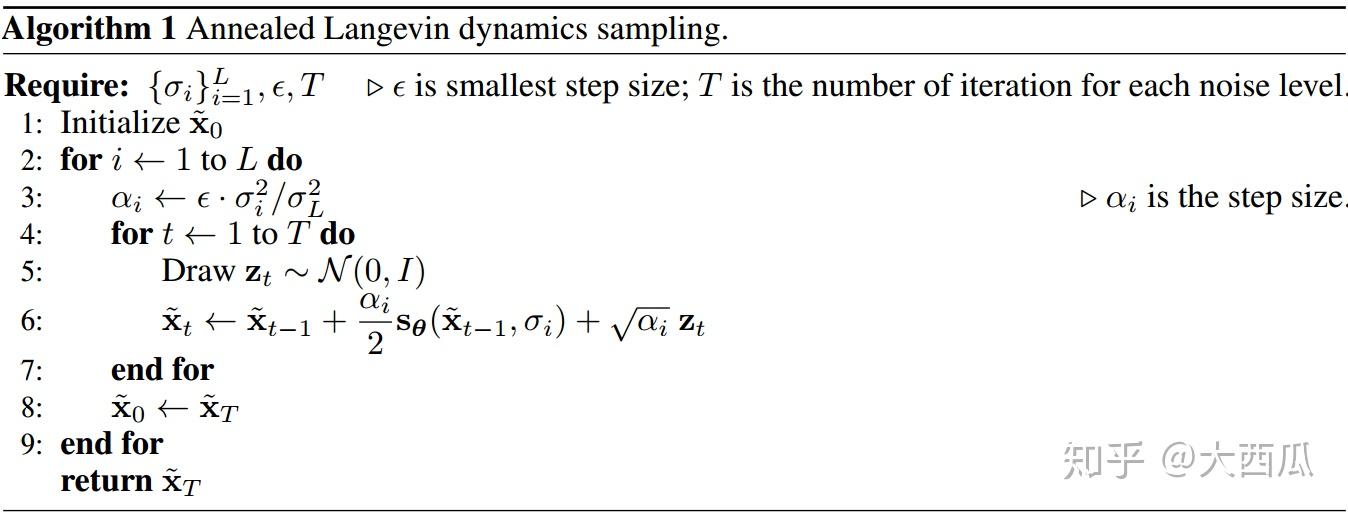

2) 提出退火朗之万动力学采样(Annealed Langevin dynamics sampling):

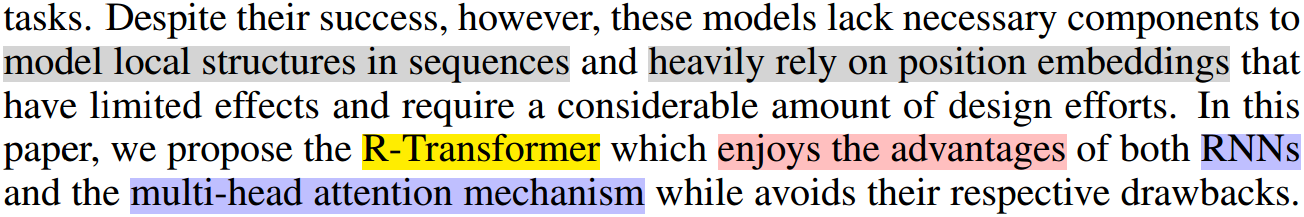

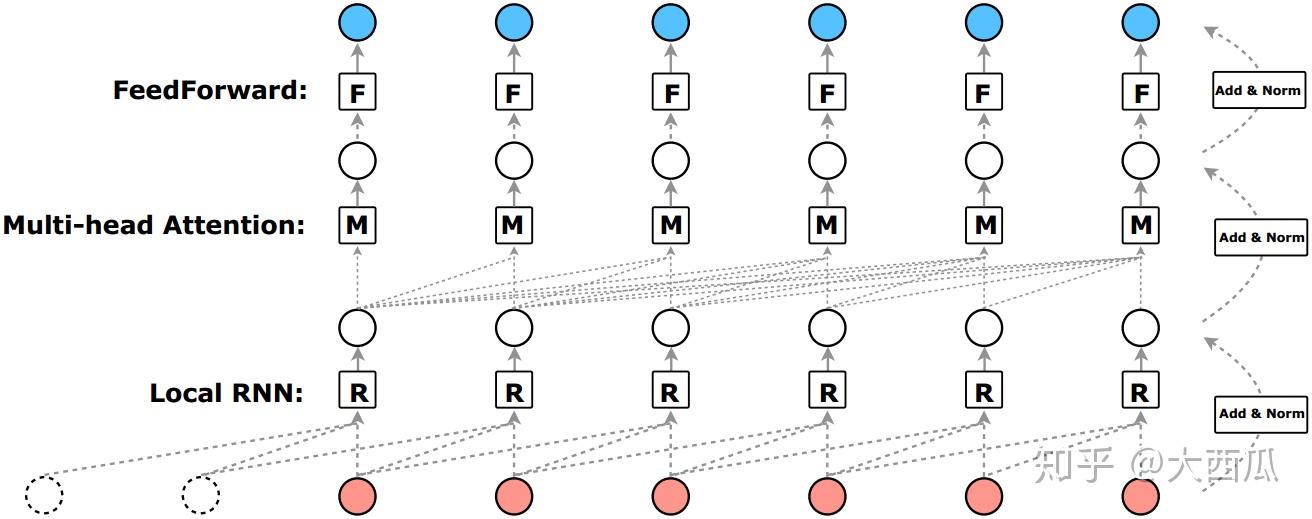

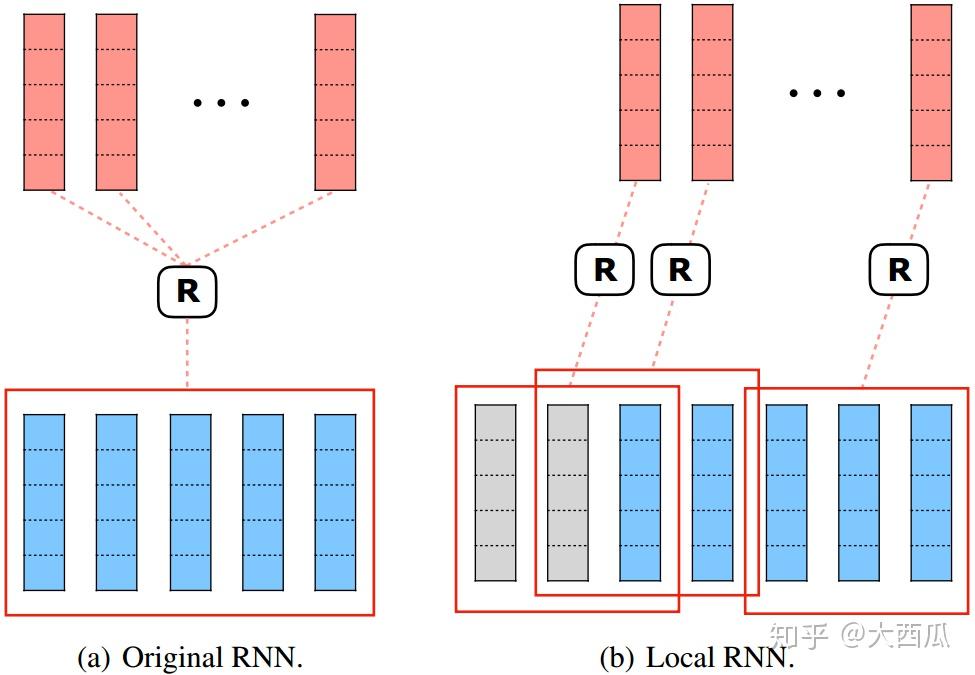

【3】2019-07-12 R-Transformer: Recurrent Neural Network Enhanced Transformer

作者来自:密歇根州立大学

待解决的问题:

解决方法:

1) 整体结构图:

2) 局部RNN:

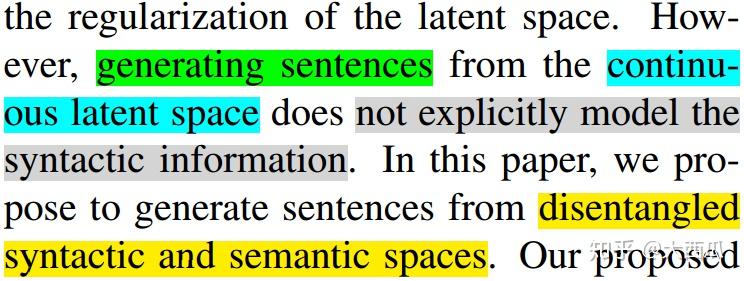

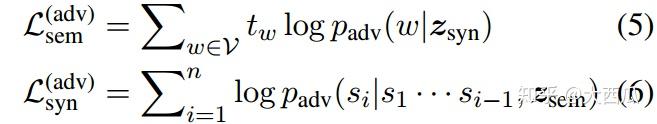

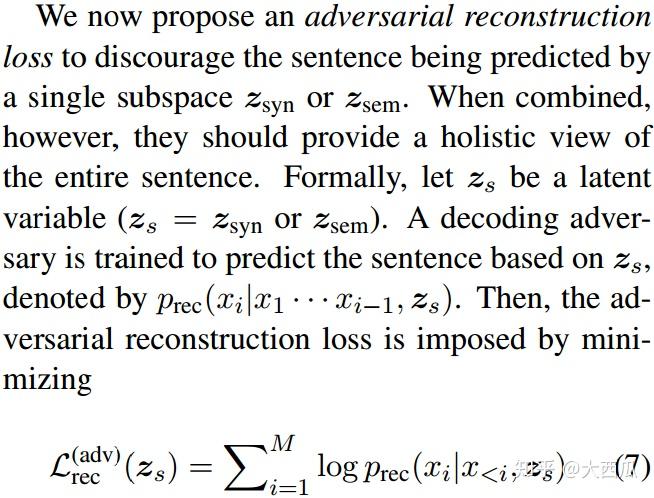

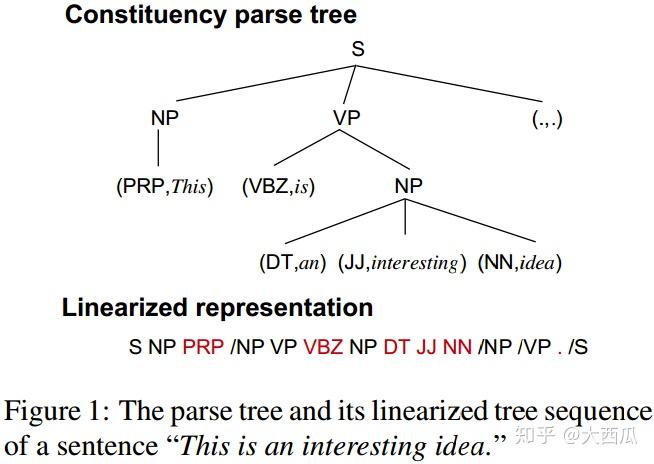

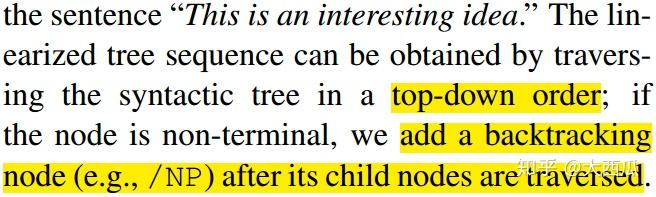

【4】2019-07-06 Generating Sentences from Disentangled Syntactic and Semantic Spaces

作者来自:南京大学、今日头条、滑铁卢大学

待解决的问题:

解决方法:

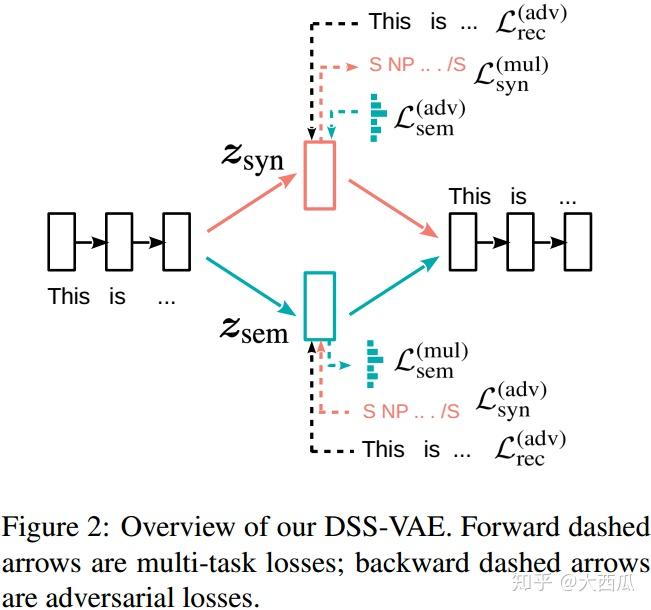

1) 整体架构图:

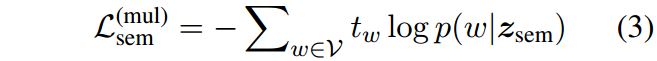

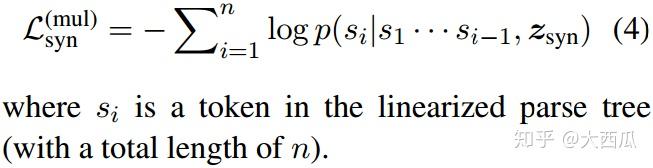

其中,

2) 线性化的表征:

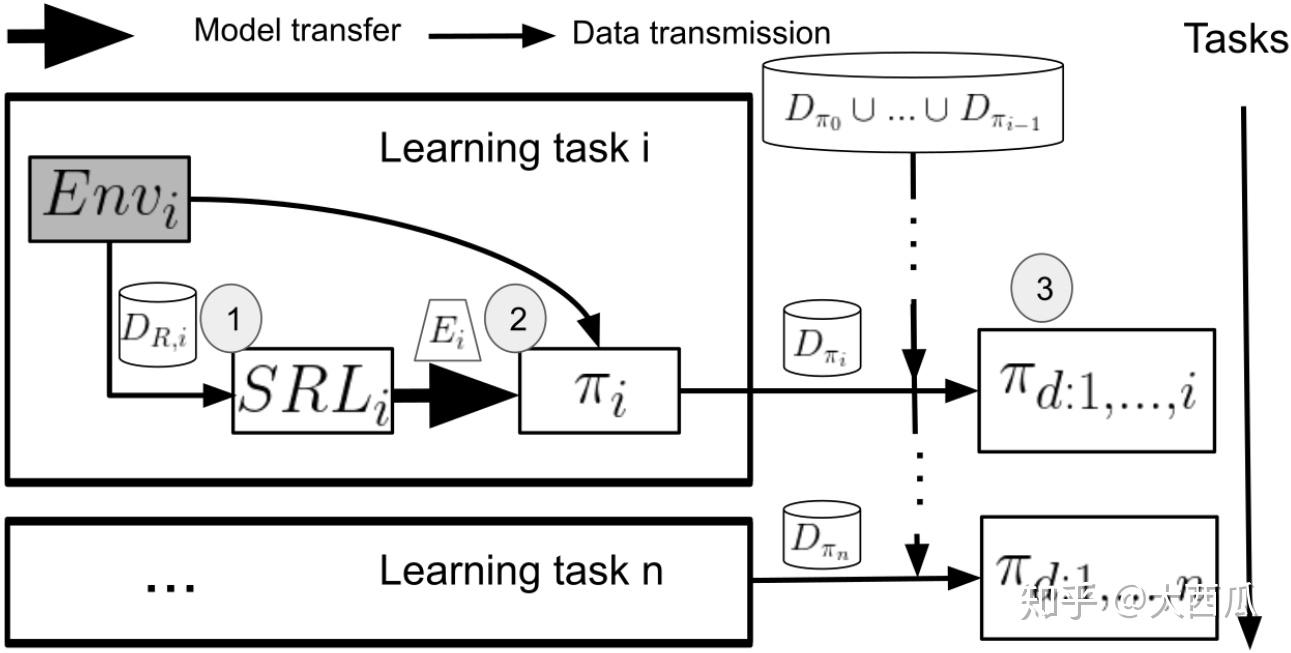

【5】2019-07-12 DisCoRL: Continual Reinforcement Learning via Policy Distillation

作者来自:巴黎高科国立高等先进技术学院

待解决的问题:

解决方法:

1) 整体结构图:

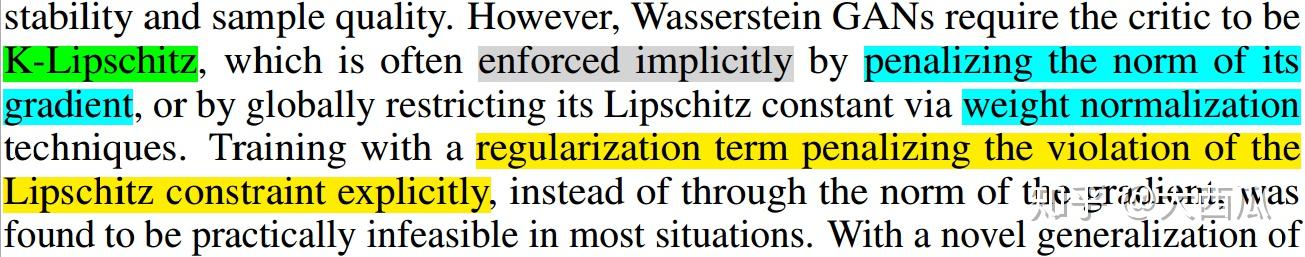

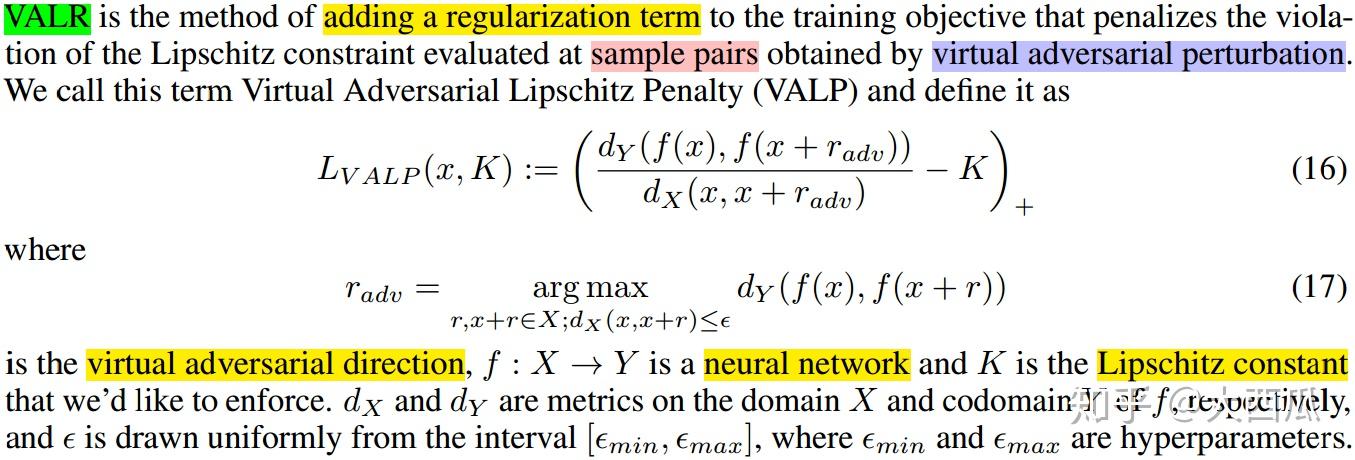

【6】2019-07-12 Virtual Adversarial Lipschitz Regularization

作者来自:Robert Bosch Kft (匈牙利的一家公司,单位一般,主要是看研究的方向)

待解决的问题:

解决方法:

1) 基本思路,以及相应的公式:

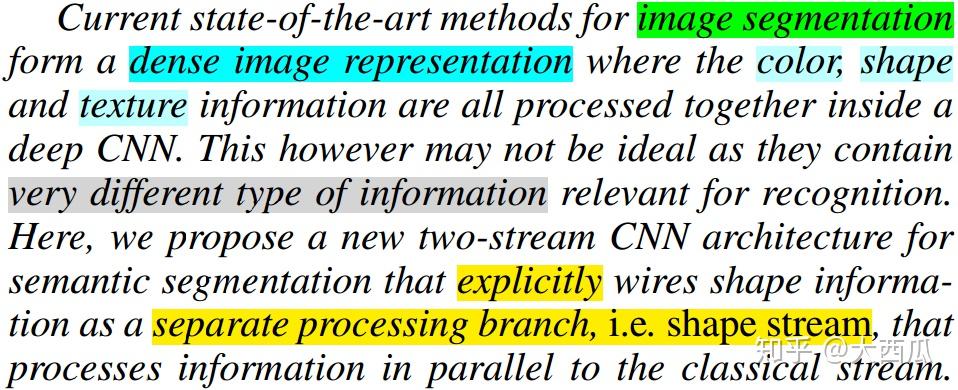

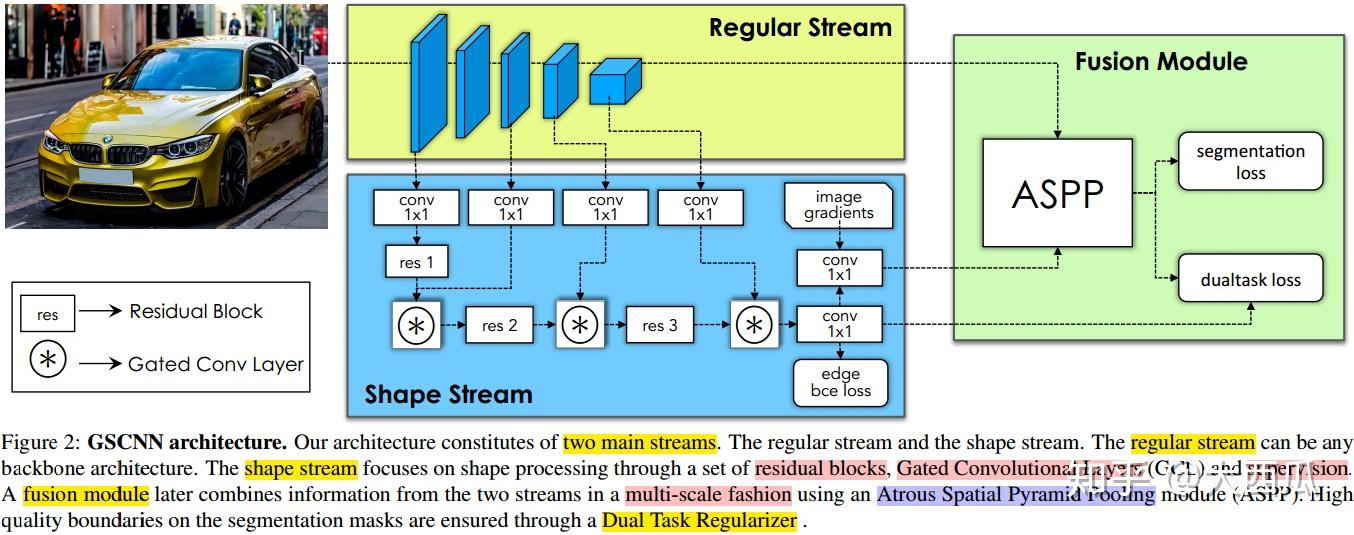

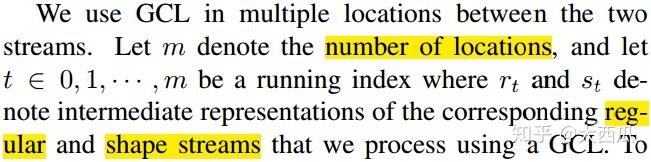

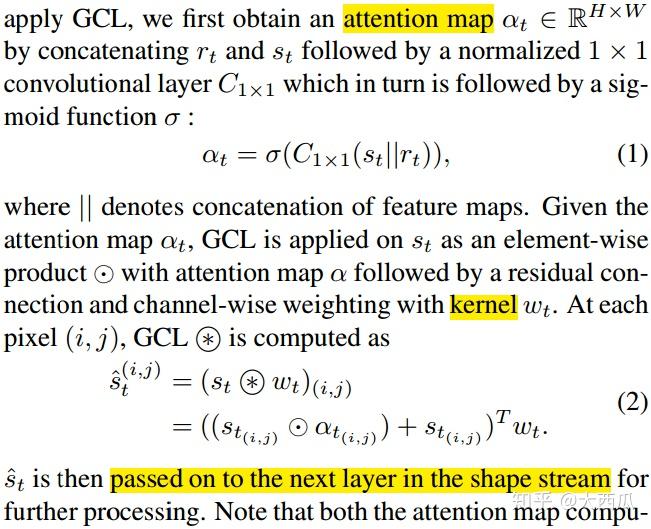

【7】2019-07-12 Gated-SCNN: Gated Shape CNNs for Semantic Segmentation

作者来自:英伟达、滑铁卢大学、多伦多大学

待解决的问题:

解决方法:

1) 整体架构图如下:

2) 门卷积层(Gated Convolutional Layer,GCL)

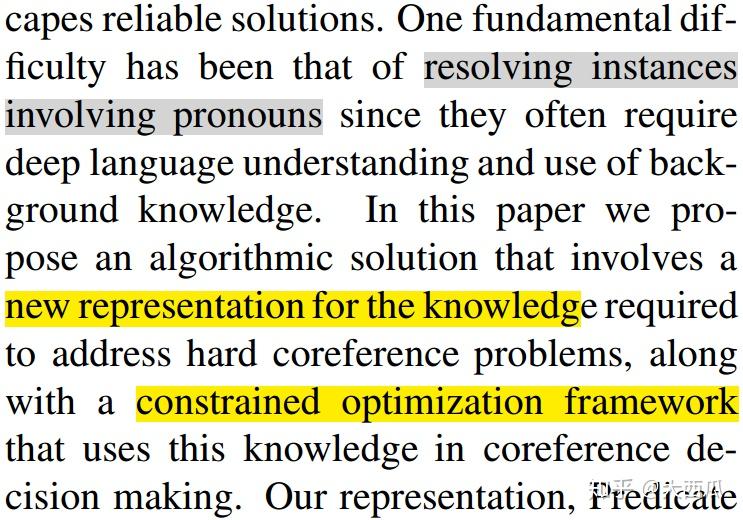

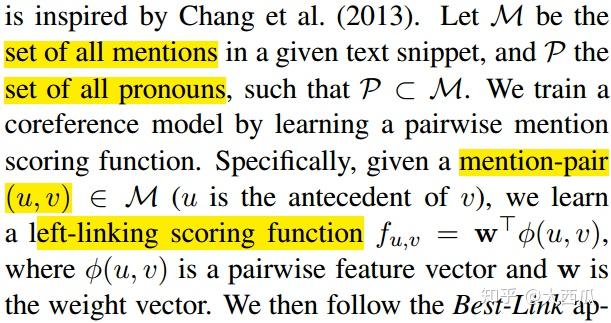

【8】2019-07-12 Solving Hard Coreference Problems

作者来自:伊利诺伊大学

待解决的问题:

解决方法:

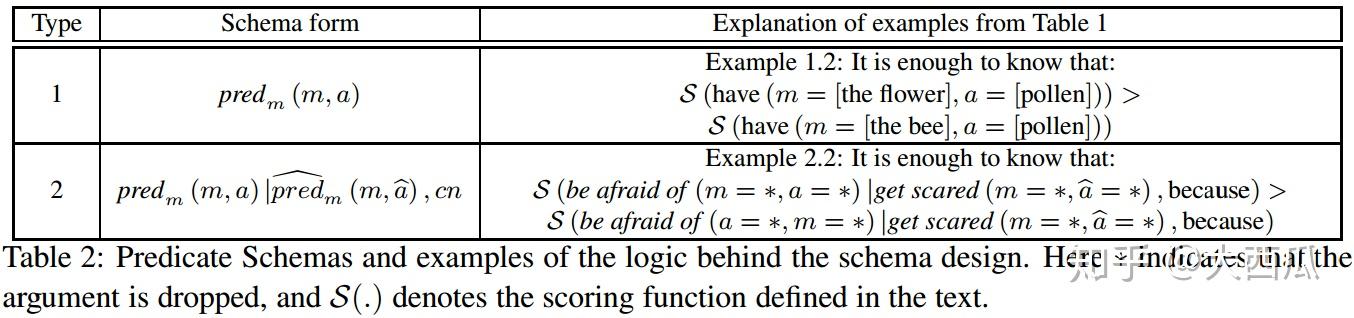

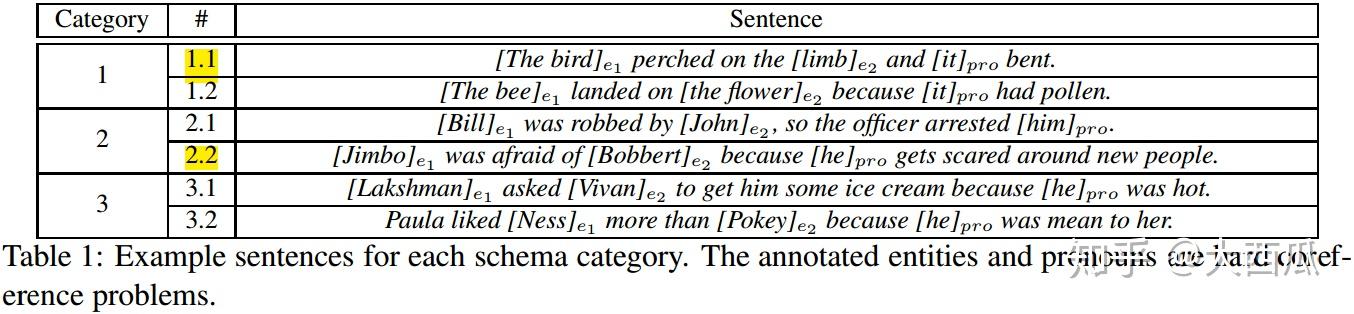

1) 首先,作者定义了两类预测模式:

其中,样例1.2、2.2如下:

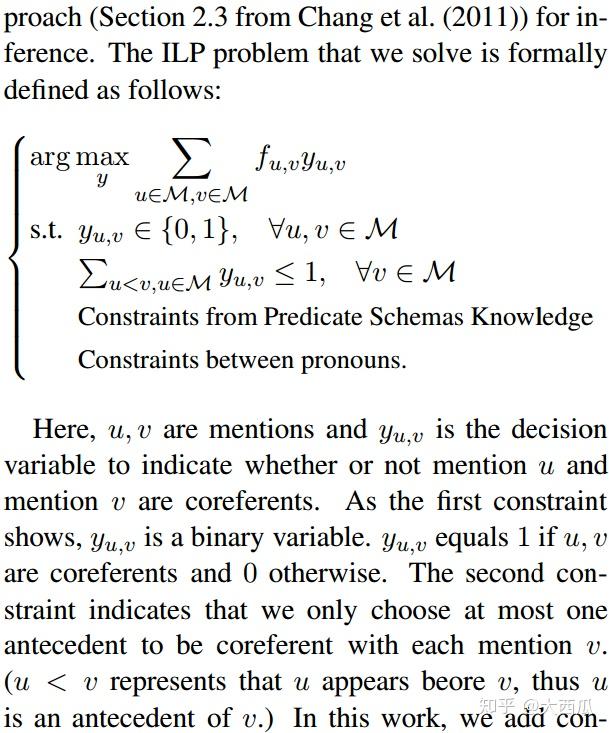

2) 选择Integer Linear Programming (ILP) 作为指代消解的处理架构:

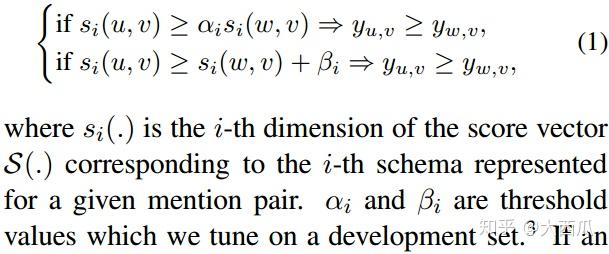

其中,预测模式的限定如下:

发布于 2019-07-15 21:12