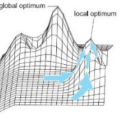

Multi-tasking optimization can usually achieve better performance than traditional single-tasking optimization through knowledge transfer between tasks. However, current multi-tasking optimization algorithms have some deficiencies. For high similarity problems, the knowledge that can accelerate the convergence rate of tasks has not been utilized fully. For low similarity problems, the probability of generating negative transfer is high, which may result in optimization performance degradation. In addition, some knowledge transfer methods proposed previously do not fully consider how to deal with the situation in which the population falls into local optimum. To solve these issues, a two stage adaptive knowledge transfer evolutionary multi-tasking optimization algorithm based on population distribution, labeled as EMT-PD, is proposed. EMT-PD can accelerate and improve the convergence performance of tasks based on the knowledge extracted from the probability model that reflects the search trend of the whole population. At the first transfer stage, an adaptive weight is used to adjust the step size of individual's search, which can reduce the impact of negative transfer. At the second stage of knowledge transfer, the individual's search range is further adjusted dynamically, which can increase the diversity of population and beneficial for jumping out of local optimum. Experimental results on multi-tasking multi-objective optimization test suites show that EMT-PD is superior to six state-of-the-art optimization algorithms. In order to further investigate the effectiveness of EMT-PD on many-objective optimization problems, a multi-tasking many-objective test suite is designed. The experimental results on it also demonstrate that EMT-PD has obvious competitiveness.

翻译:多任务优化通常能够通过任务之间的知识转让实现比传统的单一任务优化更好的业绩。然而,目前的多任务优化算法存在一些缺陷。对于高度相似的问题,可以加快任务趋同率的知识没有得到充分利用。对于低相似问题,产生负转移的可能性很大,这可能导致业绩退化的优化。此外,以前提出的一些知识转让方法没有充分考虑到如何处理人口进入当地最佳状态的情况。为了解决这些问题,建议采用两个阶段适应性知识转让,即基于人口分布的、称为EMT-PD的多重任务优化算法。EMT-PD可以根据从反映整个人口搜索趋势的概率模型中获取的知识加速和改进任务的趋同性业绩。在第一个转移阶段,采用适应性权重来调整个人搜索的阶段规模,从而降低负转移的影响。在知识转移的第二阶段,个人搜索范围进一步动态调整,这可以增加人口多样性,有利于从当地货币分配多任务组合-PD的高级目标优化的多阶段性平级标准测试,以进一步显示E-PD最佳的多级级平级平级平级平级平级平级平级平级平价测试。