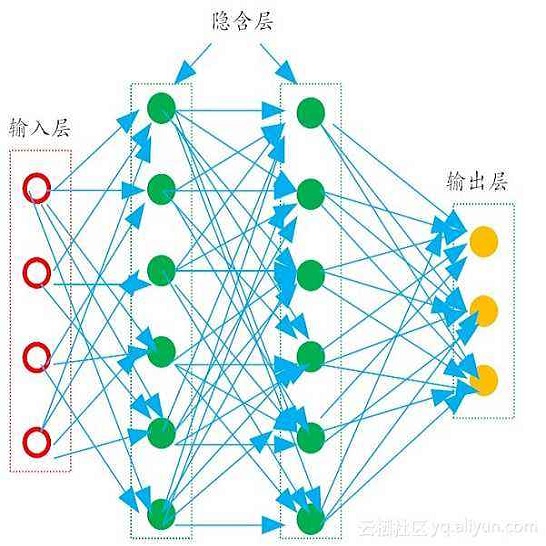

This study suggests a new approach to EEG data classification by exploring the idea of using evolutionary computation to both select useful discriminative EEG features and optimise the topology of Artificial Neural Networks. An evolutionary algorithm is applied to select the most informative features from an initial set of 2550 EEG statistical features. Optimisation of a Multilayer Perceptron (MLP) is performed with an evolutionary approach before classification to estimate the best hyperparameters of the network. Deep learning and tuning with Long Short-Term Memory (LSTM) are also explored, and Adaptive Boosting of the two types of models is tested for each problem. Three experiments are provided for comparison using different classifiers: one for attention state classification, one for emotional sentiment classification, and a third experiment in which the goal is to guess the number a subject is thinking of. The obtained results show that an Adaptive Boosted LSTM can achieve an accuracy of 84.44%, 97.06%, and 9.94% on the attentional, emotional, and number datasets, respectively. An evolutionary-optimised MLP achieves results close to the Adaptive Boosted LSTM for the two first experiments and significantly higher for the number-guessing experiment with an Adaptive Boosted DEvo MLP reaching 31.35%, while being significantly quicker to train and classify. In particular, the accuracy of the nonboosted DEvo MLP was of 79.81%, 96.11%, and 27.07% in the same benchmarks. Two datasets for the experiments were gathered using a Muse EEG headband with four electrodes corresponding to TP9, AF7, AF8, and TP10 locations of the international EEG placement standard. The EEG MindBigData digits dataset was gathered from the TP9, FP1, FP2, and TP10 locations.

翻译:这项研究提出一种新的 EEG 数据分类方法, 探索如何使用进化计算方法来选择有用的有区别的 EEG 特征, 优化人工神经网络的地形。 应用进化算法从最初的2550 EEG 统计特征组中选择最丰富的信息特征。 在对网络进行分类以估计最佳的超参数之前, 优化多层摄取( MLP) 。 还探索了与长期短期内存(LSTM) 进行深层次学习和调试的理念, 并且为每个问题测试了两种模型的适应推动。 提供了三种实验, 用于使用不同的分类器进行比较: 一个用于关注状态分类, 一个用于情感情绪分类, 第三个实验的目的是猜测一个主题的数值。 所获得的结果显示, 适应性推动LTM 能够达到84.44%, 97.01% 和 9.94 %, 用于关注、 情绪和数字组, 分别为: 进化- 进化- 高级 ELTP 的 ELTP 初选的 EEEG- dalalalalalaldalalal 和M- daldaldal- dal- daldaldaldaldaldaldaldaldal 。 两次的进进进进取取取取取取取取取取取取取取取取取取取取取取取取取取取取取取取取取的EV 两次高的 EV 。