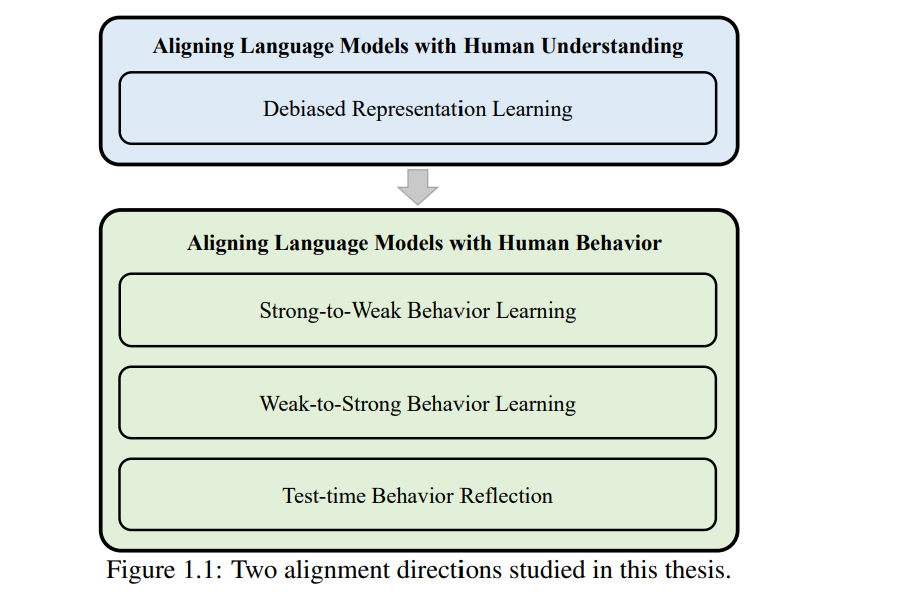

语言模型(LM)在自然语言处理领域取得了显著进展,但它们仍与人类的理解和行为存在偏差,从而限制了其在现实应用中的有效性。本论文从两个角度探讨了语言模型对齐的问题:其一是使模型的理解与人类对齐,其二是使模型的行为与人类对齐。具体而言,我们围绕四个关键主题展开研究:(i)通过去偏表示学习实现理解对齐;(ii)通过“强对弱”学习实现行为对齐;(iii)通过“弱对强”学习实现行为对齐;(iv)通过测试时行为反思实现行为对齐。 我们首先聚焦于微调过程中的表示对齐,提出了一个能够减少偏倚潜在特征并捕捉其动态影响的框架,从而提升模型在分布外数据上的泛化能力。接着,在“强对弱”学习的设定下,我们提出了一种行为对齐方法,用于提升知识密集型任务中的完整性、事实性和逻辑性,该方法融合了细粒度与粗粒度的知识信号。随后,我们研究了“弱对强”对齐的情境,即更强大的语言模型需从较弱的人类监督中学习。为此,我们引入了一种迭代式偏好优化策略,促进“弱教师”与“强学生”之间的互学机制。最后,我们在推理阶段关注模型行为的对齐,尝试缓解语言模型决策中的认知偏差。我们提出了一种包括三个连续步骤的方法——偏差识别、偏差分析与认知去偏——以迭代方式减少提示中的潜在认知偏差。 语言是人类的一项基本认知能力,使我们能够理解并交流多样且复杂的概念,这一能力使智人(Homo sapiens)有别于其他所有物种【59, 78, 104, 105, 218】。大约在五千年前,人类发明了书面语言【9, 131】,从而实现了信息在时间与空间上的保存与传播【93, 288】。在此基础上,自然语言处理(NLP)作为一个致力于使机器理解与生成自然语言的研究领域逐步发展起来【276】。早期的 NLP 系统主要依赖基于规则的方法,但自然语言本身的复杂性与歧义性带来了巨大挑战【110, 188】。近年来,语言模型(LM)取得了突破性进展,这主要得益于 Transformer 神经网络结构的提出【285】,以及模型规模、数据规模和训练时长的显著扩展【134】。 由此诞生的预训练语言模型(如 BERT【62】和 GPT-4【208】)构成了强大的通用语言理解与生成基础,可以方便地适配多种自然语言理解(NLU)【26, 272, 312】与自然语言生成(NLG)任务【28, 209, 221】。 强大语言模型的发展通常经历三个关键阶段:(i)预训练:语言模型通过自监督学习在大规模文本语料上进行训练,从中捕捉语言模式、结构与世界知识【124, 275】,这一阶段为语言模型提供了全面的语言与语境理解能力。(ii)微调:通过监督微调与偏好优化,在标注数据集上对预训练模型进行领域特定的适配【71, 209, 223】,以提升其在特定领域的性能,同时使其行为更符合人类偏好,并具备更强的指令跟随能力。(iii)提示工程:通过策略性设计任务特定的自然语言提示(prompts),实现对语言模型的调用,而无需修改模型参数【28, 305, 354】。尽管取得了诸多进展,近期研究发现语言模型在语言理解【23, 86, 101】和生成行为【29, 126, 273】方面仍存在对齐偏差,这些问题最终影响其有效性与可靠性。因此,本论文探索语言模型与人类理解及行为的对齐,如图 1.1 所示,重点关注微调与提示工程阶段。 我们首先探讨微调阶段语言模型与人类理解的对齐。虽然经过微调的语言模型【62, 168】在许多 NLU 基准任务(如自然语言推理,NLI【26, 312】)上取得了优异表现,研究表明这些模型往往依赖数据集中的偏差特征,而非人类真正关心的、与任务相关的语义特征【68, 190, 240】。例如,Gururangan 等人【101】发现,在 NLI 数据集中,语言模型倾向于利用负面词汇(如 nobody、no、never、nothing)与“矛盾”标签之间的虚假关联进行预测,导致模型在缺乏这种偏差的分布外数据上表现不佳。因此,我们旨在开发去偏表示学习方法,以减少表示中的偏差特征,并推动模型编码更多符合人类意图的、与任务相关的特征。 接下来我们研究语言模型在微调阶段与人类行为的对齐,尤其是在所谓的“强对弱”设定下。该设定的问题在于:经过微调的语言模型在处理复杂的知识密集型问答任务时,常常难以有效利用相关知识【16, 32, 42, 335】。已有研究表明,语言模型可能产生不完整的答案(知识覆盖不足)【25, 253, 321】,事实错误的答案(内容不符合事实)【197, 290, 291】,或逻辑混乱的答案(结构不连贯)【42, 132, 362】。这些问题源于模型在常规微调过程中缺乏对知识的深入理解。为了解决上述问题,我们提出了一种“强对弱”学习方法,以增强模型在微调过程中的细粒度与粗粒度知识感知能力。 随后,我们进一步探讨更具挑战性的“弱对强”设定下语言模型与人类行为的对齐问题。在这一设定中,目标是用由较弱人类智能体生成的弱标签,对更强大的语言模型进行微调。随着微调语言模型在某些任务上逐渐接近甚至超越人类水平【29, 31, 83】,使其行为符合人类价值观变得愈发紧迫。在语言模型能力超过人类的情境中,我们面临一个“弱对强”对齐问题:如何用噪声较大的弱监督信号,去有效对齐更强的模型。因此,我们探索“弱对强”学习方法,推动“弱教师”与“强学生”之间的互学机制,即通过迭代强化模型未熟悉的积极行为,并惩罚其熟悉的消极行为。 最后,我们将注意力转向测试阶段的提示工程,研究如何在该阶段实现语言模型行为与人类的对齐。语言模型在辅助决策方面展现出巨大潜力,尤其是在金融、医疗与法律等场景下作为个人助理的应用。虽然提示工程显著提升了语言模型在决策任务中的能力,但模型内部固有的认知偏差仍构成重大挑战。认知偏差是决策过程中系统性偏离理性或规范的行为模式,可能导致模型生成不准确的输出。当前先进的提示设计方法并未充分考虑语言模型中的认知偏差,因此这类偏差削弱了模型在决策任务中的可靠性。基于此,我们提出一种“测试时行为反思”(test-time behavior reflection)方法,依次执行三个步骤——偏差识别、偏差分析与认知去偏——以迭代方式缓解提示中的潜在认知偏差。 综上所述,本论文系统探讨了在不同场景下语言模型与人类理解与行为的对齐方法。研究结果强调了对齐方法在构建高效、可靠语言模型中的关键作用。