「八卦炉」炼丹规模直逼人脑!清华、阿里等搞了个174万亿参数大模型

![]()

新智元报道

新智元报道

编辑:David 好困

【新智元导读】手头只有鸡蛋和葱花,如何做出满汉全席?

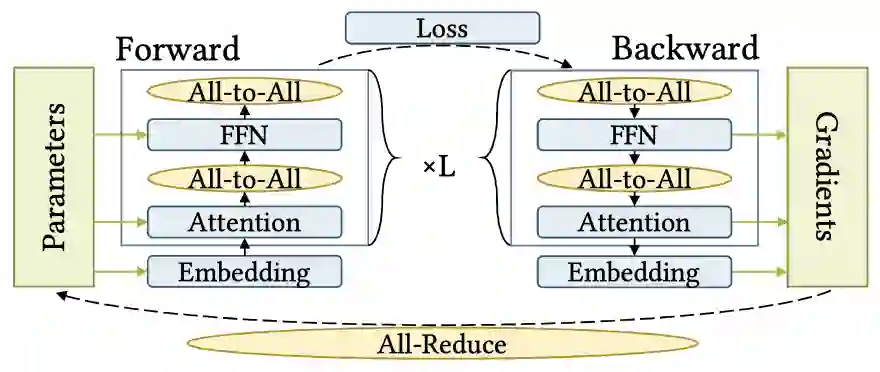

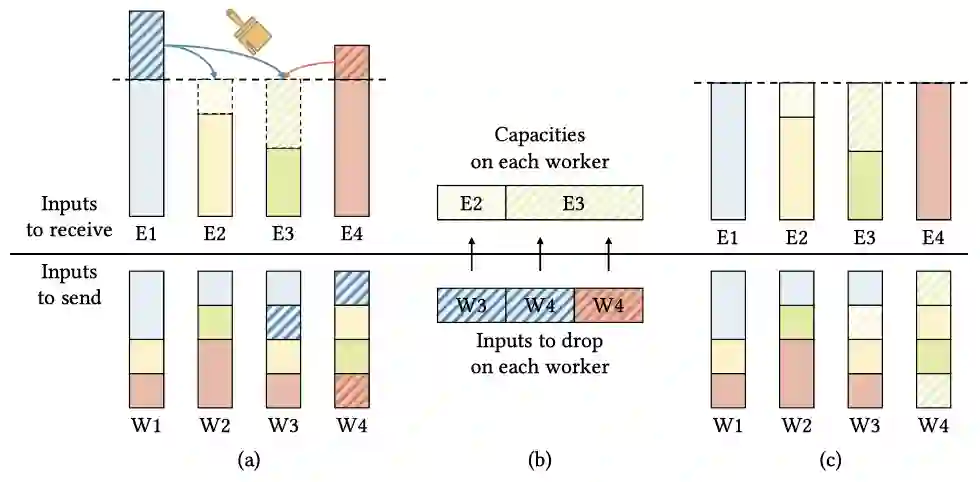

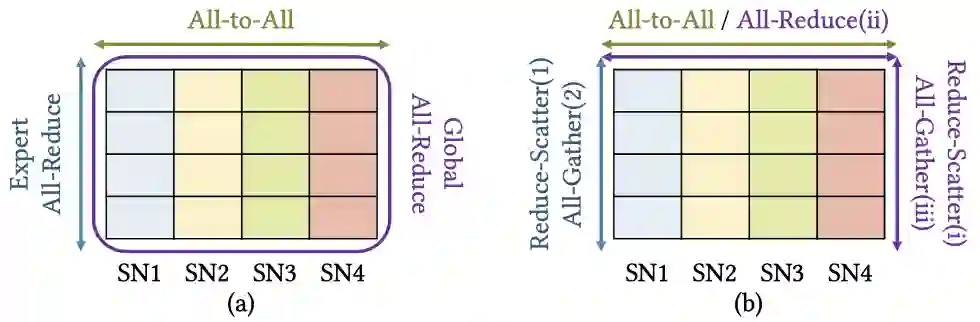

实现方法和结果

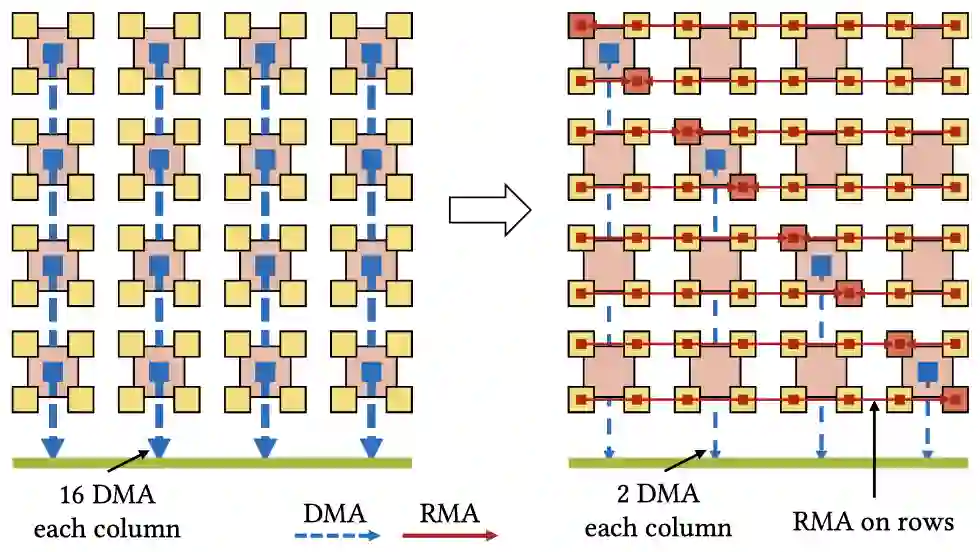

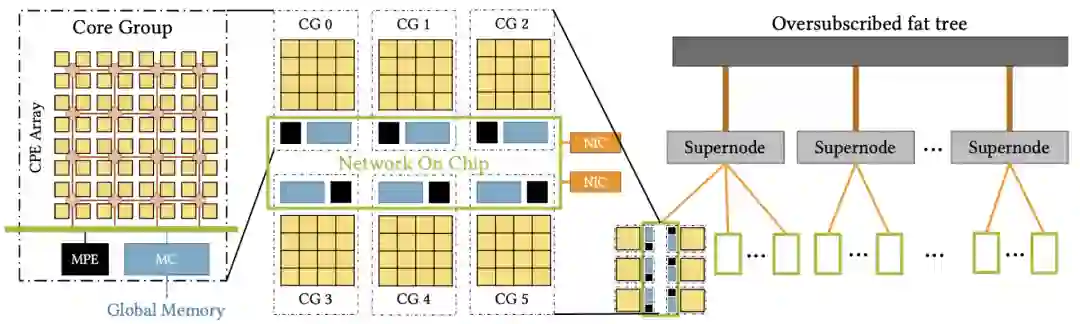

硬件的节点内优化

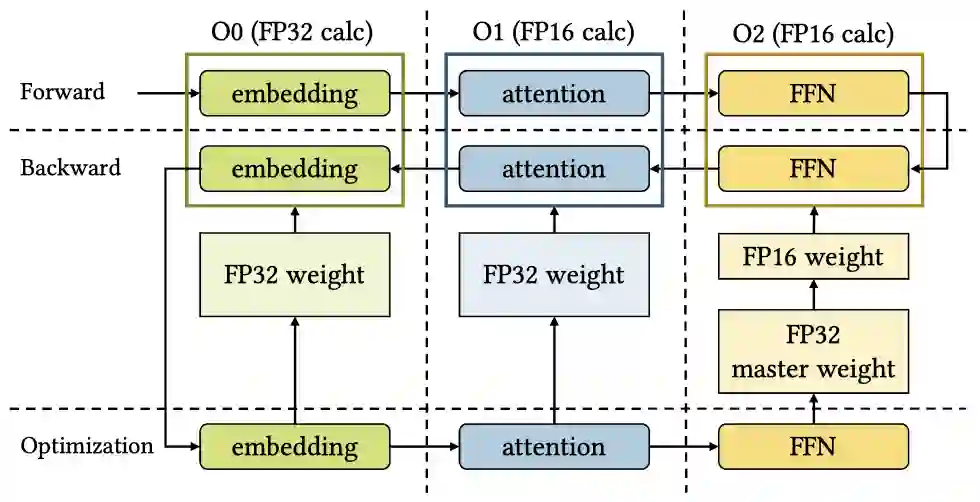

混合精度训练

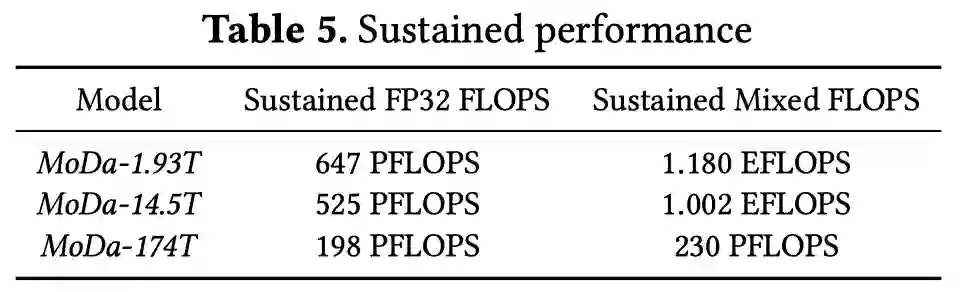

结果评估

14纳米芯片,也能造E级超算

能否超越美国?

通信作者

参考资料:

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月15日

Arxiv

10+阅读 · 2021年10月4日