哈工大讯飞联合实验室发布中文XLNet预训练模型

声明: 本文转载自公众号 哈工大讯飞联合实验室

为了进一步促进中文信息处理发展,哈工大讯飞联合实验室(HFL)发布在大规模语料上训练的首个中文XLNet预训练模型,填补了该模型在中文自然语言处理领域的空白,同时该预训练模型在中文机器阅读理解等任务中获得显著性能提升。我们欢迎各界同行下载使用并共同参与建设中文资源。

下载地址:

https://github.com/ymcui/Chinese-PreTrained-XLNet

摘要

哈工大讯飞联合实验室在前不久发布了基于全词Mask的中文预训练模型BERT-wwm以及BERT-wwm-ext模型,受到业界广泛关注及下载使用,在此表示衷心的感谢。为了进一步提升中文自然语言处理任务效果,推动中文信息处理发展,我们使用大规模中文语料训练了首个中文XLNet预训练模型,填补了该模型在中文自然语言处理领域的空白。经过我们的初步实验证明该模型在中文机器阅读理解任务中获得了显著性能提升。

预训练细节

本次发布的中文XLNet模型采用了24层Transformer结构,总参数量为209M。预训练数据总词数达到5.4B。训练时采用的最大长度为512,总训练步数达到2M步,batch size为32。训练采用了谷歌Cloud TPU v3版本(128G HBM),总训练时长约3周。为了保证结果的可靠性,在下游任务精调过程中,对于同一模型,我们运行10遍(不同随机种子),汇报模型性能的最大值和平均值。

基线测试结果

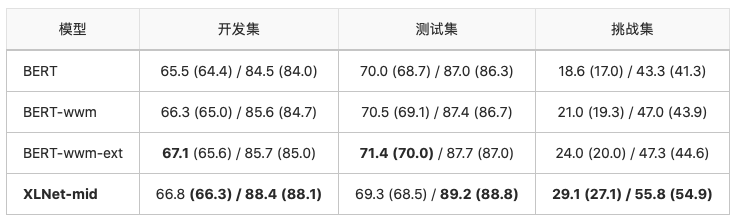

中文简体阅读理解:CMRC 2018

CMRC 2018是哈工大讯飞联合实验室发布的中文机器阅读理解数据,前不久被EMNLP-IJCNLP 2019录用。根据给定问题,系统需要从篇章中抽取出片段作为答案,形式与SQuAD相同。可以看到XLNet模型相比于BERT以及我们发布的BERT-wwm、BERT-wwm-ext模型均有显著的性能提升,尤其是在挑战集合上涨幅非常明显。

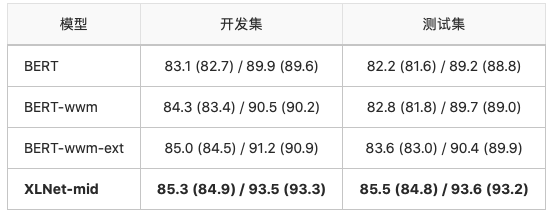

中文繁体阅读理解:DRCD

DRCD数据集由中国台湾台达研究院发布,其形式与SQuAD相同,是基于繁体中文的抽取式阅读理解数据集。我们同样可以看到XLNet相比于BERT系列模型有非常显著的性能提升。

情感分类:ChnSentiCorp

ChnSentiCorp是一个中文情感分类数据集,是一个二分类任务。我们可以看到XLNet获得了较优的结果,尤其是在平均效果上获得较为显著的性能提升。

后记

由于时间以及资源有限,我们仅在上述数据集上验证了实验效果。我们欢迎各位专家学者下载试用并加入到本开源项目中,进一步丰富与促进中文资源的建设与发展。

延伸阅读

本期责任编辑:李忠阳

本期编辑:李照鹏

“哈工大SCIR”公众号

主编:车万翔

副主编:张伟男,丁效

执行编辑:李家琦

责任编辑:张伟男,丁效,崔一鸣,李忠阳

编辑:赖勇魁,李照鹏,冯梓娴,王若珂,顾宇轩

长按下图并点击 “识别图中二维码”,即可关注哈尔滨工业大学社会计算与信息检索研究中心微信公众号:”哈工大SCIR” 。