加入极市专业CV交流群,与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度 等名校名企视觉开发者互动交流!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

◎极市「论文推荐」专栏,帮助开发者们推广分享自己的最新工作,欢迎大家投稿。联系极市小编(fengcall19)即可投稿~

视频是具有时间连续性的图像集合,其中每帧图像的上下文信息(空域信息)与不同帧之间的互补信息(时域信息)都有助于提升视频超分辨的性能。近日,来自国防科技大学的学者提出基于可变形三维卷积的视频超分辨网络(D3Dnet),通过将可变形卷积(Deformable Convolution)和三维卷积(3D Convolution)有机结合,同时实现高效时空信息建模与灵活帧间运动补偿。实验表明,该网络生成视频的清晰度、流畅度与网络的运行效率均处于领域先进水平。论文信息如下:

论文链接:

https://arxiv.org/pdf/2004.02803.pdf

代码链接:

https://github.com/XinyiYing/D3Dnet

引言(Introduction)

随着当前高分辨率视频的需求增多,视频超分辨技术被广泛应用于视频监控与高清影音设备中。相较于单幅图像超分辨,视频超分辨的核心与难点在于充分利用时域互补信息。然而,视频的帧间运动给该任务带来了较大的挑战。

现有的视频超分辨算法大多是两阶段的(two-stage),即先在空域进行特征提取,然后在时域进行帧间运动补偿。此类框架无法充分结合视频序列内的时空信息,从而限制了超分辨性能,降低了输出视频序列的流畅性。

针对以上问题,该文提出可变形三维卷积网络(D3Dnet)实现单阶段(one-stage)的视频超分辨,即使用可变形三维卷积(D3D)对时空信息进行渐进式融合,并自适应地完成帧间运动补偿。该文在公开数据集Vid4,Vimeo-90K,SPMC-11上对所提算法进行了测试评估,实验结果表明,相比于领域内其他先进算法,D3Dnet能够重建出精度更高且更加流畅的视频序列,同时具有合理的参数量与较高的运行效率。

方法(Method)

1、可变形三维卷积(D3D)

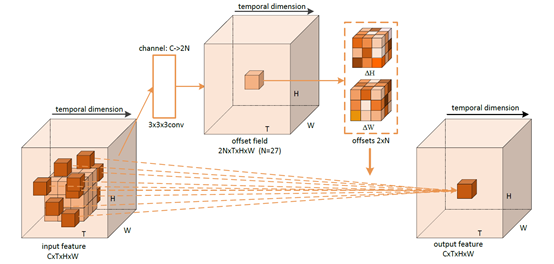

如图1所示,D3D将可变形二维卷积(Deformable Convolution, DCN)与三维卷积(3D Convolution, C3D)进行结合,输入特征中的浅橙色立方体代表3×3×3的C3D卷积核,深橙色立方体代表3×3×3的D3D卷积核。其中,D3D卷积核的偏移量(offset)由偏移量生成器(3×3×3的C3D卷积)产生。如图1上方部分所示,位于偏移空间(offset field)的特征的通道维度为2N(此处N为27),代表对应3×3×3卷积核在高度H和宽度W上的偏移量。

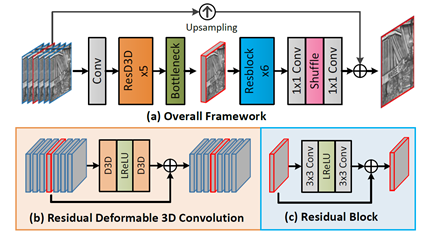

基于D3D,该文构建了D3Dnet,如图2所示。首先,将7帧视频序列送入C3D进行初始特征提取。随后,将提取的特征输入5个级联的残差D3D模块(ResD3D),同时实现时空信息进行提取与帧间运动补偿。而后,采用瓶颈层(bottleneck)将运动补偿后的视频特征进行融合,并将融合后的特征送入6个级联的残差块(Resblock)进行重建。最后,将重建后的特征依次输入1×1卷积层,pixel-shuffle层,1×1卷积层,得到高分辨率参考帧图像。

实验(Experiments)

1、消融学习(Ablation Study)

实验部分首先通过消融学习对网络中不同模块和方案的有效性进行验证。

1)双阶段方法(two-stage)和单阶段方法(C3D,D3D)。

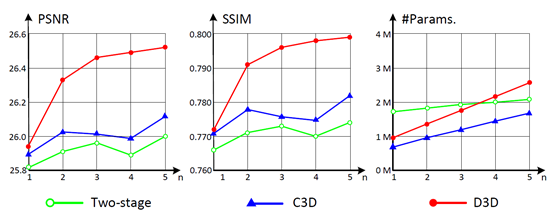

图3 双阶段方法(two-stage)和单阶段方法(C3D, D3D)性能对比,

横坐标代表模型中的残差模块的数量。

图3实验表明,相较于two-stage 算法,one-stage算法能够更加充分地利用视频中的时空信息,以较少的参数获得更好的性能;相较于C3D,D3D能够灵活地提取时空信息,有效对帧间运动进行补偿,获得质量更高的超分辨视频序列。

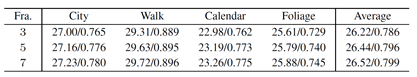

表1实验表明,输入视频帧数的增加引入了更多的时域信息,从而提升了超分辨性能。

2、算法对比(Comparison to the State-of-the-arts)

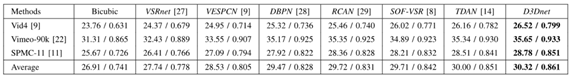

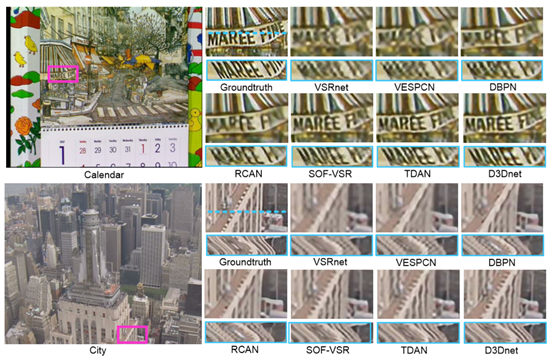

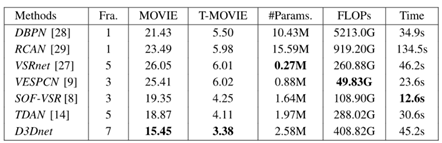

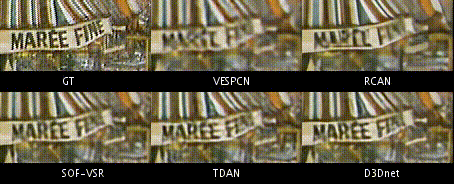

该文在表2所示的3个公开数据集上将D3Dnet与单帧超分辨算法DBPN(CVPR18)、RCAN(ECCV18)以及视频超分辨算法VSRnet(TCI16),VESPCN(CVPR17),SOF-VSR(TIP20),以及TDAN(CVPR20)进行了比较。此外,该文还采用了双三次插值的结果作为基准对照组。算法对比的结果如下。

表2 不同超分辨方法数值结果比较(PSNR/SSIM)

表3 不同超分辨方法生成的视频流畅度和运行效率比较

与单帧超分辨算法DBPN(CVPR18)、RCAN(ECCV18)相比,D3Dnet具有优异的性能和运行效率。与视频超分辨算法TDAN(CVPR20)、SOF-VSR(TIP20)相比,D3Dnet通过合理增加计算成本进一步提升了视频超分辨的性能(更高的PSNR/SSIM指标、更好的视觉效果、更优的视频流畅度)。

结论(Conclusion)

该文提出基于可变形三维卷积的视频超分辨网络(D3Dnet),通过将可变形卷积与三维卷积相结合,设计了可变形三维卷积(D3D)以同时进行时空信息提取与帧间运动补偿。D3Dnet结构简单、设计精巧,相比于领域内其他先进算法,在不大幅度增加计算开销的前提下,显著提升了视频超分辨的性能。得益于较好的时空建模与帧间运动补偿能力,D3Dnet输出的视频具有更高的流畅度。

![]()

添加极市小助手微信

(ID : cv-mart)

,备注:

研究方向-姓名-学校/公司-城市

(如:目标检测-小极-北大-深圳),即可申请加入

极市技术交流群

,更有

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、

干货资讯汇总、行业技术交流

,

一起来让思想之光照的更远吧~

觉得有用麻烦给个在看啦~

![]()