Label Smoothing分析

点击上方“CVer”,选择加"星标"置顶

重磅干货,第一时间送达

本文作者:王峰 | 编辑:Amusi

https://zhuanlan.zhihu.com/p/302843504

本文已由原作者授权,不得擅自二次转载

有挺多人问过我一个问题:Label Smoothing在图像识别中能稳定涨点,在人脸的loss里加上Label Smoothing是否有用呢?

我挺早之前就注意到了这件事,当时也做了实验,发现直接应用在人脸相关的loss上,是掉点的。其实DL发展到现在,可以说如果你想到了一个非常简单的排列组合式idea,而经过survey没见过别人这么做,那大概率这个方法是不work的...

但这事到这当然不算完,我们得分析一下它为啥不work。

要引出Label Smoothing,首先我们要知道,Softmax Cross Entropy不仅可以做分类任务(目标为one-hot label),还可以做回归任务(目标为soft label)。设网络输出的softmax prob为p,soft label为q,那Softmax Cross Entropy定义为:

而Label Smoothing虽然仍是做分类任务,但其目标q从one-hot label变为soft label了,原来是1的位置变为

假设一个6分类任务,之前的

这个问题其实在概率层面上是没法解释的,从概率上看,确实会有发生反向优化的情况,但为什么这样可以涨点呢?

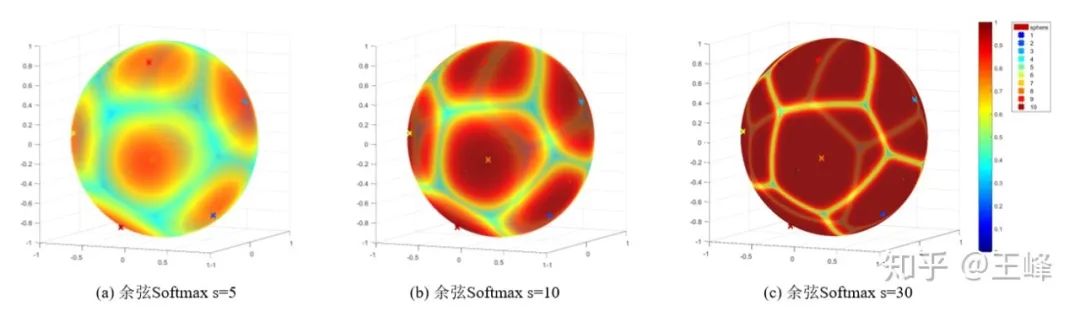

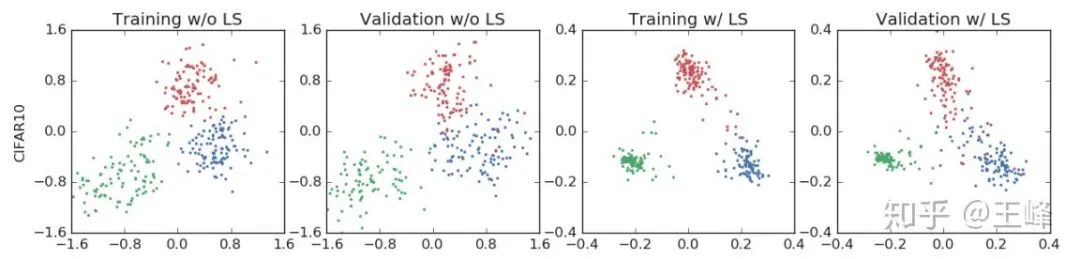

看看Hinton组对Label Smoothing的分析文章[1],里面有一张图比较有意思:

熟悉人脸识别loss的人会发现,这个Label Smoothing得到的特征分布,怎么跟人脸loss的效果这么像?竟然都可以起到让每个类别的样本聚拢的效果。

而少数细心的朋友可能会发现这里的玄机:不做Label Smoothing(标注为w/o LS)的feature norm,普遍比做了LS(标注为w/ LS)的要大很多!w/o LS时最大可以达到1.6,而w/ LS时只有0.4。

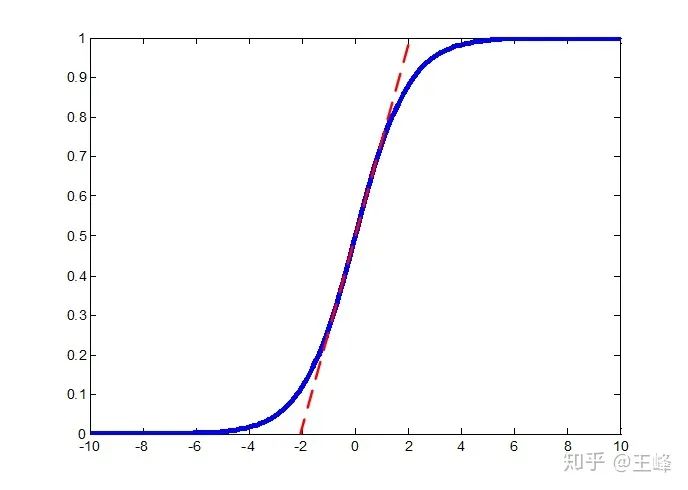

回顾之前的文章,减小feature norm实际上等效于降低s,较低的s会使softmax prob的最大值降低,如下图所示(来自于https://zhuanlan.zhihu.com/p/52108088 ):

可以看到,在较低的s的作用下,任何一个点,都不可能达到0.9以上的概率。也就是说,我们之前所担心的反向优化问题,实际上根本不会发生!即使优化到最好,也只能接近0.9,而到不了1。

但同时要注意到,Label Smoothing也并不要求p优化到1,而是优化到0.9即可。Softmax Cross Entropy 的loss曲线其实跟sigmoid类似,越靠近1的时候,loss曲线会越平缓:

而在设置了

但是在人脸识别的loss里,s通常是固定住的,而且会固定在一个比较大的值上(例如32、64),这样Label Smoothing就无法让s降低来使最大概率降低,于是反向优化在人脸的loss上就成了真的会发生的事情:p>0.9后,loss会把特征往回拉,直至落在p=0.9附近震荡。理论上特征会在类中心周围形成一个环形的分布(我懒得做实验了,有兴趣的朋友可以做一个看看)。

总结一下,Label Smoothing起到的作用实际上是抑制了feature norm,此时softmax prob永远无法达到设定的

参考

^When Does Label Smoothing Help? https://arxiv.org/pdf/1906.02629.pdf

下载:CVPR / ECCV 2020开源代码

在CVer公众号后台回复:CVPR2020,即可下载CVPR 2020代码开源的论文合集

在CVer公众号后台回复:ECCV2020,即可下载ECCV 2020代码开源的论文合集

重磅!CVer-论文写作与投稿交流群成立

扫码添加CVer助手,可申请加入CVer-论文写作与投稿 微信交流群,目前已满2400+人,旨在交流顶会(CVPR/ICCV/ECCV/NIPS/ICML/ICLR/AAAI等)、顶刊(IJCV/TPAMI/TIP等)、SCI、EI、中文核心等写作与投稿事宜。

同时也可申请加入CVer大群和细分方向技术群,细分方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch和TensorFlow等群。

一定要备注:研究方向+地点+学校/公司+昵称(如论文写作+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲长按加微信群

▲长按关注CVer公众号

整理不易,请给CVer点赞和在看!