AF-GCL:不需要增强的图对比学习

©作者 |

GeorgeM

©作者 |

GeorgeM论文链接:

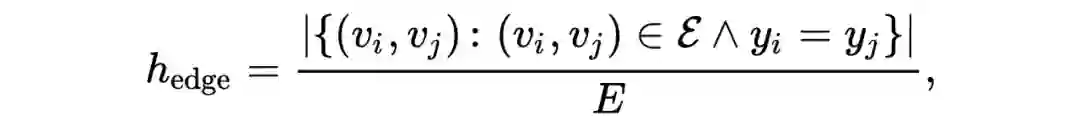

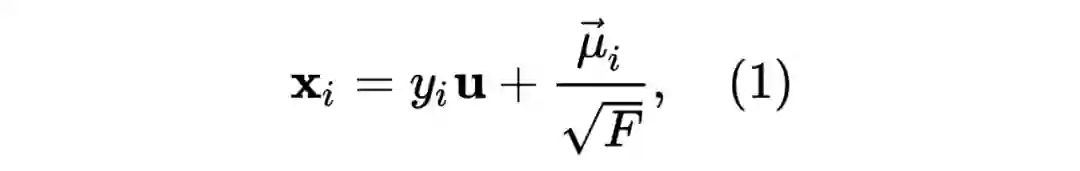

我们定义两种图同质性的衡量标准:点同质性(node homophily)和边同质性(edge homophily)。边同质性定义为连接两个同类顶点的边所占的比例:

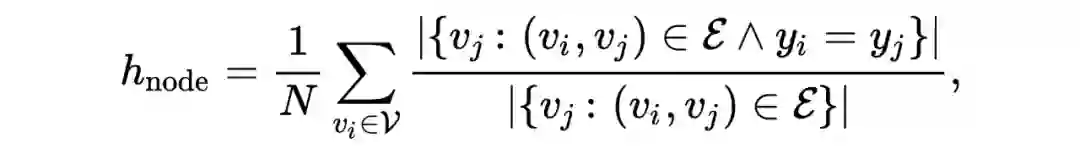

而边同质性定义为:

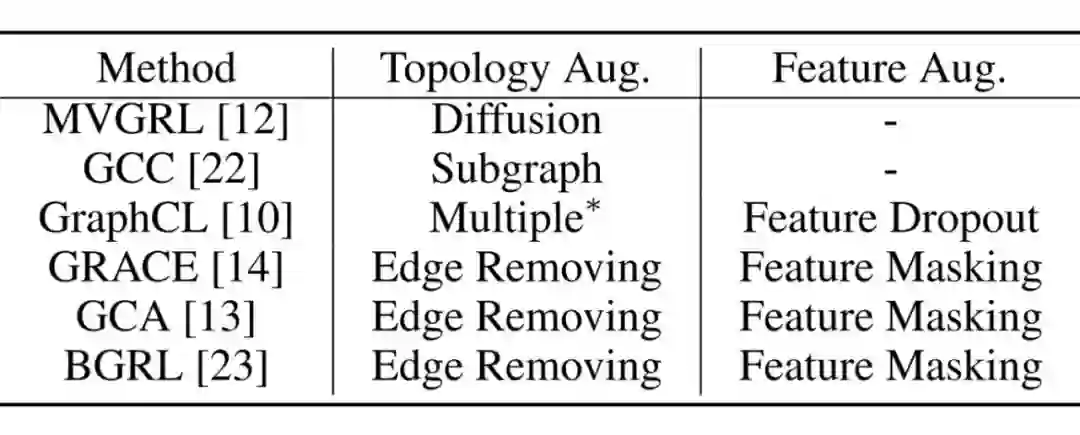

▲ 表1:图对比学习模型中图增强方法的总结。Multiple* 表示采用了多种增强方法,包括删边、加边、删点和随机游走生成子图。

-

属性遮挡(Attibute Masking):随机遮挡节点特征的一部分。 加/删边(Edge Adding/Dropping):随机增/删原始图的一部分边。

-

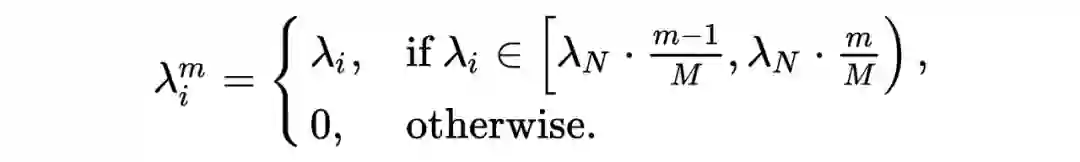

图扩散(Graph Diffusion):基于个性化 PageRank(PPR)的图扩散定义为 , 其中 是扩散系数。

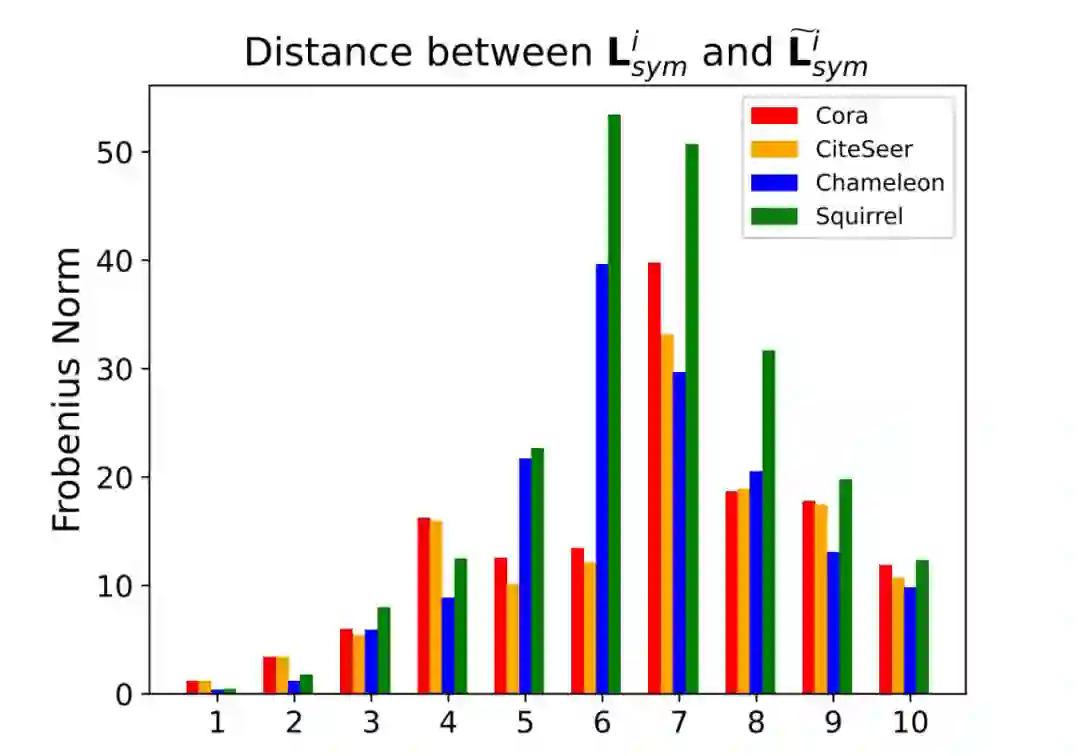

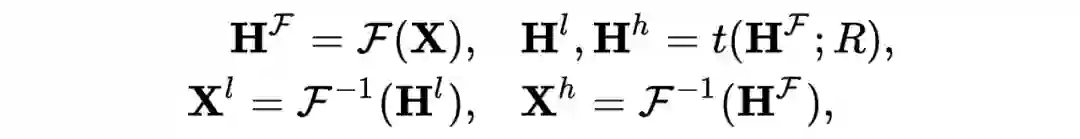

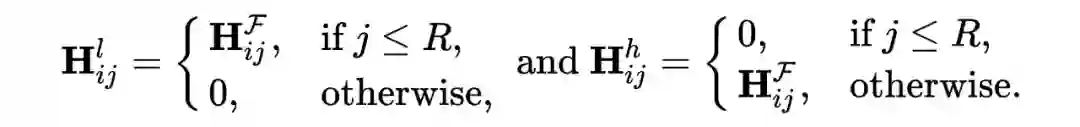

▲ 表2:在 30% 的属性遮挡下,原始节点特征和增强节点特征的距离。我们设定 R=0.8×F。

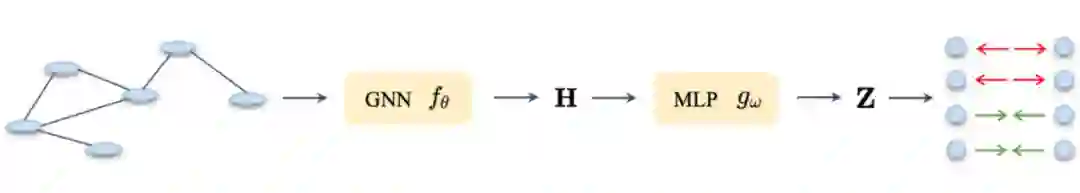

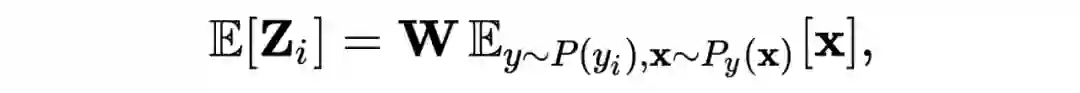

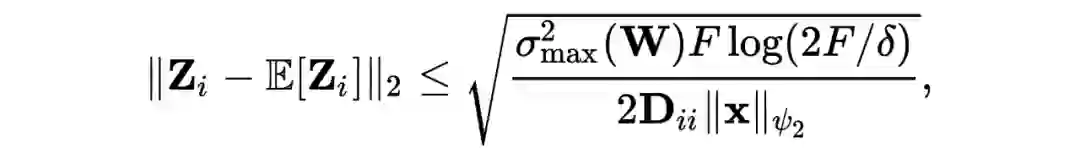

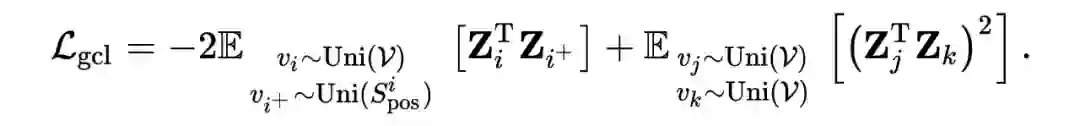

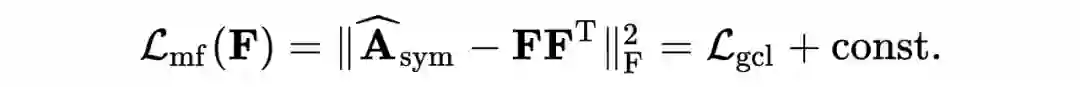

由于隐藏表示(hidden representation)是正则化的,隐藏表示的内积就等于余弦相似度(cosine similarity)。目标函数为:

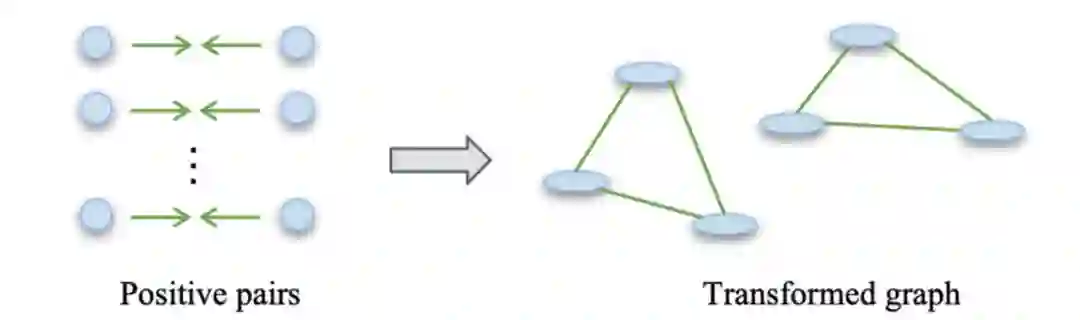

▲ 图3:由正样本对形成的变换图。

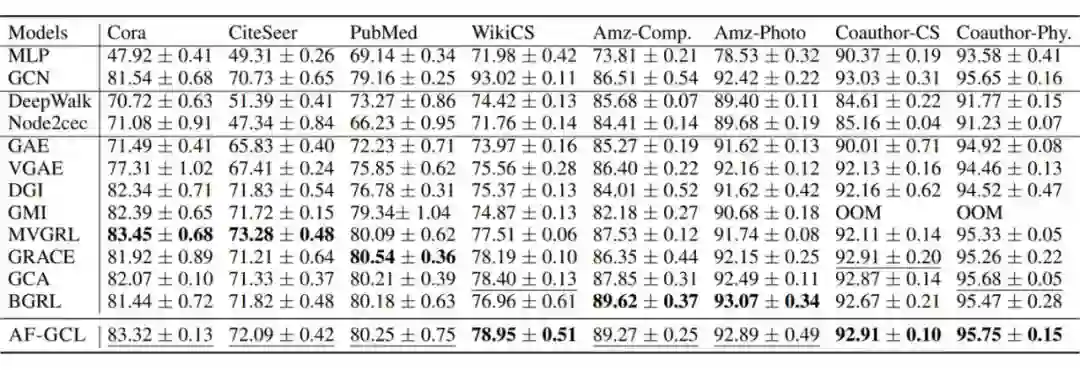

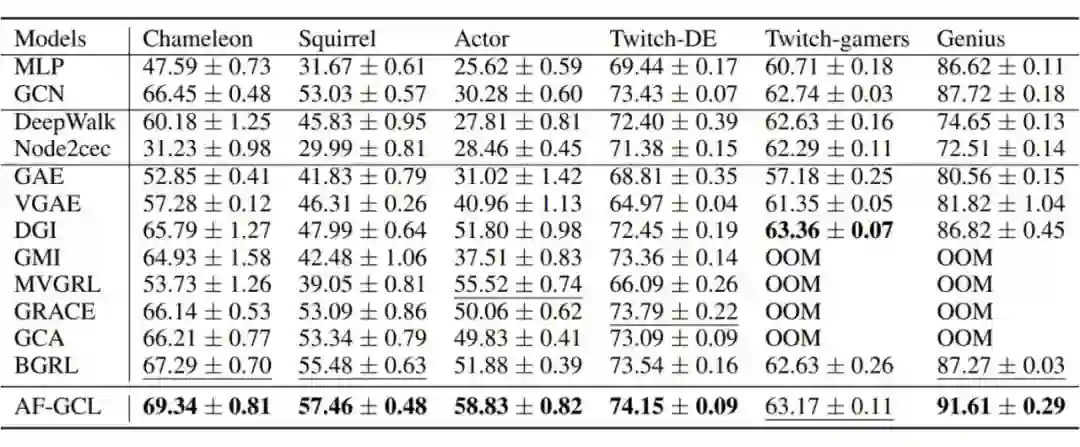

▲ 表3:同质图上的图对比学习实验结果。无监督的最优结果用粗体标出。OOM 表示在 32 GB 的 GPU 上内存溢出。

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年7月28日

Arxiv

11+阅读 · 2021年9月24日