【EMNLP2020】开放领域对话的数据增广的方法:“对话蒸馏”

标题:Dialogue Distillation: Open-domain Dialogue Augmentation Using Unpaired Data

作者:张荣升,郑银河(共同第一作者),邵建智,毛晓曦,席亚东,黄民烈

关键词:对话系统,数据增广,模型蒸馏

类型:EMNLP 2020, Long Paper

论文地址:https://arxiv.org/abs/2009.09427

GitHub: https://github.com/njuzrs/dialogue_distillation

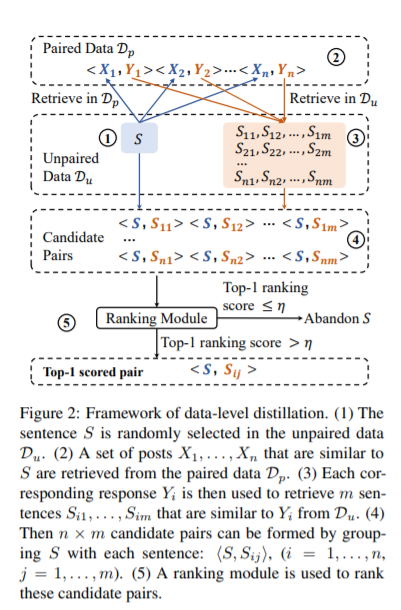

简介:目前开放领域对话模型的训练过程极大地依赖于大规模对话数据,但是,收集高质量的对话数据是非常消耗人力和物力的事情。本文中,我们提出了一个可适用于开放领域对话的数据增广的方法:“对话蒸馏”。我们的方法中使用了非平行数据来增广对话对。具体来说,我们首先设计了一个数据层面的蒸馏过程,在这一过程中,我们根据现有的对话对,在非配对数据中检索相似的句子,从而组成增广后的对话对。我们还提出了一个模型层面的蒸馏过程,这一过程中我们首先使用少量高质量的对话数据训练得到了一个Teacher模型,然后再基于增广后的数据,将这一teacher模型蒸馏到一个student模型中。自动和人工评测均表明,我们的方法可以生成高质量的增广数据,并且我们所提出的对话蒸馏方法可以进一步帮我们提升开放领域对话模型的性能。(注:与网易伏羲实验室合作)

参考链接:

https://mp.weixin.qq.com/s/kSZR-lRfQ_bhsZTZT8ePgw

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“OPDA” 可以获取《【EMNLP2020】开放领域对话的数据增广的方法:“对话蒸馏”》专知下载链接索引