![]()

©PaperWeekly 原创 · 作者 |

苏剑林

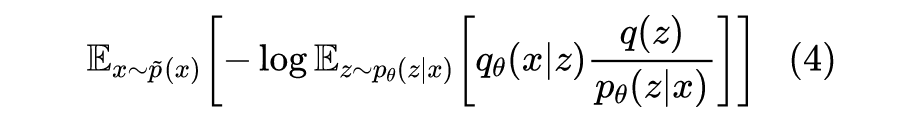

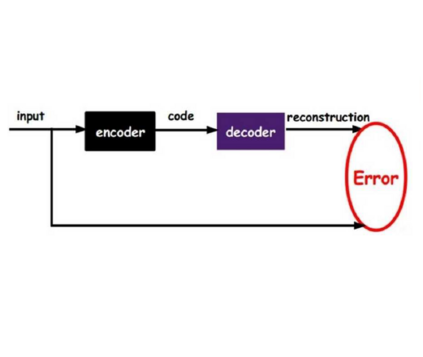

在本系列的前面几篇文章中,我们已经从多个角度来理解了 VAE,一般来说,用 VAE 是为了得到一个生成模型,或者是做更好的编码模型,这都是 VAE 的常规用途。但除了这些常规应用外,还有一些“小众需求”,比如用来估计

的概率密度,这在做压缩的时候通常会用到。

本文就从估计概率密度的角度来了解和推导一下 VAE 模型。

![]()

两个问题

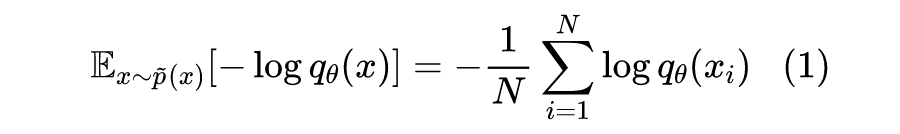

所谓估计概率密度,就是在已知样本

的情况下,用一个待定的概率密度簇

去拟合这批样本,拟合的目标一般是最小化负对数似然:

但这纯粹都只是理论形式,还有诸多问题没有解决,主要可以归为两个大问题:

![]()

第一个问题,我们自然是希望

的拟合能力越强越好,最好它有能力拟合所有概率分布。然而很遗憾的是,神经网络虽然理论上有万能拟合能力,但那只是拟合函数的能力,并不是拟合概率分布的能力,概率分布需要满足

,后者通常难以保证。

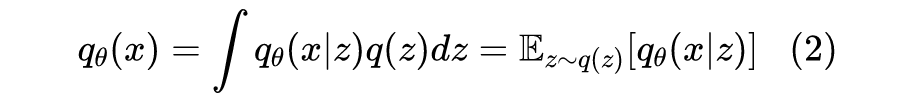

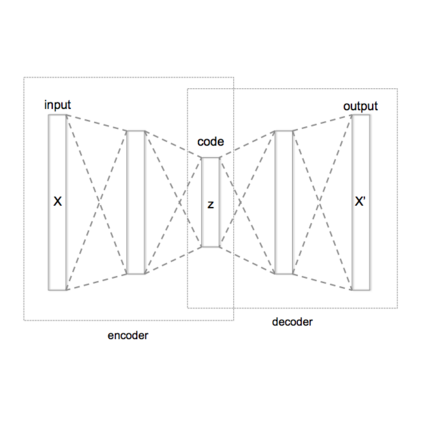

直接的做法做不到,那么我们就往间接的角度想,构建混合模型:

![]()

其中

通常被选择为无参数的简单分布,比如标准正态分布;而

则是带参数的、以

为条件的简单分布,比如均值、方差跟

相关的标准正态分布。

从生成模型的角度来看,上述模型被解释为先从

中采样

,然后传入

中生成

的两步操作。但本文的焦点是估计概率密度,我们之所以选择这样的

,是因为它有足够的拟合复杂分布的能力,最后的

表示为了多个简单分布

的平均,了解高斯混合模型的读者应该知道,这样的模型能够起到非常强的拟合能力,甚至理论上能拟合任意分布,所以分布的拟合能力有保证了。

![]()

但式(2)是无法简单积分出来的,或者说只有这种无法简单显式地表达出来的分布,才具有足够强的拟合能力,所以我们要估计它的话,都要按照

的方式进行采样估计。然而,实际的场景下,

和

的维度比较高,而高维空间是有“维度灾难”的,这意思是说在高维空间中,我们哪怕采样百万、千万个样本,都很难充分地覆盖高维空间,也就是说很难准确地估计

。

为此,我们要想办法缩小一下采样空间。首先,我们通常会将

的方差控制得比较小,这样一来,对于给定

,能够使得

比较大的

就不会太多,大多数

算出来的

都非常接近于零。于是我们只需要想办法采样出使得

比较大的

,就可以对

进行一个比较好的估计了。

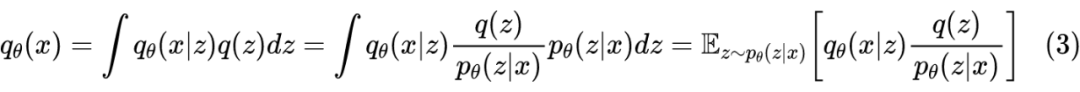

具体来说,我们引入一个新的分布

,假设使得

比较大的

服从该分布,于是我们有

![]()

这样一来我们将从

“漫无目的”的采样,转化为从

的更有针对性的采样。由于

的方差控制得比较小,所以

的方差自然也不会大,采样效率是变高了。注意在生成模型视角下,

被视为后验分布的近似,但是从估计概率密度的视角下,它其实就是一个纯粹的重要性加权函数罢了,不需要特别诠释它的含义。

![]()

至此,我们解决了第一个问题:用什么分布,以及怎么去更好地计算这个分布。剩下的问题就是如何训练了。

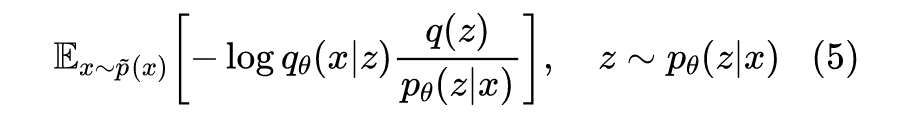

其实有了重要性采样的概念后,我们就不用考虑什么 ELBO 之类的了,直接使用目标(1)就好,代入

的表达式得到:

![]()

事实上,如果

这一步我们通过重参数只采样一个

,那么训练目标就变成:

![]()

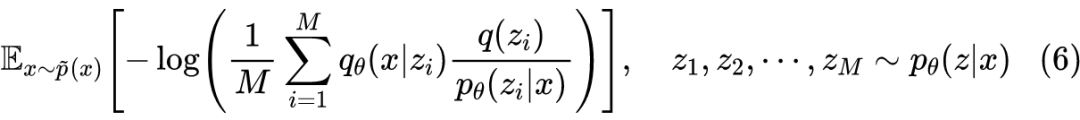

这其实已经就是常规 VAE 的训练目标了。如果采样

个,那么就是:

![]()

这就是“重要性加权自编码器”了,出自《Importance Weighted Autoencoders》

[1]

,它被视为 VAE 的加强。总的来说,通过重要性采样的角度,我们可以绕过传统 VAE 的 ELBO 等繁琐推导,也可以不用《变分自编码器(二):从贝叶斯观点出发》所介绍的联合分布视角,直接得到 VAE 模型甚至其改进版。

![]()

本文从估计样本的概率密度这一出发点介绍了变分自编码器 VAE,结合重要性采样,我们可以得到 VAE 的一个快速推导,完全避开 ELBO 等诸多繁琐细节。

[1] https://arxiv.org/abs/1509.00519

![]()

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

![]()

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

![]()