【CVPR2023】自异构融合知识挖掘的长尾视觉识别

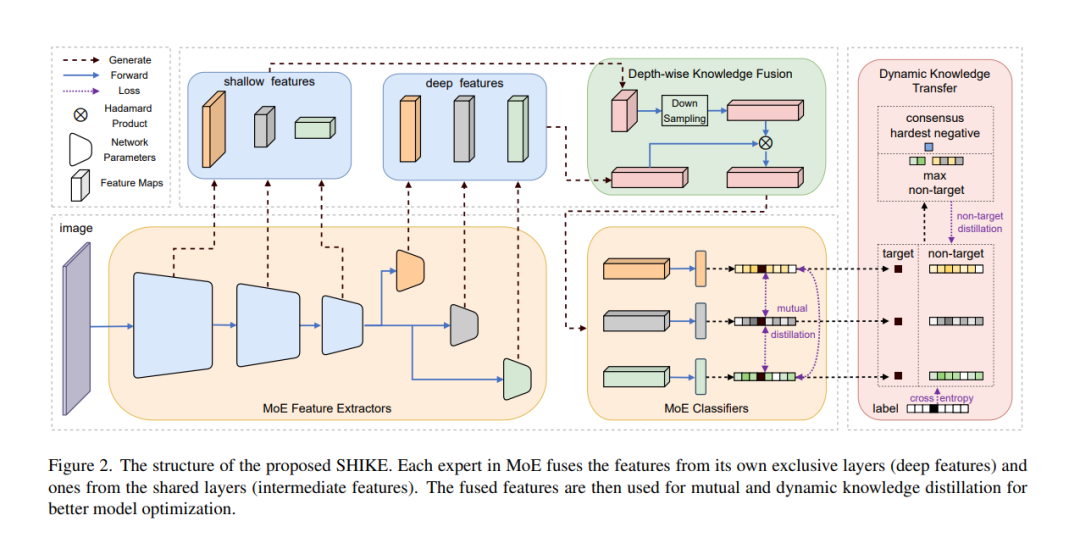

深度神经网络在过去几十年里取得了巨大的进步。然而,由于现实世界的数据往往呈现长尾分布,普通深度模型往往严重偏向于大多数类别。为了解决这个问题,最先进的方法通常采用混合专家(MoE)来关注长尾分布的不同部分。这些方法的专家模型深度相同,忽略了不同类别对不同深度模型拟合的偏好可能不同的事实。为此,提出一种基于知识挖掘的自异构融合方法(Self-Heterogeneous Integration with Knowledge Excavation, SHIKE)。首先提出深度知识融合(deep Knowledge Fusion, DKF),为每个专家在一个网络中融合不同浅层和深层的特征,使专家在表示上更具多样性;基于DKF,进一步提出动态知识迁移(DKT),以减少最难的负类的影响,在MoE框架中,该类对尾部类有不可忽视的影响。因此,可以显著提高长尾数据的分类精度,特别是对于尾部类。SHIKE在CIFAR100-LT (IF100)、ImageNet-LT、iNaturalist 2018和Places-LT上分别取得了56.3%、60.3%、75.4%和41.9%的最先进性能。源代码可以在https://github.com/jinyan-06/SHIKE上找到。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复或发消息“SHKE” 就可以获取《【CVPR2023】自异构融合知识挖掘的长尾视觉识别》专知下载链接

登录查看更多

相关内容

Arxiv

37+阅读 · 2021年5月28日