近年来,大型语言模型(LLMs)已在众多领域和任务中取得了超越人类的表现,释放了其在现实世界中的应用潜力。然而,模型的鲁棒性与可信度问题阻碍了其可靠部署。鲁棒性问题指的是模型在同等条件下表现出的不一致性,例如对细微提示词变动的敏感性。可信度问题则涵盖诸如幻觉现象(即模型生成与事实不符或与输入内容相矛盾的输出)以及公平性问题,包括模型对特定种族、性别、价值体系或语言的偏见。解决这些挑战,对于基于这些强大而脆弱模型构建可靠应用至关重要。本教程最后将概述该领域的未来研究方向。

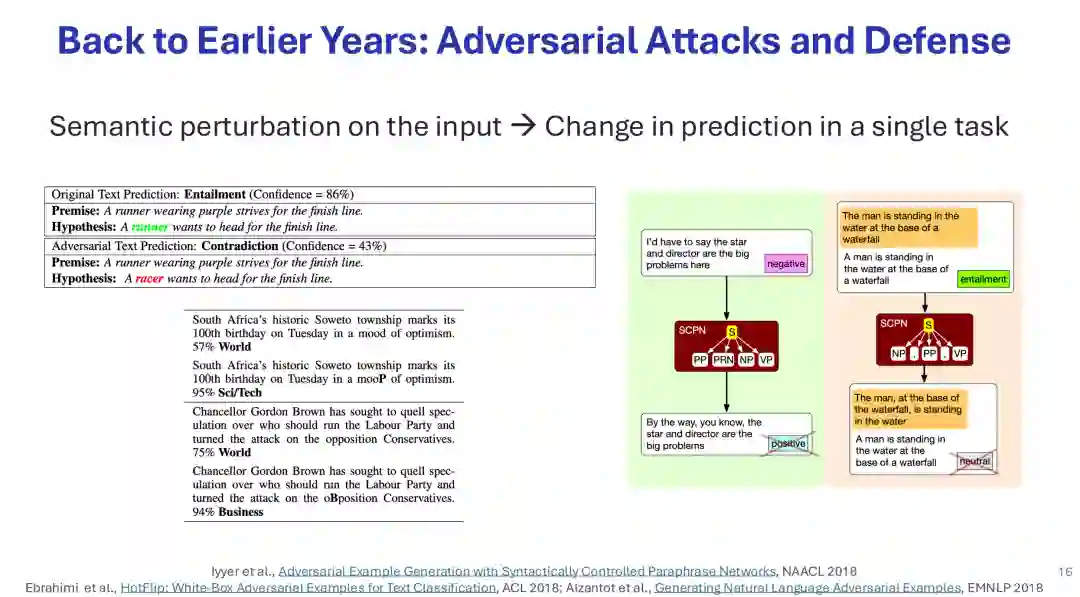

报告主要涵盖以下关键议题: 1. 攻击与越狱

探讨了如何通过对抗性后缀(如GCG方法)、可读对抗提示(如AutoDAN)、手动或自动生成的越狱提示(如DAN、符号数学注入、多语言攻击等)来绕过模型的安全对齐。防御策略包括输入扰动与多数投票、提示重写、以及使用安全护栏进行输入输出过滤。

2. 机器遗忘

研究如何使模型“忘记”敏感、有害或受版权保护的信息,避免重新训练的高成本。方法包括梯度上升、负偏好优化(NPO),以及结合知识定位的针对性遗忘。报告同时指出,评估模型是否真正“遗忘”仍需考虑其是否仅拒绝回答而非真正失去知识。

3. 幻觉问题

分析了幻觉的定义(事实性幻觉与忠实性幻觉)、产生原因(预训练数据缺陷、评估指标鼓励猜测、微调分布影响、推理时的滚雪球效应)以及检测与缓解方法。检测工具包括FactScore、D-FActScore、SimpleQA、MiniCheck和FaithBench;缓解策略涵盖训练阶段的拒绝感知微调(如R-Tuning)、基于偏好的优化,以及推理时的解码算法(如DoLa、上下文感知解码)。

4. 提示词鲁棒性

指出模型对提示词的格式、结构或同义改写非常敏感,这会影响模型性能排名和评估可靠性。解决方案包括采用多提示评估(如MaxP、AvgP)和“先生成后格式化”的两步推理策略。

5. 位置与顺序偏见

模型倾向于依赖信息在上下文中的位置(如首因/近因效应),这在少样本示例顺序、检索增强生成文档排序和多项选择题选项排列中均有体现。缓解方法包括排列聚合、注意力排序、注意力校准和位置不变推理(PINE)。 6. 推理模型的鲁棒性

尽管推理模型承诺通过更多计算获得更好泛化,但它们可能对分布偏移和任务组合表现脆弱,甚至在某些情境(如公共物品博弈)中展现出与传统指令微调模型不同的、更利己的行为模式。 7. 公平性与社会偏见

模型可能在文化知识、语言理解、道德价值观等方面存在系统性偏见。研究发现,模型声明的价值观与其在道德困境中的实际决策常不一致。评估需考虑多语言和文化原生语境(如CulturalBench、Global PIQA),缓解方法包括模块化多元对齐、人格向量控制和谱系微调。 8. 多模态大语言模型的鲁棒性

视觉语言模型在性别、年龄等方面可能继承或复合来自视觉和语言编码器的偏见,且在因果推理、细粒度理解上存在不足。通过自校正、像素空间推理和迭代反思等方法可提升其鲁棒性与推理能力。 总结:构建鲁棒且可信的大语言模型是一个多维度挑战,需要在安全性、知识管理、输出真实性、提示鲁棒性、位置公平性、推理可靠性、社会公平性以及多模态理解等方面进行持续研究与技术改进。本报告为相关研究与实践提供了系统的路线图和丰富的文献参考。