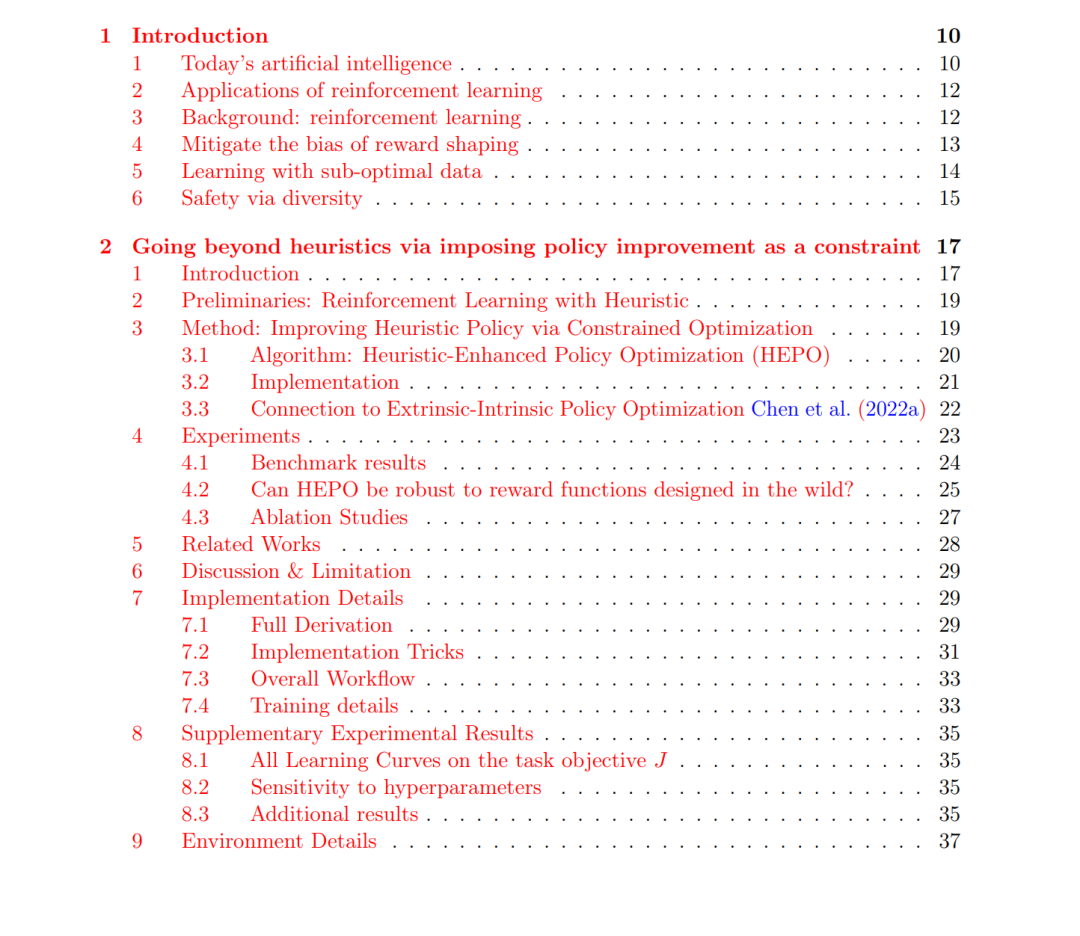

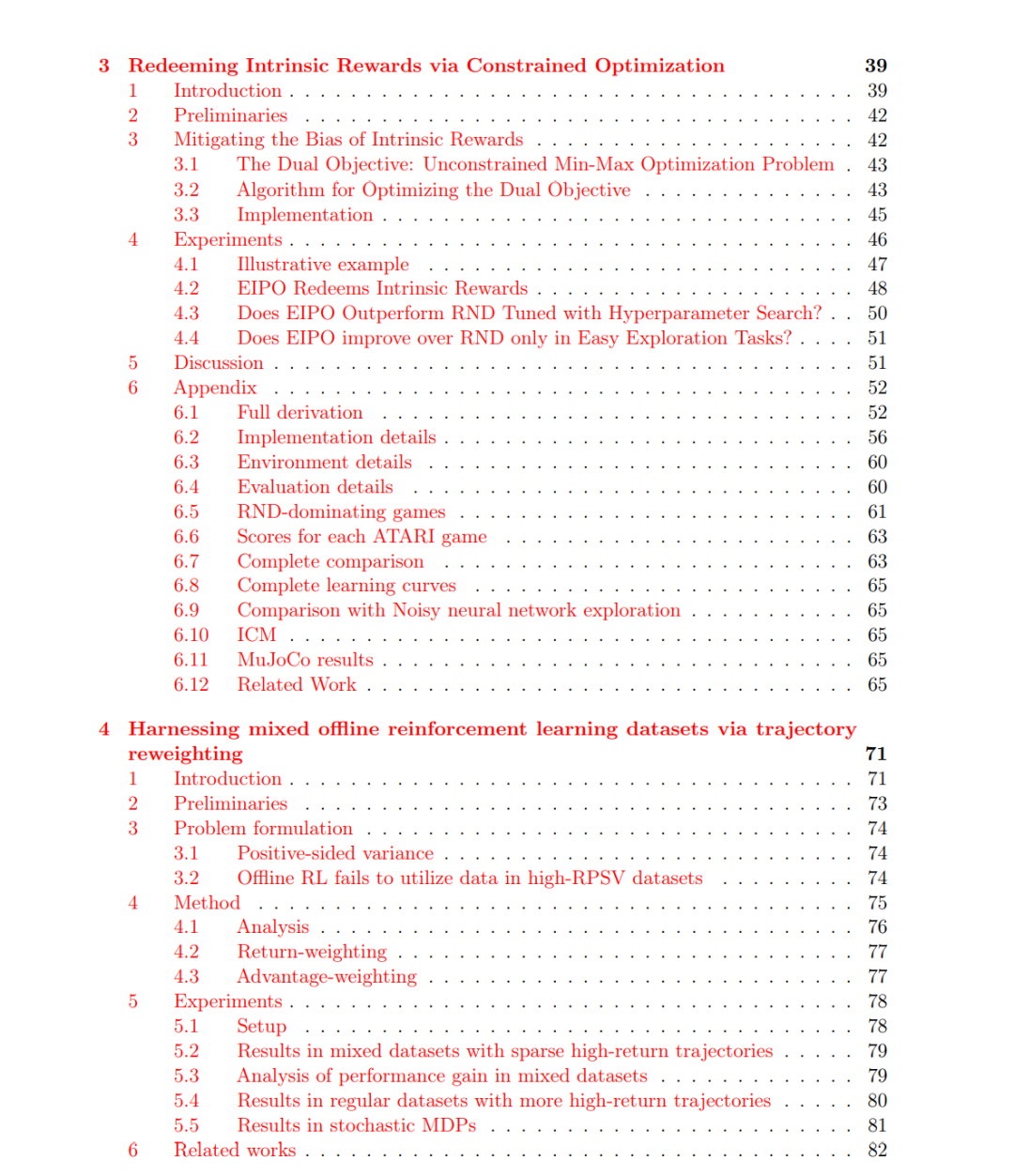

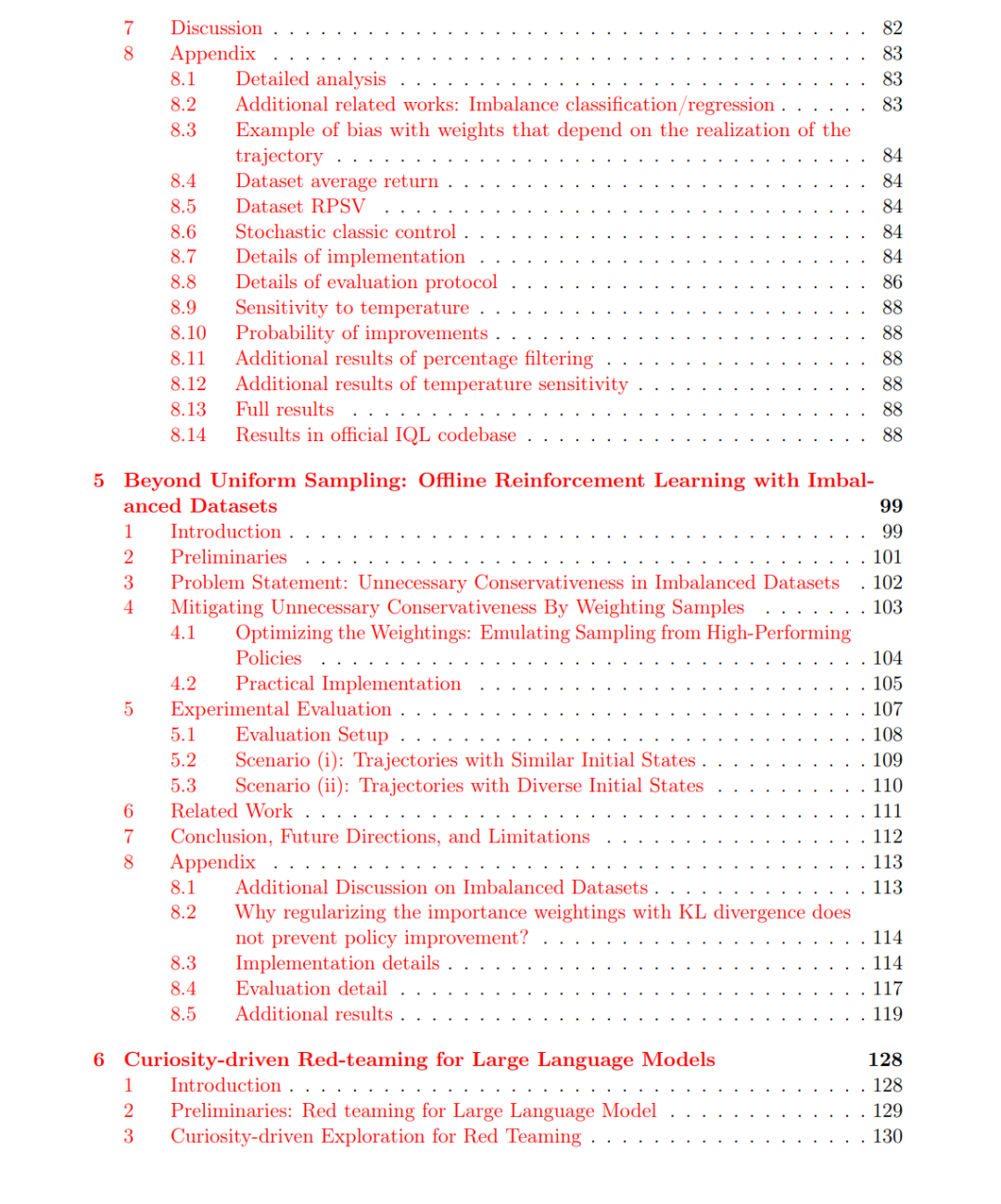

发现新知识对于技术进步至关重要,这反映了人类和动物学习新技能的方式——通常是通过试错。例如,远古人类通过尝试不同方法发现了火的使用;儿童则通过反复尝试和失败学会了走路和使用工具。在化学领域,科学家通过测试各种成分组合来发现新型催化剂。但人类究竟是如何利用试错来改进现有解决方案的(比如找到更高效的行走方式,或合成全新化合物)?我们能否设计出能够模仿甚至超越人类发现能力的计算模型?这类计算模型有望极大加速科学与工程领域的进展,因为它们可以自动化或辅助科学家和工程师的工作,并更高效地发现新知识(例如发现新化合物、简化机器人控制器设计等)。 强化学习(Reinforcement Learning, RL)非常适合用于发现任务,因为它使机器能够通过试错进行学习。我的研究克服了当前RL算法的一个主要局限,从而提升了其在知识发现方面的潜力: 1. 缓解奖励塑形(reward shaping)的偏差。

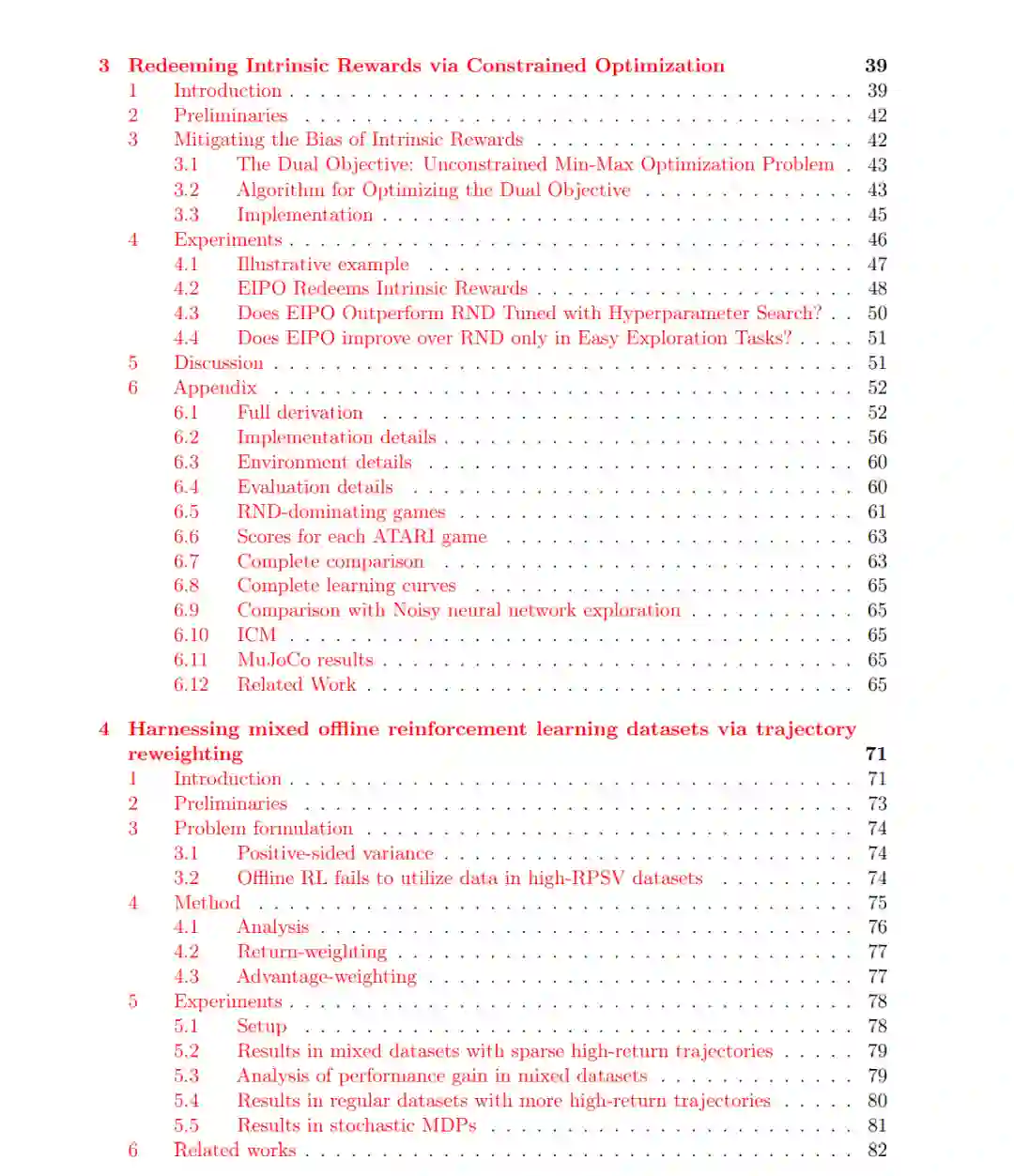

RL依赖于从试错经验中获得的奖励信号,但这些信号往往是稀疏的——即仅在找到理想解决方案时才给予奖励,其他情况下奖励为零。因此,大多数尝试几乎无法提供有效反馈。为应对稀疏奖励问题,一个常用策略是提供额外的提示(即奖励塑形)来引导RL算法。然而,如果这些提示不准确,反而会将算法引向比不使用提示更差的解决方案。我提出了一种新的RL框架,该框架可与任意标准RL算法结合,确保在使用提示进行训练时能获得更优解,而非损害性能。 2. 利用次优数据进行学习。

RL不仅可以从与环境的在线交互中学习,还能从已记录的经验数据集中学习。对于材料发现或机器人学习等代价高昂或耗时的任务,离线RL(offline RL)更受青睐,因为它利用现有数据,而无需与环境进行新的交互。然而,这类数据集可能主要包含低奖励的次优解,从而限制了离线RL算法发现优于数据集中已有解的能力(这一点将在本文后续章节中详细说明)。我提出了一种样本重加权(sample reweighting)策略,通过对数据集进行重新加权,使当前的离线RL算法即便在低奖励样本占主导的情况下,也能发现远优于原始数据集中解的新方案。 3. 通过多样性保障安全性。

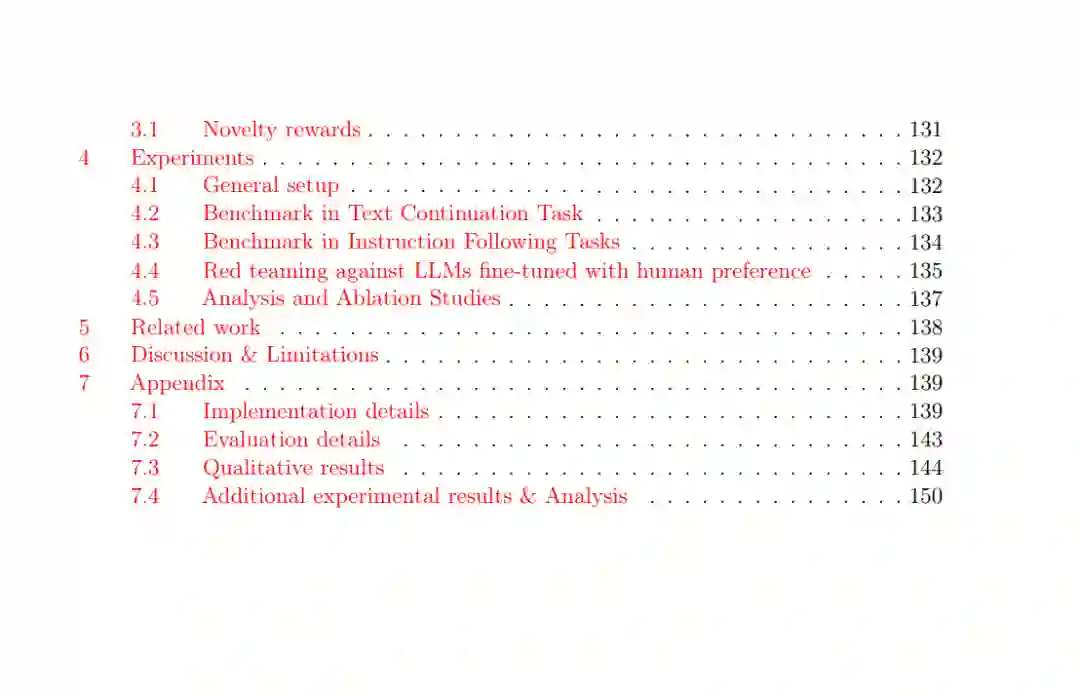

标准RL算法的目标是找到单一的“最优”解。然而,在许多发现任务中(如药物研发),生成多个具有不同特性的高奖励解(即多样性)比只关注单一最优解更有价值。我在一项新兴的发现任务——大语言模型(LLM)的“红队测试”(red-teaming)中深入研究了这一问题。在红队测试中,我们希望生成多样化的提示(prompts),以触发目标语言模型产生不良输出。当前方法利用RL训练一个LLM去对另一个LLM进行红队攻击,但所生成的提示缺乏多样性,往往收敛到少数几个能稳定触发不良输出的提示。我提出通过奖励机制激励智能体最大化生成提示的多样性,这不仅提升了提示的多样性,还显著提高了其成功触发目标LLM不良输出的效果。