深度学习是科学还是炼金术?LeCun 最新演讲(视频 + PPT)

新智元报道

新智元报道

编辑:肖琴

【新智元导读】Facebook AI 研究总监 Yann LeCun 近日在普林斯顿高等研究所进行了一次演讲,题为《深度学习认识论》,重点讨论了深度学习思想的早期历史和动态,强调理论理解在深度学习研究中的重要意义。

更好的理论理解,将有助于深度学习研究的发展。

近日,Facebook AI 研究总监 Yann LeCun 在普林斯顿高等研究所进行了一次演讲,题为《深度学习认识论》(The Epistemology of Deep Learning),重点讨论了深度学习思想的早期历史和动态。

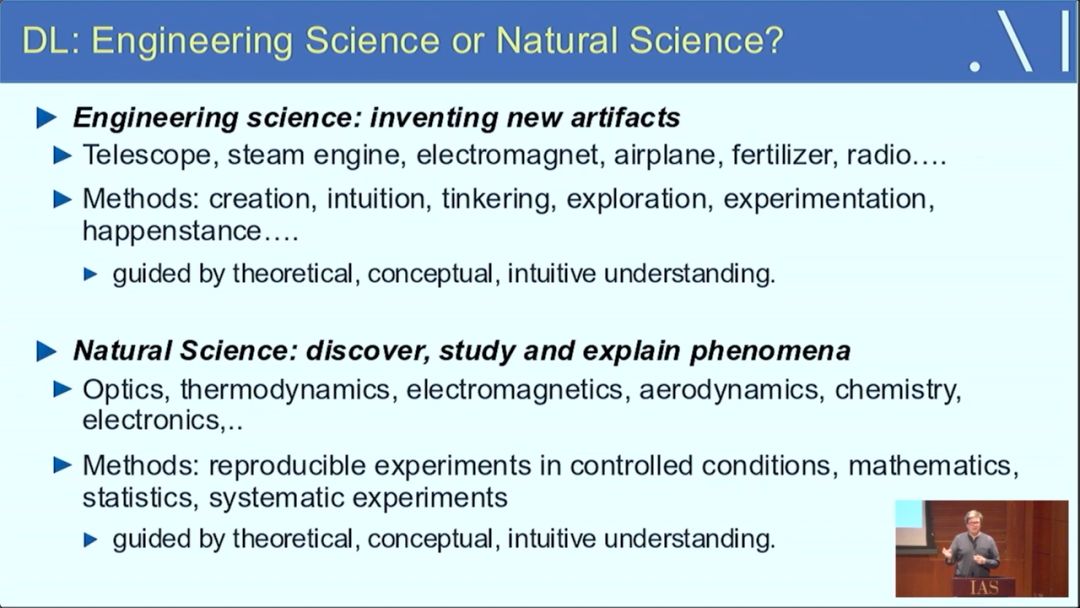

LeCun 认为,深度学习在一定程度上是一门 “工程科学”,我们通过理论洞见、直觉、灵感和经验探索来创造新的工件。但是理解深度学习在一定程度上是 “物理科学”,需要理解这个工件的一般属性。

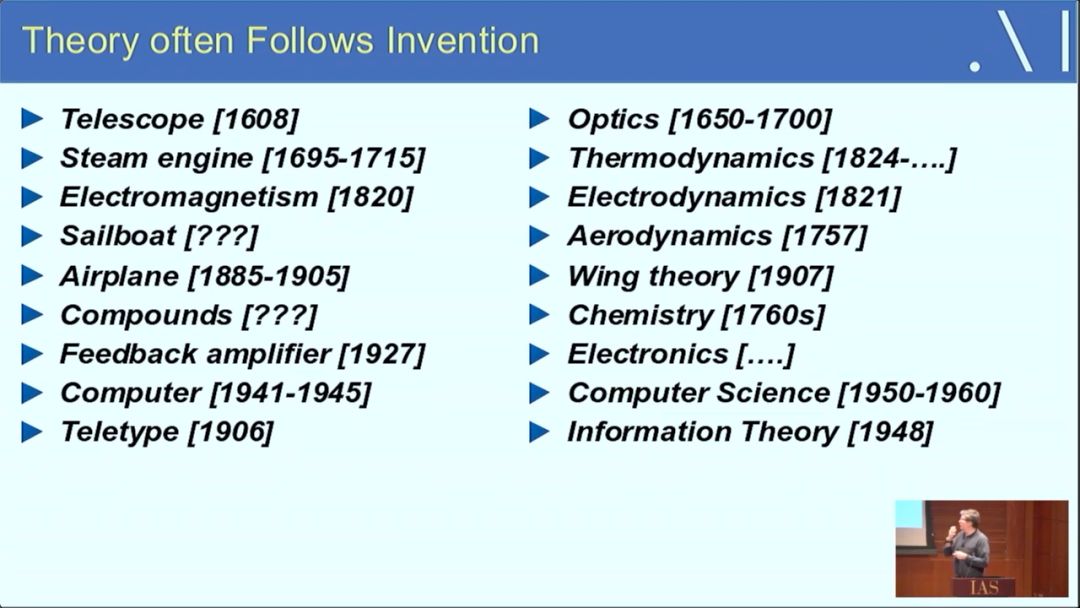

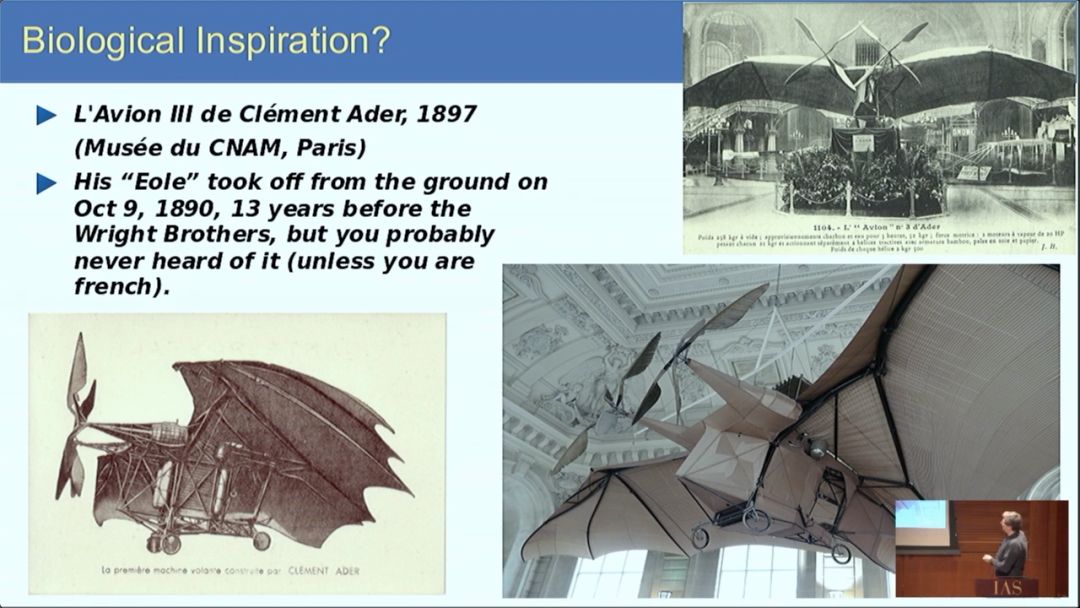

科学和技术的历史有很多技术工件先于理论理解的例子:透镜的发明在光学理论之前,蒸汽机的发明在热力学之前,飞机在空气动力学之前,无线电通信再信息理论之前,可编程计算器在计算机科学之前。

LeCun 演讲的两个要点是:

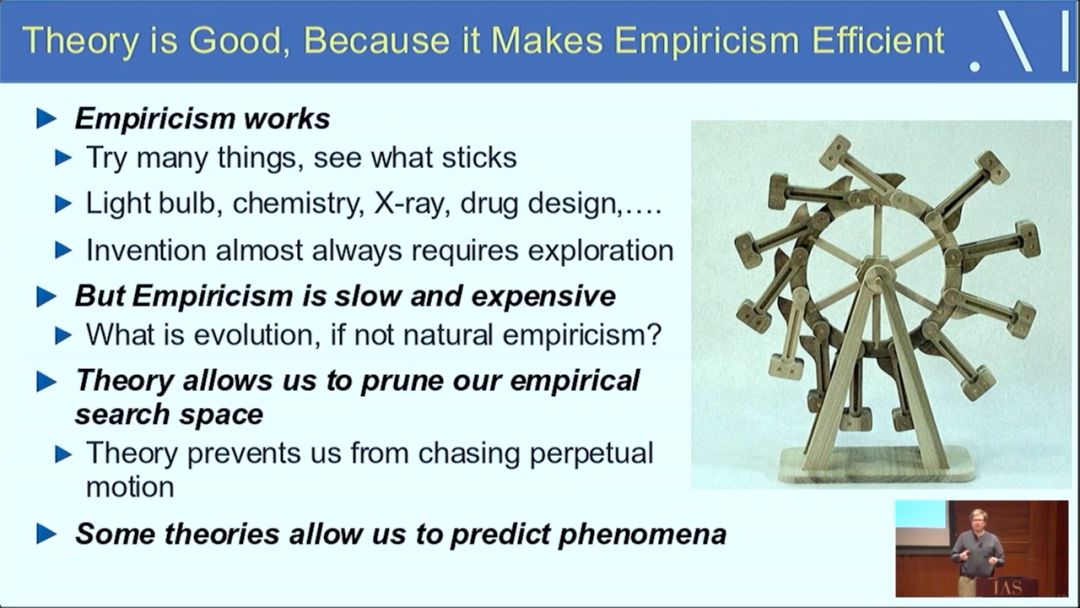

(1) 经验主义是一种完全合适的研究方法,尽管它效率低下;

(2) 我们面临的挑战是为学习和智能开发一种理论,对应于蒸汽机的热力学理论。

有了理论基础,即使只是概念上的基础,也将大大加快该领域的研究进展,但必须认识到一般理论的实际影响有限。

演讲视频:

2017 年 Ali Rahimi 在 NIPS 的演讲中批判深度学习是 “炼金术”(Alchemy),引起机器学习界大讨论。当时反驳他的代表、深度学习领军人物 Yann LeCun 在自己的主页上回应 Ali,说自己完全不同意 Ali 的说法。

LeCun 表示,那次大争论很有意思,但他认为 Ali Rahami 混淆了两个概念,即 “炼金术” 和 “工程”。Ali 所指的 “炼金术” 实际上是工程学。

炼金术 & 工程

工程科学是关于发明新工件 (new artifacts) 的,你有很多方法可以用来发明新东西。比如望远镜、蒸汽机、电磁体、飞机、无线电等新发明,显然有方法被用来创造它们。这是一种创造性的活动,其方法如创造、直觉、探测、实验等等。如果我们对这些现象有一些理论上的理解,这些发明创造显然能够更加高效。

这与今天的神经科学也有相似之处。神经科学是关于发现、学习和解释现象的,其方法如在控制条件下的可复现实验、数学、统计学、系统性实验等,同样也由理论性、概念性和直觉理解所指导。

而理论往往是在发明之后构建起来的,比如:透镜的发明在光学理论之前,蒸汽机的发明在热力学之前,飞机在空气动力学之前,无线电通信再信息理论之前,可编程计算器在计算机科学之前。

如此,现代世界的种种神奇在人们完全理解它们之前就已经被发明出来了。这和我们告诉学生的故事有些不同,我们会告诉他们去做数学运算,要理解所有的理论,只有这样你才能利用那些理论去发明东西。但现实从来不是这样。

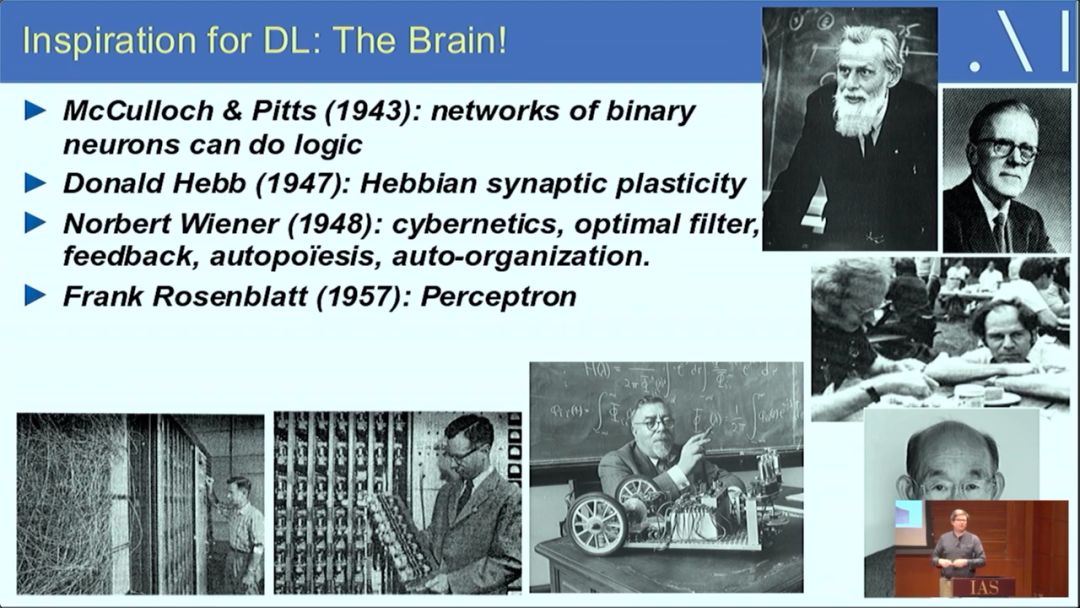

上面这张 PPT 展示了深度学习的根源,即启发了深度学习的一些理论。

McCulloch & Pitts (1943) : 二元神经元网络可以做逻辑运算

Donald Hebt (1947) : Hebbian 发现突触可塑性的基本机制(赫布理论)

Norbert Wiener (1948) :控制论,最佳滤波器,反馈,自动生成,自动组织

Frank Rosenblatt (1957): 感知机

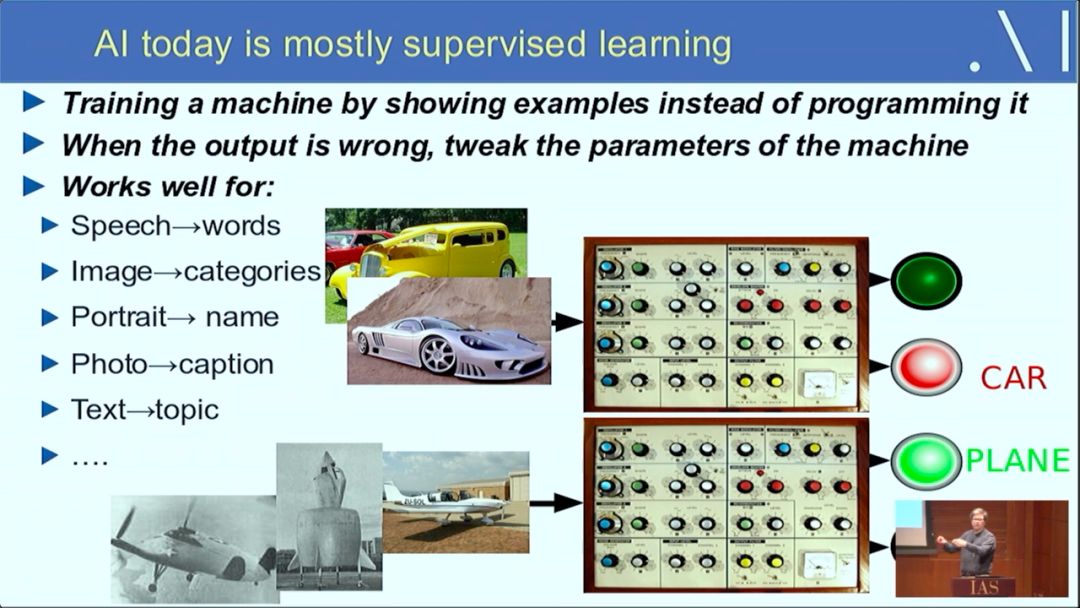

今天的 AI 大部分是监督学习

其运作方式是:向系统提供样本以训练机器,而非直接编程。

当输出错误时,则调整参数。

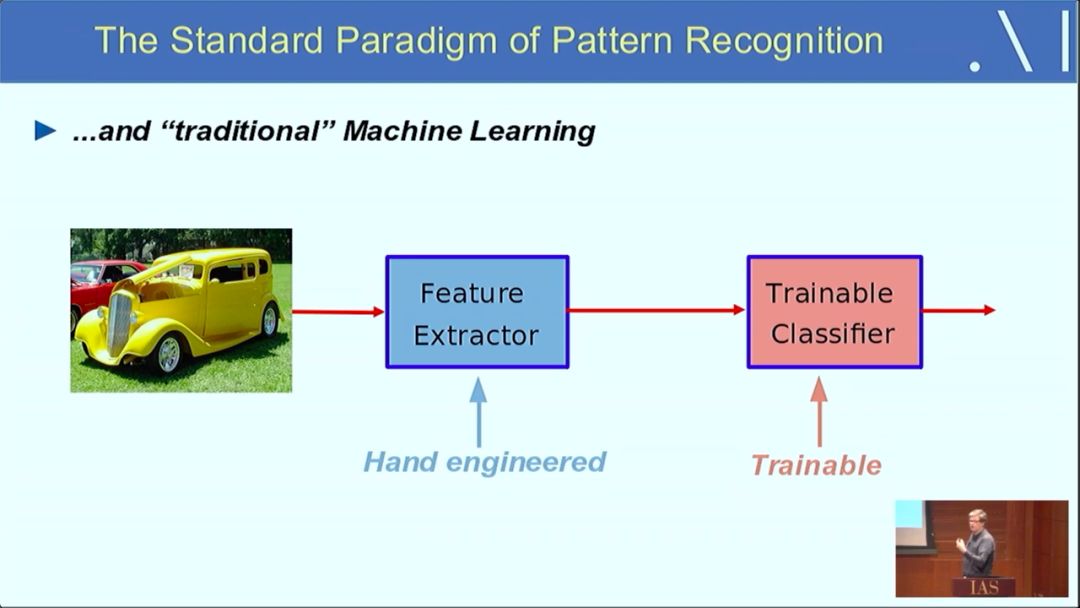

这是模式识别的一个标准范式

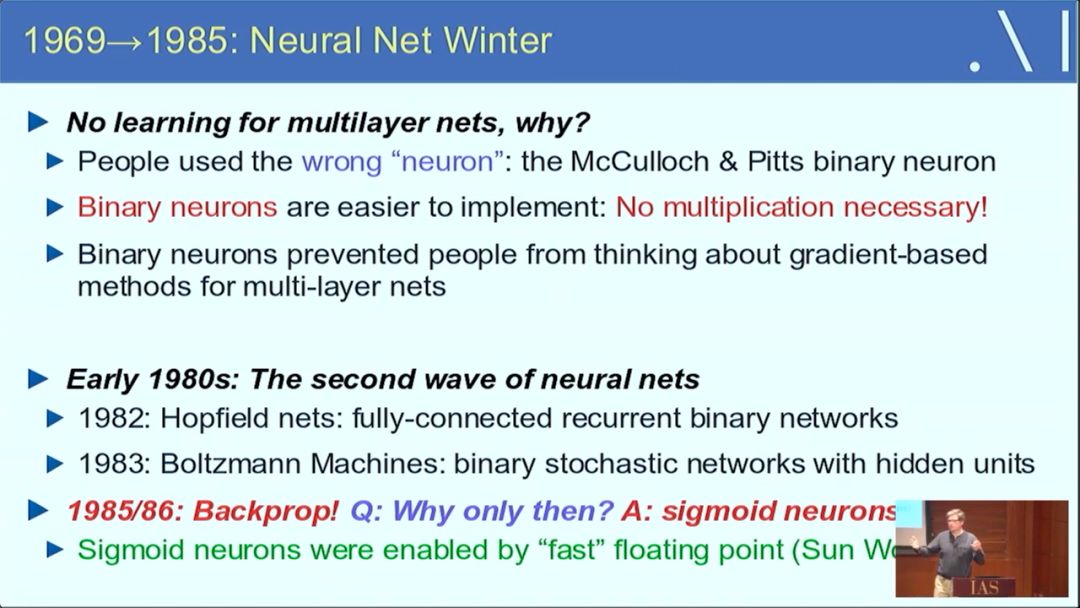

从 1969 到 1985 年,是深度学习的第一个 “冬天”。当时提出的多层网络并不学习,原因包括使用了错误的 “神经元”,而二元神经元阻碍了人们往 gradient-based 的方法去想。

不过到 80 年代早期,出现了神经网络的第二次热潮。当时提出了 Hopfield nets、玻尔兹曼机。到 1985/86 年,反向传播 (Backprop) 出现了,深度学习迎来转机。

来自生物学的启发

理论是好东西,因为它使得实验有效。

理论允许我们修补、完善经验。一些理论甚至能让我们预测现象。

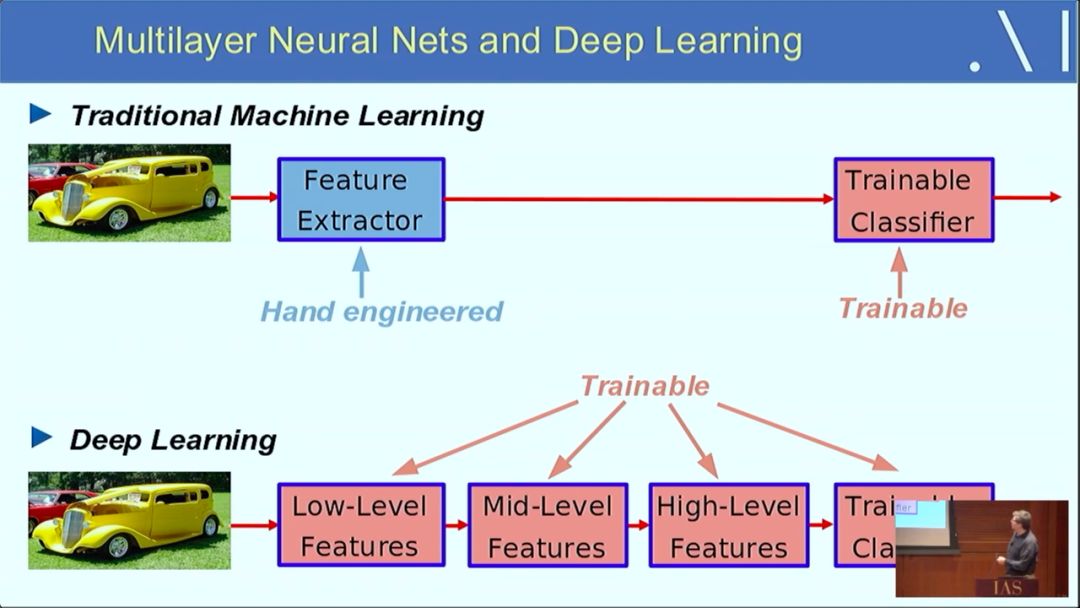

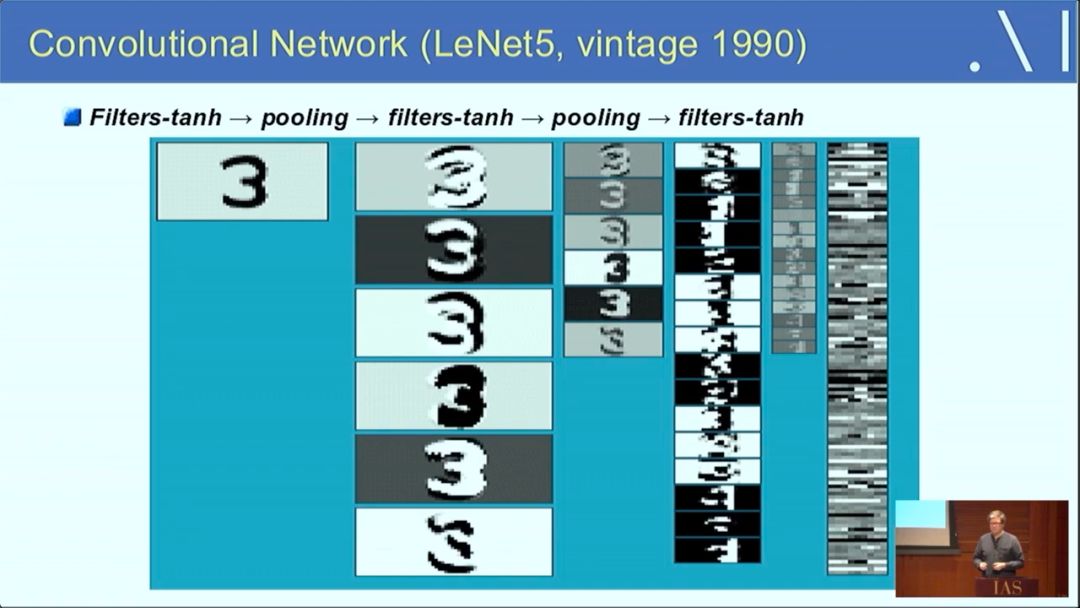

多层神经网络和深度学习

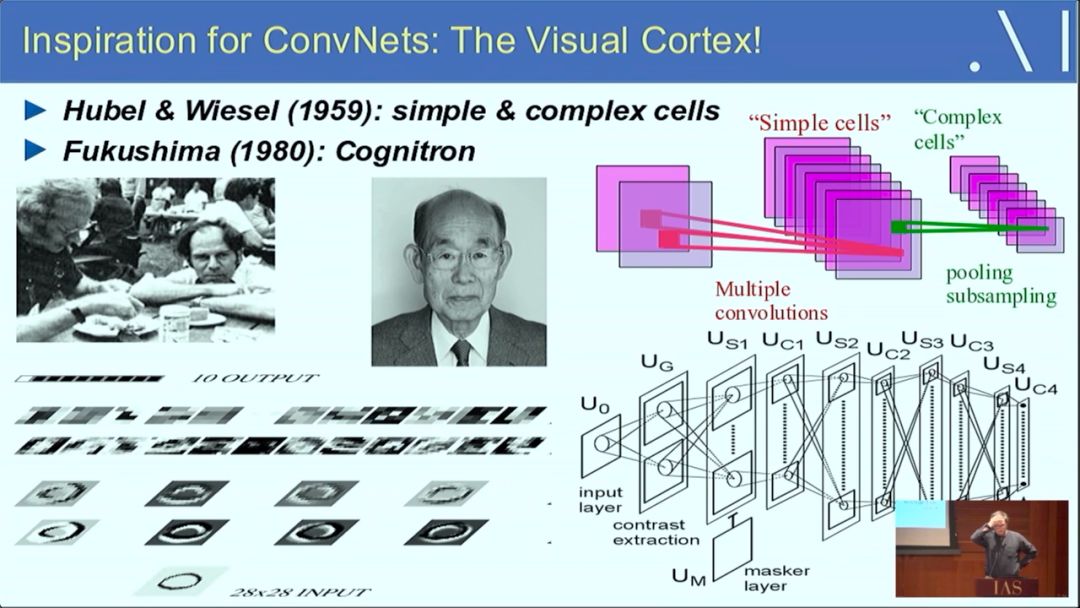

卷积网络启发自视觉皮层

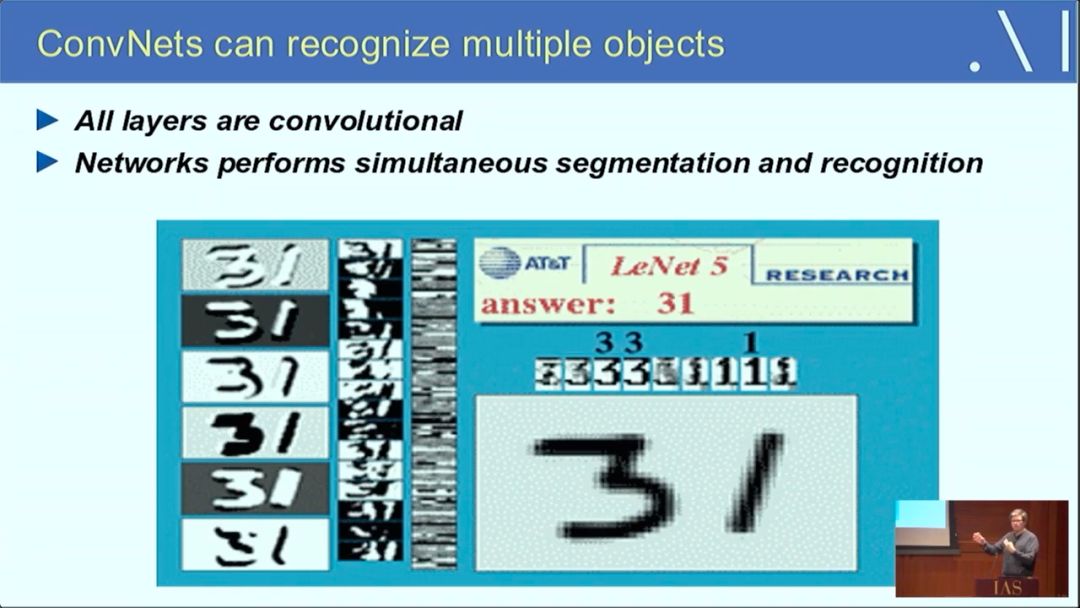

卷积网络能够识别多个物体

其中,所有层都是卷积的,神经网络同时进行分割和识别。

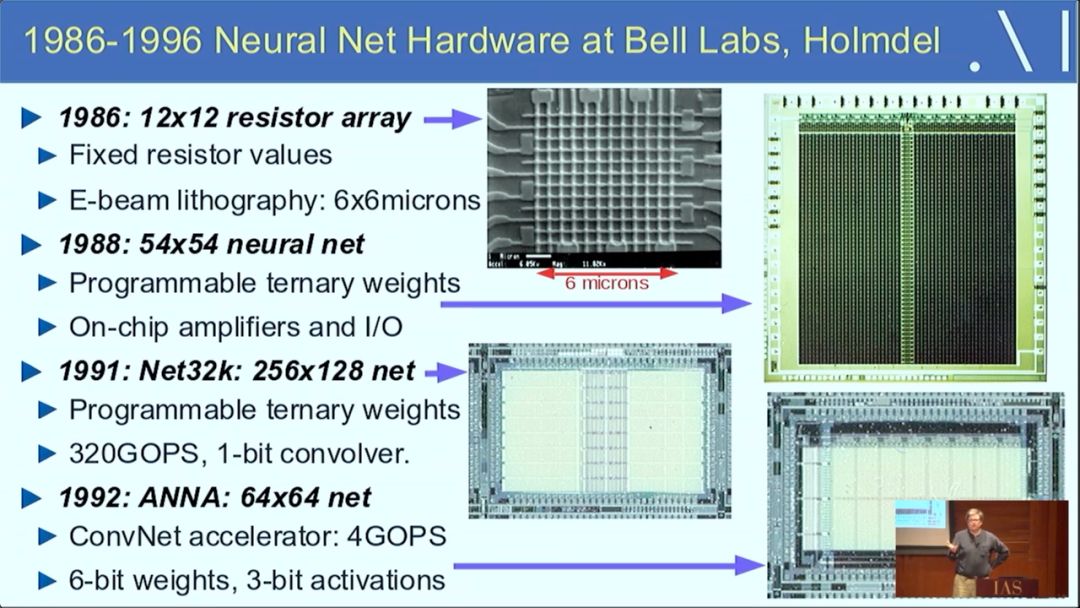

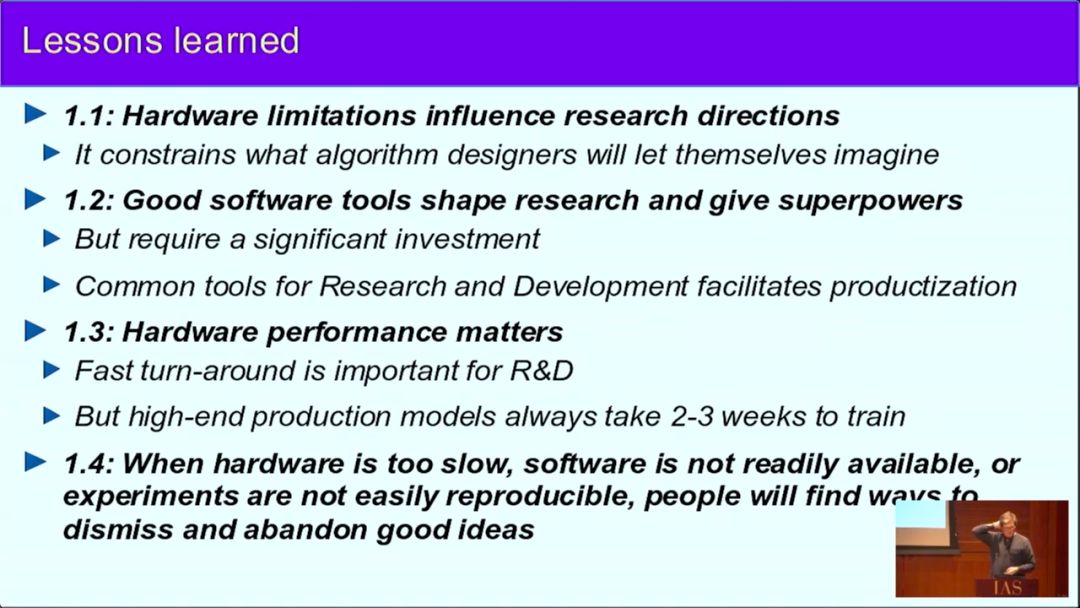

80、90 年代时的神经网络硬件

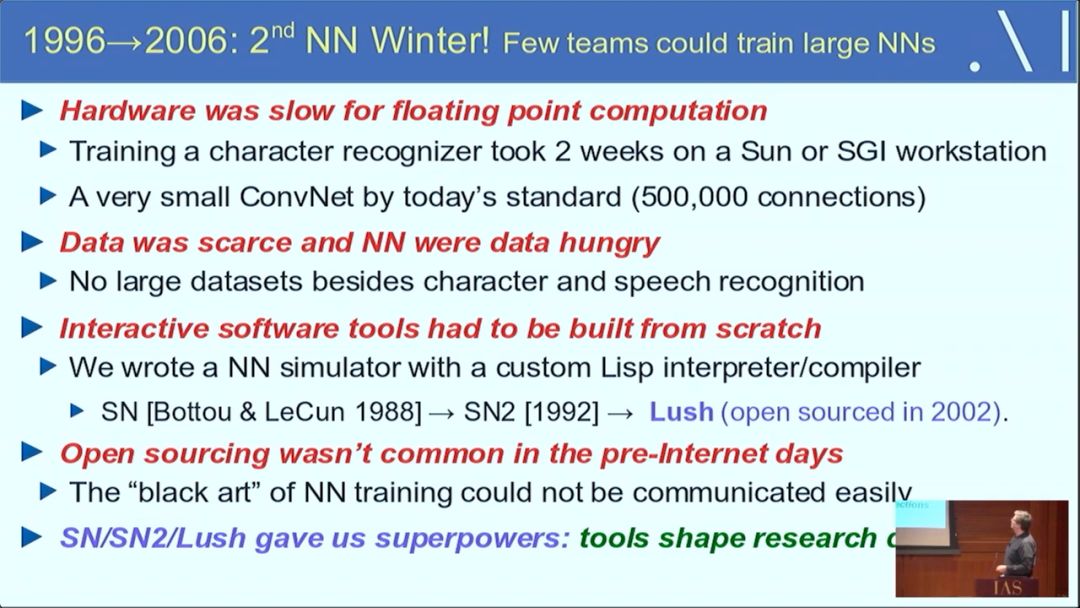

1996~2006 年的 10 年间,是神经网络的第二个冬天。这期间,很少有团队能够训练大型神经网络。

原因有很多

硬件在浮点计算方面很慢

数据稀缺,数据成本昂贵,而神经网络是数据饥渴性的

交互式的软件工具必须从头开始构建

在互联网时代之前,开源并不常见

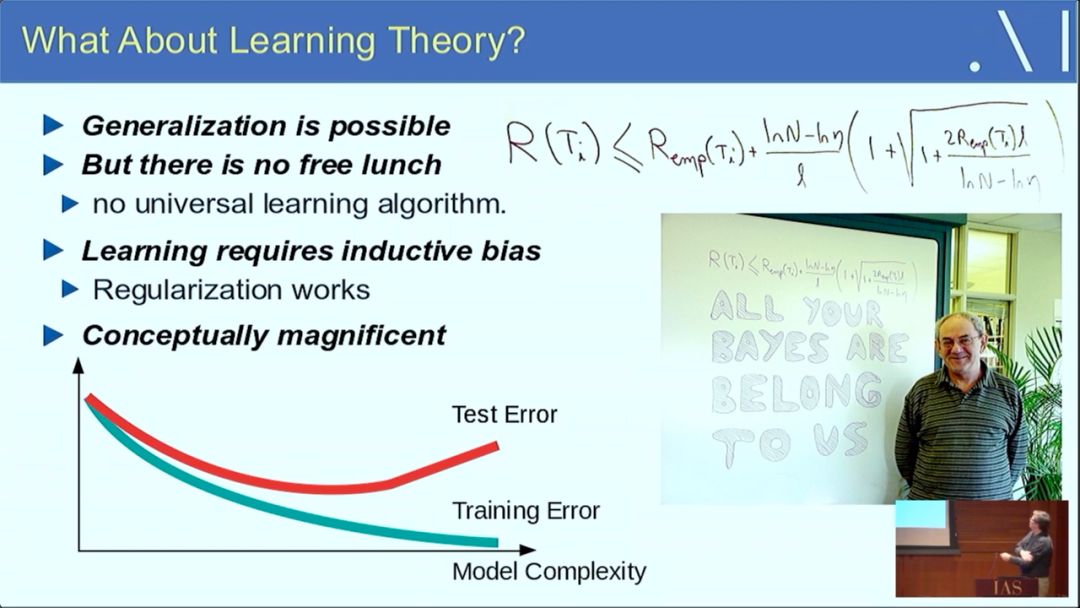

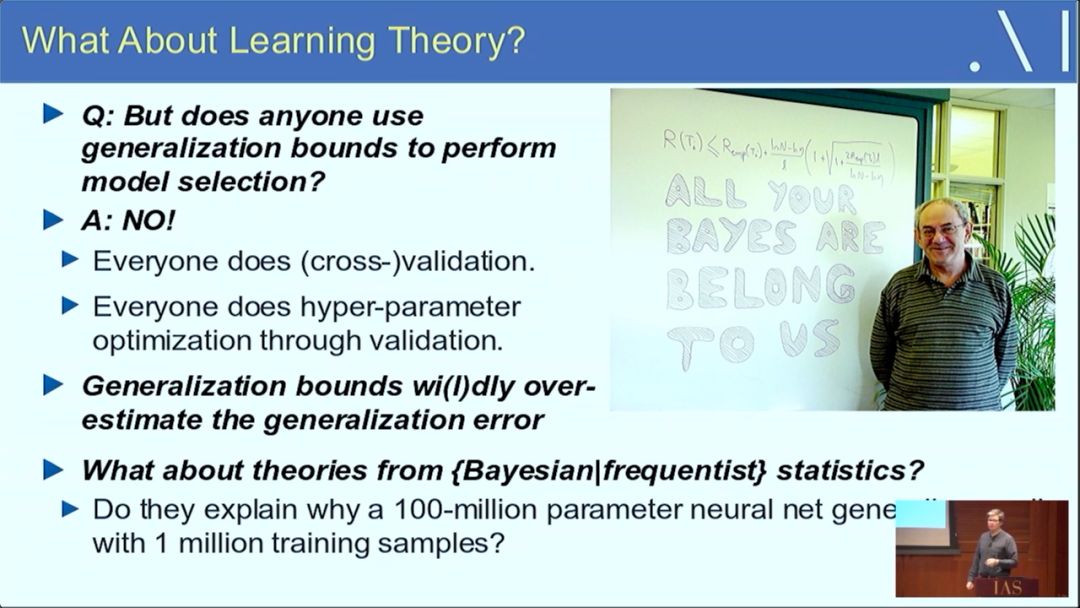

学习理论

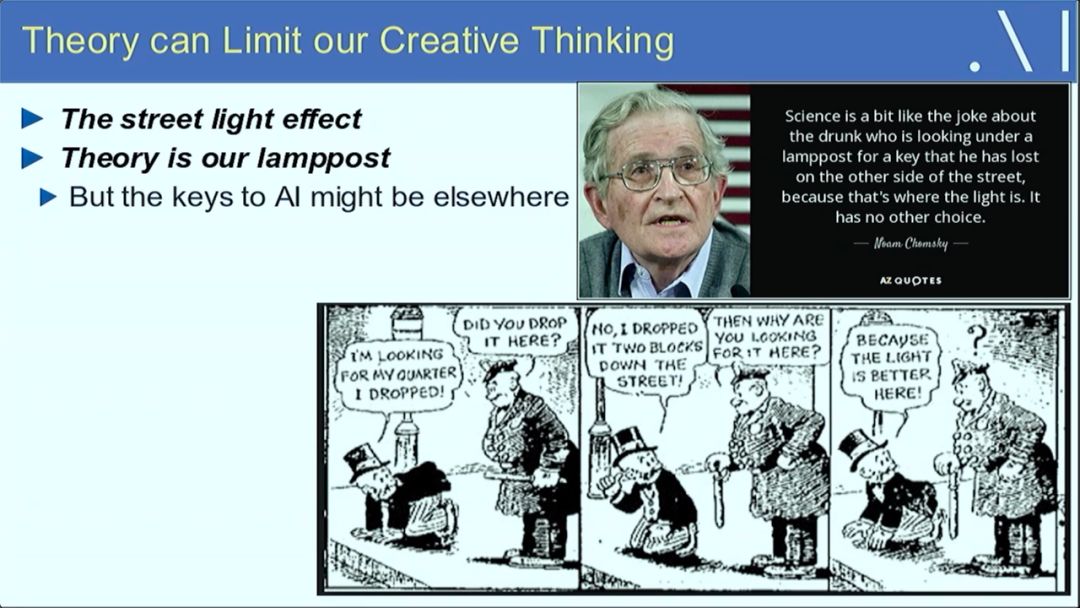

理论可能会限制我们的创造性思维

更多阅读

【加入社群】

新智元AI技术+产业社群招募中,欢迎对AI技术+产业落地感兴趣的同学,加小助手微信号:aiera2015_2 入群;通过审核后我们将邀请进群,加入社群后务必修改群备注(姓名 - 公司 - 职位;专业群审核较严,敬请谅解)