本文原作者雨宫夏一,本文整理自作者在知乎《卷积神经网络工作原理直观的解释?》问题下的回答。AI 研习社已获得转载授权。

其实我们在做线性回归也好,分类(逻辑斯蒂回归)也好,本质上来讲,就是把数据进行映射,要么映射到一个多个离散的标签上,或者是连续的空间里面,一般简单的数据而言,我们很好拟合,只要线性变化一下,然后学习出最好的 W 就可以了。

但是对于一些比较复杂的数据怎么办呢?比如说,对于一个二分类问题,特别是高纬度复杂化之后,数据不一定是线性可分的,这个时候,我们的 basis function 隆重登场,我们可以把数据进行一定的映射,转变,非线性的线性的,转变之后,就可以进行分类。最明显的例子在 andrew NG 在讲 SVM 里面的例子就很好的说明了,但是这个时候问题来了,对于一个很复杂,高维度的数据,我们如何才能找到最好的 basis function 呢?这个时候,神经网络隆重登场,我们把我们的 basis function 打开来,我们把误差转递到 basis function 的里面,通过这样的方式,来得到最好的 basis function,同理,我们可以无限打开 basis function,一直打开,对应的也就是一层神经网络(具体出自于 prml 关于神经网络的章节最开始简介的部分)。

但是问题来了,对于图片怎么办?我们知道,对于图片而言,图片是一个二维度的数据,我们怎样才能通过学习图片正确的模式来对于一张图片有正确的对于图片分类呢?这个时候,有人就提出了一个观点,我们可以这样,对于所有的像素,全部都连接上一个权值,我们也分很多层,然后最后进行分类,这样也可以,但是对于一张图片来说,像素点太多,参数太多了。然后就有人提出来,我们只看一部分怎么样,就是对于一张图片来说,我们只看一个小窗口就可以了,对于其他的地方,我们也提供类似的小窗口,我们知道,当我们对图片进行卷积的时候,我们可以对图片进行很多操作,比如说图片整体模糊,或者是边缘的提取,卷积操作对于图片来说可以很好的提取到特征,而且通过 BP 误差的传播,我们可以根据不同任务,得到对于这个任务最好的一个参数,学习出相对于这个任务的最好的卷积核,之所以权值共享的逻辑是:如果说一个卷积核在图片的一小块儿区域可以得到很好的特征,那么在其他的地方,也可以得到很好的特征。

这就有了 alex net 的提出,通过对图片进行五层(不知道有没有记忆错误)的卷积,然后后面三层的全连接,我们可以得到一个很好的结果,特别的相对于更大的数据集而言,最好参数越多越好,也就是网络最好更加深,更加的宽。

但是神经网络到底是什么?对于一批数据我们有很多的问题,为什么设置五层最好,batchsize 多少比较好,每一层多少个卷积核(这个到现在我依旧没有一个更好的解释,每一个应该多少卷积核),宽度多少?要不要 LRN?每一层都代表了什么?

这些的解释,就要好好看看今年 CVPR 的文章 Visualizing and Understanding Convolutional Networks 这篇文章写的很棒,而且 2015 CVPR 出了很多对于卷积神经网络理解的文章,这篇文章提出了一个反卷积的方法 (De-convolution) 的方法,这样我们就可以好好看看每一层卷积神经网络到底做了什么事情:

首先第一层的返卷积(上面是反卷积的图片,下面对于第一层来说,激活值最大的图片):

<span style="font-size: 14px; color: rgb(63, 63, 63);"><img src="https://pic1.zhimg.com/50/d68d271178e7dd3a0fd47ec44e7fefa0_hd.png" data-rawwidth="403" data-rawheight="552" class="content_image" width="403"></span>

我们看到,第一个卷积层只是表达了简单的图片的边缘而已,我们来看第二层:

<span style="font-size: 14px; color: rgb(63, 63, 63);"><img src="https://pic4.zhimg.com/50/8906f1eb5cc9bc86d15d1630c40a5b9f_hd.png" data-rawwidth="1147" data-rawheight="562" class="origin_image zh-lightbox-thumb" width="1147" data-original="https://pic4.zhimg.com/8906f1eb5cc9bc86d15d1630c40a5b9f_r.png"></span>

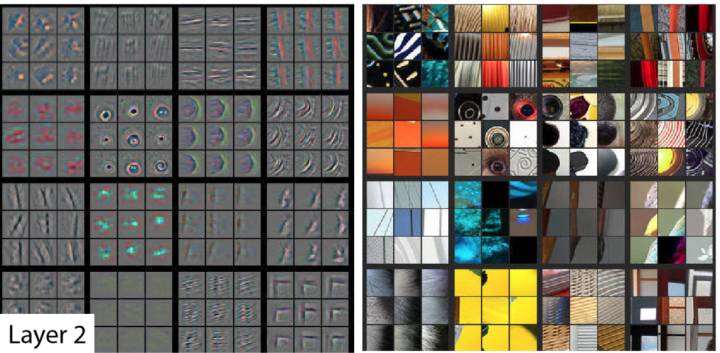

第二层稍稍复杂了一点点,可以包含的不仅仅是一个边缘,可以是几个边缘的组合

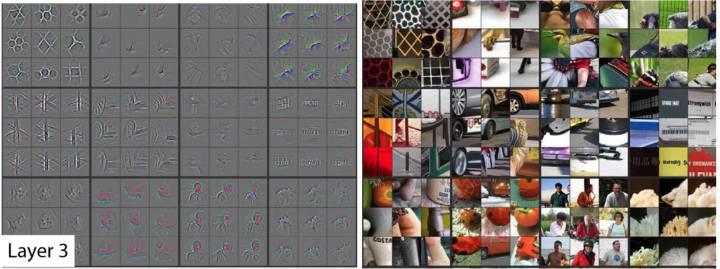

第三层:

<span style="font-size: 14px; color: rgb(63, 63, 63);"><img src="https://pic2.zhimg.com/50/6f600422e7aeb19850b19c55aea04a11_hd.png" data-rawwidth="1472" data-rawheight="549" class="origin_image zh-lightbox-thumb" width="1472" data-original="https://pic2.zhimg.com/6f600422e7aeb19850b19c55aea04a11_r.png"></span>

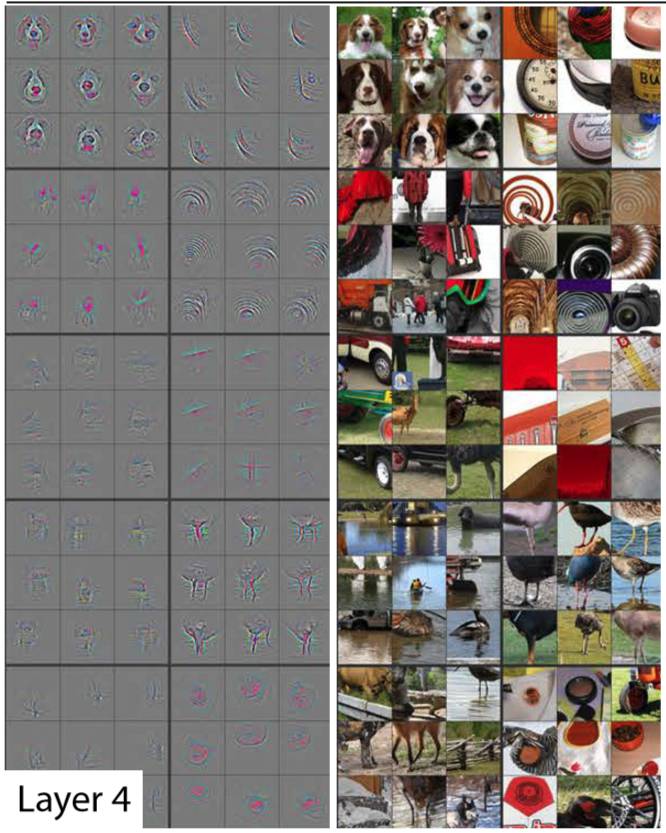

第四层:

<span style="font-size: 14px; color: rgb(63, 63, 63);"><img src="https://pic4.zhimg.com/50/f9c5fe43099bde52bd9673db4383e10f_hd.png" data-rawwidth="666" data-rawheight="833" class="origin_image zh-lightbox-thumb" width="666" data-original="https://pic4.zhimg.com/f9c5fe43099bde52bd9673db4383e10f_r.png"></span>

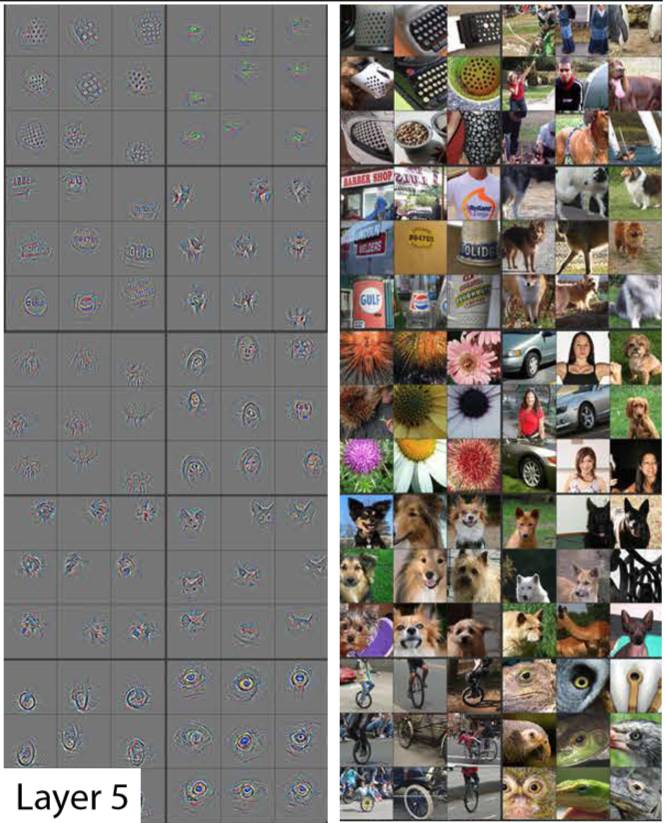

第五层:

<span style="font-size: 14px; color: rgb(63, 63, 63);"><img src="https://pic1.zhimg.com/50/074357f5b07e0c14ecf740ca47a3c728_hd.png" data-rawwidth="667" data-rawheight="823" class="origin_image zh-lightbox-thumb" width="667" data-original="https://pic1.zhimg.com/074357f5b07e0c14ecf740ca47a3c728_r.png"></span>

我们看到,每一层都是对于一张图片从最基础的边缘,不断到最复杂的图片自己本身。

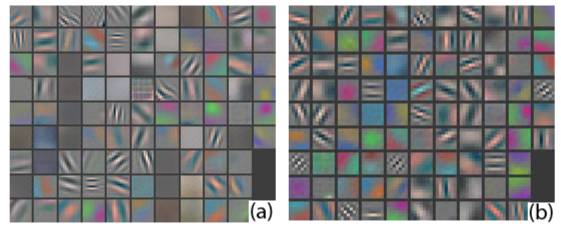

同时在进行反卷积的时候 M.D. Zeiler and R. Fergus 也发现,对于第一层的 alexnet,会得到频度很高的像素(也就是颜色很深),所以他们也提出了应该要减小窗口,这样可以得到频度比较适中的像素:

<span style="font-size: 14px; color: rgb(63, 63, 63);"><img src="https://pic1.zhimg.com/50/1f0c506afdf7c4493d398bb9c2d20408_hd.png" data-rawwidth="561" data-rawheight="232" class="origin_image zh-lightbox-thumb" width="561" data-original="https://pic1.zhimg.com/1f0c506afdf7c4493d398bb9c2d20408_r.png"></span>

当图片卷积完之后,会把一个图片对于这一类本身最独特的部分凸显出来,然后来进行判断,这一类到底是什么?有下面的实验截图:

<span style="font-size: 14px; color: rgb(63, 63, 63);"><img src="https://pic3.zhimg.com/50/4ef49fb833cc7a3510f81da4343ed1ae_hd.png" data-rawwidth="1448" data-rawheight="262" class="origin_image zh-lightbox-thumb" width="1448" data-original="https://pic3.zhimg.com/4ef49fb833cc7a3510f81da4343ed1ae_r.png"></span>

最左边的图像是原图像,作者盖住不同的区域,来分析对于一张图片,经过五次卷积之后,到底是如何判断的,我们看到卷积到最后(左三),比较凸显出来的是狗的头部,左二和右二的意思是,当我们遮住不同的区域,判断是狗的几率,红色区域代表概率很高,蓝色区域代表概率很低,我们发现,当我们遮挡住狗的头的地方的时候,我们得到这个物体时狗的概率最低,这个侧面证明了,所谓卷积神经网络,就是会自动的对于一张图片学习出最好的卷积核以及这些卷积核的组合方式,也就是对于一张图片的任务来说,求出最好的图片对于本任务的特征的表达,然后来进行判断

还有一篇文章也助于理解,

Understanding Deep Image Representations by Inverting Them

这篇对于卷积每一层都不断的还原到最原始的图片:

<span style="font-size: 14px; color: rgb(63, 63, 63);"><img src="https://pic1.zhimg.com/50/c3292580aa367cb7d07d5409d3d76f1c_hd.png" data-rawwidth="1759" data-rawheight="366" class="origin_image zh-lightbox-thumb" width="1759" data-original="https://pic1.zhimg.com/c3292580aa367cb7d07d5409d3d76f1c_r.png"></span>

越是到后面,图片越模糊,但是它自己独特的部分,却凸显了出来。(也就是这个猩猩还是狒狒的头的部分)

还望指正,多谢。

关注 AI 研习社(okweiwu),回复 1

【超过 1000G 神经网络 / AI / 大数据,教程,论文】

一文详解卷积神经网络的演变历程!

▼▼▼