CVPR 2019 | 旷视、中科大、自动化所联合提出超分辨率新方法Meta-SR:单一模型实现任意缩放因子

论文名称:Meta-SR: A Magnification-Arbitrary Network for Super-Resolution

论文链接:https://arxiv.org/abs/1903.00875

导语

随着深度卷积神经网络(DCNNs)技术的推进,超分辨率(super resolution/SR)的新近研究取得重大突破,但是关于任意缩放因子(arbitrary scale factor)的研究一直未回到超分辨率社群的视野之中。

先前绝大多数SOTA方法把不同的超分辨率缩放因子看作独立的任务:即针对每个缩放因子分别训练一个模型(计算效率低),并且只考虑了若干个整数缩放因子。

在本文中,旷视研究院提出一种全新方法,称之为Meta-SR,首次通过单一模型解决了超分辨率的任意缩放因子问题(包括非整数因子)。Meta-SR包含一种新的模块——Meta-Upscale Module,以代替传统的放大模块(upscale module)。

针对任意缩放因子,这一新模块可通过输入缩放因子动态地预测放大滤波器的权重,进而使用这些权重生成任意大小的HR图像。对于一张低分辨率图像,只需一个模型,Meta-SR就可对其进行任意倍数的放大。大量详实的实验数据证明了Meta-Upscale的优越性。

简介

单一图像超分辨率(single image super-resolution/SISR)旨在把一张较低分辨率(low-resolution/LR)的图像重建为一张自然而逼真的高分辨率(high-resolution/HR)图像,这项技术在城市监控、医疗影像、卫星及航空成像方面有着广泛应用。实际生活中,用户使用SISR技术把一张LR图像放大为自定义的大小也是一种刚需。正如借助于图像浏览器,用户拖动鼠标可任意缩放一张图像,以查看特定细节。

理论上讲,SR的缩放因子可以是任意大小,而不应局限于特定的整数。因此,解决SR的任意缩放因子问题对于其进一步落地有着重大意义。但并不是针对每个因子训练一个模型,而是一个模型适用所有因子。

众所周知,大多数现有SISR方法只考虑一些特定的整数因子(X2, X3, X4),鲜有工作讨论任意缩放因子的问题。一些SOTA方法,比如ESPCNN、EDSR、RDN、RCAN是借助子像素卷积在网络的最后放大特征图;不幸的是,上述方法不得不针对每个因子设计专门的放大模块;另外,子像素卷积只适用于整数缩放因子。这些不足限制了SISR的实际落地。

尽管适当放大输入图像也可实现超分辨率的非整数缩放,但是重复的计算以及放大的输入使得这些方法很是耗时,难以投入实用。有鉴于此,一个解决任意缩放因子的单一模型是必需的,一组针对每一缩放因子的放大滤波器的权重也是必需的。

在元学习的启发下,旷视研究院提出一个动态预测每一缩放因子的滤波器权重的新网络,从而无需为每一缩放因子存储权重,取而代之,存储小的权重预测网络更为方便。旷视研究院将这种方法称之为Meta-SR,它包含两个模块:特征学习模块和Meta-Upscale模块,后者的提出用于替代传统的放大模块。

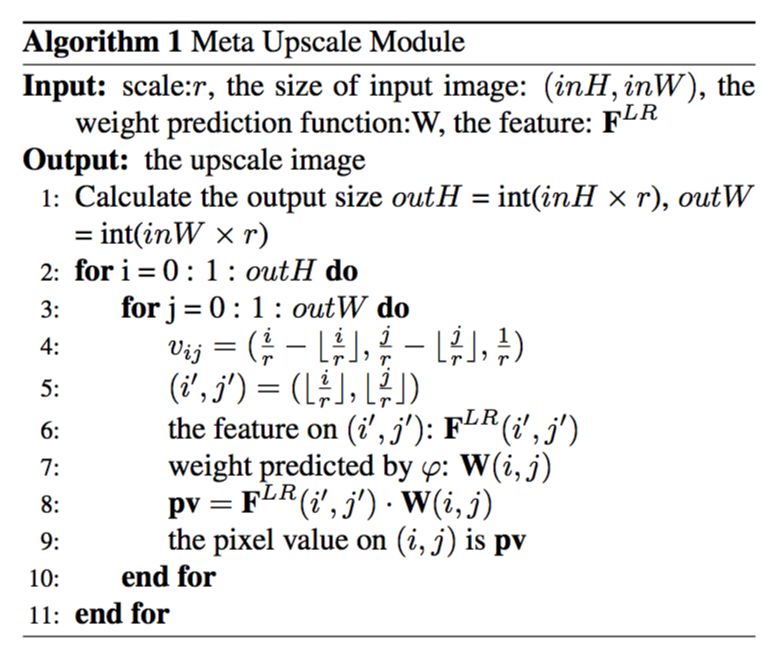

对于待预测SR图像上的每个像素点(i, j),本文基于缩放因子r将其投射到LR图像上,Meta-Upscale模块把与坐标和缩放因子相关的向量作为输入,并预测得到滤波器权重。对于待预测SR图像上的每个像素点(i, j),LR图像上相应投影点上的特征和预测得到的权重卷积相乘就能预测出(i, j)的像素值。

Meta-Upscale模块通过输入一系列与缩放因子及坐标相关的向量,可动态地预测不同数量的卷积滤波器权重。由此,只使用一个模型,Meta-Upscale模块即可将特征图放大任意缩放因子。该模块可以替代传统放大模块(upscale module)而整合进绝大数现有方法之中。

方法

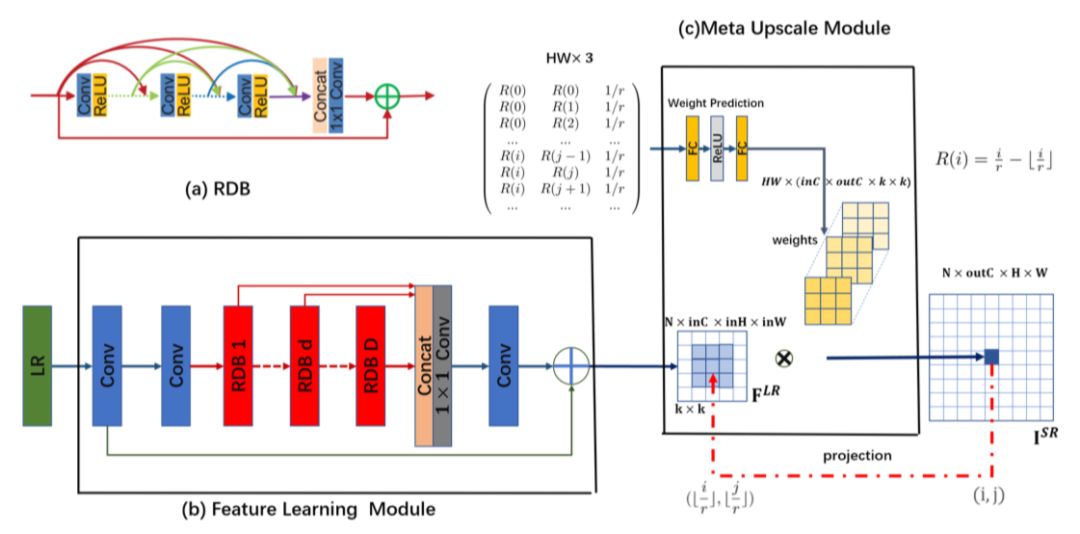

本节将介绍Meta-SR模型架构,如图1所示,在Meta-SR中,特征学习模块提取低分辨率图像的特征,Meta-Upscale按照任意缩放因子放大特征图。本文首先介绍Meta-Upscale,然后再描述Meta-SR的细节。

图 1:基于RDN的Meta-SR实例

Meta-Upscale

给定一张由高分辨(HR)图像I^HR缩小得到的低分辨(LR) 的图像I^LR,SISR的任务即是生成一张HR图像I^SR,其ground truth是I^HR。

本文选用RDN作为特征学习模块,如图1(b)所示。这里,本文聚焦于Meta-Upscale的公式化建模。

令F^LR表示由特征学习模块提取的特征,并假定缩放因子是r。对于SR图像上的每个像素(i, j),本文认为它由LR图像上像素(i′, j′)的特征与一组相应卷积滤波器的权重所共同决定。从这一角度看,放大模块可视为从F^LR到I^SR的映射函数。

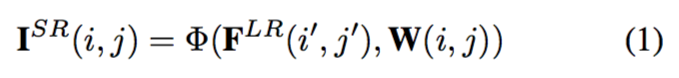

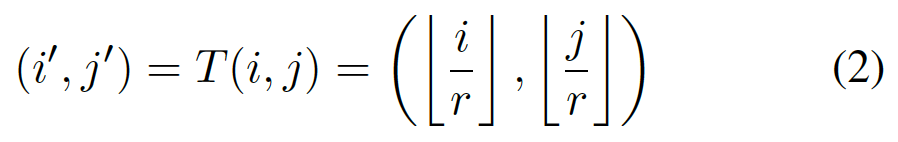

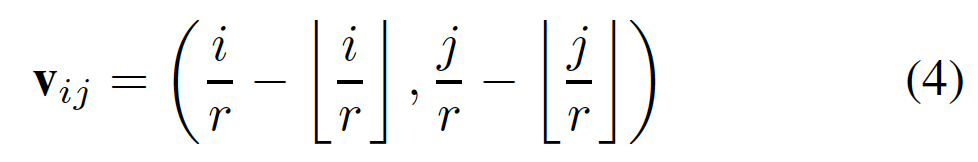

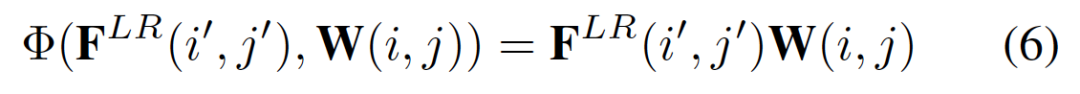

首先,放大模块应该找到与像素(i, j)对应的像素(i′, j′)。接着,放大模块需要一组特定的滤波器来映射像素(i′, j′)的特征以生成这一像素(i, j)的值。以上可公式化表示为:

由于SR图像上的每一像素都对应一个滤波器,对于不同的缩放因子,其卷积滤波器的数量和权重也不同。为解决超分辨率任意缩放因子问题,本文基于坐标信息和缩放因子提出Meta-Upscale模块以动态地预测权重W(i, j)。

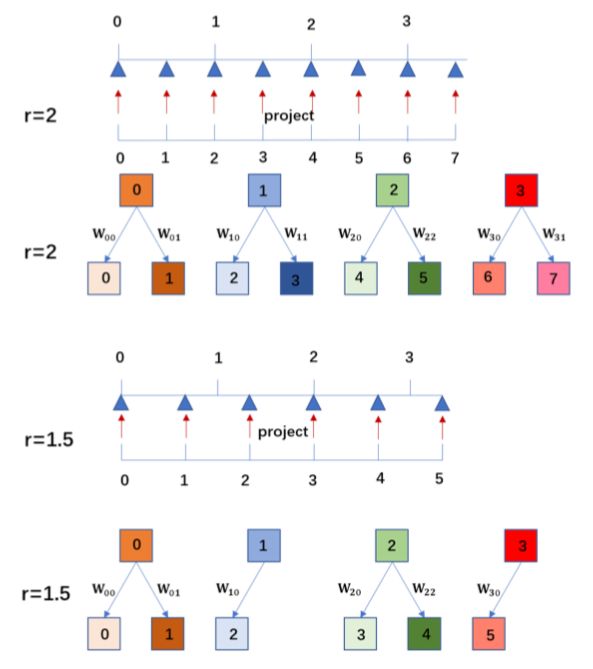

本文提出的Meta-Upscale模块由三个重要的函数,即Location Projection、Weight Prediction、Feature Mapping。如图2所示,Location Projection把像素投射到LR图像上,即找到与像素(i, j)对应的像素(i′, j′),Weight Prediction模块为SR图像上每个像素预测 对应滤波器的权重,最后,Feature Mapping函数利用预测得到的权重将LR图像的特征映射回SR图像空间以计算其像素值。

图 2:当非整数缩放因子r=1.5时,如何放大特征图的示意图

Location Projection。对于SR图像上的每个像素(i, j),Location Projection的作用是找到与像素(i, j)对应的LR图像上的像素(i′, j′)。本文认为,像素(i, j)的值是由像素(i′, j′)的特征所决定。下面的投影算子可映射这两个像素:

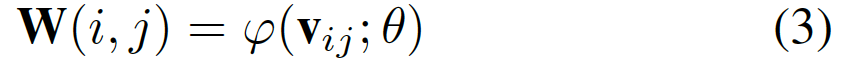

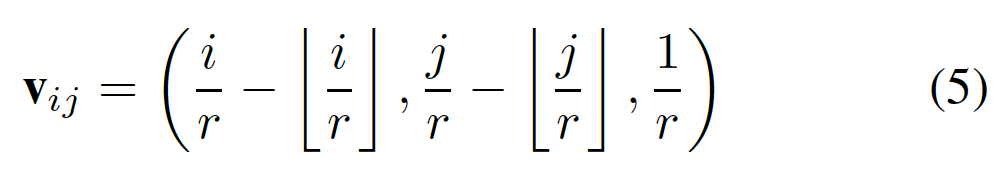

Weight Prediction。传统的放大模块会为每个缩放因子预定义相应数量的滤波器,并从训练集中学习W。不同于传统放大模块,Meta-Upscale借助单一网络为任意缩放因子预测相应数量滤波器的权重,这可表示为:

实验

单一模型任意缩放因子

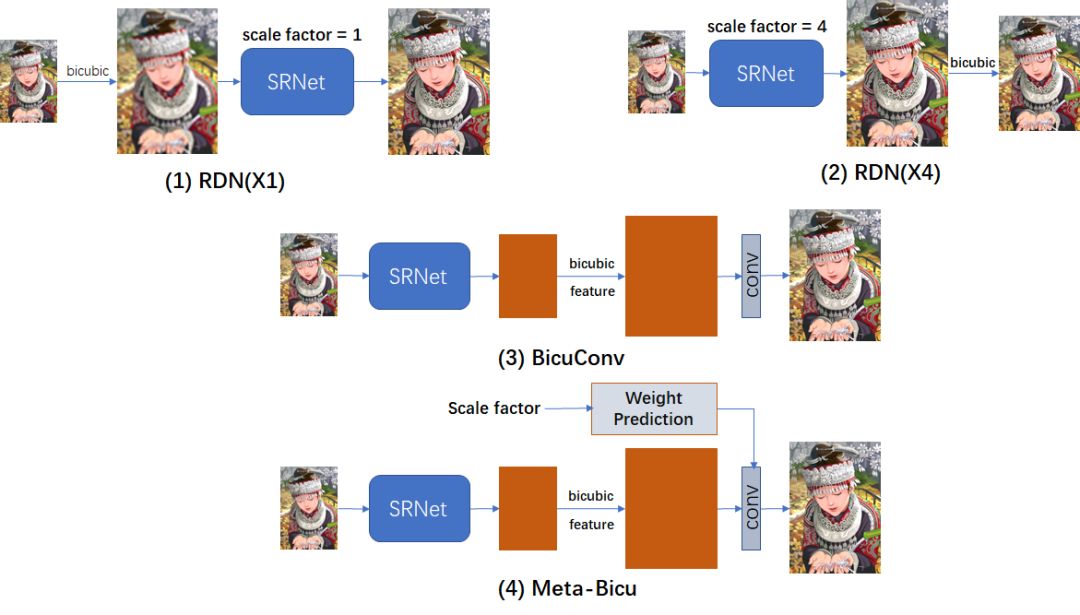

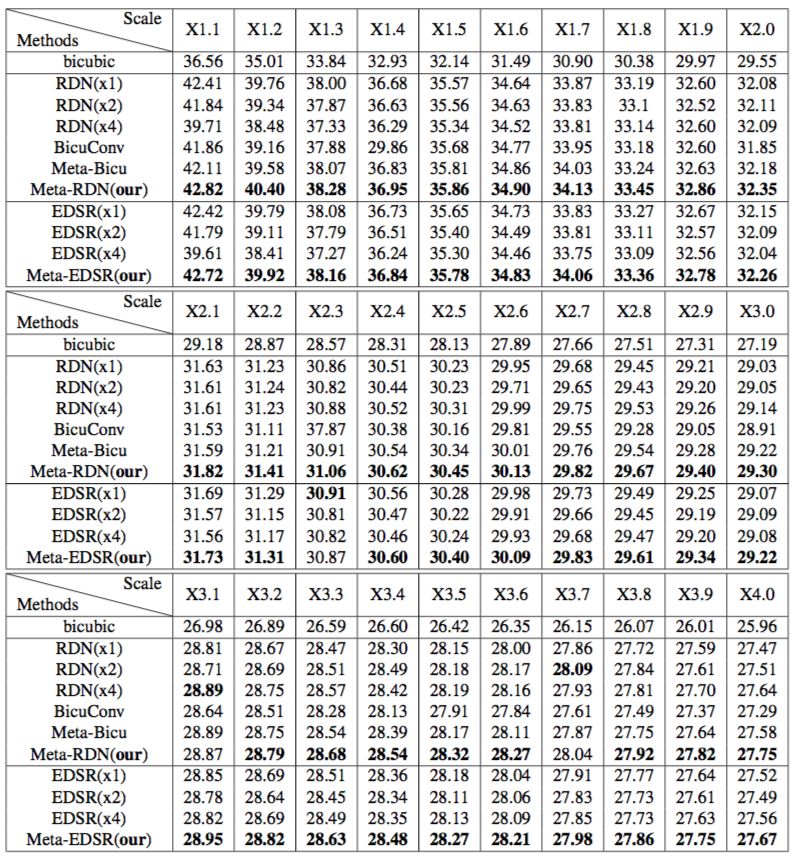

由于先前不存在类似于Meta-SR的方法,本文需要设计若干个baselines(见图3),以作对比证明Meta-SR的优越性。

图3 : 本文设计的baselines

实验结果如表1所示。对于双三次插值baseline,简单地放大LR图像并不会给HR图像带来纹理或细节。对于RDN(x1)和EDSR(x1),它们在较大的缩放因子上表现欠佳,而且需要提前放大输入,这使得该方法很费时。

对于RDN(x4)和EDSR(x4),当缩放因子接近1时,Meta-RDN与RDN(x4)(或者Meta-EDSR与EDSR(x4)之间) 存在着巨大的性能差距。此外,当r>k时,EDSR(x4)和RDN(x4)不得不在将其输入网络之前放大LR图像。

通过权重预测,Meta-Bicu和Meta-SR可为每个缩放因子学习到最佳滤波器权重,而BicuConv则是所有缩放因子共享同一的滤波器权重。实验结果表明Meta-Bicu显著优于BicuConv,从而印证了权重预测模块的优越性。

同时,Meta-RDN也由于Meta-Bicu, 这是因为对于在特征图插值,缩放因子越大,有效的FOV越小,性能下降越多。但是,在Meta-SR中,每个缩放因子具有相同的FOV。受益于Meta-Upscale,相较于其他baselines,Meta-RDN几乎在所有缩放因子上取得了更优性能。

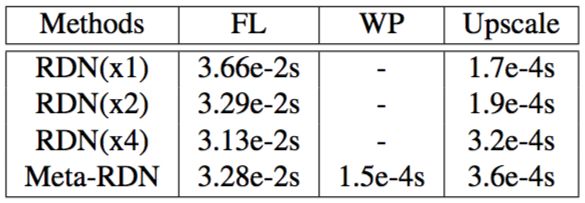

推理时间

SISR技术要实现落地,一个重要的因素是推理时间快。本文通过实验计算了Meta-SR的每一模块及baselines的运行时间,如表2所示。

表 2:运行时间对比结果

在表2中,FL表示Feature Learning模块,WP表示Meta-SR的Weight Prediction模块,Upscale是Upscale模块。测试是跑在B100上,测试的缩放因子是2。

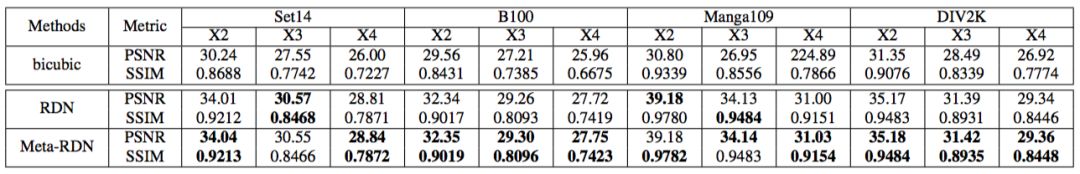

对比SOTA方法

本文把新提出的Meta-Upscale模块用于替代RDN中的传统放大模块,获得Meta-RDN,并将其与baseline RDN进行对比。

值得注意的是, RDN为每个缩放因子(X2, X3, X4)分别训练了一个特定的模型。本文按照PSNR、SSIM指标将Meta-RDN与RDN在4个数据库上作了对比,结果如表3所示:

表 3:当缩放因子为X2, X3, X4,Meta-RDN与RDN的对比结果

可视化结果

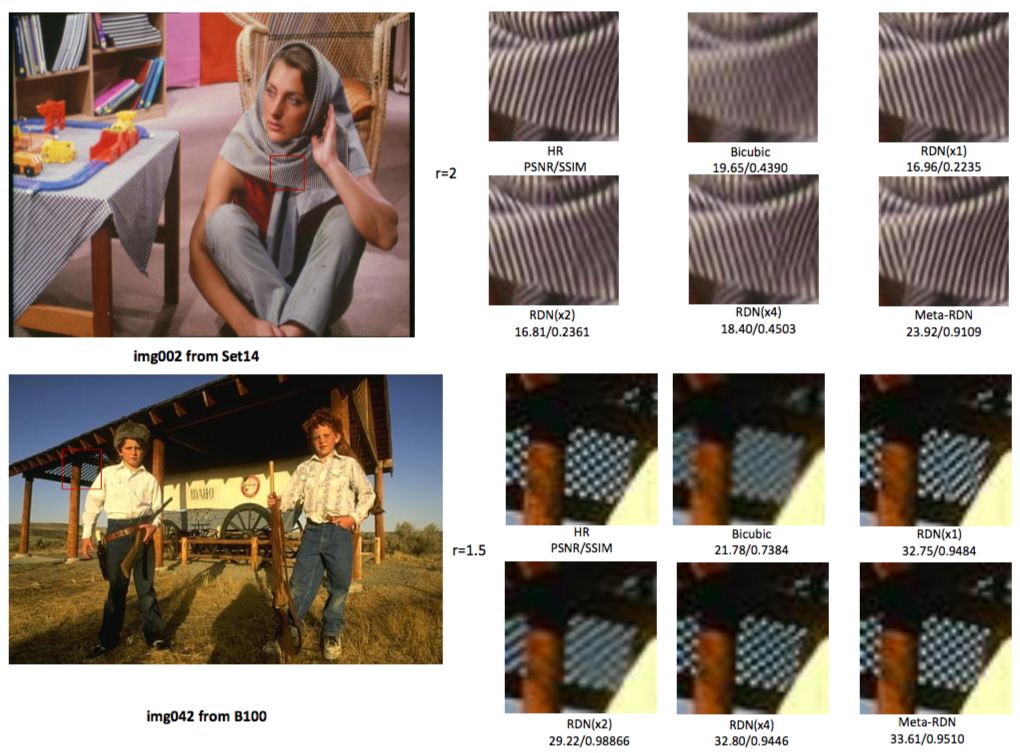

图4和图5分别给出了一些可视化结果。

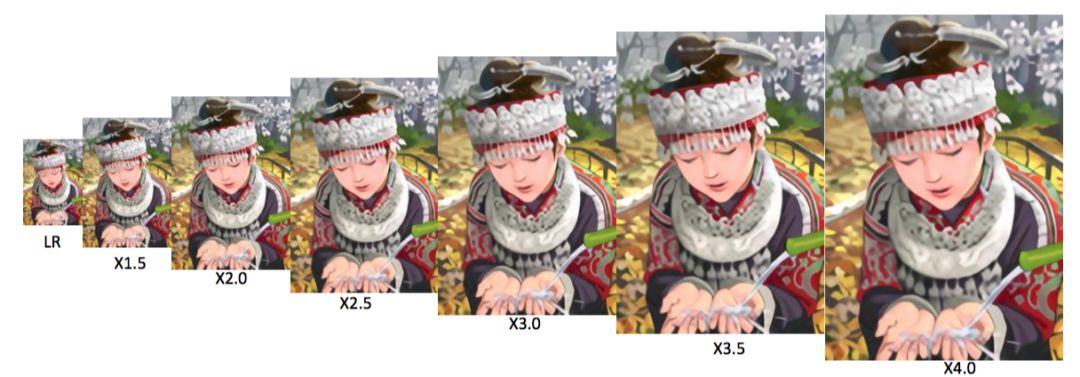

图 4:Meta-RDN方法按照不同缩放因子放大同一张图像的可视化对比结果

图 5:与4个baselines的可视化对比结果。Meta-RDN表现最优

结论

旷视研究院提出一个全新的放大模块,称之为Meta-Upscale,它可通过单一模型解决任意缩放因子的超分辨率问题。针对每个缩放因子,Meta-Upscale模块可以动态地为放大模块生成一组相应权重。借助特征图与滤波器之间的卷积运算,研究员生成了任意大小的HR图像;加之权重预测,进而实现了单一模型解决任意缩放因子的超分辨率问题。值得一提的是,Meta-SR还可以按照任意缩放因子快速地持续放大同一张图像。

参考文献

1. B. Lim, S. Son, H. Kim, S. Nah, and K. M. Lee. Enhanced deep residual networks for single image super-resolution. In The IEEE conference on computer vision and pattern recog- nition (CVPR) workshops, 2017. 1, 2, 5

2. W. Shi, J. Caballero, F. Husza ́r, J. Totz, A. P. Aitken, R. Bishop, D. Rueckert, and Z. Wang. Real-time single im- age and video super-resolution using an efficient sub-pixel convolutional neural network. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016. 1, 2, 5

3. K. Zhang, W. Zuo, and L. Zhang. Learning a single convo- lutional super-resolution network for multiple degradations. In The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2018. 1, 5

4. Y.Zhang,K.Li,K.Li,L.Wang,B.Zhong,andY.Fu.Image super-resolution using very deep residual channel attention networks. arXiv preprint arXiv:1807.02758, 2018. 2, 5

5. Y. Zhang, Y. Tian, Y. Kong, B. Zhong, and Y. Fu. Resid- ual dense network for image super-resolution. In The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018. 1, 2, 3, 5, 7

历史文章推荐:

机器学习中的最优化算法总结

深度学习500问!一份火爆GitHub的面试手册

深度学习最常见的 12 个卷积模型汇总,请务必掌握!

CVPR2019 | 专门为卷积神经网络设计的训练方法:RePr

深度神经网络模型训练中的最新tricks总结【原理与代码汇总】

基于深度学习的艺术风格化研究【附PDF】

最新国内大学毕业论文LaTex模板集合(持续更新中)

基于深度学习的图像超分辨率最新进展与趋势【附PDF】

t-SNE:最好的降维方法之一

年龄估计技术综述

若您觉得此篇推文不错,麻烦点点在看↓↓