ICLR 2020 | 神经网络架构搜索(NAS)论文推荐

ICLR 2020 线上会议已经圆满结束。此次会议关于 NAS 的研究主题包括对 benchmark 的探讨、对于流行的 NAS 方法的理解和分析,以及如何提高 NAS 方法的精度和效率等。值得一提的是,此届会议举办了 ICLR 历史上的第一个神经网络架构搜索(NAS)的Workshop(https://sites.google.com/view/nas2020/home),充分体现出 NAS 正成为越来越热门的神经网络研究方向。

此文列出以下十篇 ICLR 2020 上关于 NAS 的经典文章供大家学习参考!

1. NAS-Bench-201: Extending the Scope of Reproducible Neural Architecture Search

作者:Xuanyi Dong, Yi Yang

本文是 University of Technology Sydney 和百度研究团队的合作研究成果。近年来伴随着 NAS 的大火,NAS 的研究方法也层出不穷,但是对于各种方法的比较没有严格的基准。此篇文章致力于设立统一的基准(benchmark)用于不同 NAS 方法的比较。另外,虽然 NAS 可以自动搜索表现较好的模型,但是搜索的成本较高,尤其是是评估不同网络结构训练的成本。因此,此篇论文提供了 15625 个不同网络结构在三个数据集上的的训练的信息,有利于研究工作者避免繁琐重复的训练。

2. NAS-Bench-1Shot1: Benchmarking and Dissecting One-shot Neural Architecture Search

作者:Arber Zela, Julien Siems, Frank Hutter

作者来自 University of Freiburg 和 Bosch AI. 此篇论文与上篇论文在研究目的上具有较大的相似,上篇论文 spotlight,这篇论文被选为 poster. 因此在此对于这篇文章不做过多的总结。

3. NAS evaluation is frustratingly hard

作者:Antoine Yang, Pedro M. Esperança, Fabio M. Carlucci

后两位作者来自 Huawei Noah’s Ark Lab 该篇论文提供了 8 种 NAS 方法在 5 个数据集上的评估基准(benchmark),研究发现现有的NAS方法并没有比随机生成的网络结构具有显著的优势。

4. Understanding Architectures Learnt by Cell-based Neural Architecture Search

作者:Yao Shu, Wei Wang, Shaofeng Cai

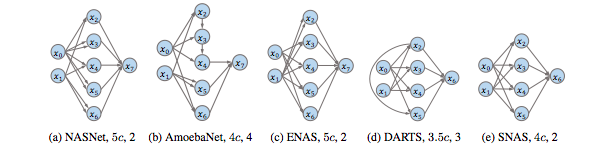

作者来自新加坡国立大学。研究发现现有的一些流行的 NAS 方法的 cell structure 大多呈现如下结构:

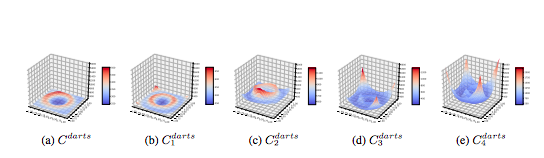

原因在于此种结构具有平稳的 loss landscape 以及快速的收敛性,如下图所示:

5. Understanding and Robustifying Differentiable Architecture Search

作者:Arber Zela, Thomas Elsken, Tonmoy Saikia, Yassine Marrakchi, Thomas Brox, Frank Hutter

此篇论文认为 DARTS 可微网络结构搜索对于一些新的数据集没有表现出稳健的结果。原因在于 DARTS 对于 valid dateset 过度拟合。因此,研究提供了一些解决方案。

6. Evaluating the Search Phase of Neural Architecture Search

作者:Christian Sciuto, Kaicheng Yu, Martin Jaggi, Claudiu Musat, Mathieu Salzmann

研究发现流行的 NAS 方法比如 DARTS, ENAS 和随机的网络结构具有相似的 performance。研究发现 weight sharing 是减弱这些流行方法的 performance 的一个原因。

7. PC-DARTS: Partial Channel Connections for Memory-Efficient Architecture Search

作者:Yuhui Xu, Lingxi Xie, Xiaopeng Zhang, Xin Chen, Guo-Jun Qi, Qi Tian, Hongkai Xiong

作者来自上海交通大学和华为诺亚方舟实验室,同济大学和 Futurewei Technologies。本篇论文为 spotlight。研究目的在于提高 DARTS 的训练和内存的有效性(efficiency)。

8. AtomNAS: Fine-Grained End-to-End Neural Architecture Search

作者:Jieru Mei, Yingwei Li, Xiaochen Lian, Xiaojie Jin, Linjie Yang, Alan Yuille, Jianchao Yang

作者来自约翰霍普金斯大学和字节跳动公司。此项研究的贡献在于增大了 NAS 的搜索空间(search space),以取得更高的精度。不同于 DARTS 有搜索和评估两个阶段,这篇文章 NAS 方法只有 end-to-end 这一个阶段。

9. Once for All: Train One Network and Specialize it for Efficient Deployment

作者:Han Cai, Chuang Gan, Tianzhe Wang, Zhekai Zhang, Song Han

作者来自 MIT 韩松团队。这篇论文主要内容是通过训练和搜索一种 once for all 的超级网络,以支持不同的硬件平台设施。

(关于本篇论文更多的信息参见“MIT 韩松专访:Once for All 神经网络高效适配不同硬件平台”)

10. FasterSeg: Searching for Faster Real-time Semantic Segmentation

作者:Wuyang Chen, Xinyu Gong, Xianming Liu, Qian Zhang, Yuan Li, Zhangyang Wang

本篇论文将 DARTS 用于 real-time 的图像分割上。发现网络结构 collapse 的问题。解决方法为加入一些正则项(regularization term)。

点击阅读原文,查看更多精彩!