独家揭秘 | 波士顿动力SpotMini机器人自主导航技术

坚持原创,点击上方蓝字关注我!

美国波士顿动力(Boston Dynamics)公司每隔一段时间就会放出几个可以在朋友圈刷屏的机器人视频,这不5月11日刚刚放出了两个最新的机器人视频,一个是Atlas人形机器人在田野间跑步的视频,一个是长的像小狗的SpotMini机器人通过自主导航在办公室自由穿行,会主动避开障碍物,甚至还会爬楼梯。

不过遗憾的是,每次放出的视频都没有具体的技术细节介绍。大家在朋友圈里感慨一下“哇,这机器人好牛X”后,这事似乎就这么过去了,后续几乎没有看到背后具体技术的资料。

我们知道波士顿动力的多足机器人的运动能力世界领先,不管是之前踹不倒的大狗,会后空翻的Atlas,还是本次发布的新功能,都在强调其快速、稳定的运动能力,不过这次SpotMini新增的的自主导航功能让人眼前一亮,不仅展示了它“四肢发达”,也展示了它“头脑不简单”。因此本文根据能查到的零碎少量的信息,结合相关专业知识,介绍一下这个“小狗”机器人SpotMini背后的自主导航技术到底是什么玩意儿?

SpotMini 介绍

SpotMini是一款小型的四足机器人。重量为约25kg(带上手臂30kg)。并且是纯电动驱动的,因此运动起来相对比较安静,充电一次可以使用约90分钟。

SpotMini本身的传感器包括:3D距离传感器、惯性测量单元(IMU,想了解更多?见《惯性导航系统简介》)、以及四肢内的位置/力量传感器。这些都是感知周围环境、了解自己运动状态,从而实现自主导航的必备传感器。SpotMini的关键参数如下图所示,其中红色方框内的3D视觉系统是实现自主导航的关键,上面提到的3D距离传感器就是3D视觉系统的重要组成部分。

3D距离传感器是什么?

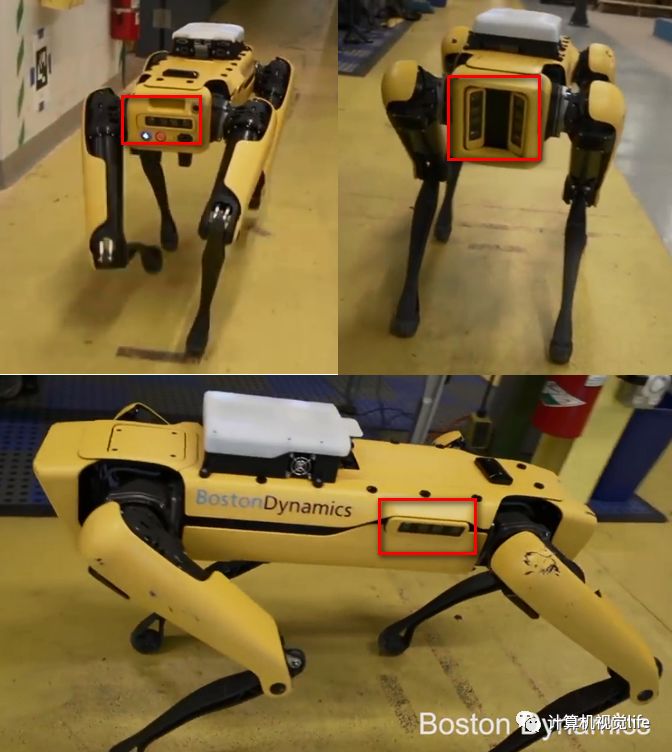

根据本次视频的介绍,SpotMini的正面,侧面,后面都安装了视觉传感器,下图红色方框内是具体的位置。

那么这个视觉传感器和3D距离传感器是什么关系?

3D距离传感器是用来获得二维图像+距离图像(术语叫深度图) 的设备,有很多种,比如基于结构光编码的RGB-D相机(想了解更多?见《深度相机原理揭秘--结构光(iPhone X 齐刘海原理)》)、基于飞行时间法的RGB-D相机(想了解更多?见《深度相机原理揭秘--飞行时间(TOF)》)、基于立体匹配的双目相机(想了解更多?见《深度相机原理揭秘--双目立体视觉》),以及激光雷达等。

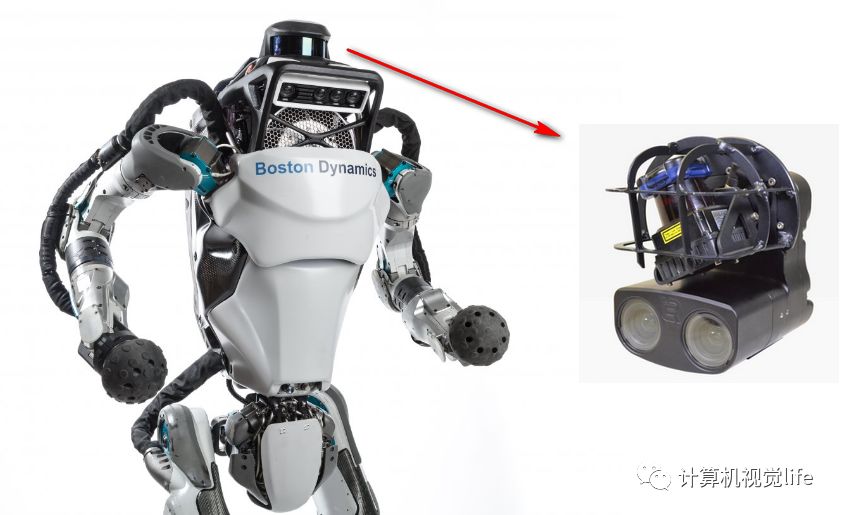

比如波士顿动力的Atlas机器人的3D距离传感器,使用的是Carnegie Robotics公司的MultiSense SL,这是一种多模式3D传感器,包括激光,双目相机传感器。

而SpotMini使用的3D距离传感器同样来自这家公司,型号为MultiSense S7 ,是一种紧凑的双目立体相机,分辨率高达2K x 2K,通过两相机视差可以计算出物体和相机的距离。

MultiSense S7简介

MultiSense S7是Carnegie Robotics公司的产品。 具有三高:高分辨率,高帧率,高精度。据官网介绍,它是第一款在相机内部本地处理所有算法的商用立体相机。不需要外置电脑,不需要相机标定,提供基于ROS的API和工具,可以实时查看图像和3D距离数据,拿来就能用。结构紧凑,可以方便的嵌入到机器人、汽车、移动设备上。

MultiSense S7的工作原理是什么?

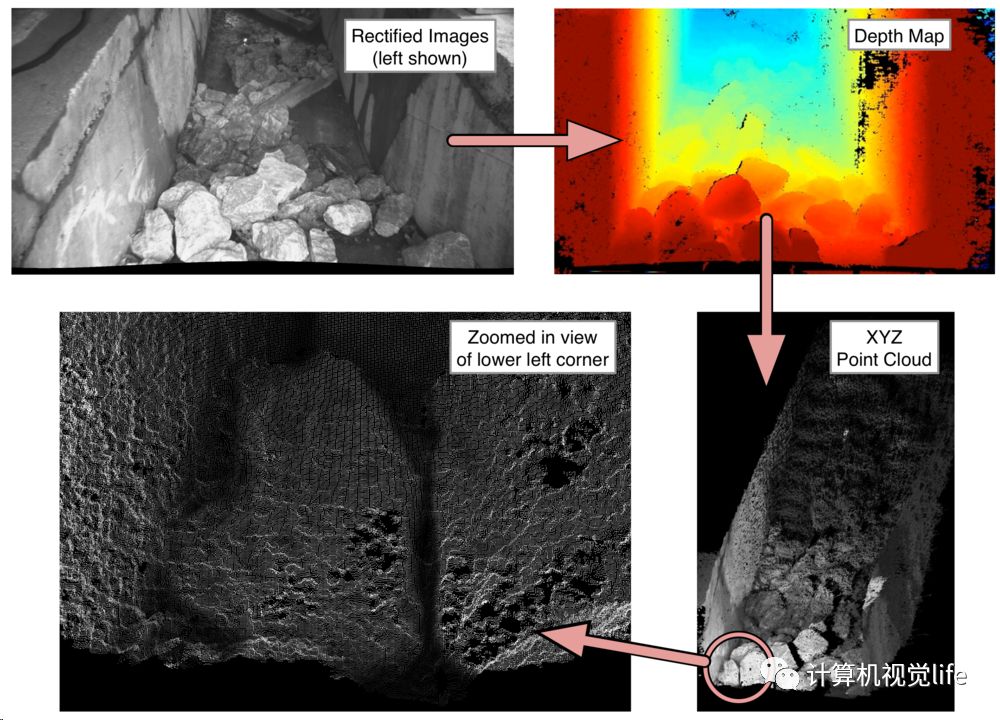

如下图所示,首先它拍摄左右两张高分辨率的图片,然后用标定内参对左右两幅图像进行了畸变校正,然后对两图逐点进行像素级匹配,匹配点水平方向差异就是视差d,物体到相机距离z=fb/d。其中b是两相机中心点之间的距离(术语叫基线),f是相机焦距。因此我们可以计算出深度图,从而得到了三维点云图。以上过程处理速度可以达到每秒15帧以上。

因此,借助3D距离传感器,SpotMini就具有了三维空间的感知能力。

如何实现自主导航?

仅仅有了感知能力只是定位导航的基础条件,如何实现更复杂的自主导航能力呢?

首先看一下官方的介绍。关于SpotMini自主导航,官方发布的视频中写了这么一段话:

在测试之前,机器人在人类指引下穿过空间,以便可以使用安装在机器人正面,后面和侧面的摄像机的可视数据来创建空间地图。在自主运动期间,SpotMini使用来自摄像机的数据在地图中定位本身,并检测并避开障碍物。

从上述描述我们可以发现几个关键点。

SpotMini想要在未知环境下实现自主导航,需要先在人类引导下走一遍,建立地图。

有了建好的地图,SpotMini才能定位自身位置,从而实现「自主导航」、检测躲避障碍物。

机器人实现自主定位和导航的核心技术称为Simultaneous Localization and Mapping,简称SLAM,中文译作同时定位与地图创建。这篇文章《SLAM初识》从扫地机器人类比,深入浅出的讲解了什么是SLAM技术。这里摘取其定义:

SLAM是指当某种移动设备(如机器人)从一个未知环境里的未知地点出发,在运动过程中通过传感器观测定位自身位置、姿态、运动轨迹,再根据自身位置进行增量式的地图构建,从而达到同时定位和地图构建的目的。定位和建图是两个相辅相成的过程,地图可以提供更好的定位,而定位也可以进一步扩建地图。SLAM非常强调未知环境,是自主移动机器人的核心技术。

因此,SpotMini由于事先人工引导建立了地图,解决了未知环境的问题,所以难度比SLAM降低了不少。因此,可以说SpotMini的自主导航其实是在已经建立好的地图上进行的定位,可以认为是利用3D视觉传感器及IMU来观察周围环境,看看自己在地图的什么位置,然后开始规划自己的运动路径,沿着地图奔跑。如下图所示。

因为有了3D距离传感器,SpotMini可以感知障碍物离自己的距离,从而避开障碍物。如下图左下角所示。

当然,SpotMini虽然是SLAM的简化版,但是实际上SpotMini的自主导航技术还是有许多非常厉害的地方,比如一般用于自主导航的机器人都是慢速轮式机器人,或者无人机,属于运动比较稳定的情况。而SpotMini整个是在奔跑中,还兼顾上下楼梯,所以双目相机存在严重的运动模糊现象,SpotMini 解决了这个问题,还是非常牛X的。另外发布的视频中的SpotMini 和官网上的相比,背上貌似多了两个东西,不太清楚是什么作用。

讨论就到这里。如果你有不同的见解,或者还有什么可以补充的知识,欢迎在下方留言。

点击图片查看相关阅读

注:转载请联系simiter@126.com,注明来源,侵权必究。