评估语言模型的句法能力

发布人:Google Research AI 学员 Jason Wei 与研究员 Dan Garrette

近年来,BERT 和 GPT-3 等预训练语言模型在自然语言处理 (Natural language processing, NLP) 中得到了广泛应用。通过使用大量文本进行训练,语言模型获得了关于现实世界的广泛知识,在各种 NLP 基准测试中取得了出色的表现。然而,这些模型通常并不透明,由此也不清楚它们的表现为什么如此抢眼,这也限制了模型以假设为驱动力实现进一步改进。因此,一条新的科学探究路线随之展现:这些模型中包含了哪些语言知识?

GPT-3

https://arxiv.org/abs/2005.14165

虽然我们想要研究的语言知识类型可能很多,但是,能为此次分析提供坚实基础的一个主题是英语中的主谓一致语法规则,它要求动词的单复数形式应与主语的单复数形式一致。例如,“The dogs run.”符合语法规则,因为“dogs”和“run”均为复数形式,但“The dogs runs.”则不符合语法规则,因为“runs”是单数形式。

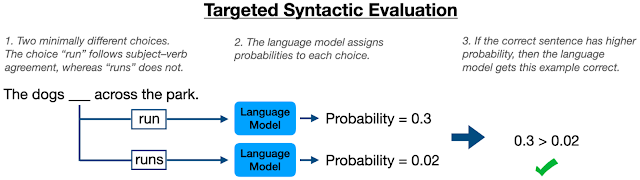

用于评估语言模型语言知识的一个框架是针对性句法评估 (TSE),在该框架内,系统向模型显示差异性最小的成对语句,其中一个语句符合语法规则,另一句不符合语法规则,然后强制模型确定哪一句符合语法规则。TSE 可用于测试英语主谓一致规则这一语言知识,方法是让模型判断同一个句子的两个版本:其中一句的动词写为单数形式,另一句则写为复数形式。

针对性句法评估

https://aclanthology.org/D18-1151/

在上述背景下,我们在 EMNLP 2021 上发表的“频率对 Transformer 中句法规则学习的影响 (Frequency Effects on Syntactic Rule-Learning in Transformers)”一文中,研究了 BERT 模型正确应用英语主谓一致规则的能力,是如何受到预训练期间单词出现次数的影响。为测试特定条件下模型的表现,我们使用精心控制的数据集从头开始预训练 BERT 模型。我们发现,在预训练数据中主语谓语对没有同时出现的情况下,BERT 模型表现良好,这表明该模型确实学会了应用主谓一致规则。但是,当错误的语法形式出现的频次高于正确形式时,模型倾向于预测错误形式,这表明 BERT 没有将语法一致性视为必须遵循的规则。这些研究结果有助于我们更好地理解预训练语言模型的优势与局限性。

EMNLP 2021

https://2021.emnlp.org/

频率对 Transformer 中句法规则学习的影响

https://arxiv.org/abs/2109.07020

在早期研究中,我们在 BERT 模型中使用了 TSE 来评估其应用英语主谓一致规则的能力。在这样的条件设置下,BERT 执行一项填空任务(例如,“the dog _ across the park”),具体指为给定动词分配单数形式和复数形式的概率(例如,“runs”和“run”)。如果模型已正确地学会了应用主谓一致规则,那么它应该始终为那些让句子语法正确的动词形式分配更高的概率。

早期研究

https://arxiv.org/abs/1901.05287

早期的这项研究同时使用自然语句(取自维基百科)和随机数语句来评估 BERT,后者指人为构造的符合语法但在语义上无意义的语句,例如 Noam Chomsky 的著名例句“colorless green ideas sleep furiously(无色的绿色想法愤怒地睡觉)”。随机数语句在测试句法能力时很有用,因为模型不能仅依赖于表面的语料库统计数据:例如,虽然“dogs run”比“dogs runs”更为常见,但“dogs publish”和“dogs publishes”都非常少见,因此模型不可能只是记住其中一个比另一个更有可能这样的事实。

BERT 在随机数语句上实现了超过 80% 的准确率(远优于 50% 的随机机会基线),该数据可用于证明模型已经学会应用主谓一致规则。在我们的论文中,我们跳出了早期的这一研究,在特定数据条件下预训练 BERT 模型,这让我们能够更深入地研究训练结果,了解预训练数据中的某些模式如何影响模型表现。

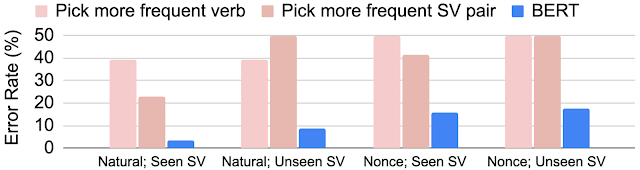

我们首先对比研究了模型对于预训练期间见过主语谓语对,与主语和谓语动词从未出现在同一个句子中的示例的不同表现:

BERT 在自然和随机数评估语句上的错误率,按训练期间是否在同一句子中看到特定的主语谓语 (SV) 对进行分类。BERT 在未见过的主语谓语对上的表现远远优于简单的启发式算法,例如,选择更频繁的谓语动词或选择更频繁的主语谓语对

对于未见过的主语谓语 (SV) 对,BERT 在自然和随机数评估语句上的错误率都略微增加,但其表现仍然大幅优于仅采用启发式算法,例如选择在预训练数据中更频繁出现的谓语动词形式,或选择与主语名词一起出现频率更高的谓语动词形式。这说明 BERT 不仅反映了它在预训练期间看到的内容:不仅基于原始出现频率进行决策,而且将其泛化到新的主语谓语对,这表明模型已经学会应用一些涉及主谓一致的基本规则。

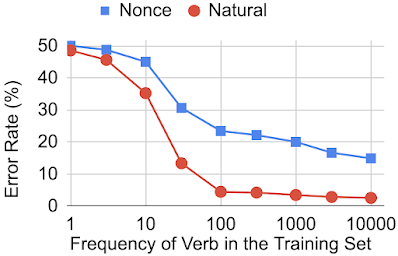

接下来,我们跳出对见过与未见过的主语谓语对的研究,进一步探讨单词的频率如何影响 BERT 应用主谓一致规则正确使用该单词的能力。在本研究中,我们选择了包含 60 个动词的一组词语,然后创建了多个版本的预训练数据,每个版本都设计为包含特定频率的 60 个动词,确保单复数形式出现次数相同。然后,我们使用这些不同的数据集训练了 BERT 模型,并就完成主谓一致任务对其进行了评估:

BERT 遵循主谓一致规则的能力取决于训练数据集中动词的频率

研究结果表明,虽然 BERT 能够对主谓一致规则进行建模,但它需要看到一个动词大约 100 次才能稳定地对其应用语法规则。

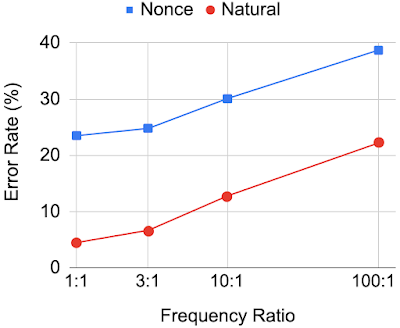

最后,我们想了解动词单复数形式的相对频率如何影响 BERT 的预测结果。例如,如果动词的一种形式(例如,“combat”)比另一种动词形式(例如,“combats”)更频繁地出现在预训练数据中,那么 BERT 更有可能分配高概率到出现频率更高的形式,即使它在语法上是不正确的。为了评估这一点,我们再次使用了相同的 60 个动词,但这次我们创建了预训练数据的人为操纵版本,其中两种动词形式之间的出现频率比从 1:1 变化到 100:1 不等。下图显示了 BERT 在这些不同程度的频率不平衡下的表现情况:

随着训练数据中不同动词形式之间的频率比变得更加不平衡,BERT 语法正确地使用这些动词的能力下降

这些研究表明,当两种动词形式在预训练期间被看见的次数相同时,BERT 在预测正确的动词形式方面取得了良好的准确率,但随着两种形式被看见频率之间的不平衡程度加剧,预测结果也变得更糟。这意味着,即使 BERT 已经学会了如何应用主谓一致,该模型也不一定将其视为“规则”,而是更愿意预测高频词,不管这些词是否违反主谓一致的约束条件。

使用 TSE 对 BERT 性能的评估揭示出其在句法任务上具备语言能力。此外,根据训练数据集中单词出现频率对其句法能力的研究,揭示了 BERT 处理竞争优先级的方式。该模型知道主语和谓语动词应该保持一致,以及高频出现的单词的可能性更高,但无法理解主谓一致是必须遵守的一种规则,而频率仅是偏好。希望本研究为语言模型如何反映训练它们的数据集的属性带来新的见解。

能够与 Tal Linzen 和 Ellie Pavlick 合作完成该项目,我们深感荣幸。

点击“阅读原文”访问 TensorFlow 官网

不要忘记“一键三连”哦~

分享

点赞

在看