懂一点物理的人工智能

作者丨庞龙刚

单位丨UC Berkeley博士后

研究方向丨高能核物理、人工智能

前段时间写了篇文章推介机器人动力学中的深度拉格朗日网络,得到出奇多的点赞。后来想起来,这应该是我第三次见到类似的研究。这类研究有个共同的名字——懂物理的深度学习。英文为 Physics Informed Deep Learning 或者叫 Physics-guided deep learning。

前两次见到是在劳伦斯伯克利国家实验室。第一次是 Northeastern University 的 Rose Yu 女士到实验室给报告,介绍如何使用深度神经网络替换掉物理模型中的一个子模块,从而可以对各种地形预测无人机马达与环境之间形成的湍流干扰,使得无人机近地起飞和降落时更加稳定。第二次是 Brown University 的陆路博士在 Machine Learning for Science 会议上以海报的形式展示了他们的 DeepXDE 库,这个库使用深度神经网络数值求解偏微分方程,这种方法里,微分方程已知,初始条件,边界条件已知,目标是求解一个方程让它满足所有这些条件。

DeepXDE 使用神经网络来近似偏微分方程的解

是网络的输入。优化目标是最小化

这篇文章介绍一下 Physics Informed Deep Learning 的原始文献和随机抽选的文章,看一下这类研究的方式以及可能的应用场景。

Physics Informed Deep Learning

这篇文章 [1] [2] 提出两个动机:1)使用数据驱动的方法得到偏微分方程解;2)数据驱动定偏微分方程各项的系数。

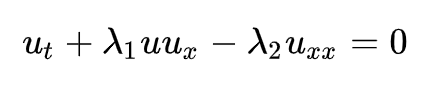

这两个动机完美的体现在使用神经网络求解 Burgers 方程的例子中。Burgers 方程在流体力学,非线性声学,气体动力学和交通流中有很多应用场景。对应 NS 方程无压强梯度时流速满足的方程。剪切粘滞很小时,导致激波产生,数值解比较难。方程形式如下:

这个方程里的解是 u(t,x),函数形式未知。是 u 对时间 t 的一阶微分,

和

分别是 u 对坐标 x 的一阶与二阶微分。Burgers 方程的系数

与系统的耗散有关。

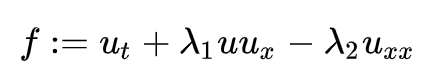

Physics Informed Neural Network 是如下这个函数 f:

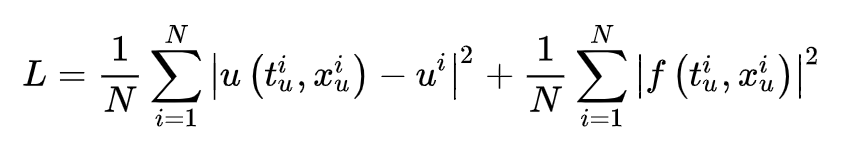

使用神经网络来近似方程的解 u(t,x,θ),而这个解又满足 Burgers 方程。所以这里类似有两个神经网络,外层神经网络有两个参数,内层神经网络参数是 θ。训练目标是最小化如下损失函数:

其中第一项要重现测量到的数据,第二项学习 Burgers 方程的系数

。

下方是训练结果。第一行是测量到的高噪声训练数据。第二行是神经网络预测值与精确解的对比。表格第一行是 Burgers 方程的精确形式,第二行是用干净数据约束出的 Burgers 方程的,第三行是用加入 1% 噪声的数据约束出的 Buregers 方程。

在这篇文章里,偏微分方程的形式已知,解的物理测量已知,解析解未知,系数未知,神经网络通过监督学习得到了近似的解析解和偏微分方程的系数。

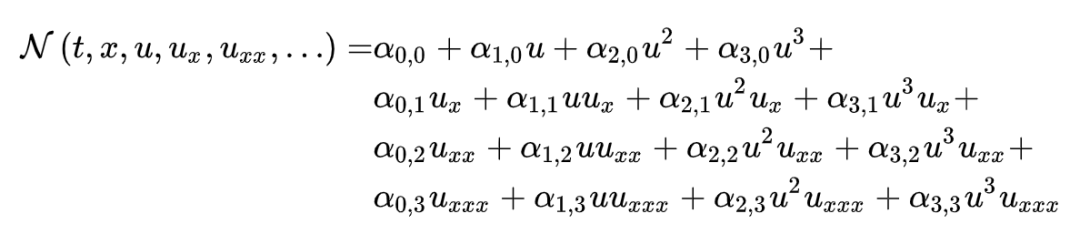

在随后的一篇文章中 [3],作者进一步放松限制,假设偏微分方程形式未知,通过 L1 正规化(sparse regression) 来敲掉系数为零的微分算子。其假设的偏微分方程形式如下:

Deep Galerkin Method [7]

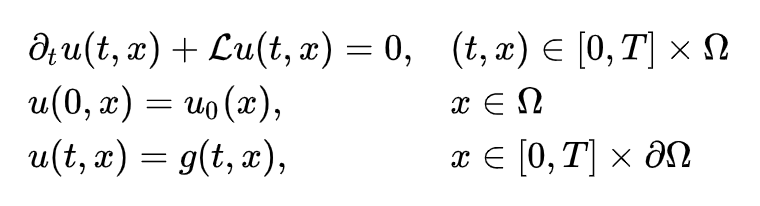

之前的方法是通过测量值来约束 u 和偏微分方程的系数,属于监督学习。在参考文献 [7] 中,作者使用了非监督学习。问题是使用神经网络求如下偏微分方程的解:

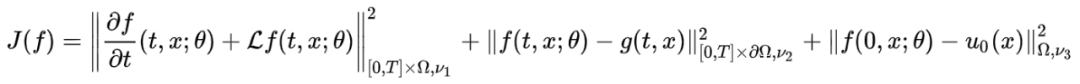

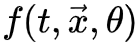

上述三行方程中,第一行是偏微分方程,第二行是初始条件 (t=0),第三行是边界条件 (∂Ω)。时间 t 的范围是 [0, T] ,坐标 x 的范围是 Ω。神经网络近似解 f(t,x,θ) 由最小化如下误差函数得到:

也就是之前描述的,神经网络近似解要(1)满足方程本身(2)满足边界条件 (3)满足初始条件。

这篇文章强调的一个创新是 mesh-free。这在解高维偏微分方程的时候非常重要,因为假设一个方向的 mesh 有 100 个格子,3 维空间就有 100 万个格子,更高维的时候格子数爆炸性增长。

如果使用梯度下降,计算 J(f) 要对整个时间,空间积分,基本不可能。如果使用深度学习训练时的随机梯度下降,则可以每次抽样一批随机坐标,分批次的更新神经网络参数 θ。

注意,损失函数中

虽然这篇文章起名叫 Deep Galerkin Method 方法,但其实跟 Galerkin 没什么关系。我所了解的 Galerkin 类似于有限元算法,在非常大的格子与时间步长上,对偏微分方程的解用一些正交函数展开,来近似坐标依赖和时间依赖。

个人思考

Deep Galerkin Method 或 DeepXDE 能够给出复杂偏微分方程的近似解,通过这个解对方程,边界条件和初始条件的破坏,能够判断神经网络近似的程度有多高。在这种情况下,新的基于神经网络的方法应该可以用来验证传统方法的数值误差,比如因差分近似带来的数值粘滞等。我看到同时求解爱因斯坦场方程,麦克斯韦方程,流体力学方程来描述中子星融合释放引力波的曙光。这种方法可能是所有数值解里最简单直接暴力的方法了。

当然,这种解偏微分方程的方法,训练一次应该只对一个特定的初始条件有效。像我们做相对论流体力学,每次都要从一个不同的初始条件出发,观察系统的演化,应该需要将这种方法进一步改进。

下面参考文献的最后两篇,一篇做无人机径迹的非线性控制,一篇解机器人动力学中的逆问题,都是 Physics Informed Deep Learning 极好的应用场景。

参考文献

点击以下标题查看更多往期内容:

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 访问知乎专栏