【Transformer】浅谈 Transformer-based 模型中的位置表示

本文小结:本文主要对原始 Transformer[1]、RPR[2]以及 Transformer-XL[3] 中使用的位置表示方法,进行详细介绍。从最初的绝对位置编码,与单词嵌入相加作为第一层的输入,再到 RPR 提出直接在注意力分数的计算中引入相对位置信息,并学习相对距离的表示矩阵(长度固定),再到 Transformer-XL 中引入偏置信息,并重新使用 Transformer 中的编码公式生成相对距离的表示矩阵,使长度可泛化。

需要注意的是,后两文中均有一些矩阵计算上的优化,本文并未提及,还请感兴趣的读者自行阅读相关内容。

感兴趣的读者可以关注一下我的专栏,会持续分享自己的学习笔记~

如有疏漏之处,还望不吝赐教~

0. 位置信息

首先简单谈一下位置信息。一般将位置信息简单分为绝对位置信息和相对位置信息,并且前者对句子语义的影响不大,更为重要的是后者。

以情感分析 sentiment analysis 为例:

I like this movie because it doesn't have an overhead history.

PositiveI don'tlike this movie because it has an overhead history.

Negative

don’t 与like的相对位置不同,决定了这两句话的情感取向是一正一负的,但在传统词袋(Bag-Of-Words BOW)模型中,这两句话得到的句子表征却是一致的,可见单词的相对位置对语义有关键性影响。

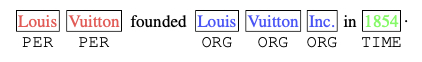

再以命名实体识别 Named Entity Recognition 为例[4]:

一般而言,在 Inc. 之前的单词为 ORG 而在 in 之后为 TIME 或 LOC ,但是同为 Louis Vuitton ,与 Inc. 相距较远的为PER,指的是创立者(人)这一实体,而相距较近的为ORG,指的是组织(公司)这一实体。可见,单词之间的相对位置在 NER 任务中是十分重要的。

需要注意的是,相对位置是具有方向性的(Inc. 与 in 的相对距离为 -1,1854 与 in 的相对距离为 1)

那么,如何对位置信息进行表示呢?

感兴趣的同学可以看下这篇文章 Encoding Word Order in Complex Embeddings 。

下文结合原始 Transformer,RPR,Transformer-XL 以及相关变体,试解释 Transformer-based 模型中的位置信息的表示问题。

1. 原始 Transformer [1]

原始 Transformer 中使用 Positional Encoding 生成固定的位置表示。

其中,pos 指的是 token 的位置。设句子长度为

i 是向量的某一维度,例如

因此,借助上述正余弦公式,我们可以为每个位置生成

We chose this function because we hypothesized it would allow the model to easily learn to attend by relative positions, since for any fixed offset k,can be represented as a linear function of

![]()

已知三角函数公式如下:

因此,可以将

作者希望借助上述绝对位置的编码公式,让模型能够学习到相对位置信息。

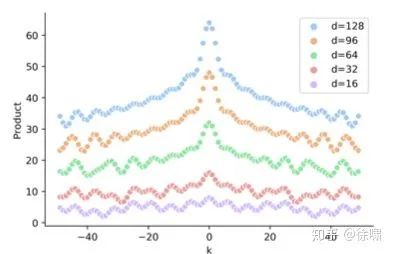

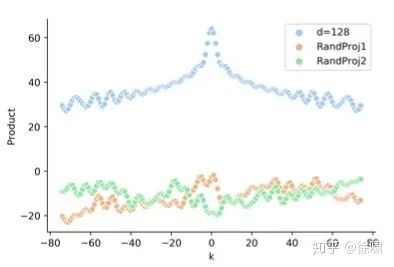

虽然如此获得的 position embeddings,两者之间的点积能够反应相对距离,但它缺乏方向性,并且这种特性(相对距离)会被原始 Transformer 的注意力机制破坏:[4]

基于公式

其中,

因此,对于给定的位置 pos 和 偏移量 k 而言,

此外,由于点积结果只依赖于 k,那么令

但是在 Transformer 中,由于需要经过映射,即两者间的点积实际是

最后,Transformer 之前的《Convolutional Sequence to Sequence Learning》[5] 以及之后的 BERT[6] 都没有选择使用 Positional Encoding 的方式生成位置表示,而是采取了所谓的“learned and fixed”的可学习的 Position embedding ,也就是去训练一个嵌入矩阵,大小为

2. 相对位置表示[2]

Relative Position Representations(以下简称为RPR) 一文中认为,RNN 通常依靠其循环机制,结合

Transformer 中的 Self-attention 机制如下,输入

RPR 的不在输入时将位置表示与 token 表示相加,而是选择对 self-attention 进行改动:

这里的

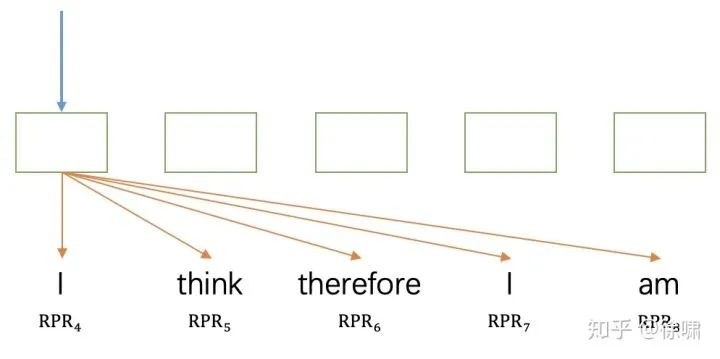

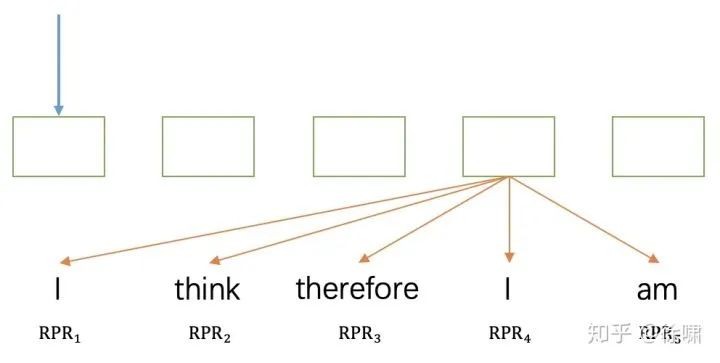

因此,模型学习相对位置表示

当

其中,“I” 使用的是

其中,“I” 使用的是

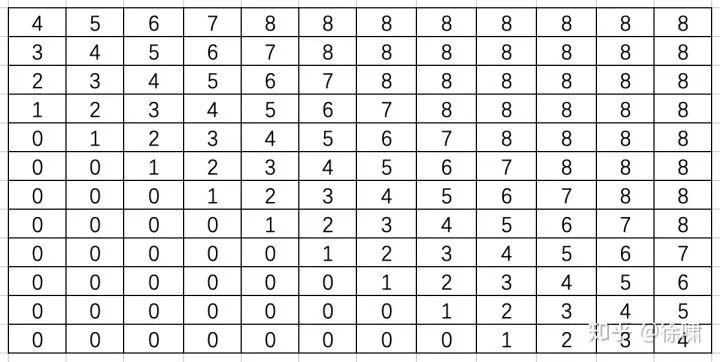

另外,作者认为精确的相对位置信息在超出了一定距离之后是没有必要的,并且截断后会使得模型的泛化效果好,即可以更好的泛化到没有在训练阶段出现过的序列长度上。

这里试举一例帮助理解。当输入句子长度为 12 且 k = 4 时, 此时的 RPR index 矩阵为:

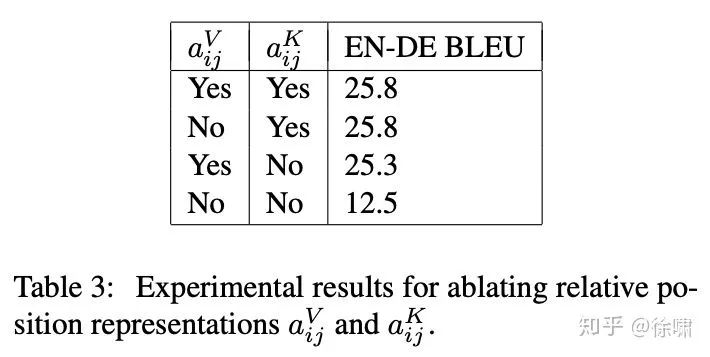

不过,论文在对机器翻译任务进行消融实验时发现,

@李如 :补充一个RPR的tensorflow实现:https://github.com/THUNLP-MT/TH

3. Transformer-XL[3]

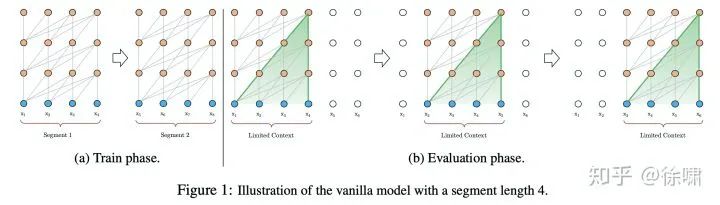

Al-Rfou et al. (2018) [8]成功在字符级语言建模中训练了深度(64 层) Transformer 网络,效果超越了 LSTM,但是其输入为分离的、固定长度(几百个字符)的片段,并且没有跨片段的信息传递。由于固定的上下文长度,模型无法捕获超出预定义的上下文长度的任何长期依赖。另外,固定长度的片段是通过选择连续的字符块而创建的,并未考虑句子边界或任何其他语义边界。因此,该模型缺乏必要的上下文信息来较好地预测最初的几个符号,这会导致无效的优化和较差的性能。

作者将此问题称为上下文碎片(context fragmentation)。如果给定无限的存储和计算能力,一个简单的解决方案就是使用无条件的 Transformer 解码器来处理整个上下文序列,类似于前馈神经网络。然而在实践中由于资源有限,通常是不可行的。为了解决这一问题,作者提出了片段循环机制(segment-level recurrence) 和新的相对位置编码(Relative Positional Encodings)方法。[9]

动态演示: vanilla model 的训练过程

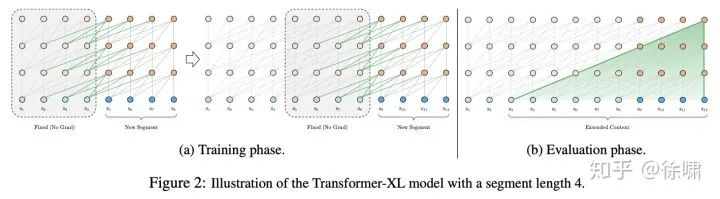

首先深入探究 Al-Rfou 等人的做法,下文将其称为 vanilla model。如上图 1.a 所示, vanilla model 将整个语料库拆分为长度受限的片段,并且只在每个片段内训练模型,忽略了来自先前片段的所有上下文信息。这使得训练过程中,信息不会在 forward 或 backward 过程中跨片段流动,而且这使得最大依赖长度受到了片段长度的限制(这本是 Self-attention 的优势)。其次,虽然可以通过 padding 来考虑句子边界或任何其他语义边界,但是在实践中直接简单分块已成为提高效率的标准做法。这也就是作者说的上下文碎片问题。

动态演示: vanilla model 的评估过程

在评估过程中,vanilla model 也在每一步中消耗与训练中相同长度片段,但仅在最后一个位置进行预测。然后,在下一步仅将片段向右移动一个位置,并且重新进行计算。如图 1.b 所示,如此可确保每一步预测都能利用训练期间暴露的最长可能上下文,并且还缓解了训练中遇到的上下文碎片问题。但是,这种评估过程太过昂贵。

这里我们先来看 XL 中的片段循环机制。引入循环机制,在训练过程中,前一片段中的隐藏状态序列(每一层都)会被固定并缓存,以便在处理下一片段时使用其作为「扩展上下文」。如图 2.a 所示,绿色部分表示当前片段使用的扩展上下文。对于每一层而言,输入为前一片段以及当前片段的前一层的输出,从而可以保证对长期依赖的建模能力并避免了上下文碎片问题。

下面用公式表达上述过程。第

其中,

借助片段循环机制,可以使隐藏状态做到片段级循环,这实际上使得有效的上下文可以远远超过两个片段。注意,这里的

基于片段循环机制,不仅可以获得更长的上下文从而解决上下文碎片问题,而且可以加快评估速度。在评估过程中,XL 可以重复使用先前片段中的表示,不需要像 vanilla model 那样重新计算。最后,理论上讲,可以在 GPU内存允许的范围内缓存尽可能多的片段作为扩展的上下文,并将可能跨越了多个片段的旧隐藏状态称为 Memory

在借助上述文字充分理解片段循环机制后,再来看为了在 Transformer 中实现这一机制而提出的 Relative Positional Encodings。

在片段循环机制中,有一个重要问题没有得到解决:如何保证在循环时,位置信息的连贯性?具体而言,vanilla Transformer 中使用 positional encodings 获得

其中,

为了避免上述问题的出现,论文提出了仅在隐藏状态中对相对位置信息进行编码。

Conceptually, the positional encoding gives the model a temporal clue or “bias” about how information should be gathered, i.e., where to attend.

从概念上讲,位置编码为模型提供了关于如何理解信息(关注哪里)的时间线索或时间偏差/倾向。为此,可以在每一层的 attention score 中引入相同的信息,而不是将 “bias” 静态放入初始嵌入中。更重要的是,以相对方式定义的时间偏差是更为直观和可泛化的。例如,查询向量

为了理解如何动态引入相对位置信息,我们首先将同一片段内的

本文基于仅依赖相对位置信息的思想,提出如下改动:

下面对改动进行一一解释。

首先将

中用于计算键向量的绝对位置编码

替换为相对位置编码

。注意这里的

不是可学习的,而是和 vanilla Transformer 中类似的正弦编码矩阵,只要将其公式中的 pos 替换为

即可。(这里的

,因为模型是自回归的)

接着引入可训练参数

来代替

中原来的

,这使得所有查询位置 i 的查询向量都是相同的,所以不管查询位置是什么,对不同单词的注意偏差都是相同的。类似的,引入

来代替

中的

。

最后,将原来的

分为两个权重矩阵

,分别生成基于内容的和基于位置的键向量。

本文认为此时的公式中的每一项都尤其直观含义:

表示基于内容的处理 (content-based addressing)

表示基于内容的位置偏差 (content-dependent positional bias)

表示整体内容偏差 (global content bias)

表示整体位置偏差 (global positional bias)

与 RPR 相比,RPR 仅仅只有

结合上述两种机制,就得到了 Transformer-XL 的体系结构。对于一个单注意力头的 N 层 Transformer-XL 而言,对于

其中,

这里需要补充的是,Transformer-XL 所采用的相对距离表示方法是不具有方向性的,即

参考

^abAttention Is All You Need https://arxiv.org/abs/1706.03762

^abSelf-Attention with Relative Position Representations https://arxiv.org/abs/1803.02155

^abTransformer-XL: Attentive Language Models Beyond a Fixed-Length Context https://arxiv.org/abs/1901.02860

^abcTENER: Adapting Transformer Encoder for Name Entity Recognition https://arxiv.org/abs/1911.04474

^Convolutional Sequence to Sequence Learning https://arxiv.org/abs/1705.03122

^BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding https://arxiv.org/abs/1810.04805

^How self-attention with relative position representations works https://medium.com/@_init_/how-self-attention-with-relative-position-representations-works-28173b8c245a

^Character-Level Language Modeling with Deeper Self-Attention https://arxiv.org/abs/1808.04444

^Google AI Blog https://ai.googleblog.com/2019/01/transformer-xl-unleashing-potential-of.html

推荐阅读

世界读书日,我来凑个单,推荐几本NLP/推荐算法/广告系统/其他相关的新书

百度PaddleHub NLP模型全面升级,推理性能提升50%以上

斯坦福大学NLP组Python深度学习自然语言处理工具Stanza试用

数学之美中盛赞的 Michael Collins 教授,他的NLP课程要不要收藏?

From Word Embeddings To Document Distances 阅读笔记

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

可解释性论文阅读笔记1-Tree Regularization

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

中用于计算键向量的绝对位置编码

中用于计算键向量的绝对位置编码  替换为相对位置编码

替换为相对位置编码  来代替

来代替  中原来的

中原来的  ,这使得所有查询位置 i 的查询向量都是相同的,所以不管查询位置是什么,对不同单词的注意偏差都是相同的。类似的,引入

,这使得所有查询位置 i 的查询向量都是相同的,所以不管查询位置是什么,对不同单词的注意偏差都是相同的。类似的,引入  来代替

来代替  中的

中的  分为两个权重矩阵

分为两个权重矩阵  ,分别生成基于内容的和基于位置的键向量。

,分别生成基于内容的和基于位置的键向量。