火爆的Transformer,可能是目前最好发论文的神器!

前段时间 Transformer已席卷计算机视觉领域,并获得大量好评,如『基于Swin-Transformer』、『美团提出具有「位置编码」的Transformer,性能优于ViT和DeiT』、『Lifting Transformer』、『TimeSformer』等等

Transformer为什么这么有实力?

因为它在分类、检测等任务上展现了极其强劲的性能。而且骨干网络上的发展也推动了下游任务的发展,Swin Transformer 更是成了屠榜般的存在,在工业界具有广阔的应用前景。所以引起了人工智能研究生的强烈兴趣。

另一方面,近小半年,Transformer+CV的论文就已经有40多篇。学术研究更新之快,与脱发速度成正比。Transformer 作为最近热起来的方向,卷起来了但是又不是那么卷,在这个方向可探索的空间还很大,获得一个好的idea,写出一篇好论文的概率相对就大得多。

毕竟能发论文没有谁会拒绝……

那么剩下的问题就是,怎么发(水)论文?

想要快速发论文有两点至关重要。

1.紧跟风口。

想发文章最容易的方法就是紧跟风口,顺着领域内的研究趋势确定自己的方向,毕竟在热门领域内,创新点和idea远比其他非热门领域多。

2.有一位有经验有能力的前辈指导。

大家都在努力的设计新网络、新策略、新training算法,只要能够在某一问题上做到一个很好的performance,论文就水到渠成。

而想要快速达到,来自前辈的指点不可或缺。

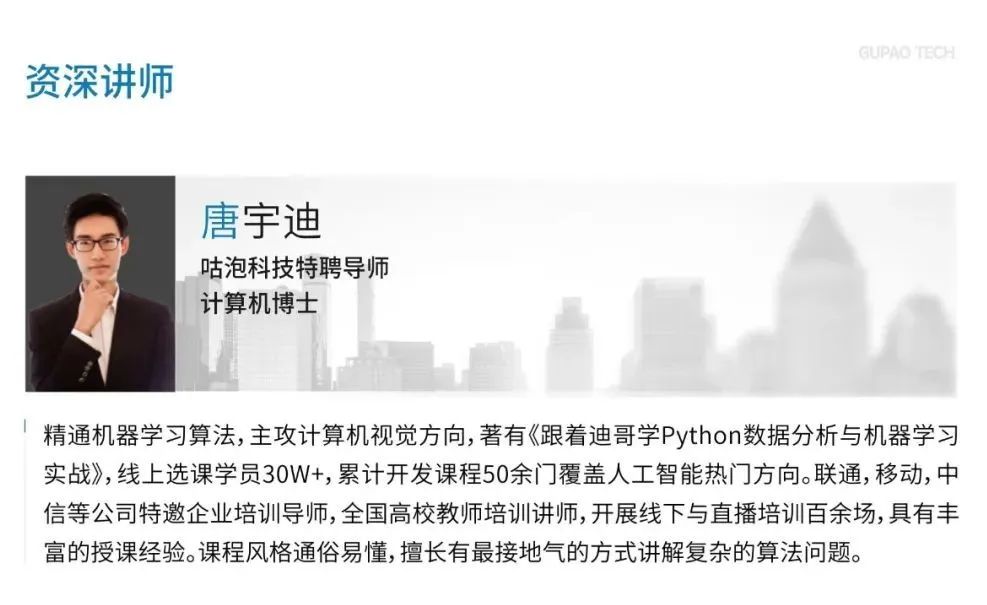

咕泡科技特别邀请、唐宇迪老师,通过讲解transformer最新前沿论文,全方位解读transformer发展应用、可创新方向。

扫描下方二维码

报名学习课程

获得完整版学习规划和课后福利

请大家务必根据页面提示,添加老师后才能领取课程和完课资料哦!

-

神经网络模型知识点分析

-

神经网络模型整体架构解读

-

卷积神经网络整体架构及参数设计

Day2:AI领域最火模块Transformer实例解读

-

2022AI领域大杀器--Transformer架构思想分析 -

论文刷点创新必备模块--注意力机制解读 -

2022各大厂项目如何与Transformer结合与落地 -

Transformer前沿研究方向分析与探索

这次课程尤其适合对AI有一定了解,但是没有明确选题目标;或者已经明确自己选题,但是找不到改进方向的同学;当然也适合对transformer感兴趣的从业者。

创新点和idea不可能凭空生成,好的performance 也绝不可能一蹴而就。

所以,如果你对自己的选题和研究方向还有疑问,这节课你一定不能错过。唐宇迪老师,一定能给出你专业的意见和指导。

扫描下方二维码

报名学习课程

获得完整版学习规划和课后福利

请大家务必根据页面提示,添加老师后才能领取课程和完课资料哦!

讲师带练,伴随式编程环境

同时还有@唐宇迪老师将会分享 , 一线热门技术和行业经验,众多学员亲测有效的一套技术提升方案,帮你摆脱迷茫,明确成长方向!

三位一体跟踪服务,项目实战驱动 , 深刻理解原理

扫描下方二维码

报名学习课程

获得完整版学习规划和课后福利

咕泡科技 ~ 让每个人的职业生涯不留遗憾

Q&A