【泡泡一分钟】在具有挑战性的HDR环境下基于学习图像增强的视觉里程计

每天一分钟,带你读遍机器人顶级会议文章

标题:Learning-based Image Enhancement for Visual Odometry in Challenging HDR Environments

作者:Ruben Gomez-Ojeda Zichao Zhang Javier Gonzalez-Jimenez Davide Scaramuzza

来源:IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS),2018

编译:王丹

审核:颜青松,陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

视觉里程计(VO)的主要问题之一是在不好照明条件或高动态范围(HDR)环境下的鲁棒性较低。这些问题的主要原因来自传感器的局限性和由于VO中的前提假设(例如亮度恒定不变),从而导致无法成功跟踪兴趣点。本文从深度学习的角度解决了这个问题,我们首先对深度神经网络进行微调,目的是获得VO影像序列的图像增强参数。然后,演示了长短期记忆的插入如何允许我们获得时间上一致的序列,因为估计取决于先前的状态。由于使用非常深的网络增加了VO框架的计算负担,因此我们还提出了一种尺寸减小的卷积神经网络,能够更快地执行。最后,我们通过评估两种体系结构在几种最先进的VO算法(如ORB-SLAM和DSO)中生成的序列来验证增强的表示。

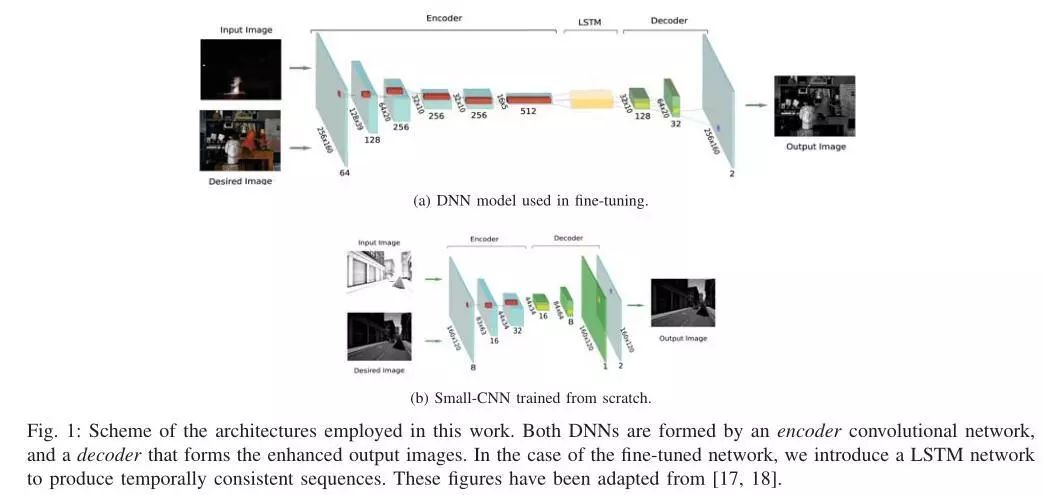

图1.本工作中使用的架构方案。两个DNN都由编码器卷积网络和形成增强输出图像的解码器形成。在微调网络的情况下,我们引入LSTM网络来产生时间上一致的序列。

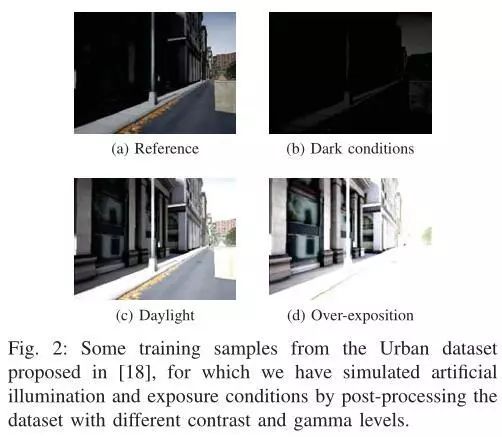

图2.来自[18]提出的Urban数据集的一些训练样本,使用不同对比度和伽马水平对数据集进行处理来模拟人工照明和曝光条件

本文主要进行了如下改进:

提出了两种不同的深度网络:一种由CNN和LSTM组成的非常深的模型,另一种是针对要求较低的应用而设计的小型网络。两个网络都将一系列RGB图像转换为信息更丰富的图像,同时对于照明,曝光时间,伽马校正等的变化也很稳健。

提出了一种多步骤训练策略,采用来自合成数据集的下采样图像,这些图像通过一组变换进行增强,以模拟不同的照明条件和相机参数。因此,我们的DNN能够将训练的行为推广到HDR场景中或在困难的照明条件下的全分辨率真实序列。

展示了如何通过合并来自先前帧的时间信息,添加长短期记忆(LSTM)层有助于在HDR序列中产生更稳定且噪声更小的结果。然而,这些层增加了计算负担。

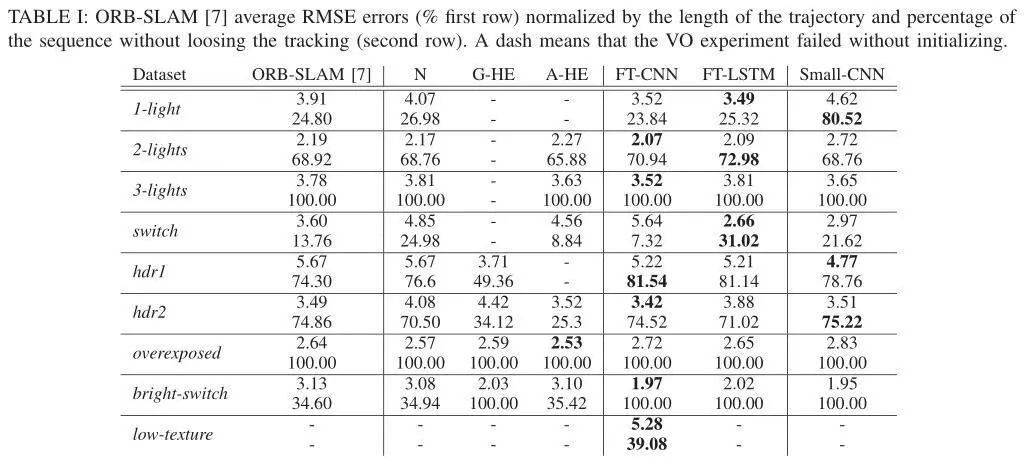

表1.通过轨迹长度进行归一化的ORB-SLAM 平均RMSE误差(%第一行)和序列未丢失跟踪的百分比(第二行)。短划线表示VO实验在初始化失败的情况

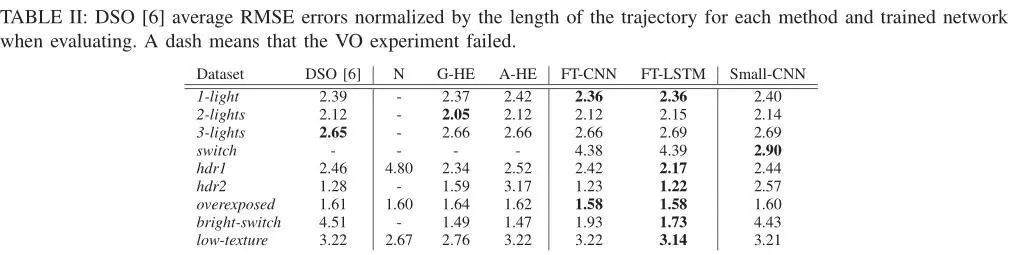

表2.通过每种方法和训练网络在评估时的轨迹长度归一化的DSO [6]平均RMSE误差。短划线表示VO实验失败

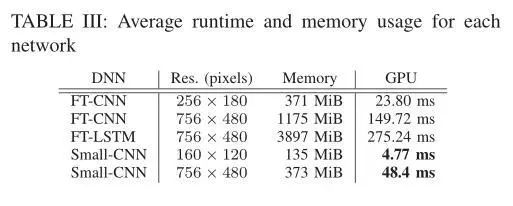

表3.每个网络的平均运行时和内存使用量

Abstract

One of the main open challenges in visual odometry (VO) is the robustness to difficult illumination conditions or high dynamic range (HDR) environments. The main difficulties in these situations come from both the limitations of the sensors and the inability to perform a successful tracking of interest points because of the bold assumptions in VO, such as brightness constancy. We address this problem from a deep learning perspective, for which we first fine-tune a deep neural network with the purpose of obtaining enhanced representations of the sequences for VO. Then, we demonstrate how the insertion of long short term memory allows us to obtain temporally consistent sequences, as the estimation depends on previous states. However, the use of very deep networks enlarges the computational burden of the VO framework; therefore, we also propose a convolutional neural network of reduced size capable of performing faster. Finally, we validate the enhanced representations by evaluating the sequences produced by the two architectures in several state-of-art VO algorithms, such as ORB-SLAM and DSO.

如果你对本文感兴趣,请点击点击阅读原文下载完整文章,如想查看更多文章请关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

百度网盘提取码:jn7l

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com