【泡泡一分钟】具有深度特征梯度的自适应跟踪学习策略(ICCV2017-12)

每天一分钟,带你读遍机器人顶级会议文章

标题:Learning Policies for Adaptive Tracking with Deep Feature Cascades

作者:Chen Huang, Simon Lucey, Deva Ramanan

来源:International Conference on Computer Vision (ICCV 2017)

播音员:格子

编译:Fei 周平

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

视觉目标跟踪是一个基本的以及处理时间要求紧要的视觉任务。近年来出现了许多基于实时像素相关滤波器CPU支持的浅层跟踪方法, 以及具有顶级性能但需要高端 GPU 支持的深层方法。

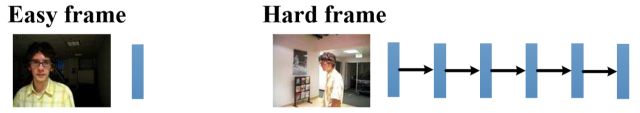

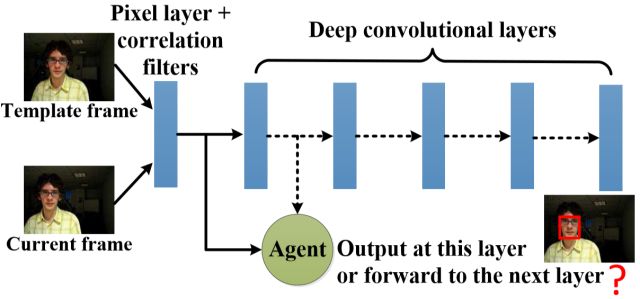

本文的目标是在不丢失精度的情况下, 提高深度跟踪器的速度。我们基本的想法是采取一种自适应的方式, 使用低成本的特征 (如像素值) 处理简单帧, 而具有挑战性的帧,则用不变的但代价很高的深层特性来处理。我们将自适应跟踪问题看成一个决策过程, 并让一个智能体来决定是在早期时将其定位成高度自信可处理的对象, 还是让其进入网络的后续层进行处理。这极大程度上降低了那些具有明显对象或者缓慢移动目标的简单帧的前馈成本。我们以强化学习的方式线下训练智能体, 并进一步证明学习所有深层 (以便提供良好的特征给自适应跟踪功能) 可以实现在一个单一的CPU上达到接近实时平均跟踪速度 23 fps(每秒帧数),同时达到极好的效果。 我们的方法在50% 的时间内都提供了100倍的加速, 展现出了这种自适应方法巨大的潜力。

图1 简单帧与复杂帧

图2 决策过程

·决策过程有多次判断,进而可以减少简单帧的前馈时间

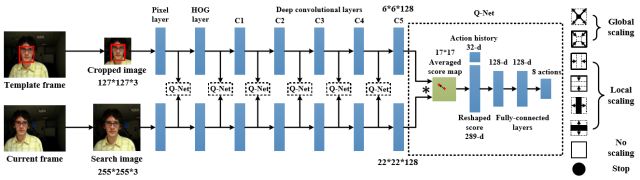

图3 策略学习原理框架

·SiamFC 网络结构:在每一层——获取实例相应的分数,然后将其反馈给Q-net,以做出判断

·定义最先两层为像素值和HOG特征——使用快速相关滤波器(FFT)来计算它们的得分

·决策的强化学习

- 动作:7个判断尺度转换和1个停止动作

- 状态:得分映射记录和行为记录

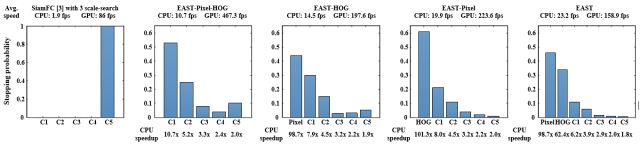

图4 基于OTB-50数据集的实验结果

·横坐标为不同的特征层决策,纵坐标为在此特征层判断停止的概率。对于5个具有不同特征梯度的模型, 我们显示 CPU和 GPU (顶部)的平均速度, 以及每个层 (底部) 的基线 SiamFC (1.9 fps) 的 CPU 加速率。

·SiamFC 在多尺度图像上搜索以处理缩放变化, 而我们在一个前向传递中预测尺度, 从而得到恒定的跟踪加速。我们的早期判断停止策略进一步加速跟踪 (4.5倍), 通过自适应地使用早期层, 而 SiamFC 总是使用最后一层 C5。当早期的层是成本较低的HOG层或像素层,且具有快速的 CPU (270 + fps), 我们能使平均 CPU 速度提高一个数量级,并且在接近50%的时间里,可以是CPU的速度提高大约100倍。另一方面, 人们发现对 CPU 计算的依赖度通常会增加 CPU 的速度, 但也会在一定程度上丢失 GPU 的速度增益。

Abstract

Visual object tracking is a fundamental and time-critical vision task. Recent years have seen many shallow tracking methods based on real-time pixel-based correlation filters, as well as deep methods that have top performance but need a high-end GPU. In this paper, we learn to improve the speed of deep trackers without losing accuracy. Our fundamental insight is to take an adaptive approach, where easy frames are processed with cheap features (such as pixel values), while challenging frames are processed with invariant but expensive deep features. We formulate the adaptive tracking problem as a decision-making process, and learn an agent to decide whether to locate objects with high confidence on an early layer, or continue processing subsequent layers of a network. This significantly reduces the feedforward cost for easy frames with distinct or slow-moving objects. We train the agent offline in a reinforcement learning fashion, and further demonstrate that learning all deep layers (so as to provide good features for adaptive tracking) can lead to near real-time average tracking speed of 23 fps on a single CPU while achieving state-of-the-art performance. Perhaps most tellingly, our approach provides a 100X speedup for almost 50% of the time, indicating the power of an adaptive approach.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

百度网盘链接:https://pan.baidu.com/s/1ht610pQ

密码:39vg

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com