梯度下降引发AI大牛们“激辩”,网友:每个人的答案都值得一看

丰色 发自 凹非寺

量子位 | 公众号 QbitAI

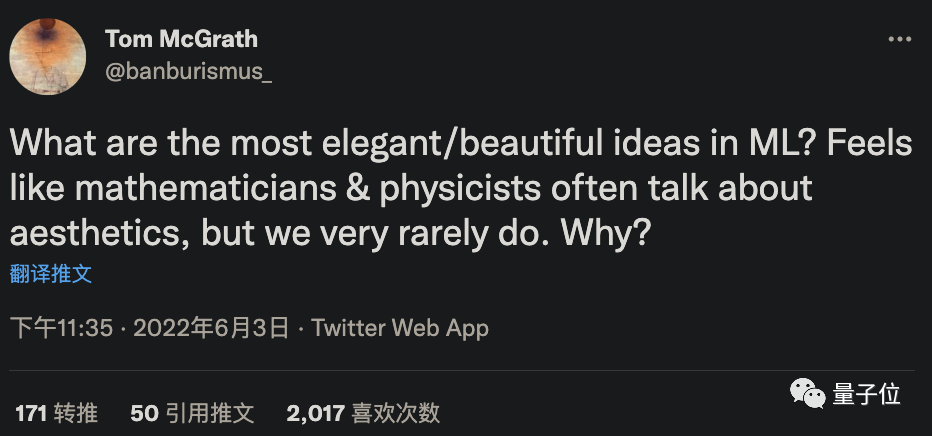

最近,DeepMind的一位AI研究员在推特上抛出了一个问题:

机器学习中最美/最优雅的点子是什么?

之所以会有这样的疑问,是因为他发现数学家和物理学家们就经常谈论美学,机器学习领域却很少这样,也很好奇为什么。

很快,大家就给出了自己的答案。

但其中的一条回复却引发了很大的讨论,连LeCun等大佬都忍不住参与进来了。

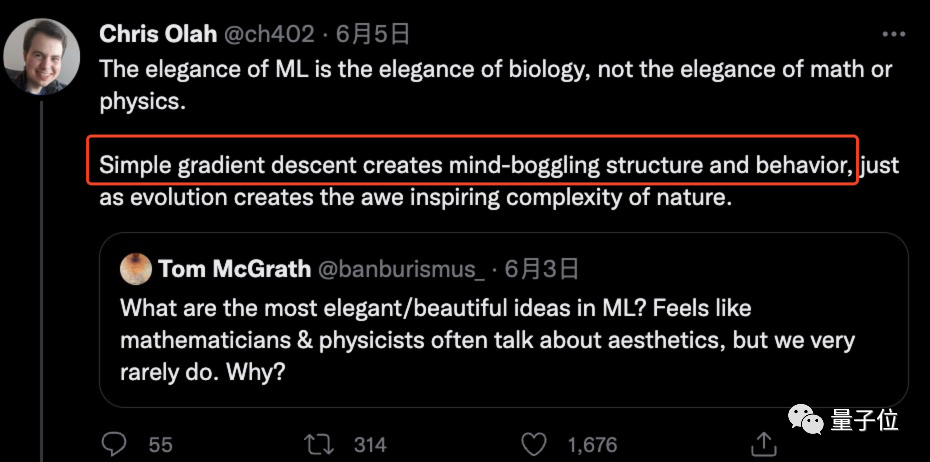

这个答案就是来自前谷歌大脑的研究员Chris Olah所提出的“梯度下降法最美论”。

那么这到底是怎么一回事呢?

“梯度下降是机器学习中最优雅的idea”

所谓梯度下降法,就是一种寻找目标函数最小化的方法,它利用梯度信息,经过不断迭代调整参数来寻找合适的目标值。

这一思想更形象地解释就是下山。

假设当你站在山上时雾很大,想尽快下山的你却无法看清下山路线,那么就只能利用周围的环境信息走一步算一步,也就是以当前位置为准,找到最陡峭的地方往下走。重复这个计算过程,就能达到山谷。

我们在求解机器学习算法的模型参数时,为了让所得模型可以更好地捕捉到数据中蕴含的规律,进行更准确地预测,一般会最小化损失函数得到参数估计值。

梯度下降法就是此时最常用的优化算法,而且它对于复杂模型也很适用。

认为梯度下降法是机器学习中最优雅理论的Chris Olah,一直致力于对人工神经网络进行逆向工程的工作,曾先后就职于OpenAI和谷歌大脑,现在是一家主攻大型模型安全性的初创公司的联合创始人。

他给出这一答案的理由是:

简单的梯度下降就可以创造出令人惊叹的结构和性能。

这一回复得到了近1700人的点赞支持。

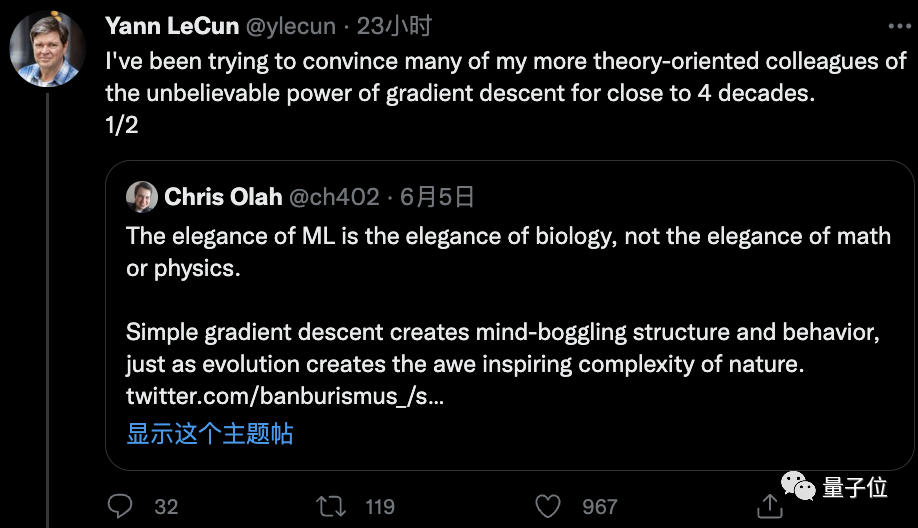

就连LeCun都转发起来,称自己四十年来都在说服身边搞理论的同事相信梯度下降法拥有多么不可思议的力量。

彷佛一下子找到“知音”的LeCun话匣子打开,分享了自己20多年前的一桩趣事。

他说,在2000年举办的NeurIPS会议晚宴中,一位非常杰出的ML科学家就提出一个类似问题:

“我们在机器学习中学到的最重要的东西是什么?”

当时他就回答“梯度下降”。

谁知这位前辈听完却一脸匪夷所思,那神情显得“自己”这一答案好像特别蠢一样……

△ 或许就像这样吧

然而,事实证明,LeCun说的完全没错。

他还举证称,“我的一位朋友用3行随机梯度下降法就可以替代复杂的传统方法解决凸问题(SVM、CRF)”。

有理有据,这位朋友(Léon Bottou)的博客链接也被甩出来了。

总的来说,关于“梯度下降法最优雅理论”这一观点,大家基本没有什么异议。

真正引起讨论的还是Chris Olah小哥那句“机器学习的美是生物学之美,而不是数学或者物理学之美”。

插曲:机器学习之美是生物学之美?

小哥解释说,自己一开始也认为机器学习的美体现在复杂的数学和巧妙的证明上,但后来才渐渐发现不是这样的,他给出了以下理由和具体例子来支撑他的观点。

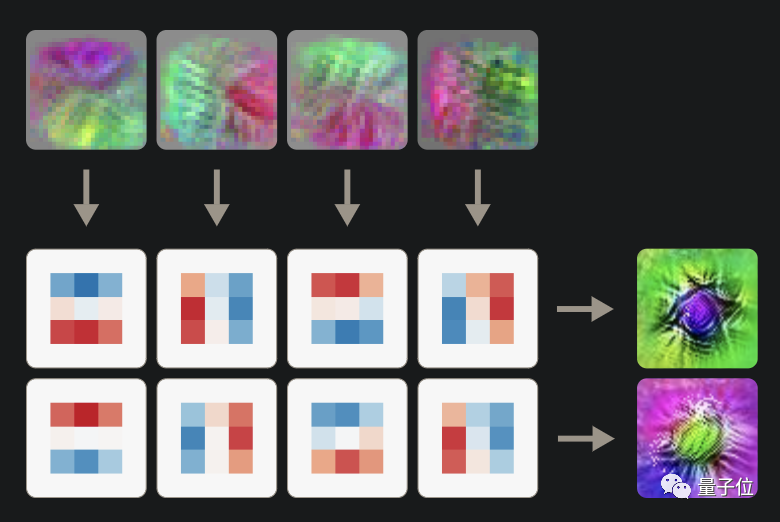

首先在他看来,机器学习中的很多理论应用到神经网络中都可以“发现”非常漂亮的图像,比如用梯度下降得到的分组卷积图。

“看起来很像一些早期生物有没有?”

小哥惊呼自己从中感受到了自然科学家感受过的美,因此觉得机器学习的美也是生物学的美。

除此之外,他还觉得:

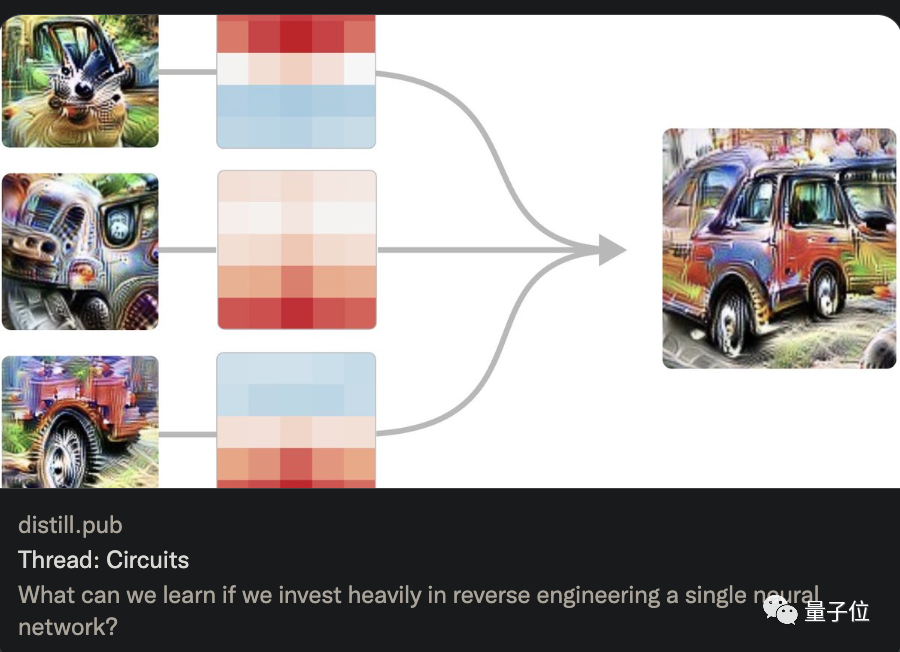

训练大模型就像是到一个偏远的岛屿去观察那里的生物。

因此“每个模型的结构都有着自己的魅力世界,等待我们去观察和发现”。

(就是说,怎么突然升华起来了。)

顺理成章,他将梯度下降法比作生物学中的进化,认为它们都是通过简单的过程就能产生具有高度复杂性的东西。

而且他思来想去,觉得还是生物学是用来类比的最佳范例,因此机器学习也可以从其中获得启发。

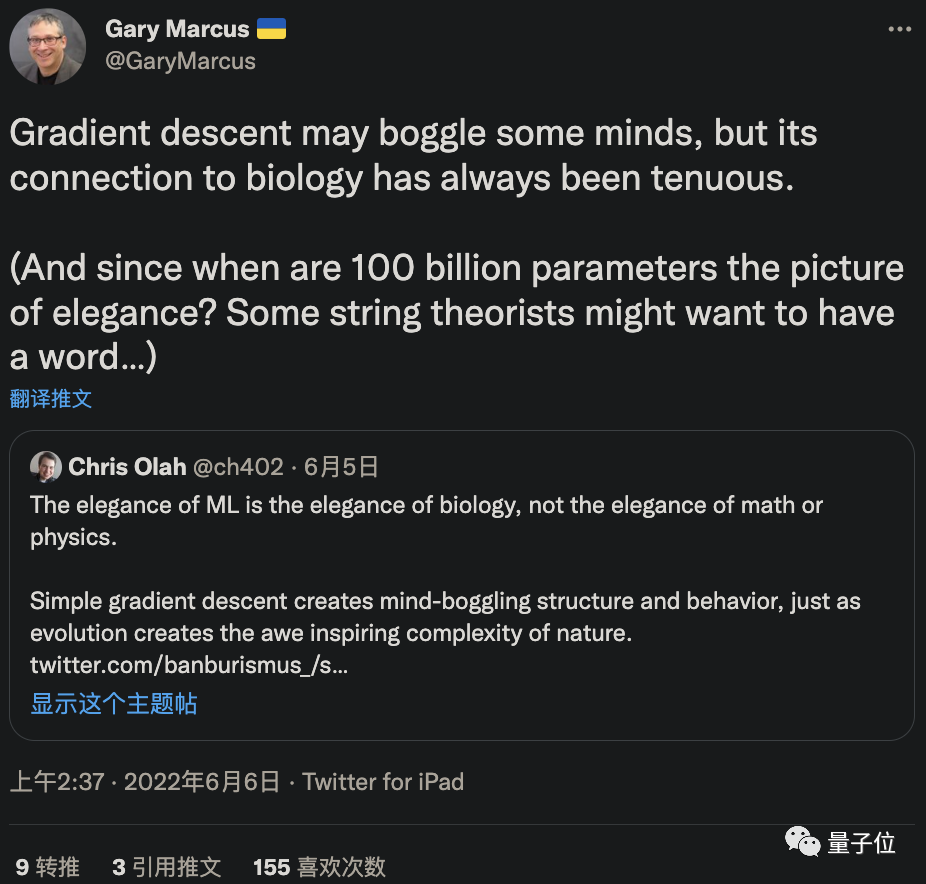

小哥这些言论一出,每一条都收到了几十到上百的点赞,但更多的人表示有点匪夷所思,不敢苟同。其中就包括大名鼎鼎的“嘴炮”马库斯。

他很直白地表示,你说梯度下降很牛没错,但它和生物学基本没什么联系吧。

与此同时也有网友反驳道,就拿反向传播机制来说,我们的大脑根本都不存在这个东西,怎么能说机器学习和生物学很像呢?

“我觉得梯度下降还是一个数学问题,和进化无关;并且我还得说一句,数学之美远超进化和生物学之美,更别提梯度下降比进化聪明了几个数量级呢。”有人进一步回怼。

反对声是七嘴八舌……

小哥眼看情况愈演愈烈,楼越堆越高,按耐不住,出来解释了。

他称,自己这个类比确实不完美,可能也存在表述不准确的原因。但无论如何,这些结论都不涉及解释人工神经网络的生物学合理性。除此之外,一切都是他的直觉感受,大家随意接受和反驳就好。

好吧,这就是一个开放问题,经不经得起推敲还很难说。

只得说他提出来的梯度学习最优雅确实目前点赞次数最多的一个答案。

那么,我们还是回到问题本身,看看除了梯度下降,还有什么机器学习理论被大家奉为“至美”吧。

还有哪些idea很优雅?

一位即将进入华盛顿大学读博士的学生认为是“高斯过程“(Gaussian Process, GP),对他来说,这是构建模型过程中最精粹的“精髓”。

一位就职于Zoom的AI从业者表示,深度学习的框架和系统中有太多优雅的东西了:

往低了说,GPU加速操作算一个;

往高了说,可微分编程/Pytorch的自动求导(autograd)/反向传播都可以算这个范围内;

来自Yoshua Bengio的MILA实验室的一位研究员则表示,当然是机器学习中的扩展定律(scaling laws)了,“那种简单到惊掉人下巴的美!”

一位拥有博士学位的网友:“我也觉得答案太多了,硬要我说,我选激活函数和ConNet架构。因为它们归根结底和矩阵和微积分很像。”

还有人的答案是:置信传播算法(belief propagation)、流形学习(manifold learning)、bottleneckz自动编码器、神经网络中的不变性和等变性编码等等。

当然,简单又通用的Transformer也必须得有一票。

这里就不一一列举了。

不过,也有人认为机器学习根本谈不上什么优不优雅。

“毕竟在得到最终结果之前,你得经历各种报错和bug的折磨。要我说,我还是觉得物理学中的诺特定理是最优雅的东西。”

所以,这就是我们很少谈论机器学习之美的原因吗?

也不止如此,有人就表示:

即使机器学习到了2022年,你也不能在没法确保能达到一个有趣结果的情况下就随意“鼓捣”宝贵的GPU,这样的话,谁还在乎机器学习到底优不优雅呢?

emmm,似乎真相了……

不过总而言之,不少人都表示DeepMind研究员提出的这个问题非常好,大家的评论也都很有意思,值得一读。

最后,你觉得机器学习中存在美的东西吗?

如果有,你pick哪一个呢?

参考链接:

[1]https://twitter.com/ch402/status/1533164918886703104

[2]https://twitter.com/ylecun/status/1533451405167669249?s=21&t=D9isbiwEfnEJPFg_SROYng

[3]https://twitter.com/GaryMarcus/status/1533518358968008704

— 完 —

「人工智能」、「智能汽车」微信社群邀你加入!

欢迎关注人工智能、智能汽车的小伙伴们加入我们,与AI从业者交流、切磋,不错过最新行业发展&技术进展。

ps.加好友请务必备注您的姓名-公司-职位哦~

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见~