别再双塔了!谷歌提出DSI索引,检索效果吊打双塔,零样本超BM25!

卖萌屋今日学术精选

这篇论文展示了信息检索可以用一个Transformer来完成,其中,关于语料库的所有信息都被编码在Transformer模型的参数中。

论文标题:

Transformer Memory as a Differentiable Search Index

链接:

https://arxiv.org/abs/2202.06991

作者提出了可微搜索索引(Differentiable Search Index,DSI)的概念,这是一种新的搜索范式,它可以学习出一个Query-to-DocID的文本检索模型,将用户Query直接映射到相关的DocID节点上;换句话说,DSI模型直接使用其模型参数来回答用户查询,极大地简化了整个检索过程。

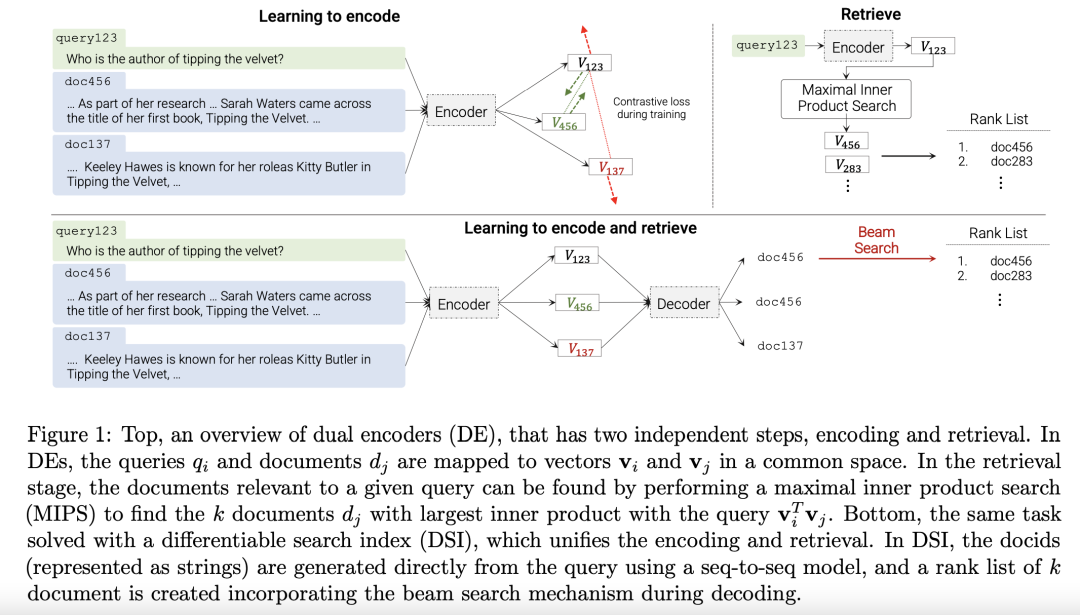

上图展示了经典的双塔模型(Dual Encoder)+最大内积检索(MIPS)的经典检索范式,与本文提出的可微搜索索引(DSI)的范式的区别。后者统一了模型的训练与检索。

实验结果

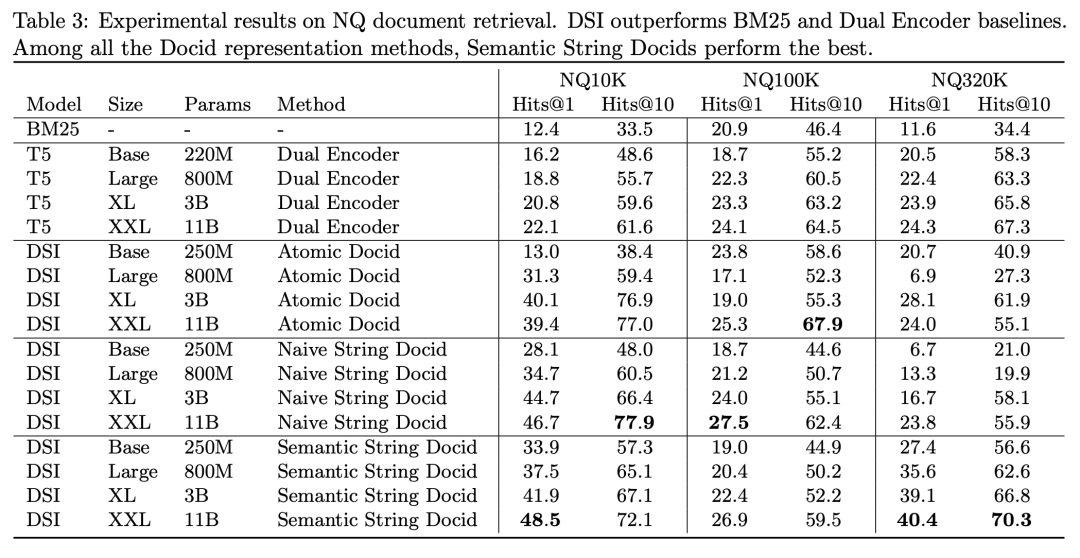

首先作者在不同规模的NQ数据集上,检验了DSI模型的supervised learning能力。

从上表可以看到,DSI模型经过finetune之后,强势吊打了BM25基线和同样finetune之后的T5模型。

此外,作者还在NQ数据集上检验了DSI模型的zero-shot能力。

众所周知,BM25是zero shot方面非常高的一个基线,从上表可以看出,DSI的zero shot能力也显著优于BM25。

实验表明,给定适当的设计选择,DSI不仅显著优于双塔模型为代表的强基线模型,此外,DSI展示了很强的泛化能力,在zero-shot实验中显著优于BM25基线。

加入卖萌屋NLP/IR/Rec与求职讨论群

后台回复关键词【顶会】

获取ACL、CIKM等各大顶会论文集!