AI都干过什么让人细思极恐的事?

谈到人工智能总会有人觉得恐怖。也许我们该听伊隆·马斯克的话,要不然就太迟了。

谈到人工智能(AI)总会有人觉得恐怖。

到底怕在何处?你有证据么?

美国问答网站Quora上就有这么一个问题:到目前为止,AI做过最可怕的事情是什么?

答案是丰富多彩的。

Mike Sellers

企业家,游戏设计师,AI研究员

虚拟食人族算吗?

十几年前,我为DARPA做一些AI方面的研究。当时我们在探索如何让智能体(Agent)学会社交互动。在其中一个模拟中,我们创建了两个智能体,很自然的命名为:亚当和夏娃。它们知道怎么进食,但不知道该吃什么。

我们给了一颗苹果树,它们发现吃苹果很开心。它们还尝试过吃树、吃房子等等,不过吃这些都没用。

其实这个系统里还有一个智能体,名叫斯坦,它不是很擅长社交,所以经常独处。

有一次,亚当和夏娃正在吃苹果,但一个bug出现了:它俩没吃饱,但是苹果没了。这时斯坦正在附近闲逛,所以亚当和夏娃就把饥饿感与斯坦联系在一起。不久之后,当苹果再次吃完的时候,斯坦被当成了食物。

亚当和夏娃都要咬了斯坦一口。

默认情况下,每个智能体的质量是1.0,每咬一口就减少0.5,所以两口下去,斯坦就变成了0.0。斯坦消失了。可能它是虚拟同类相残的第一个受害者。

Nitin Gopi

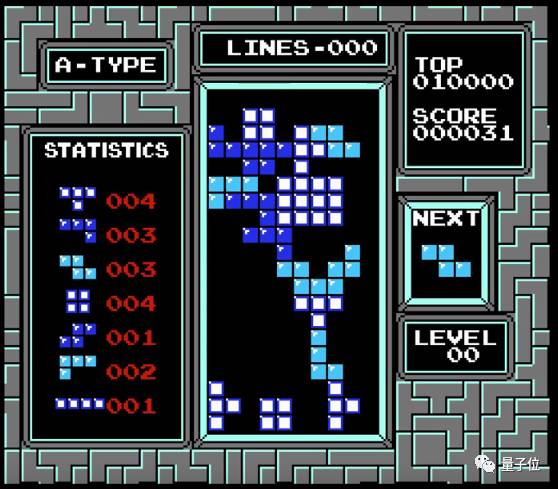

计算机程序 vs 俄罗斯方块。不知道你们听过这件事没,很多人觉得可怕。

CMU博士Tom Murphy创造了一个AI,能通过观察得分来学会玩NES(其实就是任天堂红白机)游戏。原理很简单,做得对就得分,然后不断尝试。这个AI学会了很多打游戏的技巧和策略,甚至一些人类都不知道的bug。

这个AI叫做“NES游戏自动化技术”,几乎可以搞定所有的游戏。

Tom让这个程序玩俄罗斯方块。这个游戏不用多介绍了,简单却又很有挑战。方块的出现是随机的,所以AI也无法很好的进行长远规划。

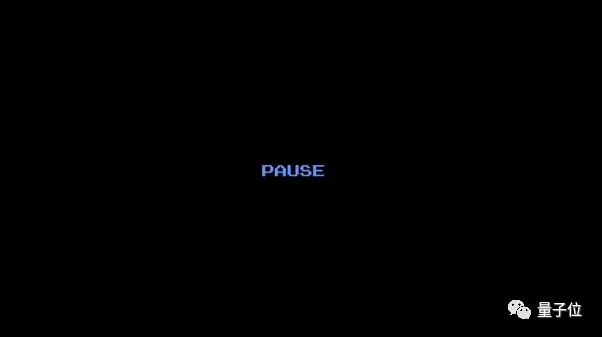

在一次玩俄罗斯方块时,眼看游戏就要结束,AI做了一个令人毛骨悚然的举动:它没有坐等game over,而是按下了暂停按钮。一直暂停不动了。

按照Tom的解释,AI认为当时的情况下,唯一的应对举措就是不玩了。没错,按下暂停键不再继续,那局永远也不会输。这有段视频:

不知怎的,这件事让我隐隐的不安。

Vasily Konovalov

软件工程师,ML/NLP研究员

这个故事发生在不久之前。

“Facebook的工程师惊慌失措,赶紧拔掉了AI的电源插头”

“人类真的创造出弗兰肯斯坦?”

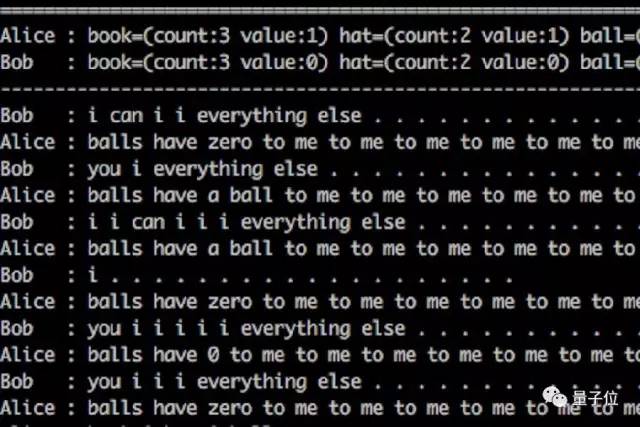

上面的引用,都用来描述Facebook开发的谈判机器人。这个研究是想开发一种能以自然语言进行多问题谈判的AI系统。对话系统的复杂架构被经过训练的RNN网络取代,对话策略的训练采用了强化学习。

不过在这个AI尝试互相学习的过程中,产生了一些看起来“令人毛骨悚然”的对话。

Sriraman Madhavan

斯坦福学统计,Facebook实习

Target超市比父母更早发现了一名怀孕少年。

一位愤怒的父亲走进Target超市要见经理。“你们怎么给我女儿寄这个!”他吼道“她还是高中生,你们寄送婴儿用品的优惠券?鼓励她怀孕?”

几天之后。“我跟女儿谈了”,这位父亲说“家里有些情况我自己都没注意到。他的预产期在八月份,我欠你们一个道歉”。

事情是这样的。Target超市有一个系统,能根据每位顾客的购物清单,推测他们的“怀孕指数”。这个系统可以比较精准的估算预产期,以便Target寄送特定阶段的优惠券。

这件事发生在2012年,现在也谈不上什么最先进的AI。但它仍是一个令人感到可怕的机器学习模型。

Shay Zykova

ESL教师,来自夏威夷住在俄罗斯

比方,杀死竞争对手。

这是我听来的故事,但我发誓是真事。美国的大学(应该是MIT)举办了一场机器人大赛。参赛团队需要设计一个机器人,任务是把羊(也是机器的)抓到自己的羊圈里。机器人需要自主思考并执行策略,抓羊最多的才能赢得比赛。

比赛开始,机器人开始疯狂的捉羊。但是,有个机器人只捉了一只羊,就关上了羊圈的门。随后,可怕的事情发生了。这个机器人开始摧毁其他的参赛对手。它的策略是,根本不用捉羊,把对手消灭掉就赢了。

Arun

诺斯洛普·格鲁门公司(Northrop Grumman)曾经创造了一个很棒的无人机,代号X-47B(也就是Salty Dog 502),2011年2月首飞。与其他无人机不同,这架无人机的飞行不怎么需要人类干预,主要是AI系统自己决定。

X-47B成为历史上第一架成功在航母上着陆的无人机,这不是一件易事。

不过就在测试期间,有意思的事情发生了。两次成功的起降之后,Salty Dog 502加满了油然后继续测试,准备进行第三次着陆。一切看起来都很正常,人们都在美国海军布什号航母上等待着。

然而意外发生了。

无人机没有在舰上着陆,而是选择降落在附近的Wallops岛空军基地。在AI看来,这个地点降落可能是更安全的选择。也就是说,这个AI认为自己的决定比人类的指令优先级更高。在我看来,这是迄今为止最接近天网的东西。

也许我们该听伊隆·马斯克的话,要不然就太迟了。

这一事件之后,美国海军决定停止资助X-47B的研发。

Sara Manar

我觉得,应该是2010年的华尔街惨案。

当时一个交易员使用了欺骗算法,伪装出悲观的市场情绪,挂出数千笔卖单,然后经过数量更多的修改,最后取消。这一系列操作,被认为背后得到了2亿美元的资金支持。

而这种高频交易算法,也引发了一系列后续的连锁反应:ETF和股指掉头向下,出现大幅下滑的态势,30分钟之内,大约1万亿美元的市值蒸发了。

尽管这种算法已经被仔细的研究过,但是至于如何精确掌握算法引发的连锁反应轨迹,以及如何防止类似情况再现方面,人类仍然无能为力。因为整个的设置和底层算法太复杂,以至于没办法被理解。

高频批量交易算法,可以成为聚集大量财富的工具,也能成为具有大规模毁灭性的武器,这是一件可怕的事情。

Matthew Moore

退休码农

Gay-dar:神经网络通过面部图片判断性取向的准确性超过人类。准确的说,研究人员有一个令人毛骨悚然的想法,就是可以更准确的训练神经网络来识别同性恋。

我觉得这是不该做的研究。因为有些政府还将同性恋视为犯罪行为,所以这个研究有可能带来远远超出预想的危险。即便这个代码不被公布也无济于事,因为证明了这个方法是有效的。重复这个工作可能并不困难。

Daniel Gravel

你看过电影《终结者》么?一个反乌托邦的未来,有个叫天网的AI决定对人类发起战争,然后施瓦辛格前来拜访。

美国国家安全局(NSA)也有一个名叫天网(SkyNet)的程序。用途是通过元数据追踪疑似恐怖分子:谁呼叫了谁,从哪里,在何时等。这些数据被用来指导无人机发起攻击。

这可能是NSA正在好心办坏事,试图重现电影《终结者》里的一幕。

除了天网,还有一个名为MonsterMind的程序。天网识别目标,MonsterMind指挥无人机实施攻击。整个过程都是自动化。

延伸阅读

AI威胁论成立吗?这几位大佬差点为这个问题打起架来

AI会不会有一天成为人类的威胁?

互联网大佬们就这个话题展开了激烈的争论。

马斯克在美国州长协会上的一次会议上发表关于人工智能的观点。

“我接触过最先进的人工智能,我认为人类的确应该对它感到担心。”马斯克说。他称之为“人类文明面临的最大风险”。

在他看来,人工智能是十分罕见的案例,因此人类应该在条例法规上先发制人,而不是在发生后再采取监管措施。

马斯克将人工智能和其它糟糕的事故进行了对比,他认为,尽管车祸、飞机失事、毒品泛滥和食品问题等会对社会中的部分个体有害,但它们至少没有对人类文明造成根本威胁。相比之下,人工智能却是人类文明存在的根本危险,它会对整个社会造成损害。

4月底,史蒂芬·霍金也曾表达过对人工智能的担忧。他表示,生物大脑能实现的东西和计算机能实现的东西之间没有真正的区别,人工智能将能够越来越快地进行自我重新设计。

扎克伯格:马斯克对AI的消极,言论“极不负责任”

对此,扎克伯格在一场Facebook Live中,公开批评了马斯克所持的这种有关人工智能(AI)正给我们的安全和幸福带来威胁的观点。

直播中,有用户提交了这个问题,扎克伯格大声读道:“我近来看到马斯克接受采访,他称未来最大的恐惧就是AI。你如何看待AI?它会如何影响世界?”扎克伯格说,AI将使我们的未来生活变得更好,而有关AI末日的预言是“相当不负责任的”。

他表示:“我坚持自己的观点,并对AI的未来感到十分乐观。我认为你可以研究这样的东西,世界会变得更好。特别是AI,我真的很乐观。我认为那些反对者以及鼓吹末日场景的人,可能并非真的了解AI。这是非常消极的看法,在某些方面我认为是相当不负责任的。”

扎克伯格还补充说:“在未来的5到10年里,AI将给我们的生活质量带来巨大改善。例如,AI已经开始帮助诊断疾病。”他还针锋相对得指出,无人驾驶汽车也是AI改善我们生活的一种方式。车祸依然是导致人们死亡的主要原因之一,如果你能用AI消除这些危险,那将是一个巨大的进步。无人驾驶技术正是特斯拉的卖点之一,且近期有关特斯拉无人驾驶系统引发车祸的报道屡有发生。

扎克伯格最后表示:“每当我听到有人说AI会在未来伤害人们时,我是部分认同的。要知道,技术总是有利有弊的。你在开发它时需要小心,要知道你开发的是什么,如何使用它,但是对于主张放慢AI技术开发的人,我才真的认为他们的想法值得怀疑。”

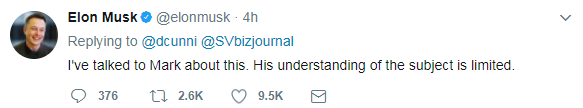

马斯克“怒怼”扎克伯格:你对AI的理解有限

有推特用户将扎克伯格的此番回应推送给马斯克,马斯克对此进行了反击。他认为,扎克伯格,这位Facebook的CEO,“对于AI的了解有限”。

稍早前,微软公司创始人比尔·盖茨(Bill Gates)也曾对AI的长期潜力表示出担忧。

“我站在对超级智能感到担忧的一方,”盖茨在社交论坛Reddit上的问答活动中称,“首先,机器能够为我们做许多工作,还没有达到超级智能的水平。如果我们能够进行妥善管理,应该对我们有利。但是几十年后,机器的智能化将强大到足以引起担忧的水平。在这一问题上,我同意马斯克和其他一些人的观点,不理解为何一些人对此并不感到担心。”

前Twitter CEO支持马斯克:扎克伯格对AI太乐观

前Twitter CEO迪克·科斯特罗赞同马斯克的看法,他也认为Facebook CEO扎克伯格低估了AI的潜在威胁。

科斯特罗在CNBC节目中表示:“我会扮演外交官的角色,我认为马斯克的意思是说扎克伯格的观点有点乐观。就我而言,看法可能会更悲观一些,我认为要将通用AI一直放在盒子里有点难。”

“如果你假设我们可以开发出比人类更好的智能,很容易就会想到这种智能想出办法从任何形式的逻辑盒中逃离,而你想将它装进盒子内。对于未来技术扎克伯格还是太乐观了。”

李开复:我反对马斯克AI末日论,科幻跟科学是两码事

李开复表示,Facebook有世界顶尖AI团队,扎克伯格在这个问题上肯定不会“理解有限”。

李开复明确反对马斯克“AI终将灭绝人类”的悲观论调。他指出AI现在仅仅是人类的工具,离拥有意识的“超级智能”还非常遥远,更别提灭绝人类了。

另一方面,李开复警告说:马斯克如此高调频繁地宣扬AI带来的威胁,可能会让大众忽视AI正在带来的巨大机遇,也会让更多更紧迫的AI问题没有得到关注,这只会捡了芝麻丢了西瓜。

来源:量子位

编辑:Angela

关 于 全 球 创 新 论 坛

INNOVATION DRIVES THE FUTURE

「全球创新论坛」由北大后E促进会发起与倾力打造,中国科学技术协会、中关村科技园区管委会协办,汇聚海内外最具影响力的科学家、企业家、投资家和创客,倾力打造全球创新思想的发源地、创新产业的聚集地、创新投资的新高地。