图神经网络再拿顶会最佳论文! KDD22 FederatedScope-GNN

转载机器之心

8 月 18 日,全球数据挖掘领域顶级会议 KDD 2022 大奖公布,阿里巴巴达摩院团队斩获应用科学方向“最佳论文奖”,这是中国企业首次获得该重磅奖项。

KDD会议分为研究和应用科学两个方向,本年度共收到2448篇投稿,仅接受449篇。包括阿里巴巴、华为、腾讯、百度等多家中国科技企业均有论文被收录,其中阿里巴巴今年共34篇论文入选,是全球入选论文数量最多的企业之一,同时阿里巴巴独立获得了大会应用科学方向唯一的“最佳论文奖”。历年荣摘桂冠的包括来自谷歌、亚马逊、卡内基梅隆大学等海外知名机构的研究团队,国内企业此前从未获得该奖。

联邦学习实用导论

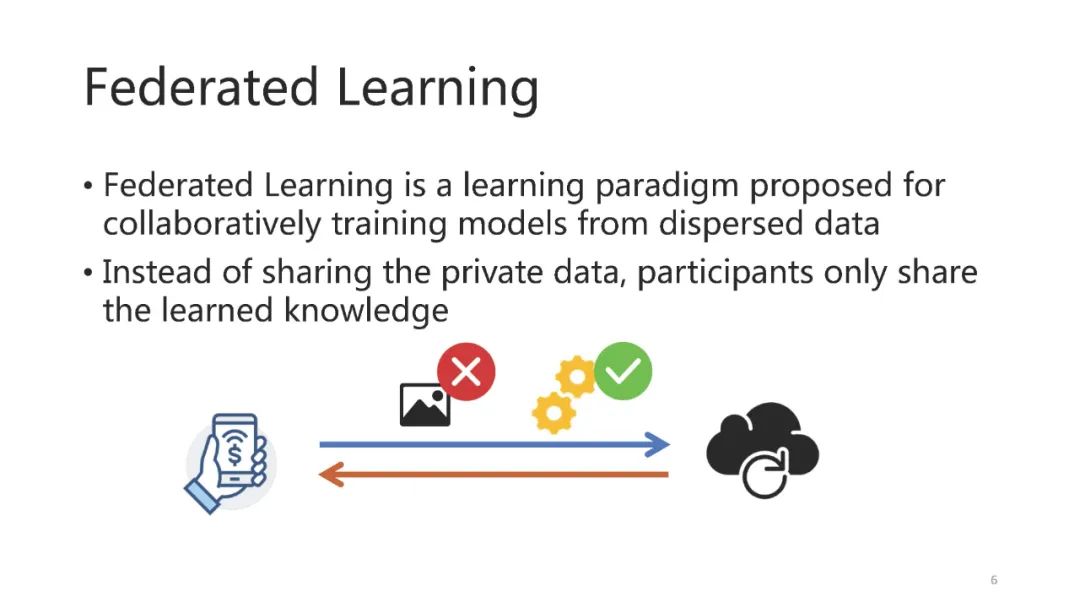

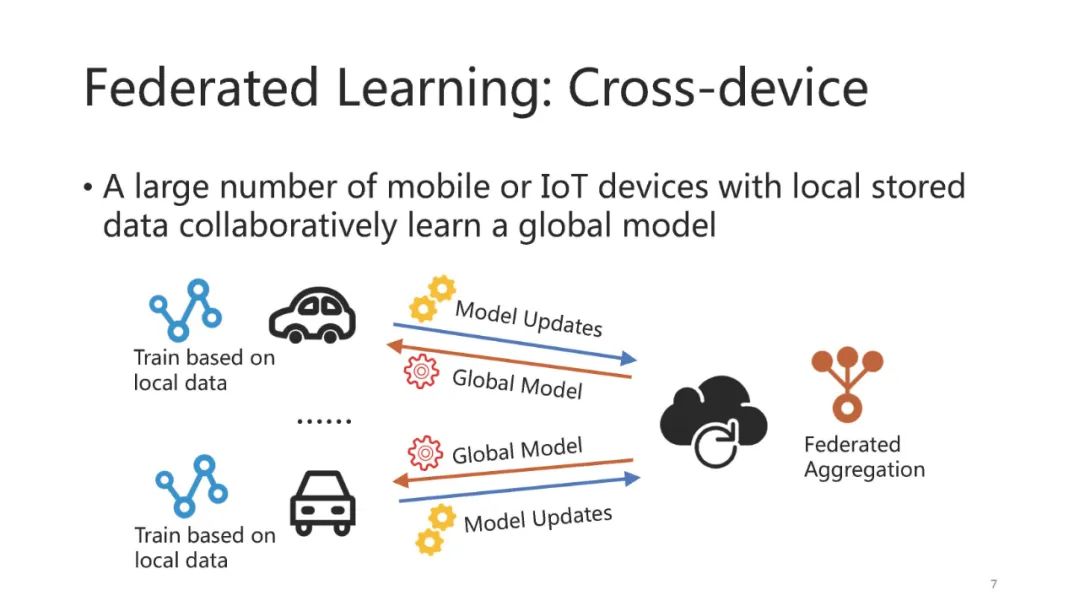

由于互联网用户对自己隐私的重视,以及大多数国家的一些法律法规的实施,互联网产品需要为用户提供隐私保护。联邦学习作为提供这种隐私保护的可行方案之一,近年来在学术界和工业界迅速受到欢迎。在本教程中,我们将从一些现实世界的任务开始,以说明联邦学习的主题,并涵盖一些基本概念和重要的场景,包括跨设备和跨竖井设置。与此同时,我们还将演示几种流行的联邦学习框架。我们还将展示如何使用联邦学习进行自动超参数调优,从而在实践中大大节省工作量。然后我们深入探讨了三个并行的热门话题:个性化联邦学习、联邦图学习和联邦学习中的攻击。对于它们中的每一个,我们将用真实世界的应用来激发它,说明最先进的方法,并使用具体的例子讨论它们的优点和缺点。最后,提出了今后的研究方向。

我们首先介绍了联邦学习[16,25](FL)的基本概念,以及在真实任务中利用隔离数据而不泄露隐私的必要性。几个重要的隐私保护技术,包括同态加密[17],安全多方计算[26]和差分隐私[4],将在我们的教程中简要介绍,从这些技术如何保护数据的隐私(例如,将消息分成帧或添加噪声到交换的消息),以及如何在FL中利用这些技术。然后我们将展示几个标准和实用的联邦学习任务作为例子,例如,聚合来自不同物联网设备的记录,用于全球预测(即水平FL[16]),并共享公司之间重叠应用用户的不同特征(即垂直FL[7])。在此之后,基于现有的FL框架(如TFF[2]、FATE[25]和FederatedScope[24]),我们将提出两种不同的实现FL过程的方法,包括顺序方式和事件驱动方式。

当超参数优化(HPO)来到FL时,每次尝试都意味着多个参与者之间的通信,这可能是非常昂贵的,特别是对于跨设备的场景。因此,有必要让社区意识到在FL设置下HPO的独特性,并促进联合HPO的技能。首先,我们将正式定义联邦HPO问题。然后我们引入了低保真HPO的概念,并强调了在FL设置中调节保真度的两种方法。在此前提下,我们演示了如何实现流行的HPO算法(如Hyperband[11])来配合FL跑路器。这个示例的重要性在于展示HPO组件如何与现有FL框架交互,包括如何触发FL实例,指定每次尝试的配置,以及更重要的是,优化质量如何随着保真度的变化而变化。此外,我们推广了源于神经体系结构搜索[14]的权重共享视图,并在最近应用于治疗联邦HPO。最后,我们回顾了最近的一些工作[9,10,28,31],并为联邦HPO引入了一个新的基准[21]。

目前关于个性化联邦学习的研究主要集中在学习对象向他人学习的程度以及如何将共享知识与局部模型融合等方面。我们将文献中提出的个性化FL方法根据不同客户之间的不同进行分类,如训练配置、子模块、训练行为和局部模型,并从有效性和效率方面总结它们的优缺点。然后,我们将演示如何将个性化模块插入到一个标准的FL课程,使用几种现有的方法为例,包括pFedME [19], FedBN [13], FedEM [15], Ditto[12]等。此外,我们还将展示如何监控客户端和全局指标,以检查应用个性化FL方法的优势。最后,我们引入了一个个性化FL[3]的基准,并讨论了一个扩展任务,该任务进一步考虑了客户端级任务[27]的异构性。

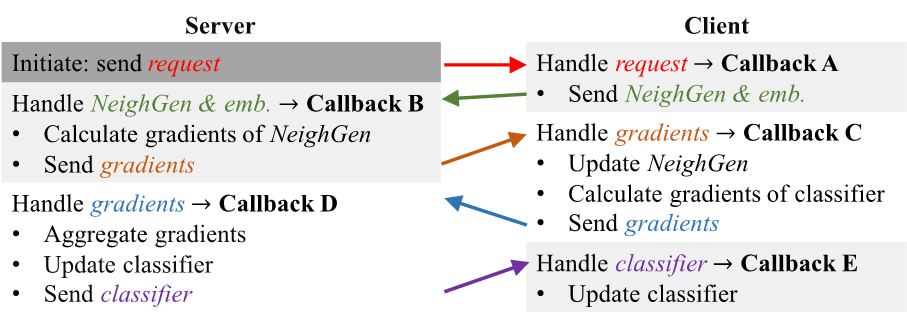

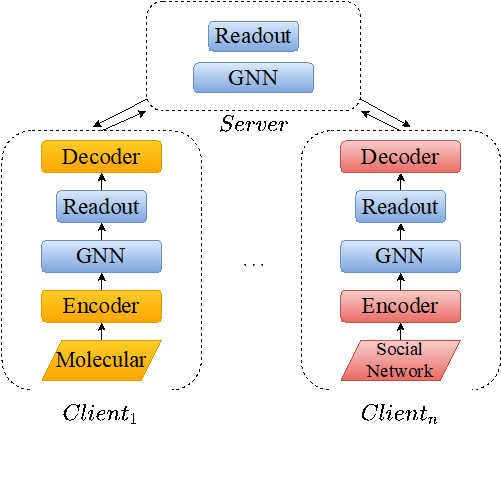

尽管FL已被应用于各种类型的数据,但联邦图学习(FGL)的重要性和独特性使其值得在本教程中占据专门的部分。首先,我们列举了几个真实的FGL应用,包括推荐系统[22]、医疗健康[29]、反洗钱[18]等,来吸引我们的受众。这些应用表明,联邦处理图数据的需求是非常普遍和强烈的。然后,我们将展示如何通过将原始图拆分为子图来将普通图数据集转换为联邦图数据集。我们将比较两种流行的分裂策略,随机分裂和基于社区的分裂[1]。接下来,我们演示了如何基于PyG[5]实现一个图神经网络(GNN),以及如何将所开发的GNN模型集成到FL框架中并进行FGL。最后,我们将学习后的GNN模型与整个图、客户端子图和FGL进行性能比较。与此同时,这个示例暗示了完成每个客户端子图的潜在优势。因此,我们进一步介绍了最近关于这个主题的一项工作—federatedage +[29],描述了它的公式以及如何使用FederatedScope[24]实现它。由于FGL算法(如FedSage+和GCFL+[23])经常要求在FL参与者之间交换异构数据,并表现出更复杂的行为,因此它们的实现使观众对FederatedScope的事件驱动设计有了更多的了解。最后,我们将介绍一个最近的FL包[20],它专门用于FGL。

直接应用隐私攻击可以直观地展示FL的隐私保护能力,这使得它成为本教程的一个重要部分。从攻击FedAvg[16]这一最流行的FL算法开始,我们将介绍FL中隐私攻击的背景:(1)包括被动攻击和主动攻击的攻击设置,(2)攻击类型,包括成员推断攻击、属性推断攻击、类代表攻击、训练数据和标签推断攻击,(3)最先进的隐私攻击方法,包括DMU-GAN [8];DLG [32], iDLG [30], GRADINV[6]。接下来,使用FederatedScope中实现的攻击方法,我们将演示在FedAvg中直接共享模型参数更新时的隐私泄露。此外,通过展示隐私攻击和防御策略之间的对抗,我们将说明隐私攻击如何指导防御策略的选择。最后,我们还将演示如何使用FederatedScope方便地开发用户定制的攻击者。