![]()

©作者 | 刘璐

学校 | 北京邮电大学

研究方向 | 问题生成与QA

![]()

论文标题:

GPL: Generative Pseudo Labeling for Unsupervised Domain Adaptation of Dense Retrieval

https://arxiv.org/abs/2112.07577

https://github.com/UKPLab/gpl

Abstract

稠密检索相比于稀疏检索可以克服 lexical gap,可以得到更好的检索结果。然而训练稠密检索模型往往需要大量的数据。BEIR: A Heterogenous Benchmark for Zero-shot Evaluation of Information Retrieval Models

[1]

表明领域迁移会极大地影响稠密检索模型的性能。

本文针对稠密检索提出了一种先进的无监督领域适应方法 Generative Pseudo Labeling(GPL),使用 query 生成模型与基于 cross-encoder 的匹配模型为目标域构造伪标签。

实验结果证明了此方法的有效性,且相比于之前的领域迁移方法更加鲁棒。

本文还探究了六种近期提出的预训练方法在稠密检索领域迁移任务上的表现,只有三种方法有促进作用。其中效果最好的 TSDAE

[2]

可以与 GPL 结合,进一步提升模型性能。

![]()

Introduction

稠密检索模型需要大量的训练数据才可表现优异,研究表明其对领域迁移十分敏感。比如,在 MS MARCO 上训练的检索模型在 COVID-19 相关文档检索任务中表现很差。MS MARCO 数据集是在 COVID-19 之前创建的,因此它不包括任何与 COVID-19 相关的主题,模型无法学习如何在向量空间中很好地表示该主题。

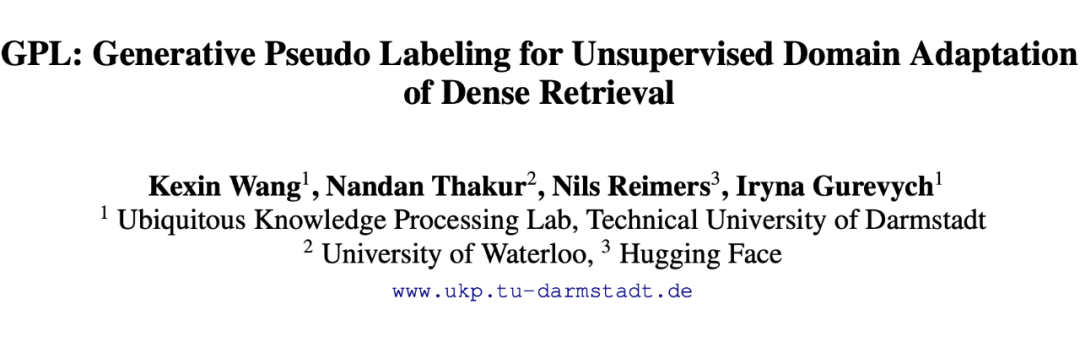

针对此问题,本文提出 Generative Pseudo Labeling(GPL),具体流程如下图所示。

![]()

1. 首先使用预训练 T5 模型根据目标域 passage 生成对应的 query;

2. 之后使用稠密检索模型为每个 query 挖掘负样本;

3. 最后,使用 cross-encoder 为每个 query-passage 对打分,为目标域稠密检索模型的训练构造伪标签。

流程中使用到的 T5、稠密检索模型、cross-encoder 均为现有的在 MS MARCO 数据集上预训练过的模型。

Related Work

3.1 Pre-Training based Domain Adaptation

对于 transformer 模型,最常用的领域适应方法是基于域自适应的预训练,该方法的基本做法是在使用标签数据对模型进行微调之前,先使用目标域数据对模型进行预训练。然而对于检索任务,目标域标签数据往往难以获得,因此需进行零样本学习。除 MLM(Masked Language Modeling)外,还有一些针对稠密检索的其他预训练策略,具体如下。

ICT(Latent Retrieval for Weakly Supervised Open Domain Question Answering [3] , ACL 2019)通过从 passage 中随机选择一个句子作为 query,剩余的部分作为配对的 passage,生成 query-passage 对。

CD(Condenser: a Pre-training Architecture for Dense Retrieval [4] , EMNLP 2021)提出针对稠密检索的预训练模型 Condenser,改变现有 MLM 的结构以迫使模型学习有意义的 CLS 表示。

-

SimCSE(SimCSE: Simple Contrastive Learning of Sentence Embeddings

[5]

, EMNLP 2021)将同一句句子输入到具有不同 dropout 的网络中两次,最小化两次结果的距离。

CT(Semantic Re-tuning with Contrastive Tension, ICLR 2021)与 SimCSE 类似,不同的是其将句子输入到不同的两个模型中。

-

TSDAE(TSDAE: Using Transformer-based Sequential Denoising Auto-Encoder for Unsupervised Sentence Embedding Learning

[6]

, EMNLP 2021 finding)使用具有瓶颈的去噪自编码器架构:从输入文本中删除单词,并通过编码器生成固定大小的 embedding,解码器须重构原始文本。

ICT、CD 仅被研究用于域内的性能,即在预训练之后,有大量标签数据用于后续有监督的微调。SimCSE, CT, TSDAE 仅用于无监督的句子向量学习。直接使用利用这些策略学习到的句子表示用来检索,其性能远远不足。

![]()

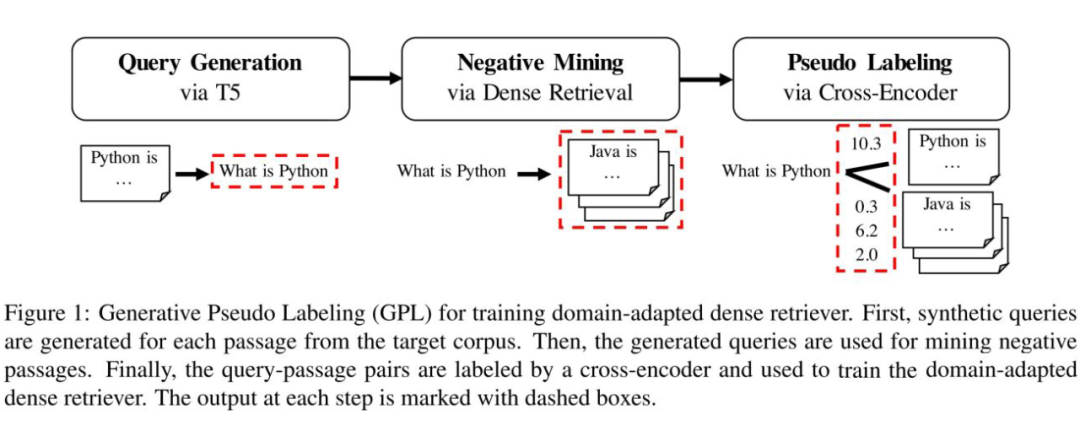

目前这些预训练方法是否可以用于稠密检索的无监督领域适应还不明确

。本文首先使用这些这些策略在目标域文本上进行预训练,之后在 MS MARCO 数据集上微调模型来实现稠密检索的领域迁移,并探究其效果。

3.2 Query Generation

一些工作通过 query 生成来提升检索模型的性能。

尽管 QGen 很有效,训练检索模型时损失使用的是批内负样本的交叉熵损失,这仅提供了粗粒度的相关性,因此限制了模型的性能。本文使用考虑困难样本的 cross-encoder 提供的伪标签来提升模型性能。

3.3 Other Methods

3.4 Pseudo Labeling and Cross-Encoders

不同于双塔式结构,cross-encoder 将 query 和 passage 进行拼接后通过 cross-attention 预测相关性分数,通常用于精排阶段。相关研究表明 cross-encoder 相比于稠密检索模型具有更好的性能和领域适应能力。但由于其较高的计算开销,不太适用于检索,但检索模型可从 cross-encoder 中蒸馏知识以提升性能。

![]()

Method

Introduction 部分已介绍本文所提出 GPL 的基本结构,此处不再赘述。此处主要介绍本文方法相比于 QGen 的区别。

QGen 进行 query 生成后,使用 MultipleNegativesRanking(MNRL)损失训练检索模型:

![]()

其中

表示 query,

表示 passage,

表示 batch size,

控制 softmax 归一化的尖锐程度。

QGen 存在一些弊端:MNRL 损失仅考虑了 query 与 passage 之间的粗粒度相关性;query 生成器可能生成不能被输入 passage 回答的 query;存在其他passage可能与 query 相关的情况,即假负例的问题。

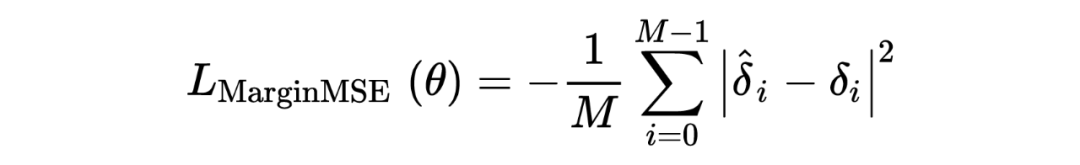

本文使用 cross-encoder 提供的伪标签和 MarginMSE 损失来训练模型,使稠密检索模型模仿 query 与正负 passage 之间的得分差异。

![]()

MarginMSE 损失解决了两个关键问题:当 query 生成器生成的 query 质量较低时,其 cross-encoder 分数也会比较低,此时稠密检索模型不会使 query 和 passage 在向量空间中过于接近。假负例会在cross-encoder中得到高分,相应的向量也不会被拉得很远。

![]()

Experiments

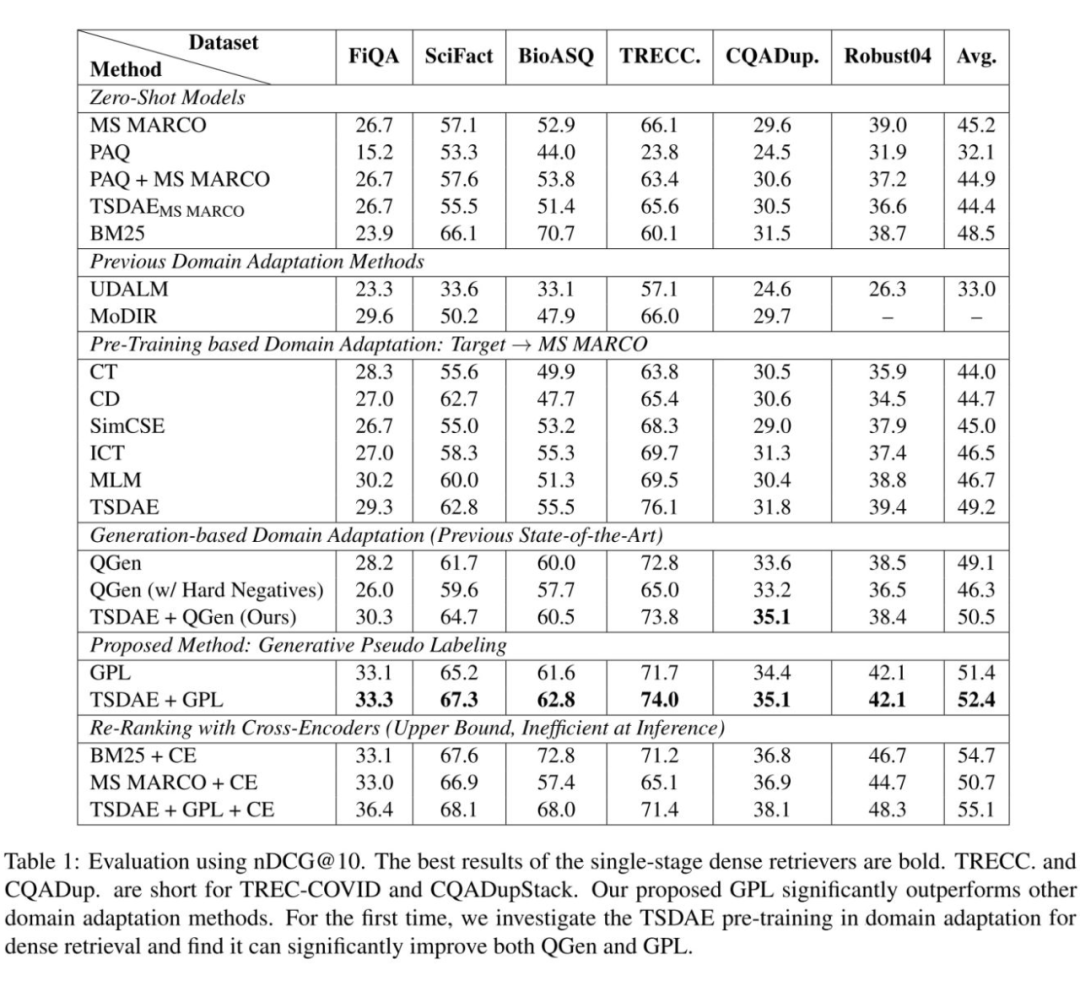

选择六个特定领域来检测模型的领域适应能力,包括 FiQA(financial domain), SciFact(scientific papers), BioASQ(biomedical Q&A), TREC-COVID(scientific papers on COVID-19), CQADupStack(12 StackExchange sub-forums), Robust04(news articles)。使用 nDCG@10 作为评估指标。实验结果如下表所示,与多个 baseline 相比可见 GPL 的有效性。

![]()

![]()

Analysis

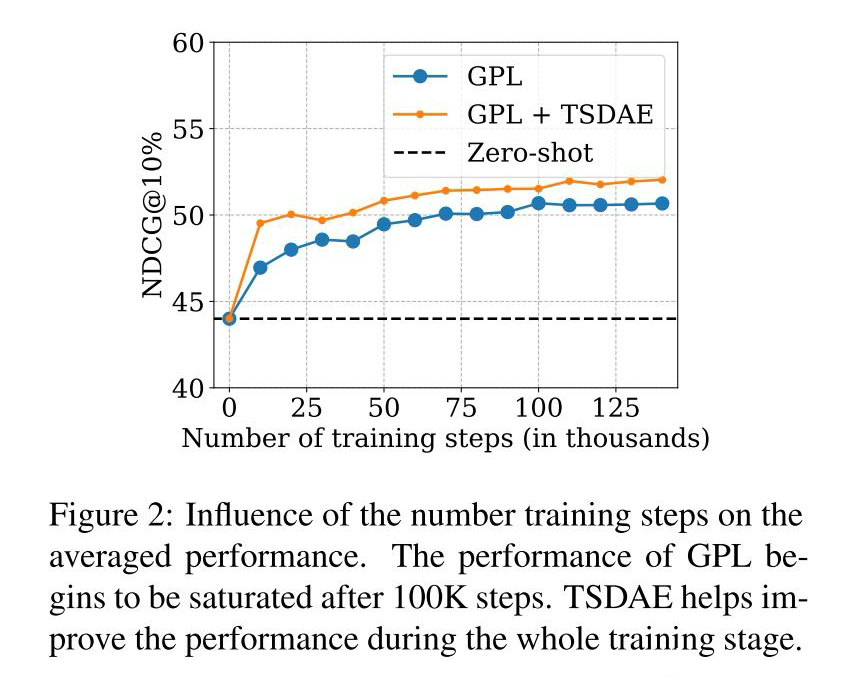

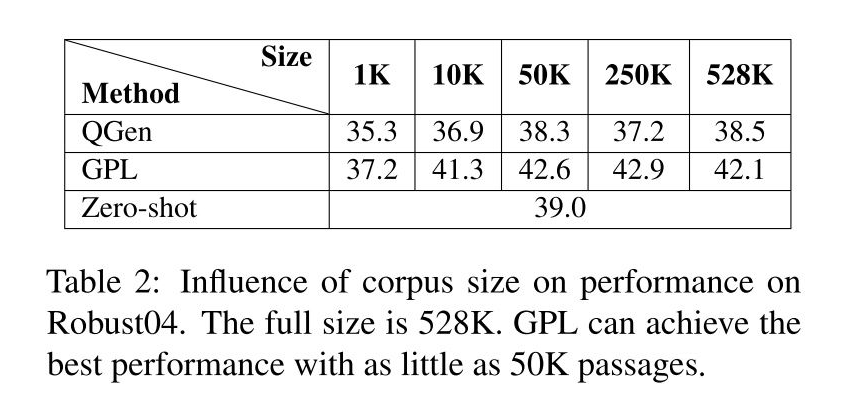

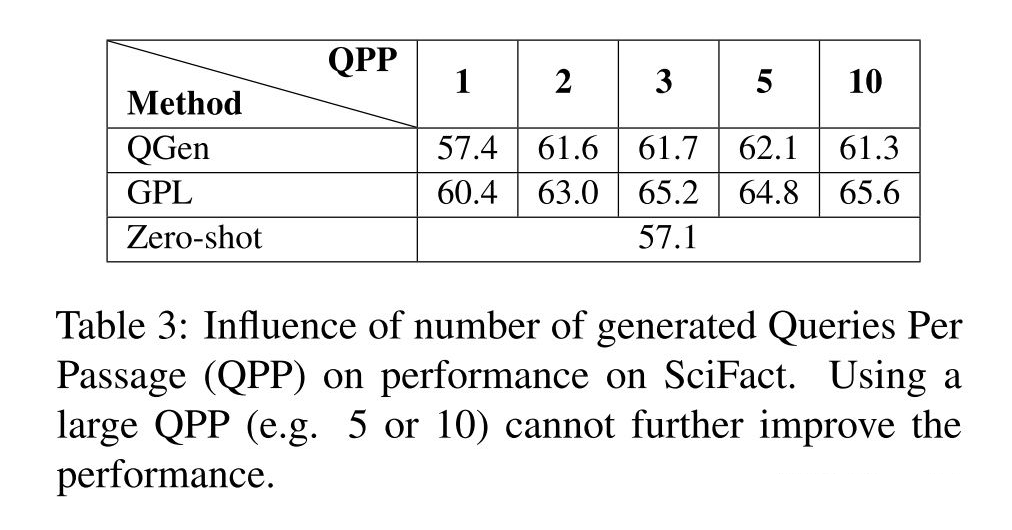

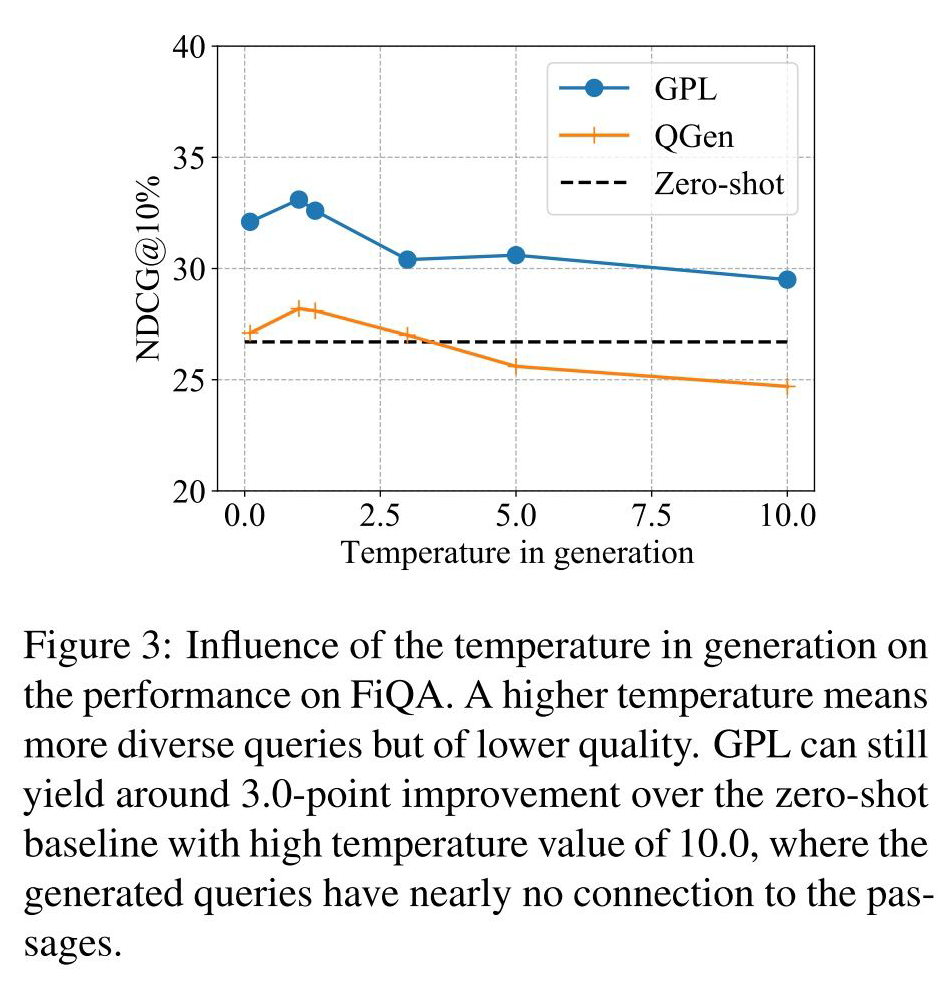

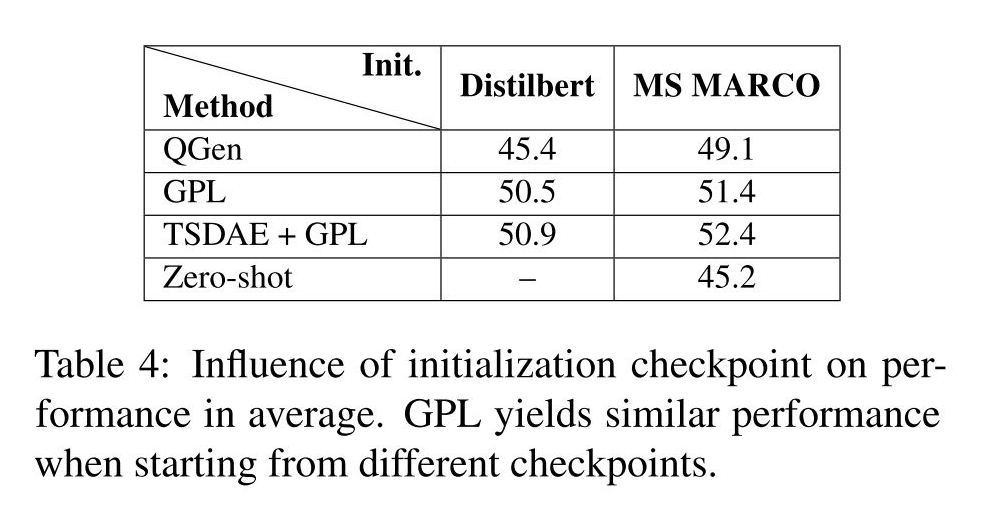

此部分分析了训练步数、语料库数量、query 生成、开始 checkpoint 对 GPL 模型的影响。

![]()

![]()

![]()

![]()

![]()

![]()

Conclusion

本文提出 GPL,一种稠密检索的无监督领域适应方法,通过 query 生成模型为目标域 passage 生成 qurey 并使用 cross-encoder 构造伪标签,克服了以往方法的两个重要缺点:query 质量无法保证及假负例的问题。GPL 在所有目标数据集上的表现超越了之前的方法。

本文还探究了多个预训练策略在领域适应上的表现,ICT 和 MLM 可以带来少许提升,TSDAE 可以带来较为明显的提升,其他方法反而对性能有损。

模型的领域适应本质上是对源域训练的模型进行修正或补充,因此设计与目标任务更接近的预训练策略或为目标任务构造对模型修正有效的训练数据均可以提高模型在目标域的表现。

[1] https://arxiv.org/abs/2104.08663

[2] https://aclanthology.org/2021.findings-emnlp.59/

[3] https://aclanthology.org/P19-1612.pdf

[4] https://aclanthology.org/2021.emnlp-main.75.pdf

[5] https://aclanthology.org/2021.emnlp-main.552.pdf

[6] https://aclanthology.org/2021.findings-emnlp.59.pdf

[7] https://arxiv.org/abs/1904.08375

[8] https://aclanthology.org/2021.eacl-main.92.pdf

[9] https://arxiv.org/abs/2110.07581

[10] https://aclanthology.org/2021.naacl-main.203.pdf

![]()

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

![]()

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

![]()