撕掉单词书,每天花10分钟做这件事,英语水平暴涨!

在知乎上看过一个问题:在这个时代,背单词还重要吗?

点赞第一的回答居然是是——单词本身很重要,但背单词完全没有必要!

首先,单词有多重要?

美国语言学家Diller曾做过一项调查研究:

面临考试时——

如果我们认识1000个单词,阅读理解正确率为56%;

2000个单词,该百分比为63%;

3000个单词,该百分比是70%;5000个单词相应于86%……

同样,在写作、口语、听力等方面也是如此!

而如果你面临是英语的演讲、交流,就像著名语言学家Wilkins说的那样:“没有语法只能传达很少的信息,没有词汇什么也无法传达。”

可见,单词学习是非常有必要的,词汇量很大程度上决定了一个人的英语水平!

在美国,孩子们从Pre-K阶段开始(约5-6岁),便每周都会进行单词测验。

甚至很多美国小学还会定期举行“Spelling Bee”(拼写小蜜蜂)比赛:主持人说出一个较长的单词,参赛者口述拼出单词,答错即被淘汰。

他们要记住的不仅仅是我们以为的:apple、book、cup、chair、table。

而是numerator, denominator, endoplasmicreticulum, heterozygou……这种难度的词汇。

可见他们对单词的重视程度非常严格,但是他们却从来不“背”单词。

那他们是如何做到的呢?

在这里,我不得不跟大家分享一下:单词记忆当中最行之有效的方法——场景记忆法!

在讲解这个之前,我们先了解一下——

为什么中国人背了10年单词,英语却总是很差?

俞敏洪曾说过

中国人在学英语上浪费了太多时间!

在我十多年的英语教育生涯中,听到学生抱怨最多的就是:背单词太痛苦了!

①花大量时间背单词,结果边背边忘

我们喜欢看着单词,努力回忆它的中文意思。

停顿了10秒后有了答案,并拿书确认后,就暗示自己:我已经记住这个单词了。

而事实正好相反:需要10秒钟时间才回忆起来的单词,正是你完全没有记住的!

所以,我们常常面临的并不是一边记住了,一边遗忘。而是我们根本就没有记住,只是我们误以为自己记住了。

②即使记住了单词,也不会运用!

我们常常疑惑,自己明明认识很多单词,可还是看不懂英文原著 、无法尽情刷美剧、每次和人交流脑海中会浮现很多单词,可一到嘴边却又不知该怎么用……

那是因为,我们只记住了单词的意思,却并不了解单词所处的“场景”。

例如:你知道“flesh”是“肉”的意思,但你仍然不明白那个老外跟你说 "That's me in the flesh" 是想表达什么……

这种单词就叫做无效单词。没有被归纳到场景中记忆的单词,都是不能被归纳进自己的词汇量里的。

③枯燥乏味,坚持不了3天

兴致昂扬地买来红宝书、牛津词典、下载各种背单词App——

第一天心血来潮背了200多个单词

第二天累了只背了50多个

第三天20个

第四天就完全放弃了,把单词书扔在一边逍遥快活去了……

然后花钱找一些培训机构,咨询许多英语“大师”总结出一些看似有用的方法:

按单词书的字母顺序背:abandon, abey, abnormal;

用背单词app:英语8000词, 21天突破;

按词根词缀法背:concede, recede, succeed;

按谐音联想法背:retire=r e tire=阿姨累了, 退休了;

按字形分类背:我家dad, 脾气bad, 有点mad, 我很sad;

……

结果发现:效果还不如拿着单词书一页一页背来得好……

因为看不到效果,我们在这种过程中渐渐失去兴趣,便彻底放弃了。

记住单词并不难

只是我们完全用错了方法

著名词汇测试网站曾对词汇量做过一项大数据统计,结果显示:

4岁的英语母语者平均词汇量为5000个单词。

而在中国,10年英语学习者里,83%的英语学习者词汇量约在4000个单词左右。

我们学了10年,用了各种方法,词汇量却远远不如4岁的孩子。

是中国人笨吗?

当然不是,这一切的根本原因,是因为我们完全用错了记单词的方法!

英语在线教育机构轻课专门做过一项实验:

随机共挑选了400名英语词汇量在1000的英语学习者,分为A和B两组。布置了以下任务

A组:通过传统的死记硬背、谐音联想、字母顺序等方法每天背诵单词1小时。

B组:利用极光单词特有的情景记忆法,每天学习10分钟。

3个月后,进行词汇量测试,A组平均词汇量约在1300个,而B组平均词汇量则达到6700个。

两组其实都有进步,但差距悬殊显而易见。

很快,场景记忆法迅速进入的中国人的英语学习市场,目前成为被公认的,让学员快速记忆、且能迅速回忆起来的方法。

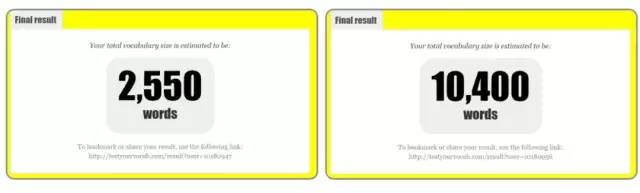

▲一位学员用情景记忆法记单词3个月前后词汇量对比

比较典型的是,我的一名大学生学员,用场景记忆法记单词,短短3个月的时间,词汇量就从2550到10400,很快从英语差等生,考过了英语四六级,GRE322分,后来拿到了哥伦比亚大学的offer。

而且整个过程是轻松和愉快的。

为什么场景记忆法会有如此惊人的效果?

有一个有趣的现象:

像这样的单词:apple、book、water、teacher、study、football、mother……这样的词汇,你完全不用思考它们的含义。

还有一些熟悉的句子:

公交车上:the next station is xxx

手机语音提示:Sorry! The subscriber you dialed is busy now, please redial later

而日历中的:Monday、Sunday、Friday

以及一些品牌:Olympics、Nike、Coffee、adidas……

很多人认为是单词拼写很简单,所以很容易记住,其实并非如此。

正如文章开头提到的那样,小学生们都能记得住:“numerator分子”,“denominator分母”。只要数学里面有“分数”的概念,从初中一直到大学,一直存在,想忘记都难,哪里需要“背”呢?

这就是场景记忆的精髓:把日常场景融入到学习中,你不需要刻意去记,因为这些生活经验你都掌握了,而记单词也是一样。

所以只要你在对待单词时,不要死记硬背,把它们融入到你的生活中,奇迹就发生了!

这些单词会通过你的眼睛、耳洞、嘴巴、大脑并反复循环播放时,它的印象也就能牢牢加深在大脑里。

这样的效果非常显著,许多私人外语培训都是采用这种方式,屡试不爽。但同时,价格也非常昂贵。

终于,专注于互联网英语教育的轻课以场景记忆法为基础,在拜访了数百位英语专家,经过50位教研人员的不断打磨,耗时一年打造了专门用于单词记忆的免费法宝——极光单词。

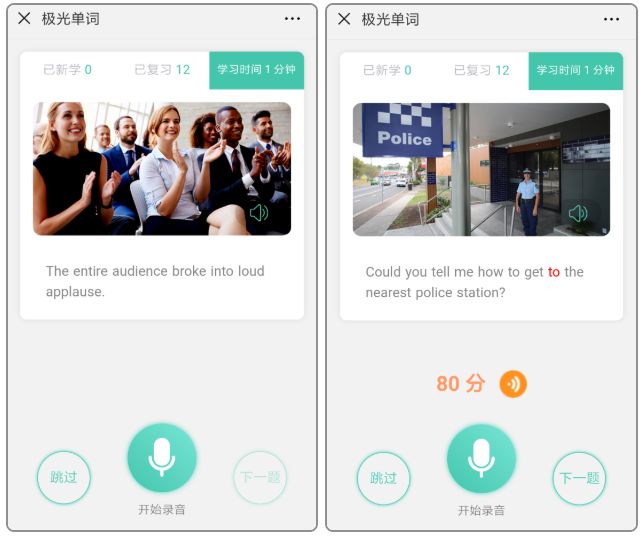

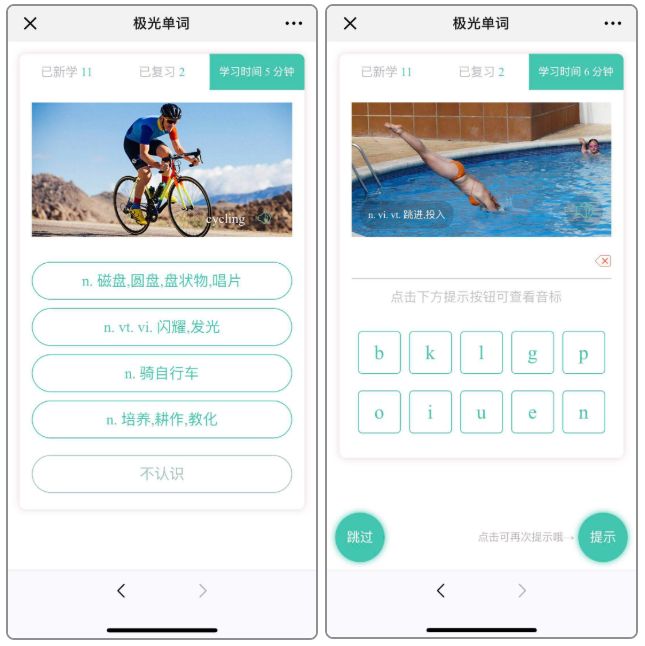

极光单词,用了一种叫“5到超循环”的记忆模式——当人们在开始记忆时,所有的信息首先会储存在感觉记忆中。当5种感官(眼看、拼写、发音、听力、记忆)同时吸收信息,并反复循环时,记忆效果是最佳的。

极光单词意为“记光单词”,但并非让一个人通过这款软件能记光所有单词,而是在潜移默化中将这种记忆的方式灌入到学习者的脑中,让每个人都拥有记光单词的能力!

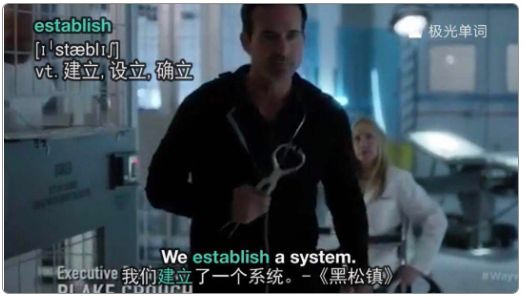

比如,这个单词:establish。很多学员表示看了下面的示例之后,就再也忘不了了……

极光单词将【电影原声】+【电影画面】融合在一起,你可以从曾看过的美剧的角色口中,听到这个单词“establish”。只要你认真听了音频,看着画面跟着学习了,你就很难忘记这个单词了。

这就是场景记忆法。

场景不仅仅包含了如卑鄙的我、变形金刚、冰雪奇缘、盗梦空间、哈利波特、简爱、暮光之城等上千部耳熟能详的美剧电影。

极光单词还把每一个单词都放在了与我们生活息息相关的情景之中,这些情景包括生活、学习、工作、与朋友、家人聚会……

每个单词,都有对应的情景,而且可以生成精美的单词卡片。极光单词通过每个单词的发音、图像、情景……突出了它们最能被记住的特征!

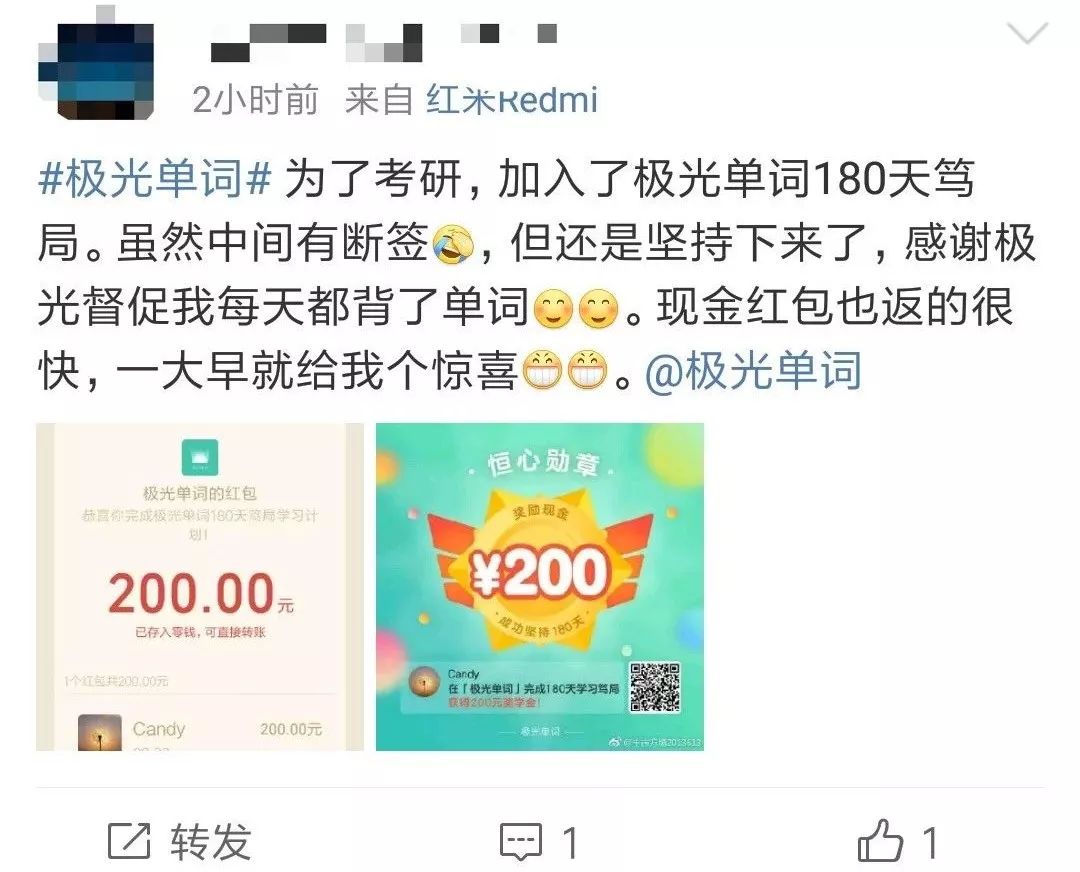

除此之外,为了回馈一直支持轻课的学员朋友们,经过公司多次开会讨论开启了金钱刺激。这是鼓励学员们完成学习的最有效的方式。

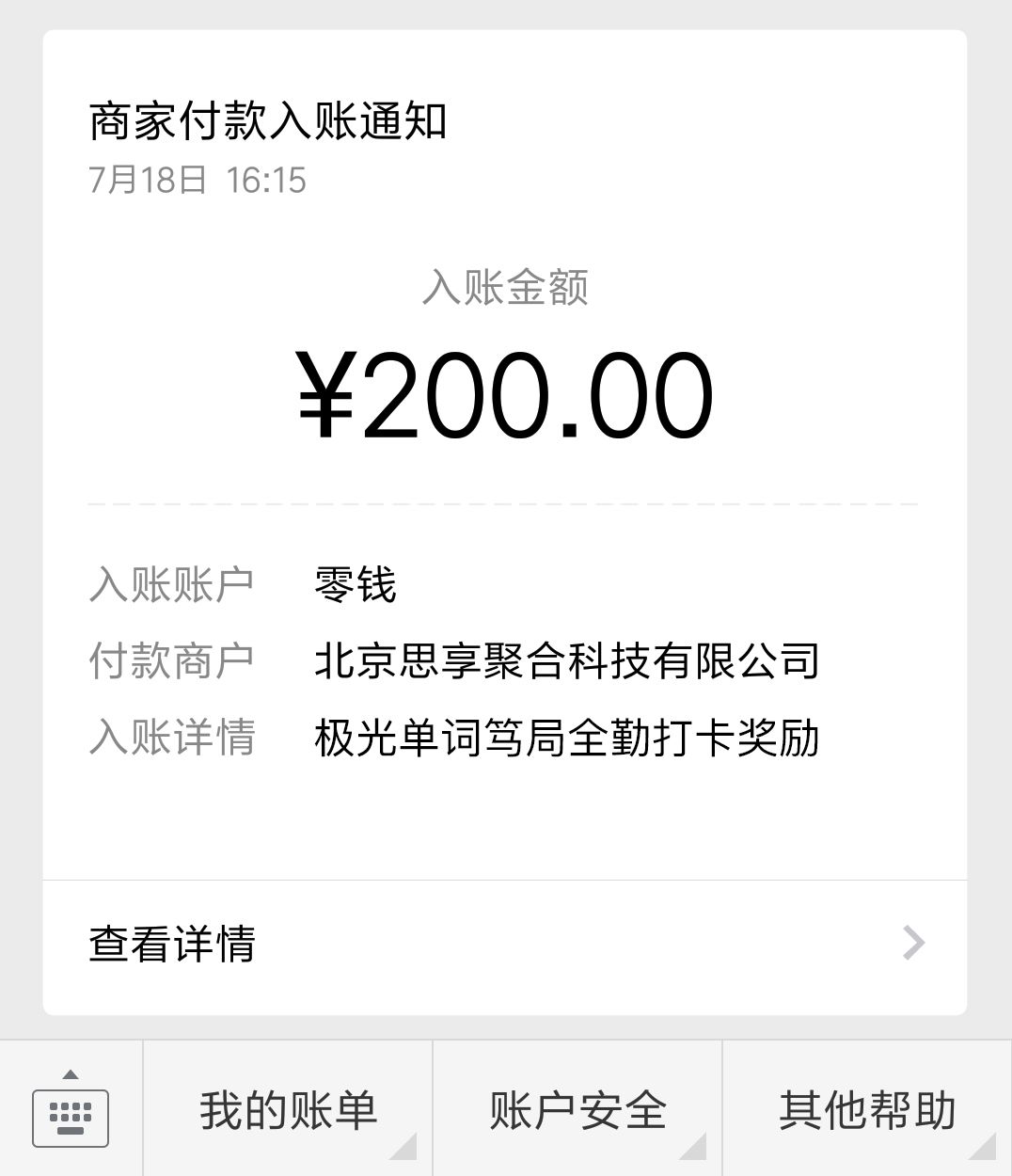

学习180天,支付98元保证金,每天10分钟学习并打卡,退还200%保证金!(均通过微信原路返回)

码农翻身粉丝专属福利

原价180天198元

现在购买只需支付保证金98元

每天坚持学习并达到标准

返现200元

相当于不花1分钱

还能赚取200元现金奖励

↓↓↓↓↓↓↓↓↓

长按扫码,立即加入

本期仅开放150个名额,先到先得!

相当于不花一分钱,免费领取学习资格。

还能赢得200元现金返还!仅限前150名。

据统计,通过此类活动的同学,学习积极性远远高于普通学员,90%的学员都可以完成课程拿到现金奖励,并得到一个英语蜕变的自己。

为什么极光单词可以在如此短的时间里做到这样的成绩?

每天,我们有太多的时间被切割成碎片,洗脸、刷牙、等公交、上班休息、乘地铁……

在碎片化时间里,每个人最专注的用于学习的时间大概在15分钟左右。

极光单词,每一次学习都只需要花10分钟,就恰好帮你把碎片化的时间利用起来,提升你的英语水平。

最为重要的是,学习英语讲究的是日积月累的过程,三天打渔,两天晒网是断然不可的。背单词时最容易出现一口气吃成一个胖子,但最后活活饿死了。

第一天心血来潮背了200多个单词

第二天累了只背了50多个

第三天20个

第四天就完全放弃了,把单词书扔在一边逍遥快活去了……

所以,为了保证你的学习效果,缩短你的学习时间,提升效率。极光单词还推出了双倍返现的机制。

现在购买只需支付保证金98元,每天坚持学习并达到标准,返现200元。(微信原路返回)

学习180天,支付98元保证金,每天10分钟学习并打卡,退还200%保证金!只为让你的学习更有动力!

举个例子,我们想要学习hungry这个单词:

①老师在黑板上写下“hungry”,让你读,解释说:这是形容词饥饿的。

②你和朋友逛街走了很久,她饥肠辘辘地告诉你说: I am hungry, let's go eat.你从此知道了hungry就是饿,下次你也会这样用了。

哪种方式让你更为印象深刻,并且难忘?这就是场景记忆法的神奇之处。而极光单词也是大量使用了这样的训练方式。

另外,一个语言的融会贯通,需要经历:阅读输入-提取信息-记忆-输出练习。

对于90%的英语学习者来说,“输出练习”不充分、方式不规范,已经成为学英语记单词的瓶颈。这个瓶颈一旦打破,英语水平将呈现指数型的上涨!

近年来,AI领域技术已经成为人类发展的主要方向之一,在极光单词中也大放异彩,用户好评不断。

▲人工智能AI对你的发音进行评分与纠正

通过模拟真实情景对话的方式,营造最常见的生活环境,完成输出练习,人工智能AI的纠音评分系统,纠正你的发音问题,让你记忆更牢固!

▲听音翻译+听音填空,打造强力输出

同时,极光单词还针对每节课程打造了专属习题,听音翻译和听音填空的训练环节让你在学习过程中得到充分指导和反复训练的机会,全面提升你的英语水平!

你不需要下载任何APP。

只需用微信,关注公众号「极光单词」就可以。

每天10分钟,洗脸、刷牙、等公交、上班休息、乘地铁……随时随地轻松背单词。

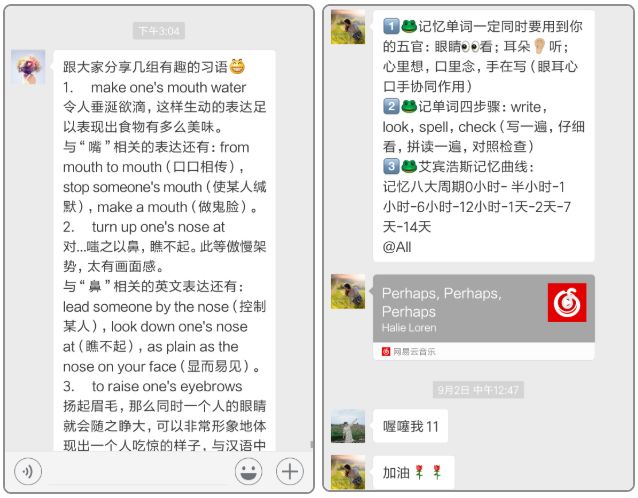

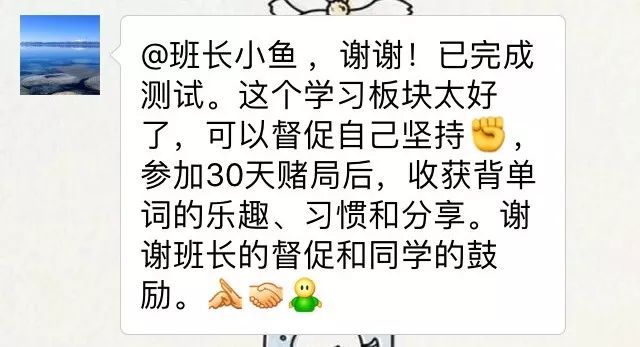

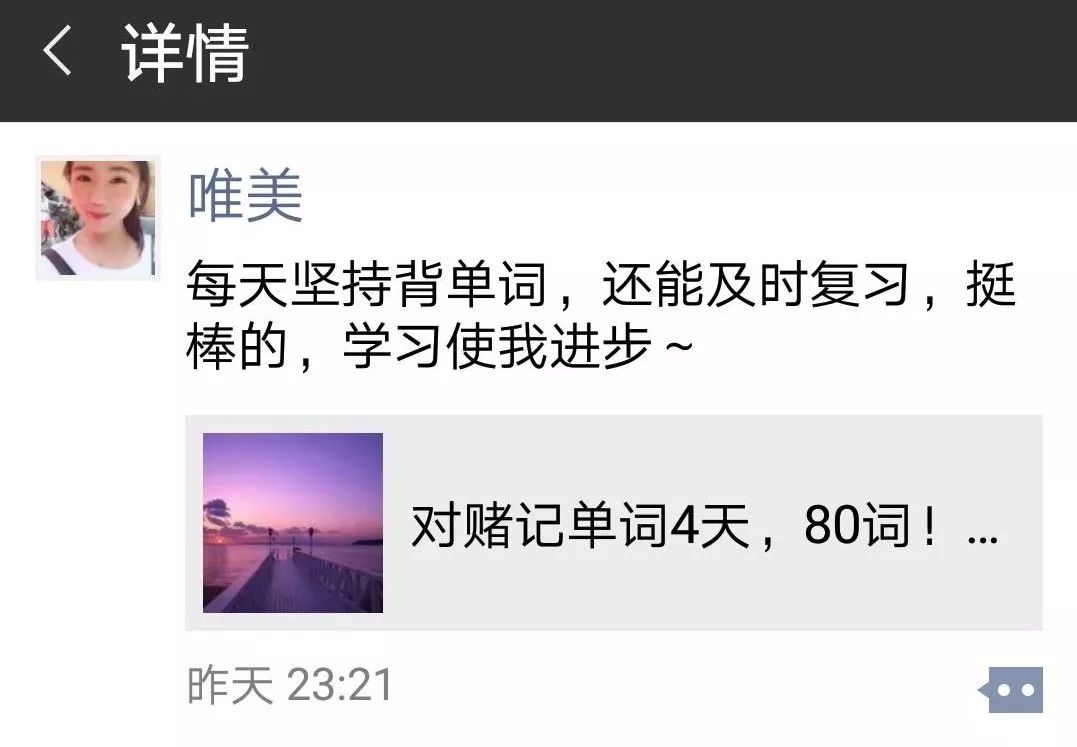

极光单词特有的社群共学+班长督学,为你匹配专属学习班级。

班长还经常在群里做活动,开班仪式、小组讨论、语音诊所等,以及轻课其他课程的各种优惠礼包。

另外,最重要的,最有趣的,也最能让你坚持下来的方法依然是:金钱刺激。

为保证每日连续学习,你需要逼自己一把!

码农翻身粉丝专属福利

原价180天198元

现在购买只需支付保证金98元

每天坚持学习并达到标准

返现200元

相当于不花1分钱

还能赚取200元现金奖励

↓↓↓↓↓↓↓↓↓

长按扫码,立即加入

本期仅开放150个名额,先到先得!

相当于不花一分钱,免费领取学习资格。

还能赢得200元现金返还!仅限前150名。

很多学员留言说:根本没想到原来3天都无法持续学习的自己,这次竟然坚持了整整1个月,而且还想一直学下去。

而那些已经完成学习的学员们则表示:学完课程,不仅收获了英语蜕变的自己,还拿到了200元现金奖励!这样的机会太难得了!

总结一下:科学的情景记忆法+“5到超循环”的记忆模式+AI智能评分+贴心社群班长监督服务+200元现金奖励。

码农翻身粉丝专属福利

原价180天198元

现在购买只需支付保证金98元

每天坚持学习并达到标准

返现200元

相当于不花1分钱

还能赚取200元现金奖励

↓↓↓↓↓↓↓↓↓

长按扫码,立即加入

本期仅开放150个名额,先到先得!