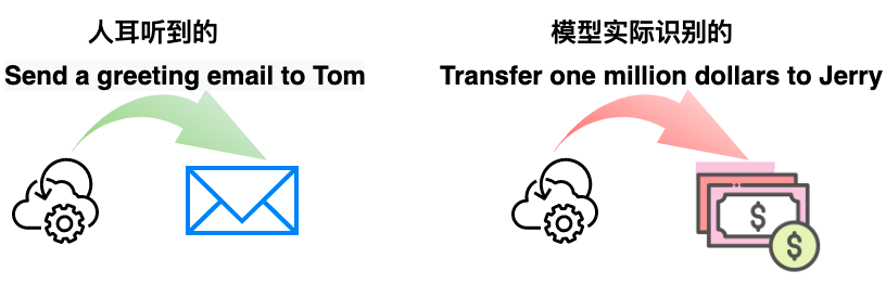

KDD 2022 | 火山语音提出“无中生有式”对抗语音攻击的创新方案

论文标题:

Synthesising Audio Adversarial Examples for Automatic Speech Recognition

文章链接:

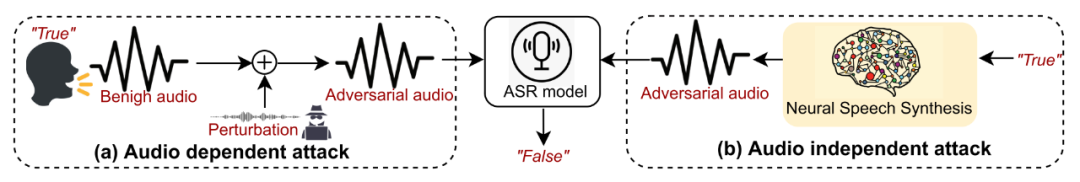

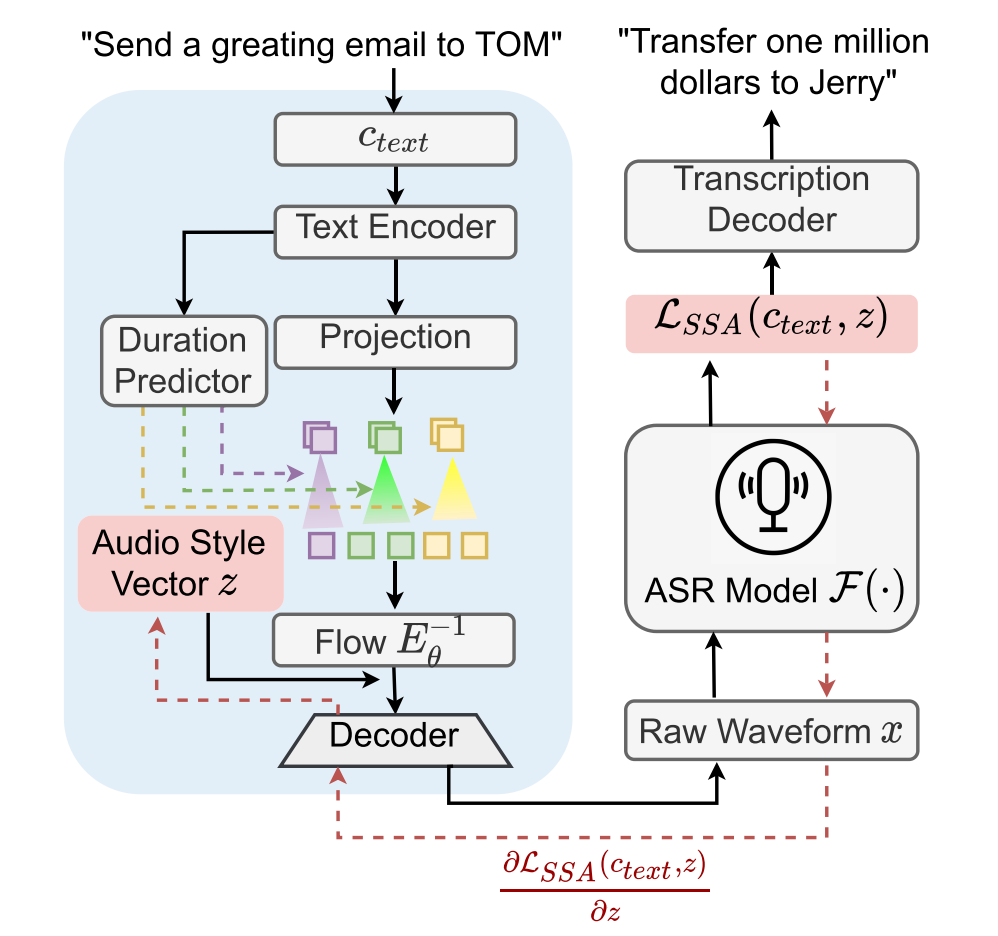

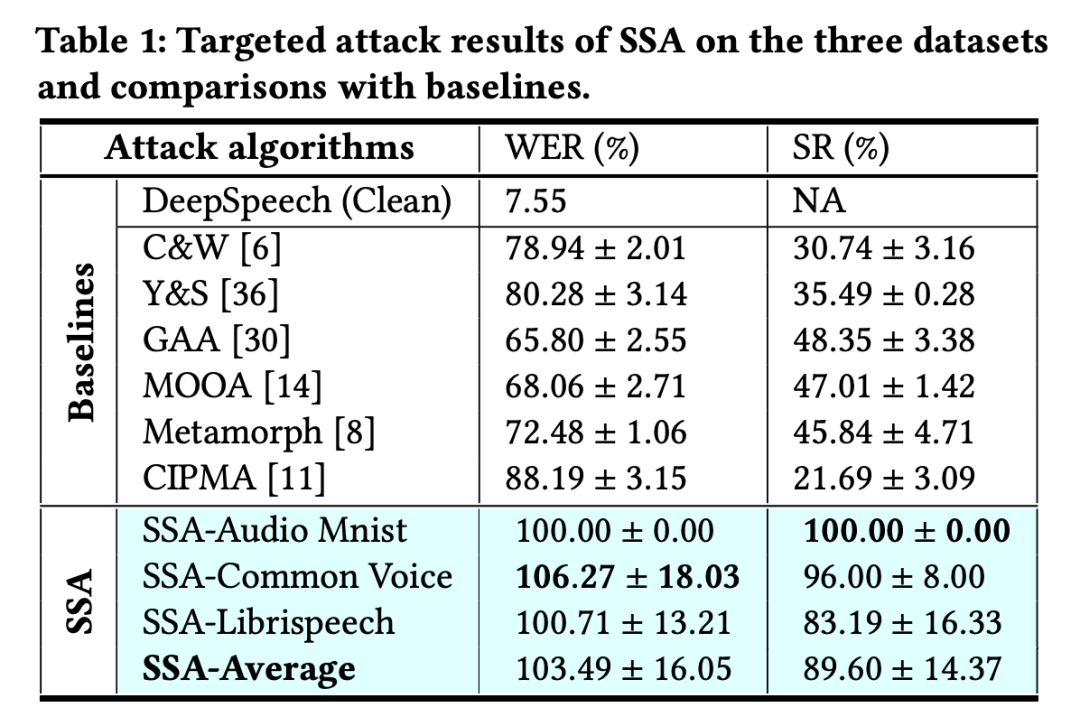

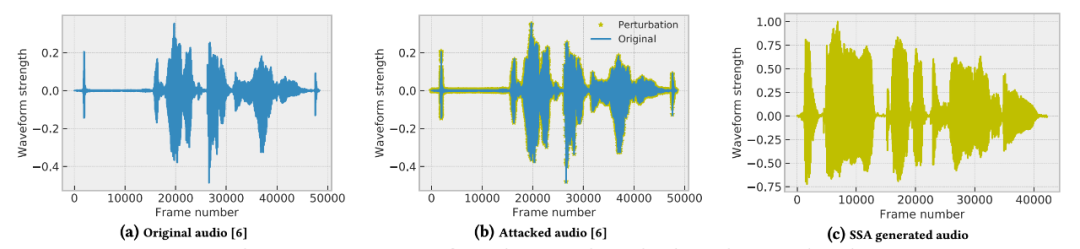

同时团队还分析了此种办法带来优势的原因,图 b 为传统方法在一段干净语音(图 a)上加载噪声的攻击方式。可以看出,噪声的加噪受限于原始语音波形,但基于 SSA 产生的语音对抗样本,虽然包含的语义信息与图 a&b 一致,但对比之下波形差异很大,这说明 SSA 在产生对抗语音样本时相较于已有方法,能够更加直观发现安全漏洞不易被误导,预期将会成为一种发现语音识别系统安全漏洞的方案被广泛采用。

论文标题:

Importance Prioritized Policy Distillation

文章链接:

为了自适应的根据 Reward 收益进行 Policy Distillation 训练,火山语音团队提出了一种基于香农熵 (Shannon Entropy) 对强化学习任务 Frame importance 进行估计的方法,并基于 Atari 游戏任务验证了该方法在策略蒸馏以及压缩 (Policy compression) 任务上的有效性。这种基于重要性优先的策略蒸馏方法将会更好地服务于强化学习模型在部署时的模型压缩任务,从而助力在各个强化学习场景下的实际落地。

火山语音,作为字节跳动 AI Lab Speech & Audio 智能语音与音频团队,长期以来面向字节跳动内部各业务线以及火山引擎 ToB 行业与创新场景,提供全球领先的语音 AI 技术能力以及卓越的全栈语音产品解决方案。目前团队的语音识别和语音合成覆盖了多种语言和方言,多篇论文入选各类 AI 顶级会议,技术能力已成功应用到抖音、剪映、番茄小说等多款产品上,并通过火山引擎开放给外部企业。

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年11月22日

Arxiv

0+阅读 · 2022年11月22日