WSDM 2022最佳论文候选:港大提出多行为对比元学习的推荐系统

©PaperWeekly 原创 · 作者 | 韦玮

单位 | 香港大学

研究方向 | 推荐系统

论文标题:

Contrastive Meta Learning with Behavior Multiplicity for Recommendation

WSDM 2022

论文链接:

https://arxiv.org/pdf/2202.08523.pdf

代码链接:

https://github.com/weiwei1206/CML.git

https://sites.google.com/view/chaoh

模型方法

2.1 多行为用户数据表示

2.2 多行为图神经网络

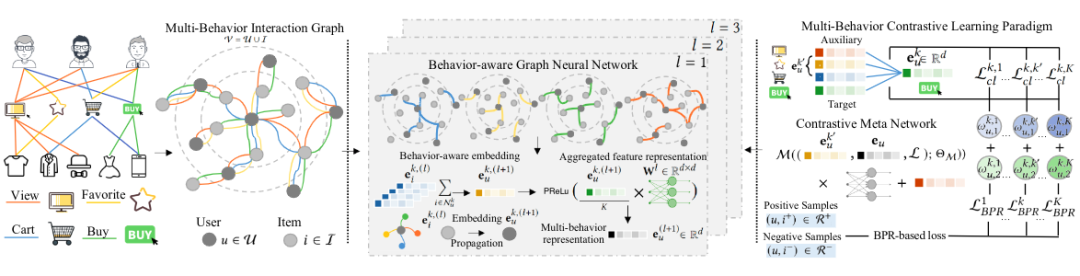

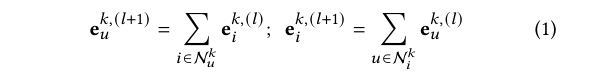

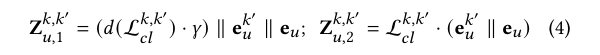

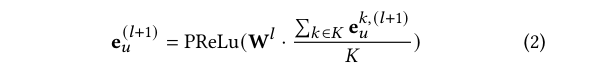

为了在 u-i 关系建模的时候注入高阶连通关系,CML 设计了一个多行为的 GNN。在同一行为类型下,每个节点都通过 sum pooling 的方式直接从异质节点获取信息(LightGCN)。聚合方式如下:

在每层 GNN layer 中,本层的 embedding 将通过上一层的表征得到,多行为表征会先聚合再传入下一层。

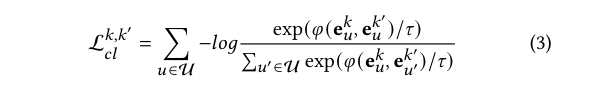

2.3 多行为的对比学习范式

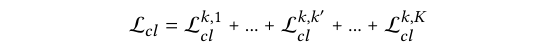

为了可以捕捉到不同行为间的关联性,我们的 CML 模型将不同的用户行为作为对比学习中不同的视图。每种辅助行为都会和目标行为进行关联性建模。具体而言,CML 模型将相同用户的辅助行为与目标行为作为正样本,其他的表征 pair 将作为对比学习中的负样本。用户的每个辅助行为都会和目标行为通过 InfoNCE 计算相应的互信息。

2.4 对比元学习范式

考虑到不同的用户会有不同的多行为偏好,为了有效地建模个性化的多行为关联性,CML 模型通过将基于元学习的编码器引入到对比学习框架中,从而实现用户个性化的多行为信息聚合。

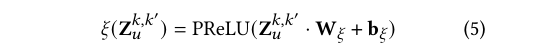

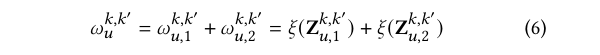

随后模型会将提取出来的 meta knowledge 送入基于元学习的权重网络(meta weight network)中,从而学习出多行为聚合函数中用户定制化的损失函数权重。

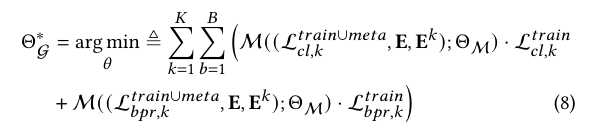

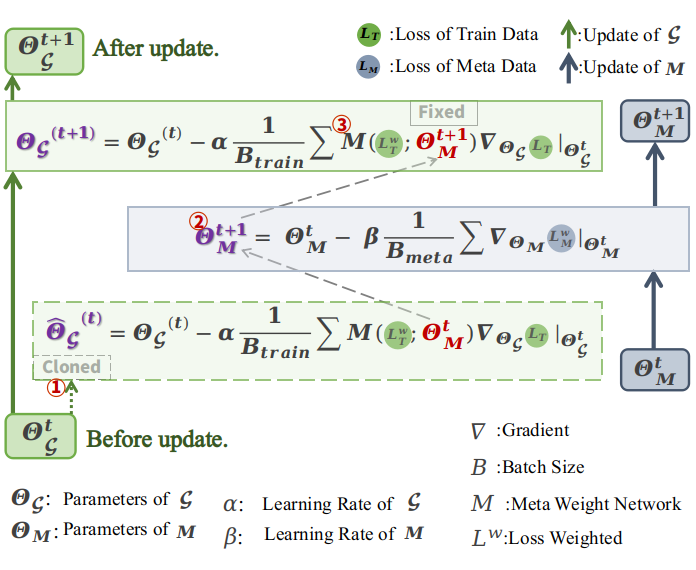

2.5 模型训练

通过 nested meta learning 优化过程,我们将得到有助于本次训练的权重信息,使得在真正梯度下降并更参数的过程,是在学到有效的权重参数的指导下进行:

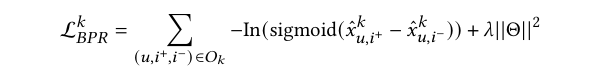

Recommendation 任务的优化是通过 CML 输出的 user 和 item 的 embedding,结合,BPR 损失函数,加上用于防止过拟合的 L2 正则进行训练优化:

实验结果

3.1 整体模型效果

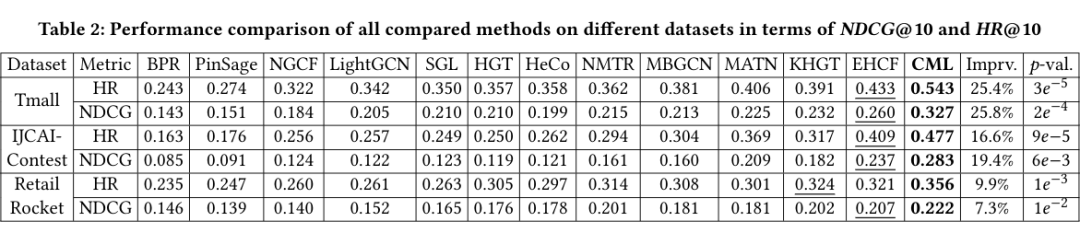

我们在三个真实的数据集(Tmall,IJCAI,RetailRocket)上,通过与 12 个属于不同子技术领域(普通推荐,自监督,多行为推荐)的模型做了比较。结果表明我们的 CML 优于各个 baseline。

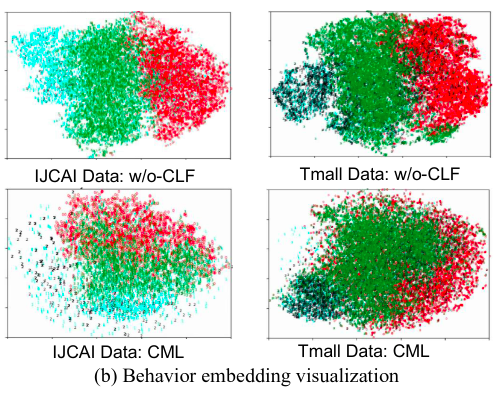

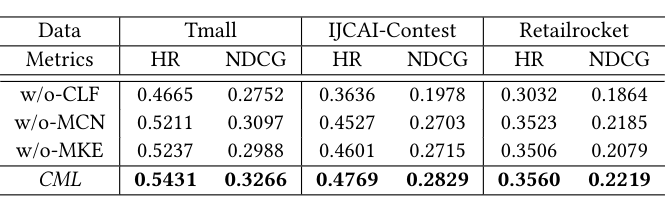

3.2 消融实验

我们设计了 CML 的三种变体, 以证明 CML 关键部件的合理性与有效性。w/o-CLF 去掉了对比学习,只利用 GNN 捕捉多行为关系,而它的实验结果表明了 CML 的多行为对比学习的有效性和对比起到的知识迁移的效果;w/o-MCN 是为了探究行为偏好的影响,如果使得多行为对比有一样的权重,则实验结果表明 meta contrastive 网络可以自动区分 target-auxiliary 行为对之间的影响。

为了验证 metaknowledge encoder 的影响,w/o-MKE 去掉了 meta contrastive weight network,而用一个权重门控机制生成统一的权重,实验结果表明了 customized 行为偏好的重要性。

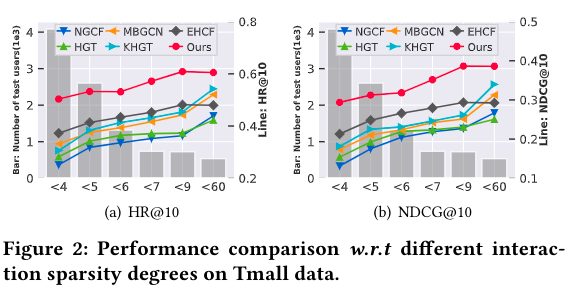

3.3 模型对稀疏数据的鲁棒性

为了说明的 CML 能够一定程度地缓解稀疏性的问题,我们将 user 按照交互数量区间分组(如:“<7” and “<60”)并与其他 baseline 进行比较。结果表明,多行为的模型总是会表现更好,CML在不同程度的稀疏数据下相较于其他模型具有明显的优势。

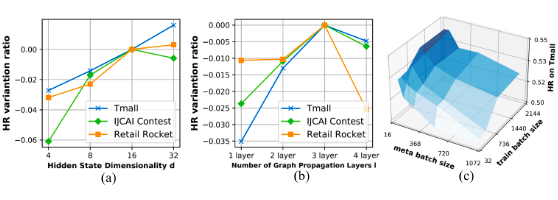

3.4 参数学习

作者对三个模型的主要参数做了实验:i)GNN 的层数 ii)embedding 的大小 iii)meta batch size&train batch size。实验结果表明当 GNN 层数增加,embedding 会得到更高阶的交互信息进而使得模型的结果提升,但是过多的层数会导致 oversmoothing 问题而带来结果的下降;当 embedding 的大小增加时,表征能表示更丰富的信息,进而带来结果提升;我们分别从 {128、256、512、1024、2048} 和 {256、512、1024、2048} 范围内搜索 CML 的 meta batch size 和 train batch 的大小,在 3D 图中,颜色越深表示性能越好。当 meta 网络的采样批量小于基图网络时,模型性能更好。

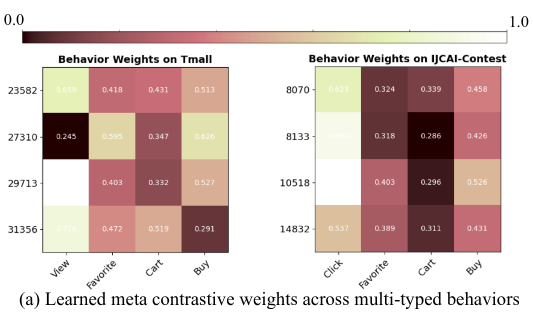

3.5 样例分析

我们采样了一些 CML 建模的用户,并可视化了 meta contrastive 学到的权重,它们表示了个性化的 user 多行为偏好。不同的 user 学到不同的 weights 表明该模块的有效性。

Embedding 可视化实验针对 CML 和 w/o-CLF,说明了 CML 在缓解数据稀缺问题方面的有效性并再次证明:多行为的 contrastive learning 框架的可以最大化行为间的互信息,引入自监督信号,进行跨不同类型行为的知识迁移。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧