CVPR 2022 | ViT版的Slimming来了,原作者团队打造,参数少,搜索更高效

极市导读

时隔 5 年,network slimming 原作者团队打造出了 ViT 版的 slimming,入选 CVPR 2022。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

卷积网络版的 network slimming 在 ICCV 2017 上被提出,作为神经网络剪枝领域代表性的工作之一,目前已被引用超过 1400 次,五年之后的 CVPR 2022,原作者团队跟 Meta、印度理工学院等机构的研究者联合打造了 ViT 版的 slimming,据悉该工作得到了四个审稿人一致推荐接收!

论文地址:https://arxiv.org/pdf/2201.00814.pdf

代码地址:https://github.com/Arnav0400/ViT-Slim

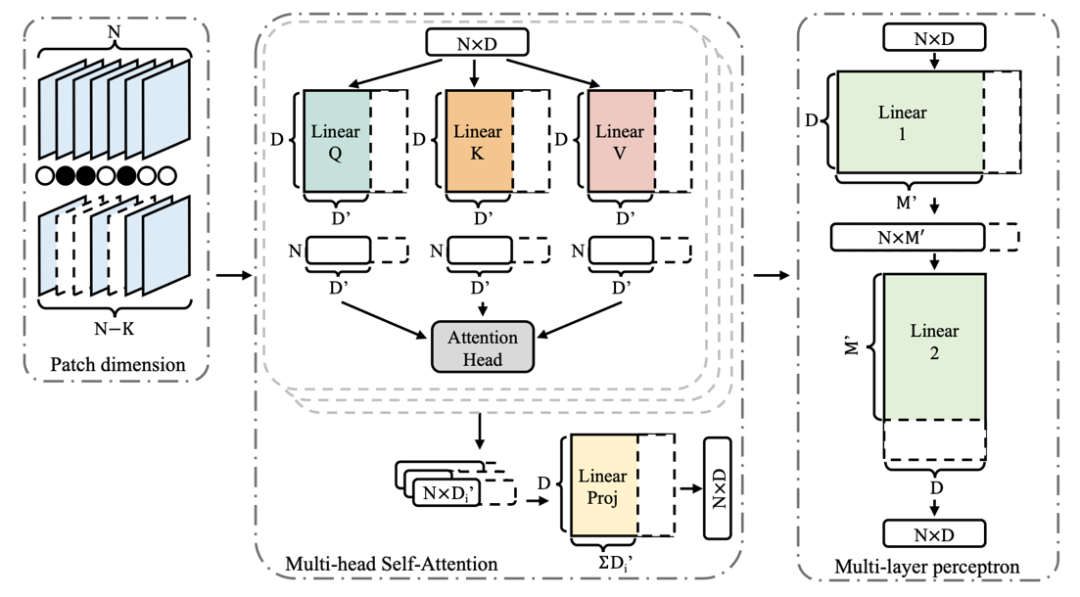

正则使得这些系数变得稀疏,同时作者发现由于通常会将卷积核与批量归一(BN)一起使用,因此可以直接使用 BN 层的缩放系数

正则使得这些系数变得稀疏,同时作者发现由于通常会将卷积核与批量归一(BN)一起使用,因此可以直接使用 BN 层的缩放系数

作为每层卷积的重要性系数,这样就不需要引入额外的参数了。

作为每层卷积的重要性系数,这样就不需要引入额外的参数了。

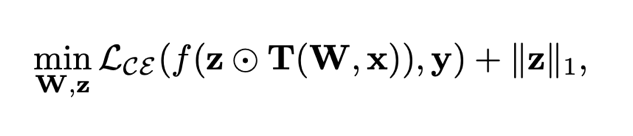

稀疏正则组成,如下所示:

稀疏正则组成,如下所示:

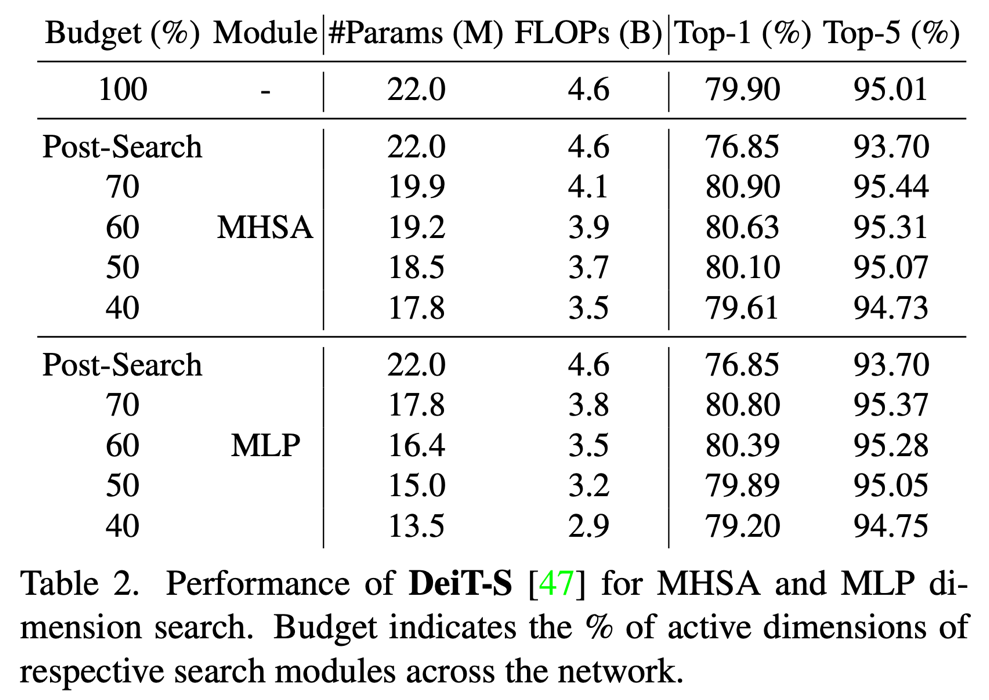

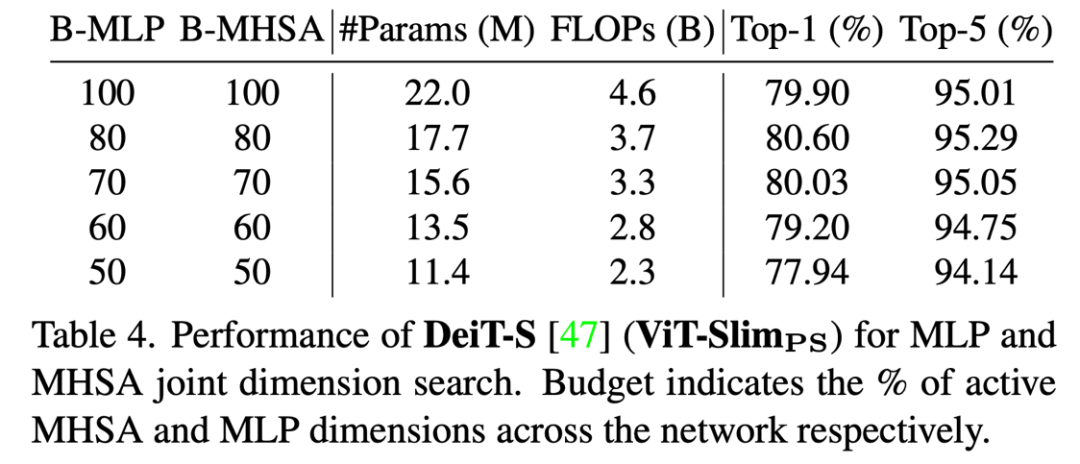

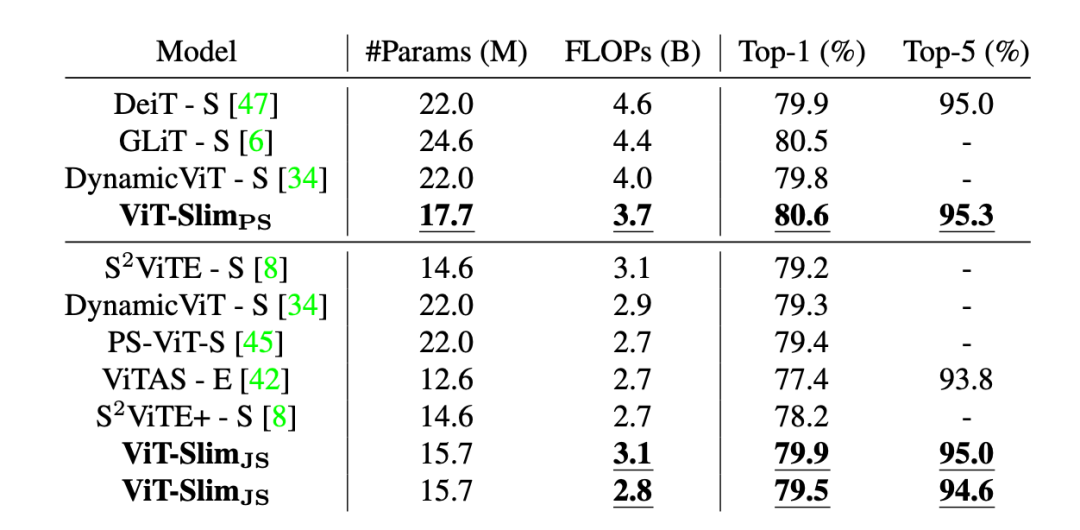

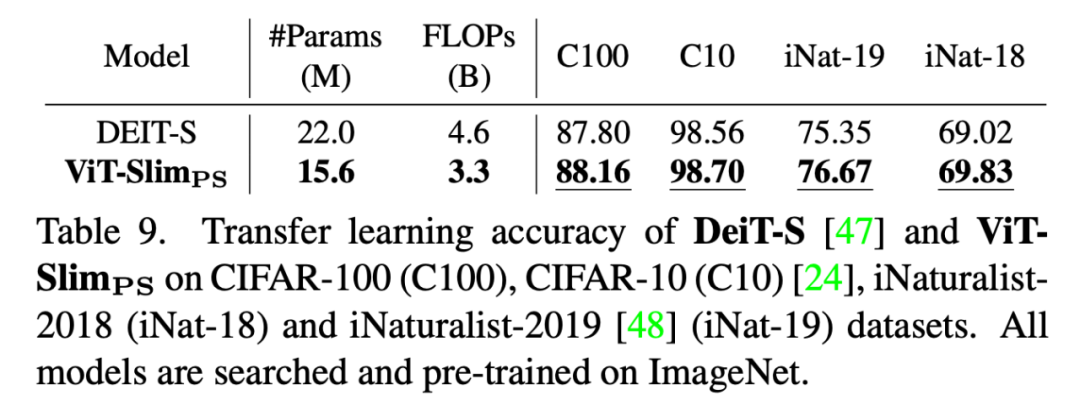

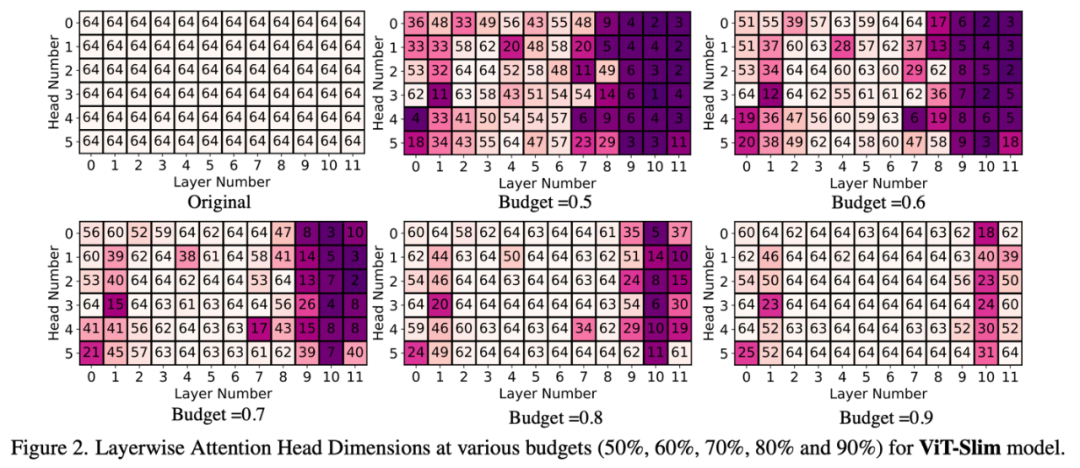

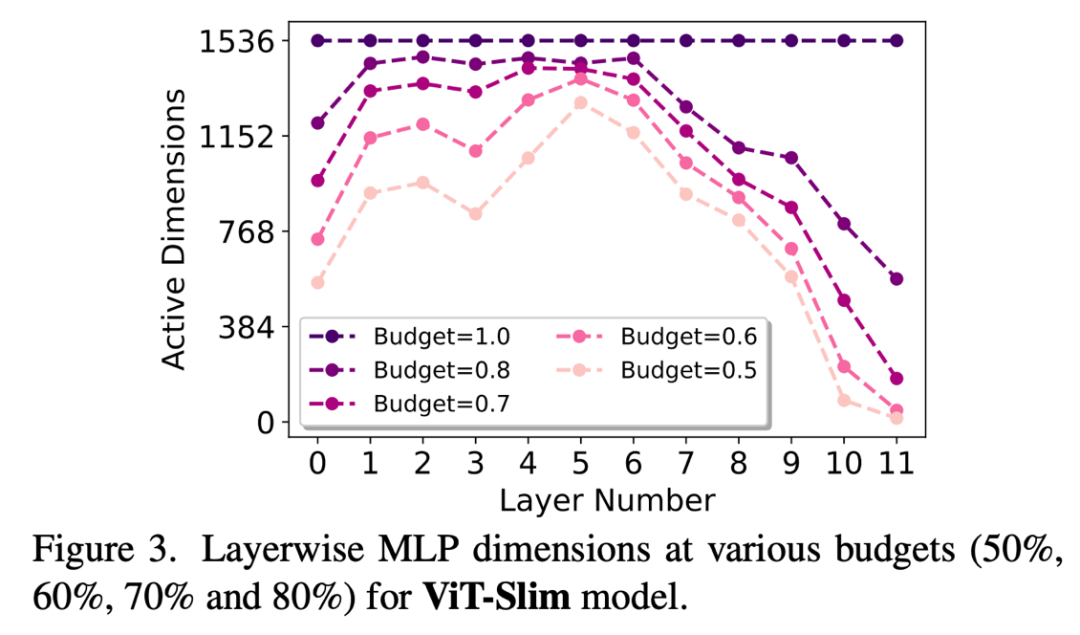

实验结果

公众号后台回复“数据集”获取90+深度学习数据集下载~

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~

登录查看更多

相关内容

Networking:IFIP International Conferences on Networking。

Explanation:国际网络会议。

Publisher:IFIP。

SIT: http://dblp.uni-trier.de/db/conf/networking/index.html

Arxiv

10+阅读 · 2018年5月10日