NeurIPS 2022 | 词嵌入表示参数占比太大?MorphTE方法20倍压缩效果不减

©作者 | 机器之心编辑部

来源 | 机器之心

天津大学量子智能与语言理解团队联合香港中文大学(深圳)共同发表论文《MorphTE: Injecting Morphology in Tensorized Embeddings》,该论文已被 NeurIPS 2022 接收。

引言

论文来源:

论文链接:

代码链接:

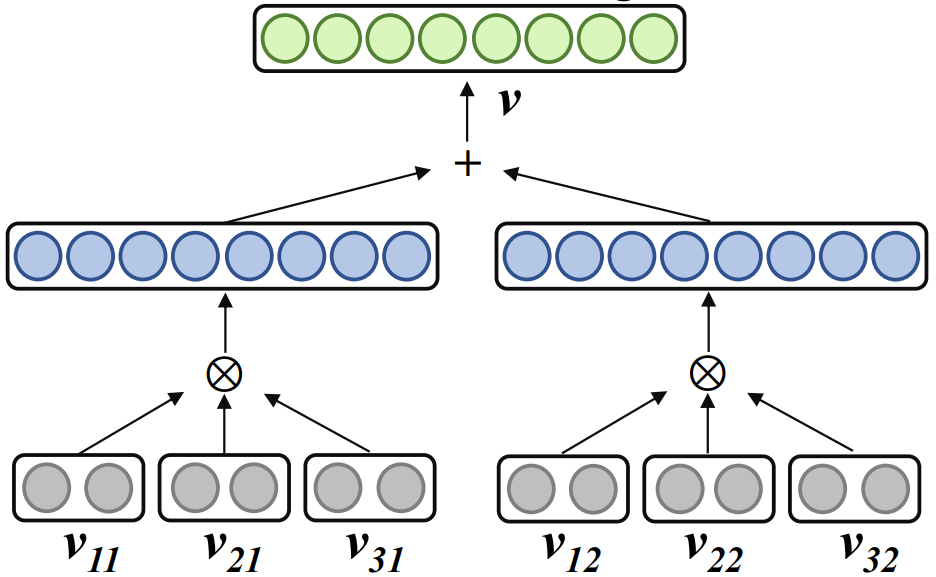

2.2 纠缠张量形式的词嵌入压缩表示

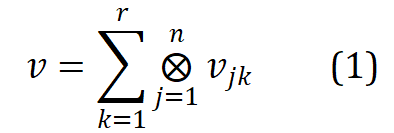

、r 为秩、n 为阶,

、r 为秩、n 为阶,

表示张量积。Word2ket 只需要存储和使用这些低维的向量来构建高维的词向量,从而实现参数有效降低。例如,r =2、n=3时,一个维度为 512 的词向量,可以通过两组,每组三个维度为 8 低维向量张量积得到,此时所需参数量从 512 降低至 48。

表示张量积。Word2ket 只需要存储和使用这些低维的向量来构建高维的词向量,从而实现参数有效降低。例如,r =2、n=3时,一个维度为 512 的词向量,可以通过两组,每组三个维度为 8 低维向量张量积得到,此时所需参数量从 512 降低至 48。

)。

)。

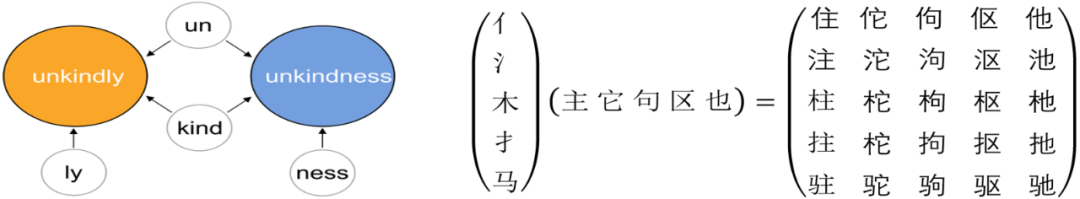

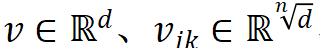

的语素索引矩阵,其中 n 是 MorphTE 的阶数。

的语素索引矩阵,其中 n 是 MorphTE 的阶数。

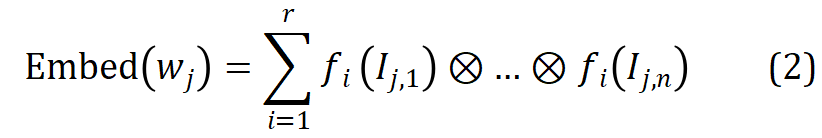

,利用其语素索引向量

,利用其语素索引向量

从 r 组参数化的语素嵌入矩阵中索引出相应的语素向量,并通过张量积进行纠缠张量表示得到相应的词嵌入,该过程形式化如下:

从 r 组参数化的语素嵌入矩阵中索引出相应的语素向量,并通过张量积进行纠缠张量表示得到相应的词嵌入,该过程形式化如下:

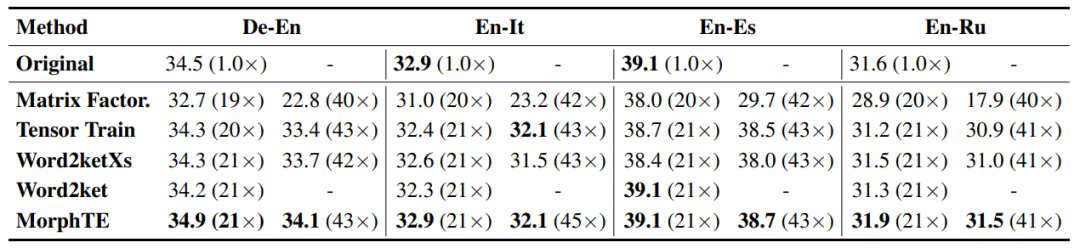

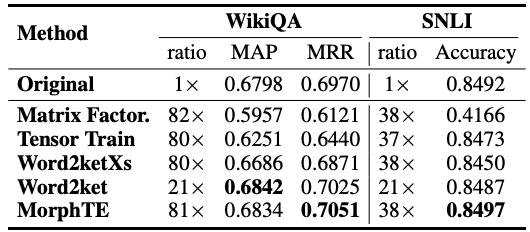

实验

结论

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

登录查看更多

相关内容

Arxiv

0+阅读 · 2023年1月2日

Arxiv

10+阅读 · 2019年9月15日