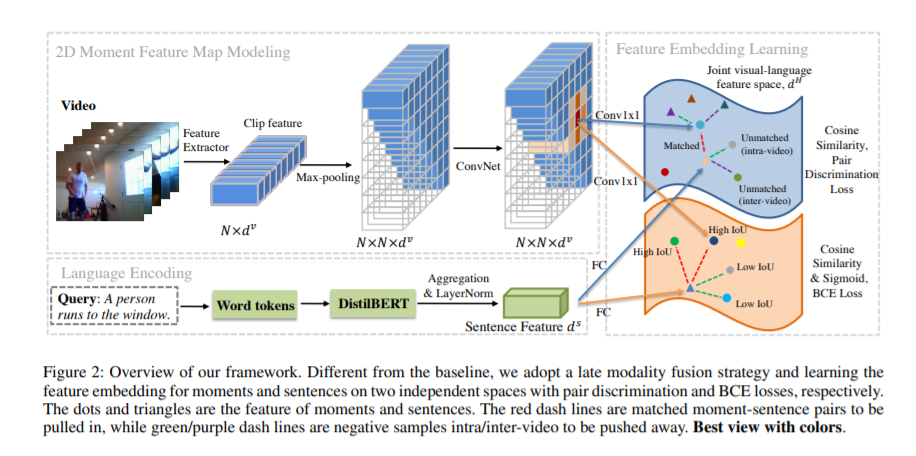

【AAAI2022】 负样本问题:时间基础度量学习的复兴

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“MMN” 就可以获取《【AAAI2022】 负样本问题:时间基础度量学习的复兴》专知下载链接

登录查看更多

相关内容

Arxiv

1+阅读 · 2022年4月20日

Arxiv

0+阅读 · 2022年4月19日