革命性计算架构突破:性能提高 200 倍;内存上可运行 AI 应用

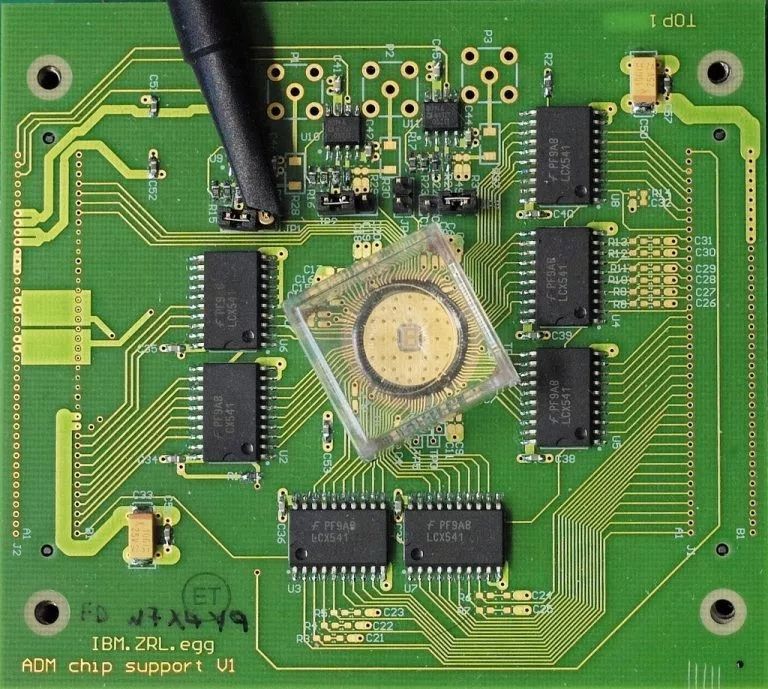

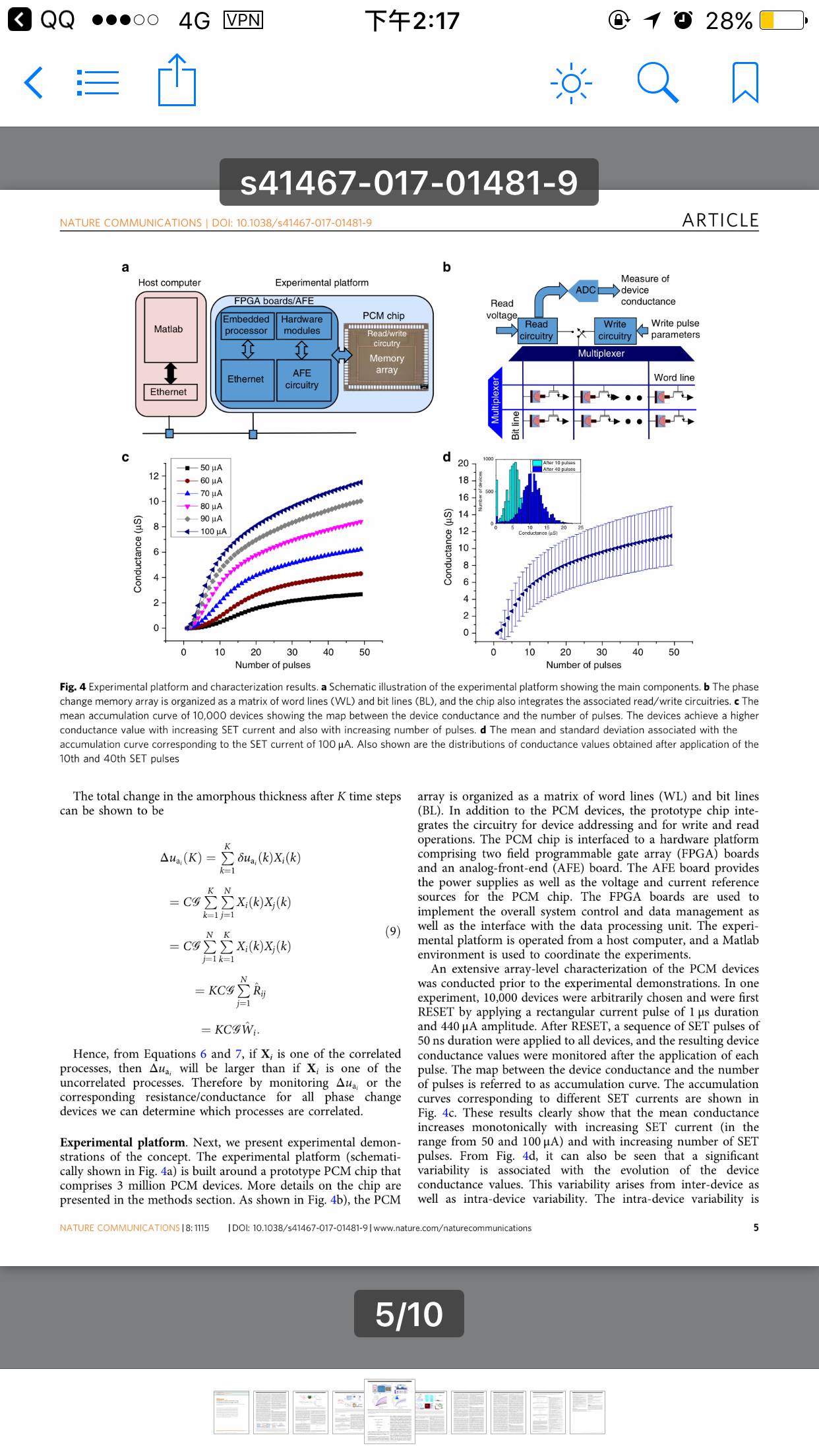

研究人员使用了用锗锑碲合金材料做成的PCM设备,这种合金材料包夹在两个电极之间。

“内存计算”(In-memory computing)或“计算型存储器”(computational memory)是一种新兴概念,使用了存储器设备的物理属性来存储信息和处理信息。这与目前的冯•诺伊曼系统和设备(比如标准台式机、笔记本电脑,甚至手机)恰好相反,后者在存储器和计算单元之间来回传输数据,因而使得它们运行速度较慢、能耗效率较低。

今天,IBM 研究公司(IBM Research)宣布其科学家演示了在100 万个相变存储器(PCM)设备上运行的一种非监督式机器学习算法,并在未知的数据流当中成功地发现了时间相关性(temporal correlations)。与目前最先进的传统计算机相比,预计这种原型技术会在计算速度和能源效率这两个方面提升 200 倍,因而能够做出人工智能方面大有用武之地的高密度、低功耗的大规模并行计算系统。

IBM 研究员、论文作者之一伊万杰罗斯•埃莱夫特里乌(Evangelos Eleftheriou)博士说:“这是我们在研究人工智能物理学的过程中向前迈出的重要一步,而这个研究方向的重心是探究新的硬件材料、设备和架构。”

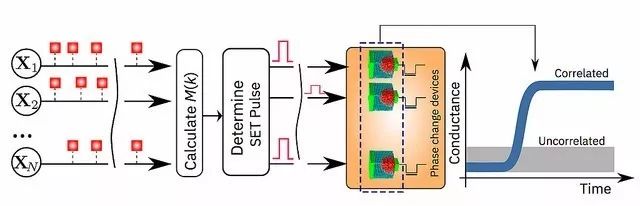

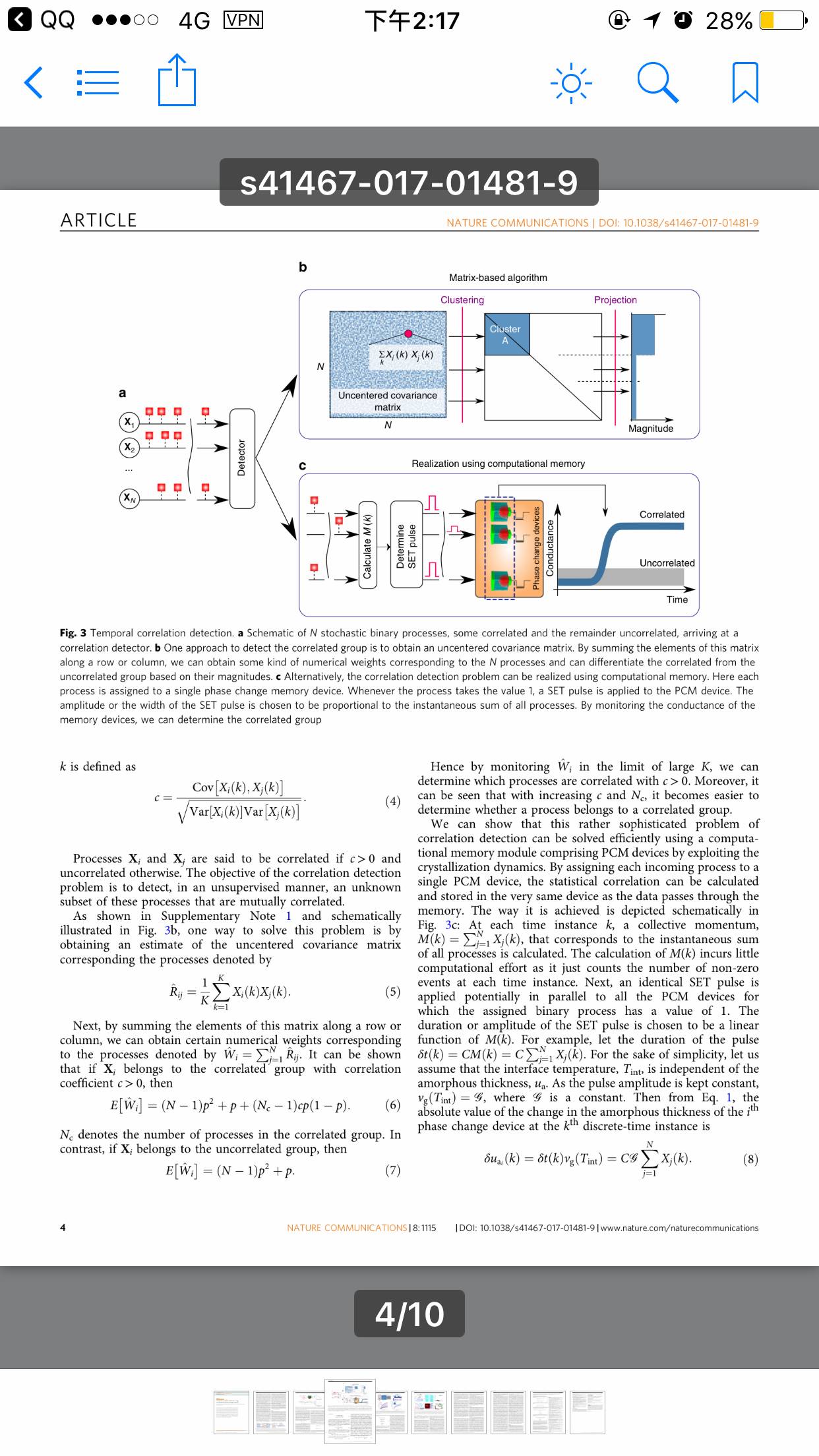

图2:内存计算算法的示意图。(图片来源:IBM研究公司)

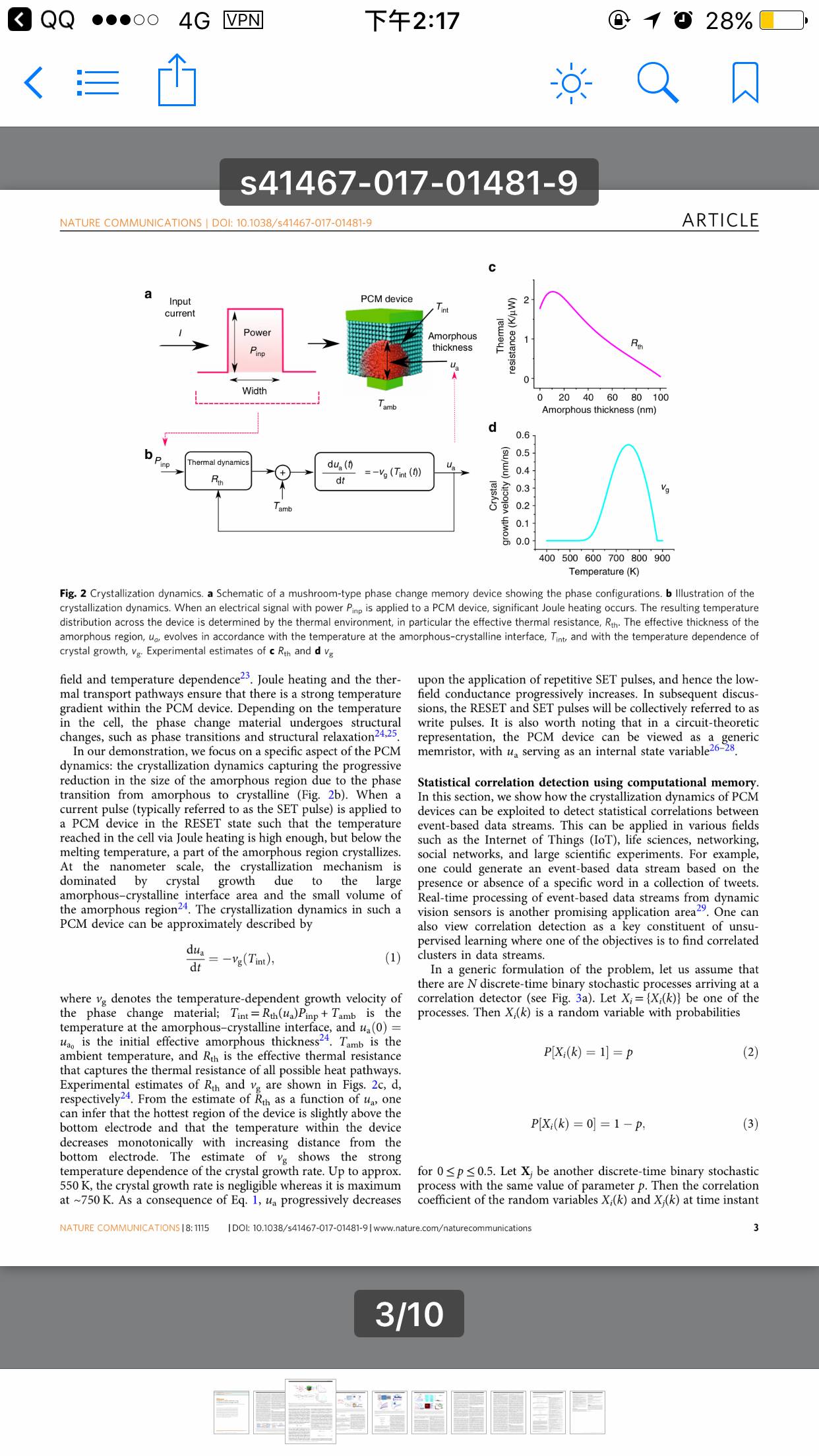

研究人员使用了用锗锑碲合金材料做成的PCM设备,这种合金材料包夹在两个电极之间。科学家对这种材料通上一股微弱的电流后,实际上起到了对材料加热的功效。材料受热后,状态从无定形(原子无序地排列)变成了晶状体(原子有序地排列)。IBM 的研究人员利用晶状体的特性,在合适的位置执行计算。

IBM 研究员、论文作者之一伊万杰罗斯•埃莱夫特里乌(Evangelos Eleftheriou)博士说:“这是我们在研究人工智能物理学的过程中向前迈出的重要一步,而这个研究方向的重心是探究新的硬件材料、设备和架构。由于CMOS递增定律因技术瓶颈而失效,为了避免如今计算机存在的局限性,我们需要彻底告别处理器-内存这种一分为二的体系。由于我们的内存计算方法具有简单性、高速度和低能耗等优点,我们的结果非常类似在冯·诺依曼计算机上运行的典型基准方法,这令人瞩目。”

IBM 研究公司今天发表在同行评审杂志《自然通讯》(Nature Communications)上的论文详细解释了相关细节:

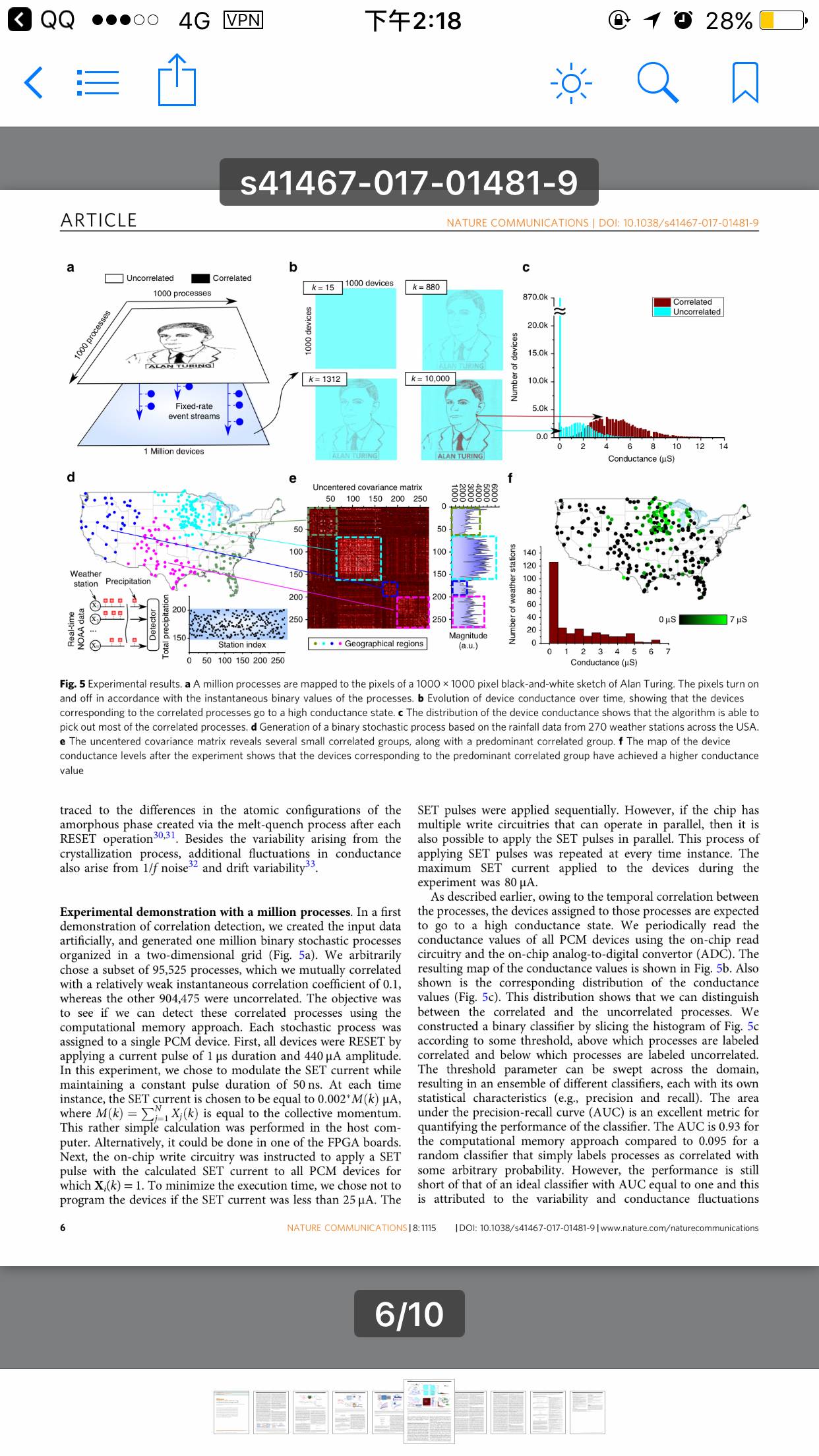

为了演示这项技术,论文作者选择了两个基于时间的例子,并将其结果与传统的机器学习方法(比如k 均值聚类)进行了一番比较:

论文作者:Nikolaos Papandreou、Evangelos Eleftheriou、Lukas Kull、Thomas Parnell(后排从左到右)和前排的Abu Sebastian及Manuel Le Gallo,唯独少了Tomas Tuma。

模拟数据:一个2D网格上排列组织的100万个二进制(0 或 1)随机进程,该网格基于1000x1000像素的英国著名数学家艾伦•图灵的黑白侧画像。然后,IBM科学家让像素以同样的频率闪灭,而以一种弱相关的方式让黑色像素闪灭。这就意味着,一个黑色像素闪烁时,另一个黑色像素也会闪烁的可能性略大一点。随机进程被分配给了100 万个PCM设备,并使用了一种简单的学习算法。每次闪烁,PCM阵列不断学习,与关联进程相对应的PCM设备进入到高电导状态。这样一来,PCM设备的电导图再现了艾伦•图灵的侧画像。

实际数据:过去六个月内从美国270 个气象站收集而来的间隔1小时的实际降雨量数据。如果1小时内降雨,标以“1”;1小时内没有降雨,则标以“0”。典型的k均值聚类和IBM 内存计算方法就270 个气象站中245个的分类达成一致。内存计算方法将12个气象站标记为不相关,而k均值聚类方法将它们标记为相关。与之相仿,内存计算方法将13个气象站标记为相关,而k均值聚类方法将它们标记为不相关。

阿布•塞巴斯蒂安(AbuSebastian)博士是IBM研究公司的探索性记忆和认知技术科学家,也是论文的主要作者。他说:“到目前为止,存储器还是被认为是仅仅用来存储信息的地方。而我们在这项工作中明确地表明,我们可以如何利用这些存储器设备的物理特性,还能执行相当高级的计算基元(computational primitive)。计算的结果也存储在存储器设备中;从这个意义上来说,其概念多少受到大脑计算方式的启发。”他还领导欧洲研究委员会资助的一个项目,以研究这个课题。

IBM科学家将在今年12月召开的IEDM大会上演示运用内存计算的另一项成果。

相关阅读:

一份 IT 合同从 570 万美元暴涨至 1.85 亿美元,IBM 赚翻了!