CSIG云上微表情第30期研讨会成功举办--计算机视觉与心理学中的面孔情感计算线索研究

微表情是一种短暂的、微弱的、无意识的面部微表情,持续时间往往在0.5s内,能够揭示人类试图隐藏的真实情绪。微表情识别的研究旨在让机器有足够的智能,能够从人脸视频序列中识别人类的真实情绪。然而由于微表情持续时间短、面部肌肉运动强度低,对其进行准确的表征与识别是一项极具挑战性的任务。为了促进心理学领域和计算机视觉领域针对微表情的进一步研究,由中国图象图形学学会(CSIG)和中国科学院心理研究所主办、CSIG机器视觉专业委员会和CSIG情感计算与理解专业委员会联合承办,中国科学院心理研究所的王甦菁博士组织了一系列云上微表情的学术活动。

-

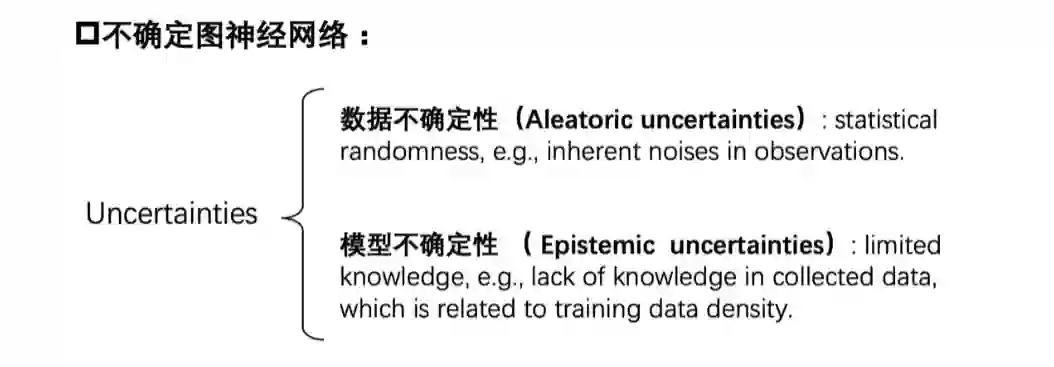

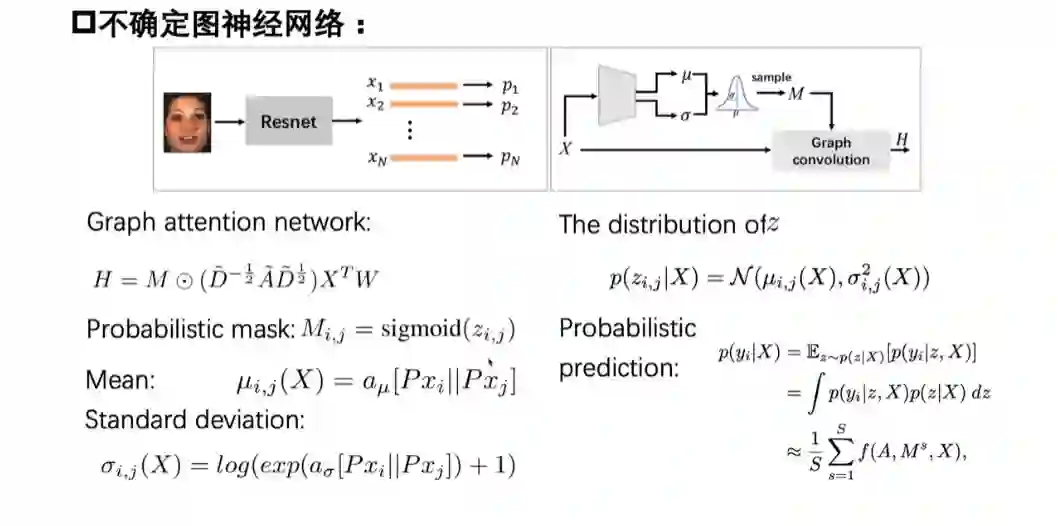

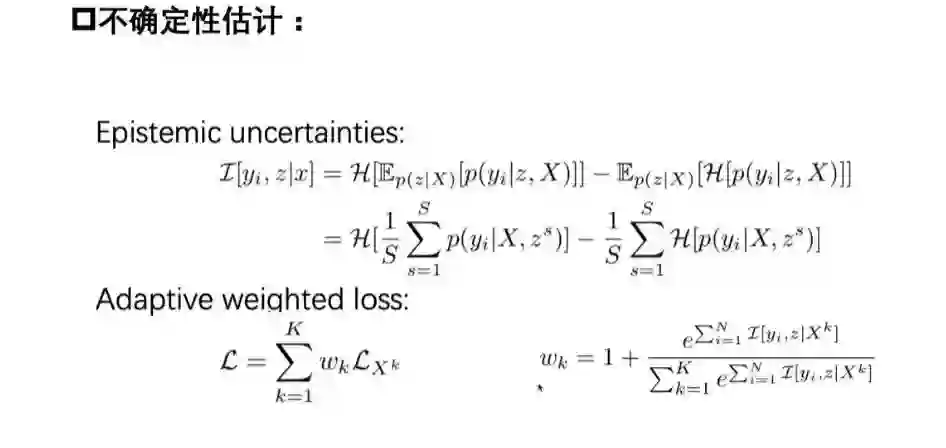

基于图神经网络的情感识别研究 - 东南大学的宋腾飞博士

此外,他们提出了一个基于认知的不确定性的自适应加权损失函数,在训练过程中自适应地改变训练样本的权重,以考虑到不平衡的数据在AU之间的分布。

宋博士等人还对不确定性与AU检测性能的关系进行了深入的分析。在两个基准数据集,即BP4D和DISFA上进行的实验表明,其所提方法达到了最先进的性能。

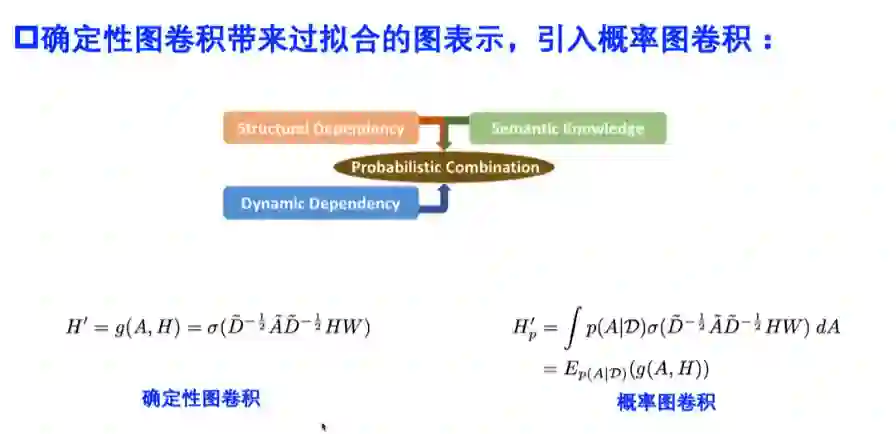

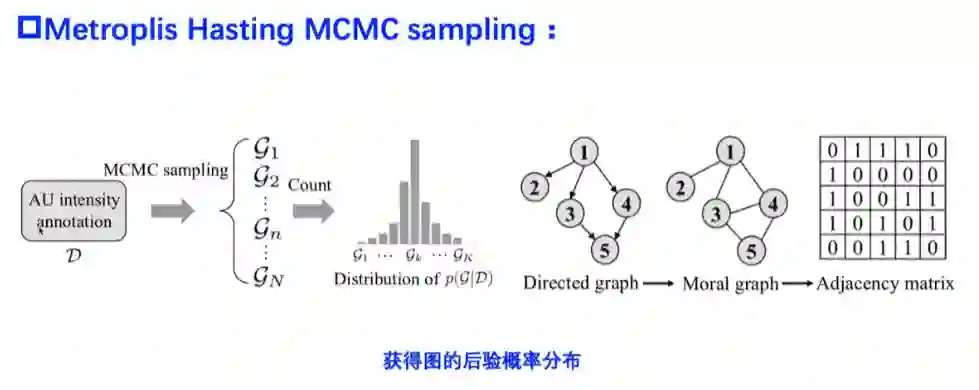

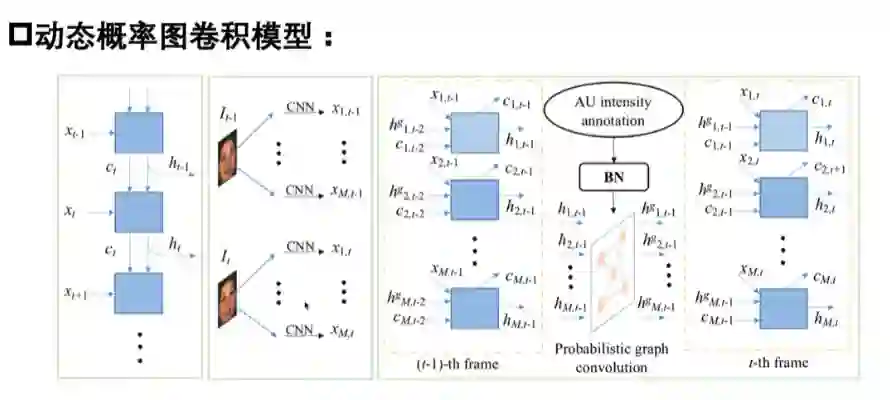

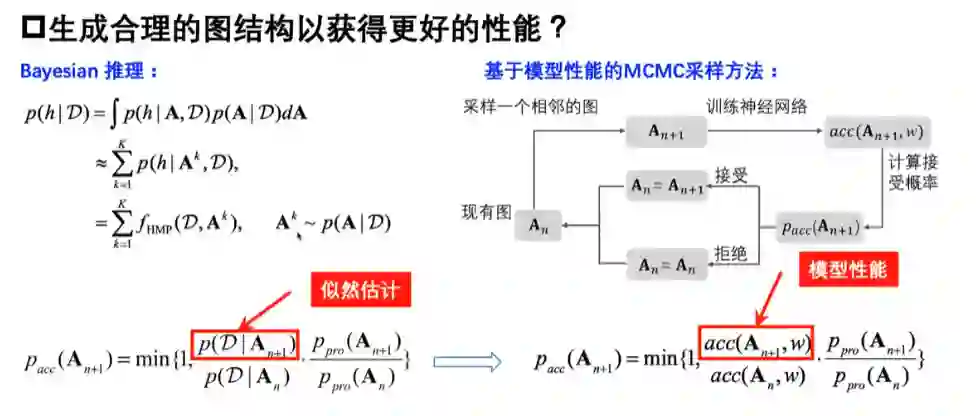

深度学习方法已被广泛应用于自动面部动作单元强度估计,并取得了良好性能。然而,这些方法大多是基于外观的,未能利用AU之间的潜在结构信息。宋博士等人提出了一个新的动态概率图卷积(DPG)模型,以同时利用AU的外观、AU的动态和它们的语义结构依赖来进行AU强度估计。首先,宋博士等人提出使用贝叶斯网络来捕捉AU之间的固有依赖关系。其次,引入概率图卷积,允许对贝叶斯网络结构的分布进行图卷积,以提取AU结构特征。

最后,宋博士等人引入了一个基于LSTM的动态深度模型,同时结合AU外观特征、AU动态特征和AU结构特征,以提高AU强度估计。

在实验中,宋博士等人所提方法在两个基准的面部AU强度估计数据库,即FERA 2015和DISFA上取得了与最先进的方法相当甚至更好的性能。

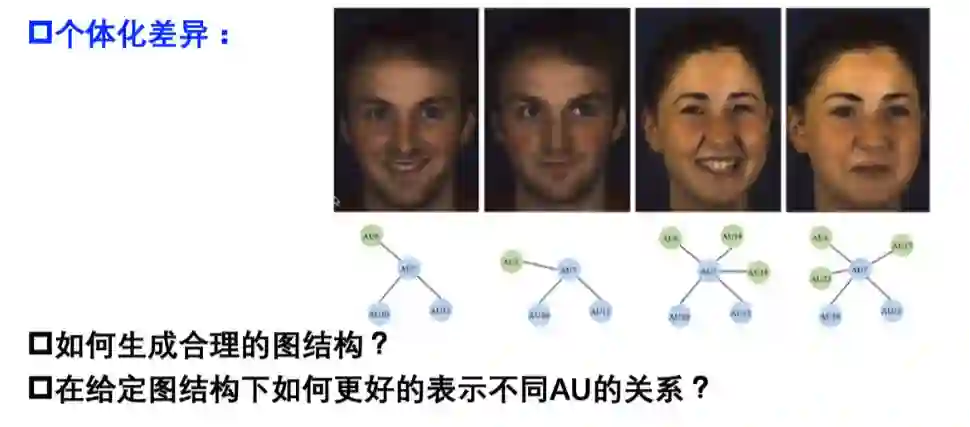

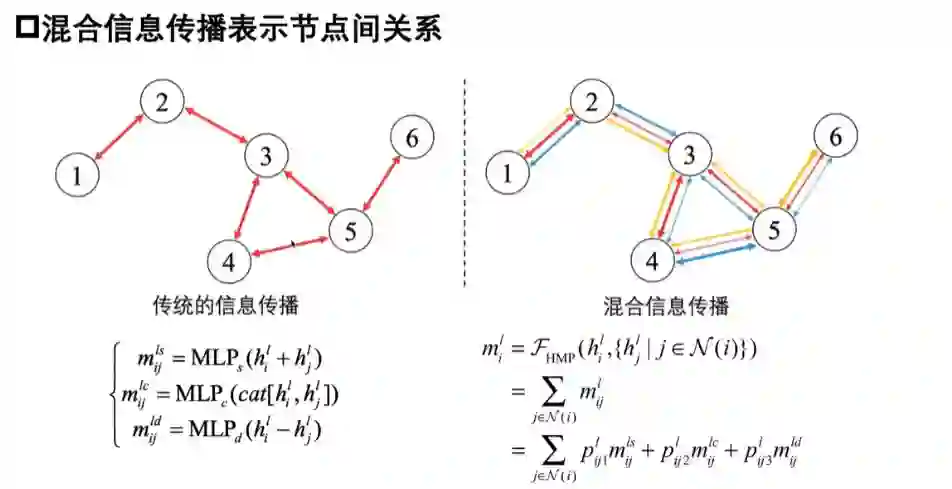

消息传递神经网络是一种有效的方法,通过传播消息来表示节点之间的依赖关系。然而,大多数消息传递算法都集中在一个结构上,并且消息是由一个单一的方法来估计的。对于现实世界的数据,如面部动作单元(AU),依赖关系可能因不同的表情和个体而不同。

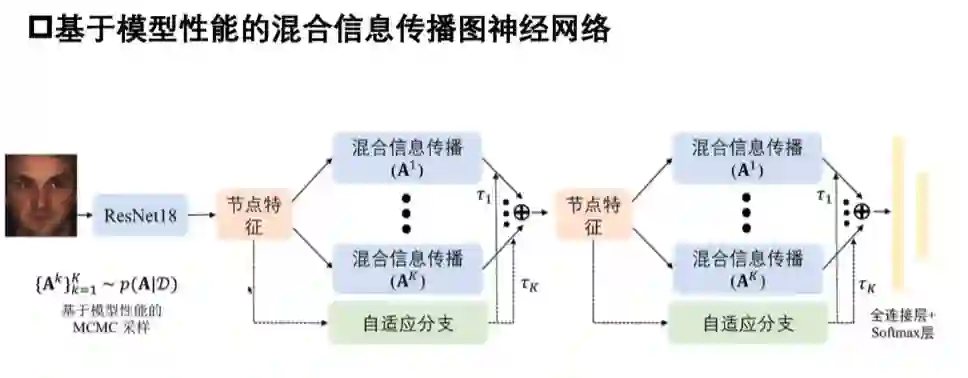

宋博士等人提出了一种新型的具有性能驱动结构的混合消息传递神经网络(HMP-PS),它结合了互补的消息传递方法,并以贝叶斯方式捕捉更多可能的结构。

特别是,宋博士等人提出了一种性能驱动的蒙特卡洛马尔科夫链采样方法,用于生成高性能的图结构。

此外,还提出了混合消息传递,以结合不同类型的消息,提供互补的信息。每种类型的消息的贡献是随着不同的输入而适应性地调整的。

在两个广泛使用的基准数据集,即BP4D和DISFA上的实验验证了其所提方法可以实现最先进的性能。

-

通过面部肌电信号探究微表情的强度特征-中国科学院心理研究所在读硕士生鲁绍愿同学

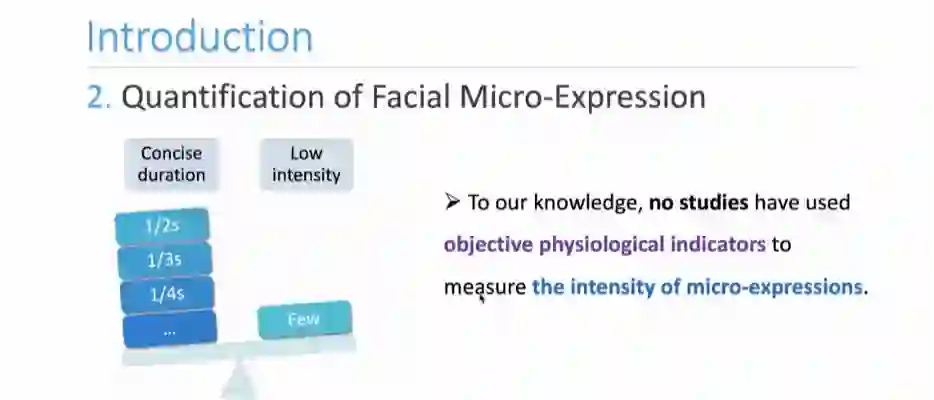

当前针对微表情特性量化的研究主要集中在其持续时间,而对其低强度动作特性的关注很少。鲁绍愿同学在王甦菁老师的指导下首次基于客观生理指标,即面部肌电信号,量化微表情的动作强度进行研究。相关成果:A more objective quantification of micro-expression intensity through facial electromyography,已被ACMMM2022 workshop FME接收。

鲁同学从引言、方法、数据分析、结果和讨论五个方面进行了汇报。首先,鲁同学简要介绍了微表情的定义和应用价值。不论是心理学还是计算机视觉领域关于持续时间的研究日益增加。但是,目前心理学中还没有使用客观的指标刻画微表情的强度的相关研究。由此我们思考,强度作为微表情的特征之一,是否也能被量化呢?

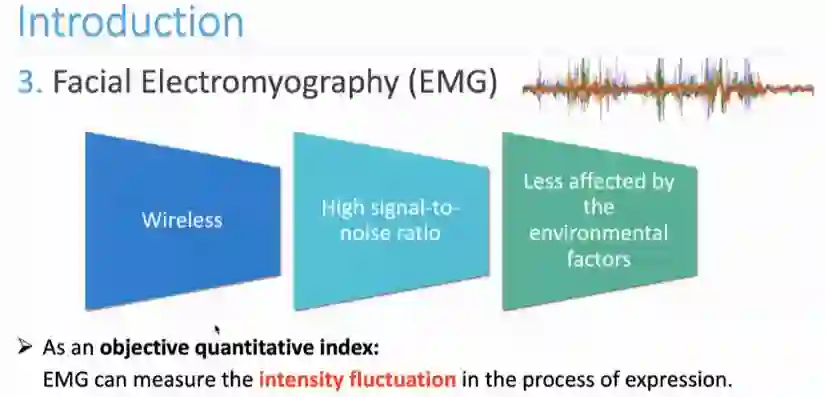

在微表情研究中,大多会使用面部表情编码对微表情的特征进行分析。使用最广泛的人工面部编码系统就是Ekman提出的FACS编码手册,在表情的AU强度编码中并没有明确的客观指标,而是通过定性描述将强度划分为5个不同的等级。这一编码方法对编码者的要求严格且非常主观和难以重复。

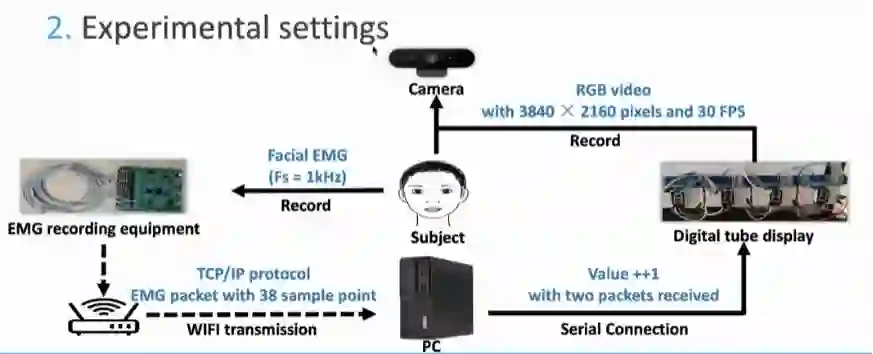

本研究选择了面部肌电信号EMG,试图通过这一生理指标来量化微表情的强度。EMG数据允许通过无线传输记录,具有信噪比高,受环境因素(如光照)影响较小等多种优点。作为一种客观的定量指标,面部肌电可以量化表情发生过程中的强度起伏,以直观的电信号形式呈现出来以便于后续分析。

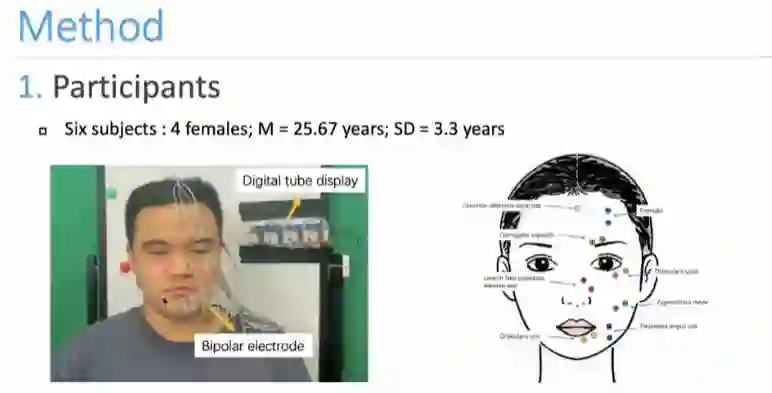

在方法的部分,鲁同学分别介绍了被试、面部肌电采集设备(电极片分布)和采集场景布置。

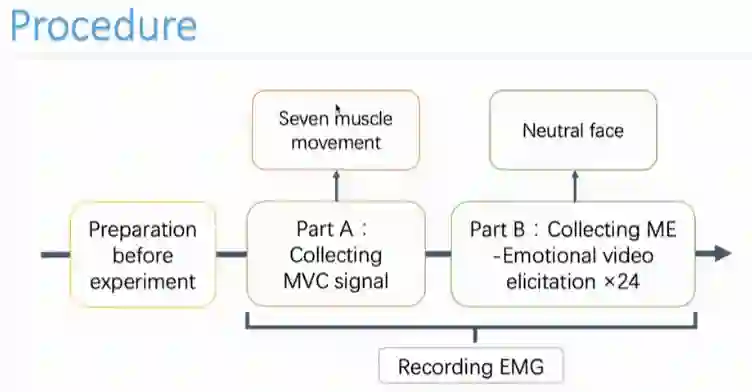

在具体流程部分,首先采集每个被试不同肌肉通道的最大自愿收缩(MVC),然后通过让被试观看情绪刺激材料,诱发微表情。

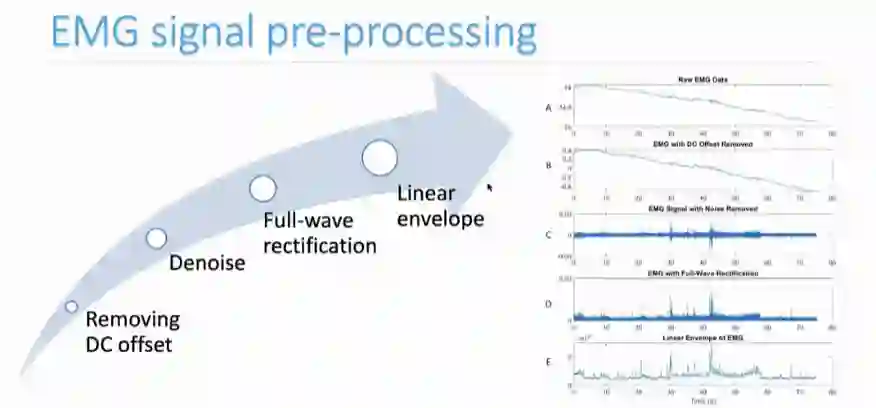

收集面部肌电信号后需要进行信号预处理,操作包括去除直流电干扰、滤波降噪、全波整流、线性包络四部分。

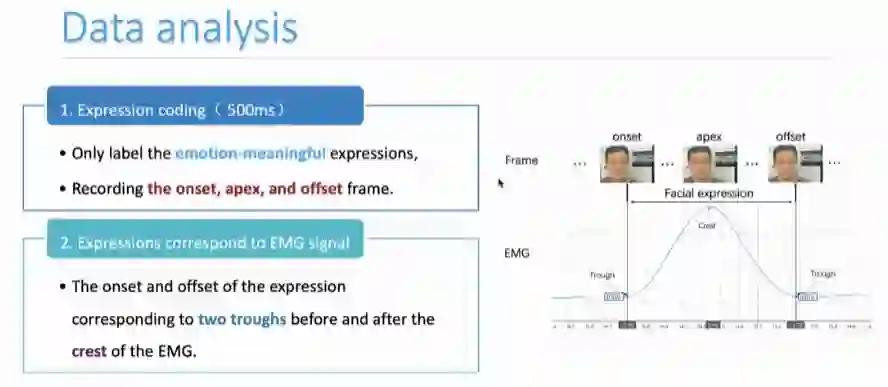

在信号预处理后,数据处理过程也分为两步,首先是对录像中面部表情进行编码,然后,根据表情标注出的时间区间,通过数码管对应到面部肌电信号,截取出对应的信号波,即为表情的面部肌电信号。

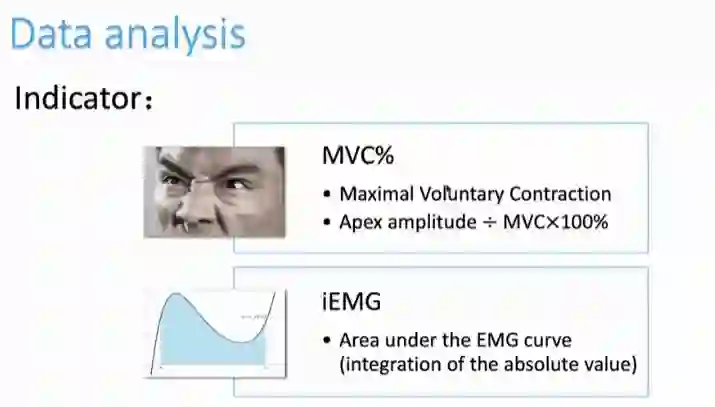

得到表情对应的肌电数据后,鲁同学等人对肌电信号选取了两个指标进行数据分析,分别是MVC%和iEMG。

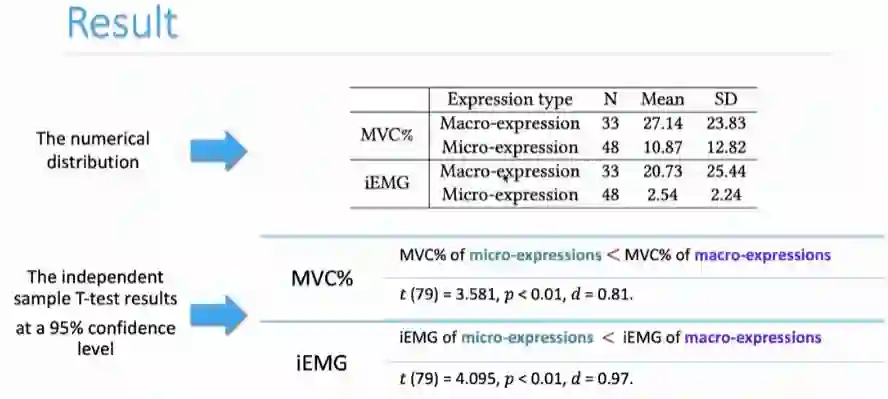

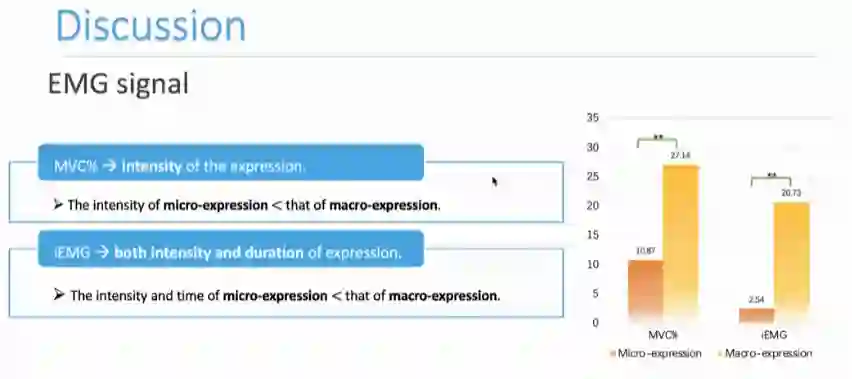

实验结果部分,鲁同学等人共得到81个具有对应肌电信号的表情数据,其中33个宏表情,48个微表情。在两个指标上的数据分布,如下表中所示。通过MVC%指标和iEMG可以看出,微表情在强度和时间两方面都要小于宏表情,统计分析也得到了显著差异。

但是如果想要通过肌电信号给出微表情和宏表情之间具体的强度界限相对比较困难。在后续的研究中,鲁同学等人将通过增加表情的样本量,探究体现在MVC%这一指标下的微表情具体强度范围。

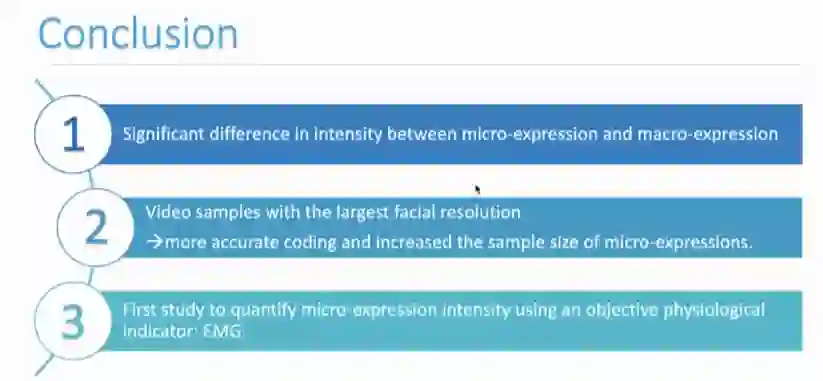

最后,鲁同学对报告进行了总结,并提出使用客观生理指标-肌电信号来量化微表情强度特征的研究是对微表情的生理机制研究领域,一个具有创新性方向的初步探索。

Lu, S., Li, J., Wang, Y., Dong, Z., & Wang, S. J. (2022, October). A more Objective Quantification of Micro-Expression Intensity through Facial Electromyography. In Proceedings of the 2nd Workshop on Facial Micro-Expression: Advanced Techniques For Multi-Modal Facial Expression Analysis.

在问答环节,听众和讲者们就AU协同与互斥的概率问题、量化微表情强度所需数据量、基于脑电的情感计算等技术问题进行了讨论。

在活动的最后,讲座的主持人李婧婷博士对活动进行了总结并对第三十一期CSIG云上微表情活动进行了预告。敬请继续关注!

此次讲座的回放已经发布在B站:https://www.bilibili.com/video/BV12F411A7j1?share_source=copy_web&vd_source=da367a2f90a1bbb21d8762ab6354d4ea,欢迎观看!

最后,中国科学院心理研究所微表情实验室(MELAB)诚聘博士后,微表情相关方向、计算机或心理学专业皆可,有意请联系王甦菁老师(wangsujing@psych.ac.cn)。