【ICML2021】利用最大化证据作为准则的预训练模型选择判据

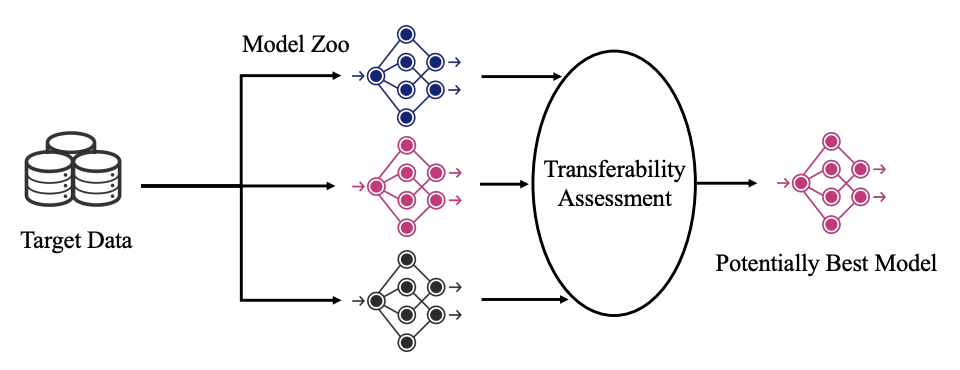

本文研究了任务自适应预训练模型的选择问题,这是一个有待探讨的问题,即如何评估预训练模型,以便在不进行微调的情况下从模型族中选择适合任务的模型。一项试点工作(Nguyen等人,2020年)解决了将有监督的预训练模型转移到分类任务中的问题,但它不能处理新兴的无监督的预训练模型或回归任务。

为了寻求一种实用的评估方法,我们提出了估计标签的最大证据(边缘似然),在给定预先训练模型提取的特征。与似然值相比,最大证据值不容易出现过拟合,而且通过我们精心设计的算法可以大大减少昂贵的计算量。最大证据对数(LogME)可以用来评估迁移学习的预训练模型:LogME高的预训练模型可能具有良好的迁移性能。LogME具有快速、准确、通用的特点,是第一个实用的迁移学习评估方法。相对于蛮力微调,LogME在时间上带来了超过3000倍的加速。它在设置上比以前的方法有很大的优势,并且适用于以前的方法不能处理的新设置。它对于不同的预训练模型(有监督的预训练和无监督的预训练)、下游任务(分类和回归)和模式(视觉和语言)来说是足够普遍的。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“LME” 就可以获取《【ICML2021】利用最大化证据作为准则的预训练模型选择判据》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年10月11日

Arxiv

0+阅读 · 2021年8月20日

Arxiv

3+阅读 · 2019年2月11日