CV大神何恺明最新一作:视觉预训练新范式MAE!下一个CV大模型要来?

新智元报道

新智元报道

编辑:David、桃子

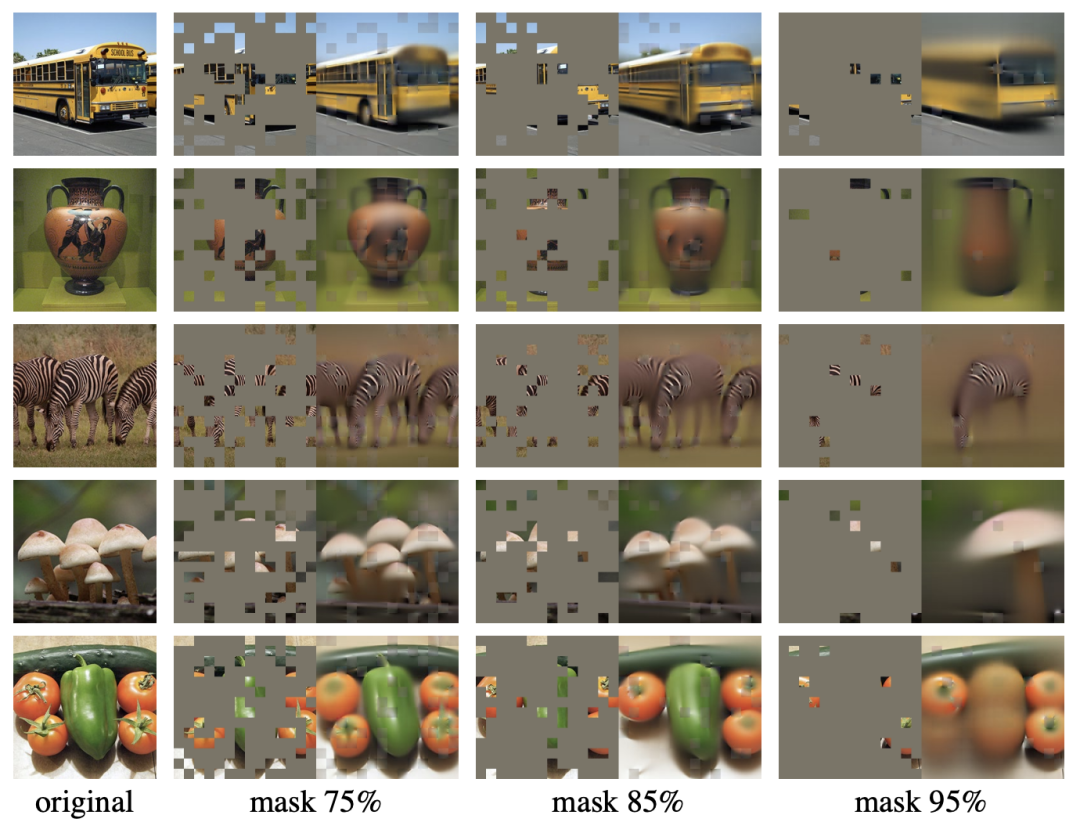

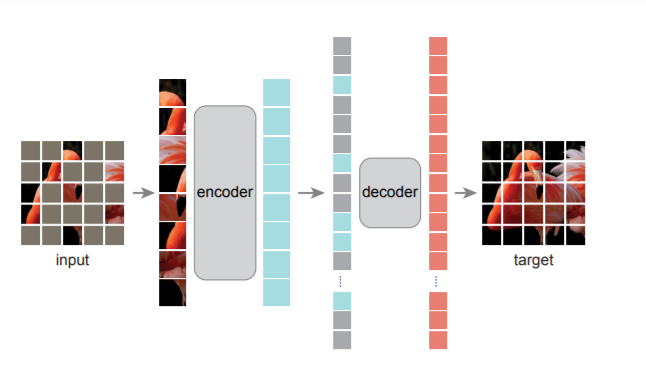

【新智元导读】CV大神何恺明又出力作!团队提出MAE模型,将NLP领域大获成功的自监督预训练模式用在了计算机视觉任务上,效果拔群,在NLP和CV两大领域间架起了一座更简便的桥梁。

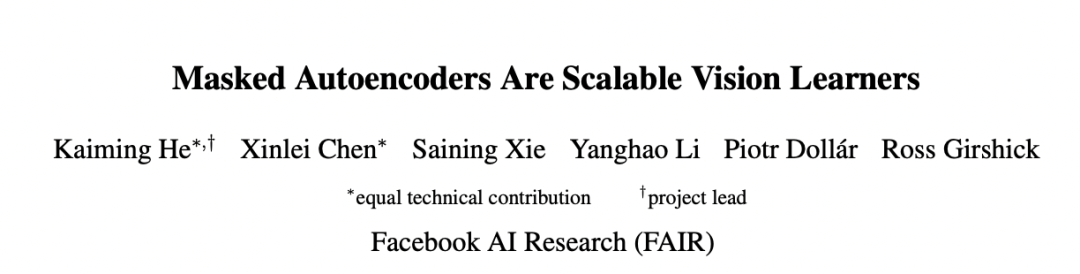

论文成果简介

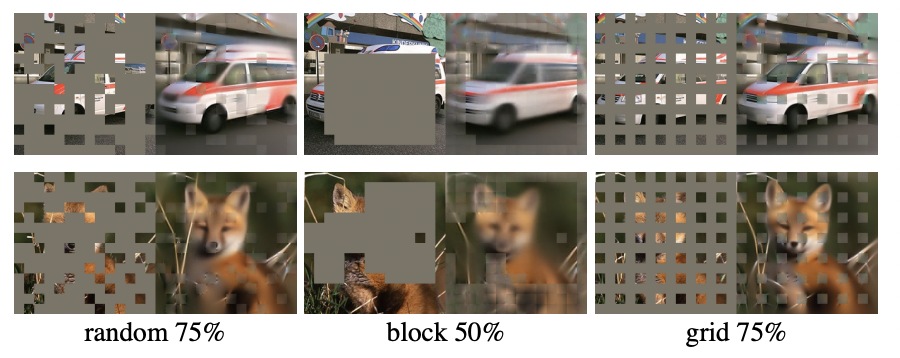

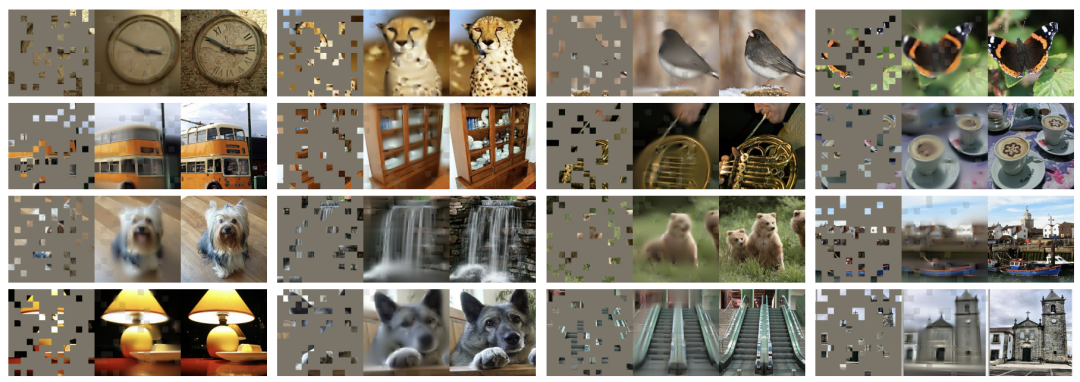

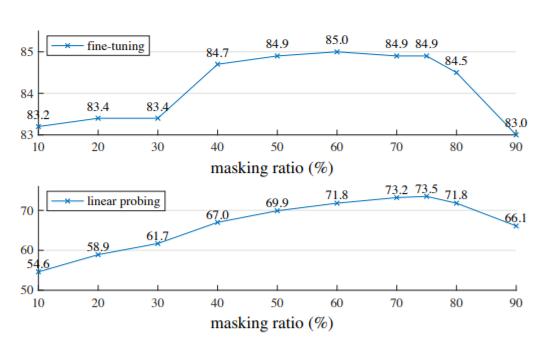

MAE模型结构与实现

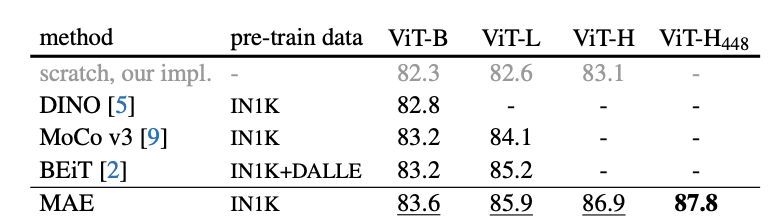

性能惊艳:ImageNet-1K最高87.8%

与当前SOTA自监督预训练方法相比,对于 ViT-B 的表现结果都很接近。对于 ViT-L不同方法的结果就存在很大差距,这表明更大模型的挑战是减少过度拟合。

网友:respect

「现在是2021年11月12日中午,恺明刚放出来几个小时,就预定了CVPR2022 best paper candidate(这里说的是best paper candidate,不是best paper)」

作者介绍

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月15日