ICLR 2022 | 对偶彩票假说!美国东北大学等提出DLTH:将随机子网络变换得到中奖彩票

极市导读

本文已被ICLR2022接收,来自美国东北大学,圣克拉拉大学和Meta的研究者提出对偶彩票假说(DLTH)。不同于彩票假说(LTH)验证了随机网络中存在好的子网络(中奖彩票),DLTH验证了在给定的随机网络中,随机的子网络都可以被转换成中奖彩票。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

稀疏网络训练一直是深度学习中训练神经网络的难点。随着网络规模和数据量的不断增加,训练成本也不断提升。如何有效的训练稀疏网络来维持合理的训练开销便十分重要。另一方面,找到有效的稀疏网络训练方法对理解神经网络的工作原理同样很有帮助。

近日,来自美国东北大学,圣克拉拉大学和Meta的研究者提出对偶彩票假说(Dual Lottery Ticket Hypothesis(DLTH))。不同于彩票假说(Lottery Ticket Hypothesis(LTH))验证了随机网络中存在好的子网络(中奖彩票),DLTH验证了在给定的随机网络中,随机的子网络都可以被转换成中奖彩票。文章已被ICLR 2022接收。代码已开源。

论文地址:https://arxiv.org/abs/2203.04248

OpenReview: https://openreview.net/forum?id=fOsN52jn25l

论文代码:https://github.com/yueb17/DLTH

相关研究:

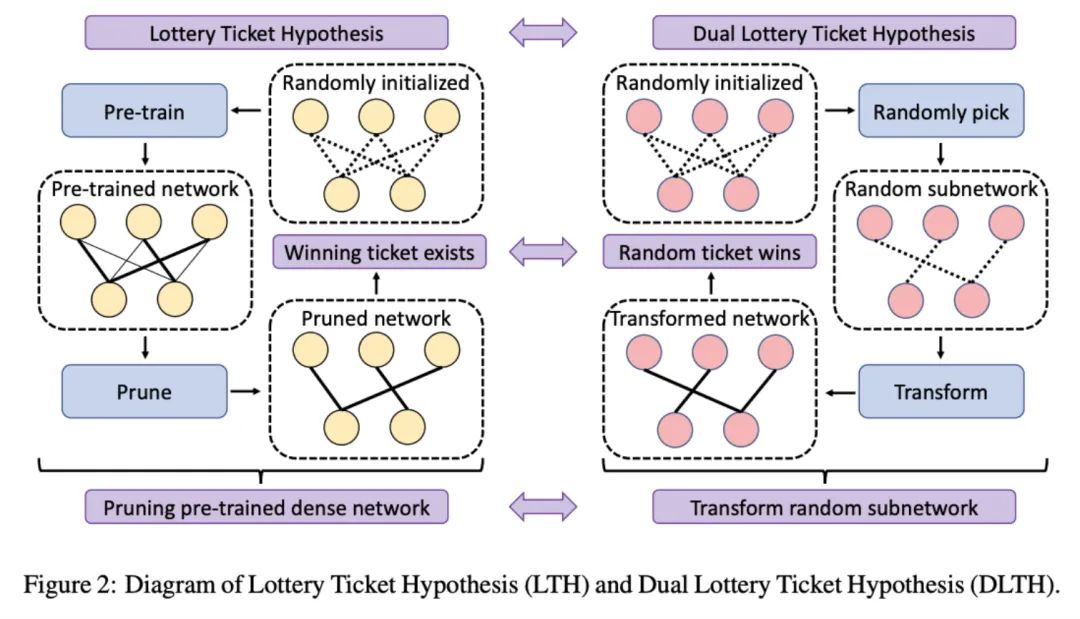

2019年,来自MIT的研究人员提出彩票假说(Lottery Ticket Hypothesis(LTH)):给定一个初始化网络,其中存在一个彩票子网络(winning ticket)在被单独训练的情况下达到很好的效果。这个子网络可以用传统的预训练加剪枝的方法得到。LTH还是用了iterative magnitude pruning的策略来找到更好的彩票子网络。LTH揭示了神经网络与其稀疏子网络之间的关系开启了一个研究稀疏网络训练的新方向。

给定随机初始化的神经网络,随机的子网络并不能达到理想的训练效果。而LTH中的彩票子网络是通过剪枝预训练网络得到的。但是LTH只验证了彩票子网络的存在性,并没有探索彩票网络的普遍性。相对应的,通过预训练加剪枝的方法找到的彩票子网络的结构是无法控制的。这同样限制了彩票网络在实际应用中的潜力。

对偶彩票假说:

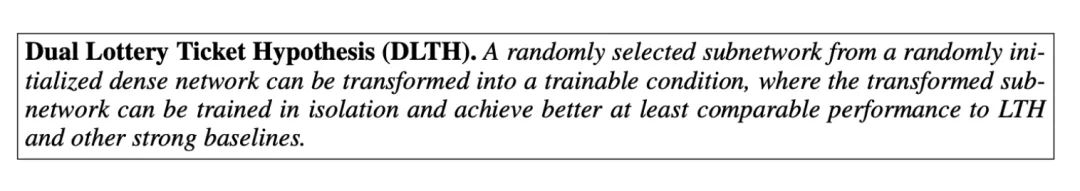

研究者受LTH所启发,探索了其对偶问题并提出对偶彩票假说DLTH:给定随机初始化的网络,其随机挑选的子网络可以被转换成彩票子网络,并得到与LTH找到的彩票子网络相当甚至更好的准确率。

DLTH与LTH的关系与比较如下图所示:

同时,DLTH提出了随机子网络变换(Random Sparse Network Transformation(RST))来验证提出的DLTH。

随机子网络变换(RST):

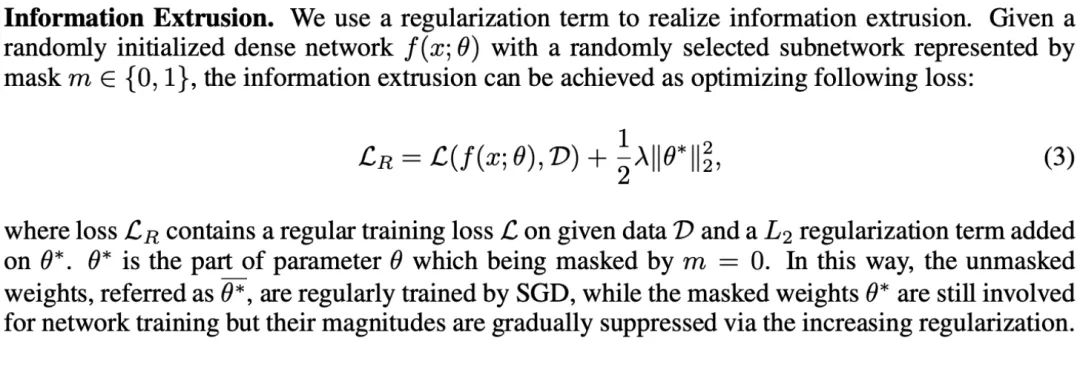

给定随机初始化网络并确定随机子网络结构,RST借助网络中其余的权重(masked weights)来帮助被选中的子网络(randomly selected sparse network)进行变换。形象的说,RST通过借助彩票池中所有的信息把一张随机彩票转换成了中奖彩票。RST通过训练完整的网络来完成。在训练过程中,RST通过在未被选中的权重上添加一个逐渐增加的正则项,从而这部分权重的幅值逐渐变小,这部分权重的作用也逐渐被抑制,并在变换结束之后完全去掉这部分权重。而被选中的子网络则进行正常训练。最终得到被转换好的稀疏子网络。这一过程可以理解为RST把信息从网络的其他部分挤到目标子网络中(information extrusion),如下图所示:

实验:

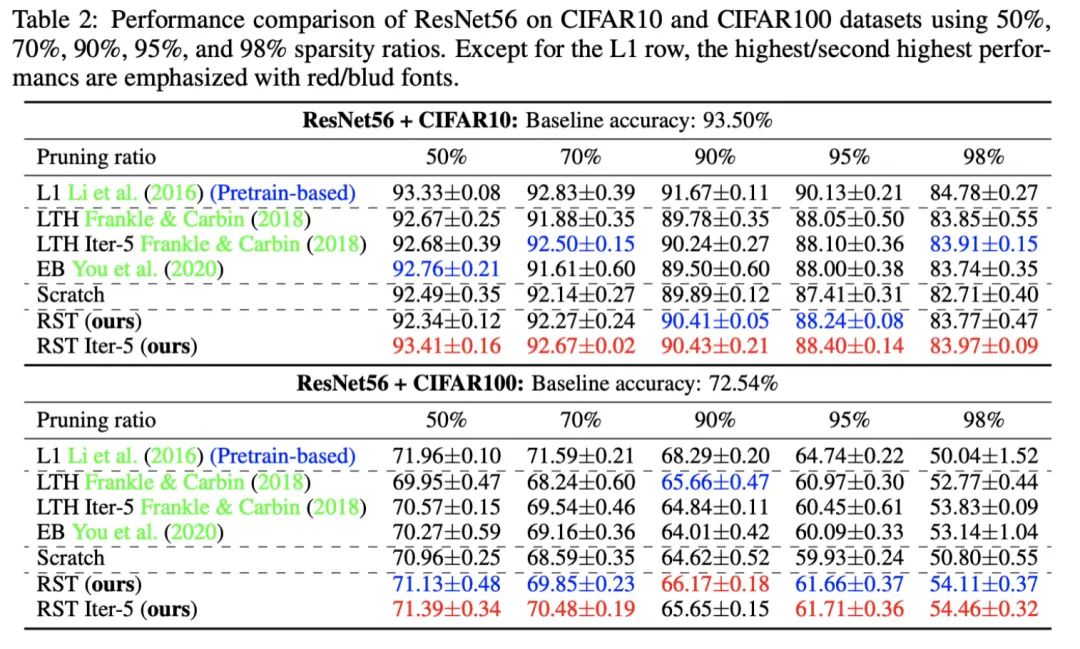

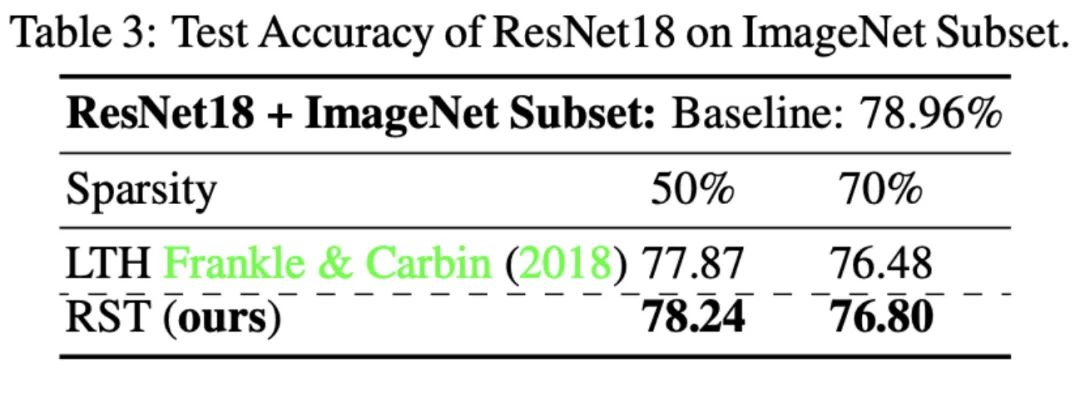

RST方法在cifar10,cifar100以及Imagenet 数据集上进行了测试。模型选择了ResNet56和ResNet18。对比方法包括LTH及其变体,预训练加剪枝,以及随机子网络scratch training。实验结果如下图所示。

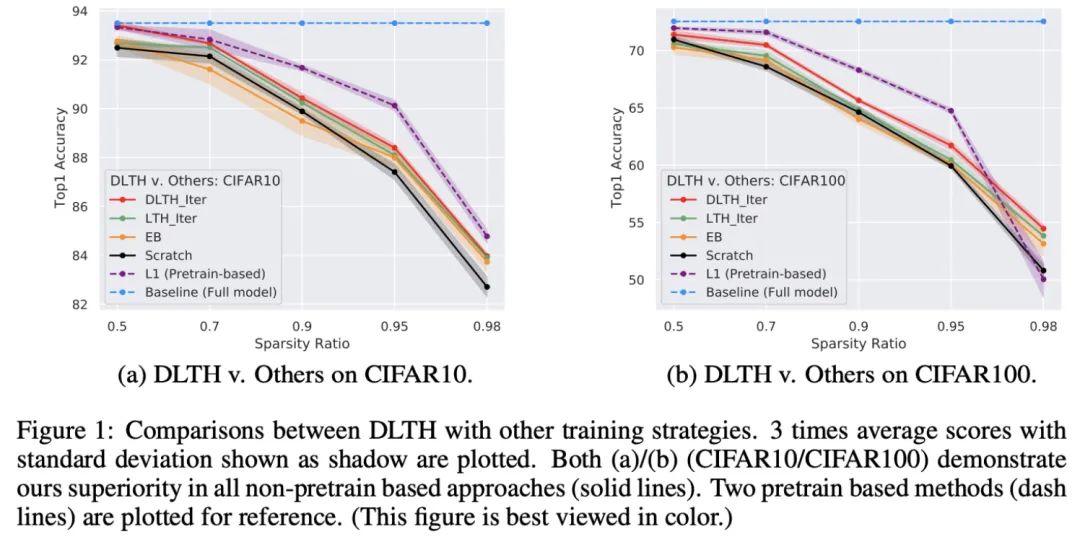

作者发现RST方法相比较于LTH,普遍可以得到更好至少相当的结果,无论使用one-shot的策略或者iterative的策略。因此,所使用的RST很好的验证了文章提出的DLTH。直观的比较如下图所示。

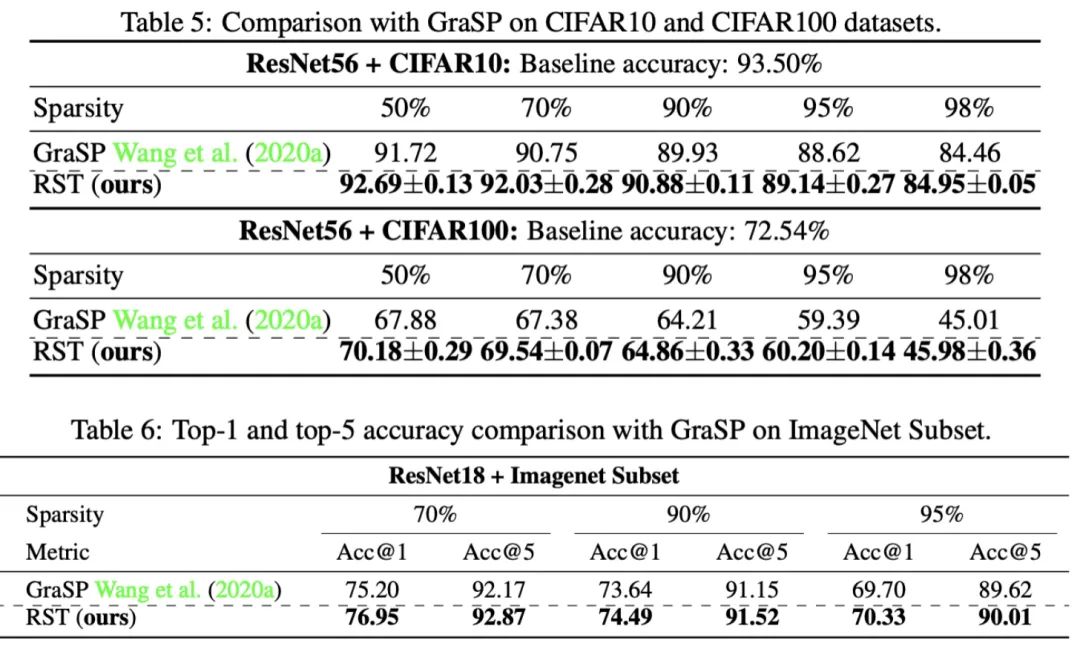

对比Pruning at Initialization(PI):PI同样在随机网络中选择子网络进行训练。因此,PI相关的研究同样也是重要的对比方法。文章中,作者选择了Gradient Signal Preservation (GraSP)作为PI方法的代表,与提出的RST进行比较。具体结果如下图所示。

实验结果表明相比较于GraSP,RST方法普遍取得了更好的效果。

结论:

本文从彩票假说(LTH)的研究视角出发,提出其对偶形式:对偶彩票假说(DLTH),从更广泛的角度探究了神经网络与其稀疏子网络之间的关系。相应的,文章提出了随机子网络变换(RST)的方法来验证DLTH。在benchmark数据集与网络上和众多对比方法的比较表明RST方法有效的验证了文章所提出的对偶彩票假说(DLTH)。

公众号后台回复“数据集”获取火焰和烟雾图像数据集下载~

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~