复旦大学张军平:深度学习,你就是那位116岁的长寿老奶奶!

2015年有条新闻,当年116岁的纽约布鲁克林老太太琼斯接受采访。记者问其养生之道,告之,每天早餐吃四片培根。没错,就是“知识就是力量,法国就是培根”里的培根。

这种另类的长寿秘诀在百岁老人中似乎并非个例。美国一著名的搜索“令人惊奇事件”的网站曾特地搜罗过,比如百岁老人英国人多萝西·豪喜好金铃威士忌和每天抽15根超级帝王香烟,1997年辞世的122岁老人让娜·卡尔芒每周会吃约1公斤的巧克力,美国沃思堡的104岁老人伊丽莎白·沙利文喜欢每天喝三厅“碳酸”饮料,美国密歇根州104岁的特雷莎·罗利每天一瓶无糖可乐。国人也能找到类似的例子,比如在湖北蔡甸城关肖家164号的102岁长寿太婆周如英从80岁开始每天一升可乐。2014年台北110岁的老太太林黄玉珍特别喜欢喝红酒、薯条。

为什么明明不符合共识的养生之道却能奏效呢?这其中有个统计的解释。共识的养生之道是通过归纳的方式总结的经验。归纳是由一系列具体的事实概括出一般原理。在数学上,则是从众多个别的事物或样本中概括出一般性的概念、原则或结论。归纳追求的是统计上的共性、平均,关心的也不是个例上的特定品质。既然是共性、平均,他自然会光滑掉某些成功的长寿个例的品质。其次,在统计或归纳的时候往往是基于共同的结构,而不会过多地考虑甚至会忽略个体间差异。所以,如果过分地相信统计和归纳,就可能陷入一个误区,认为这些个例是不合理的。

从这个角度看,近年来引发第三波人工智能热潮的深度学习就像是那位116岁的长寿老奶奶,而深度学习之前的做法则像是共识的养生之道。

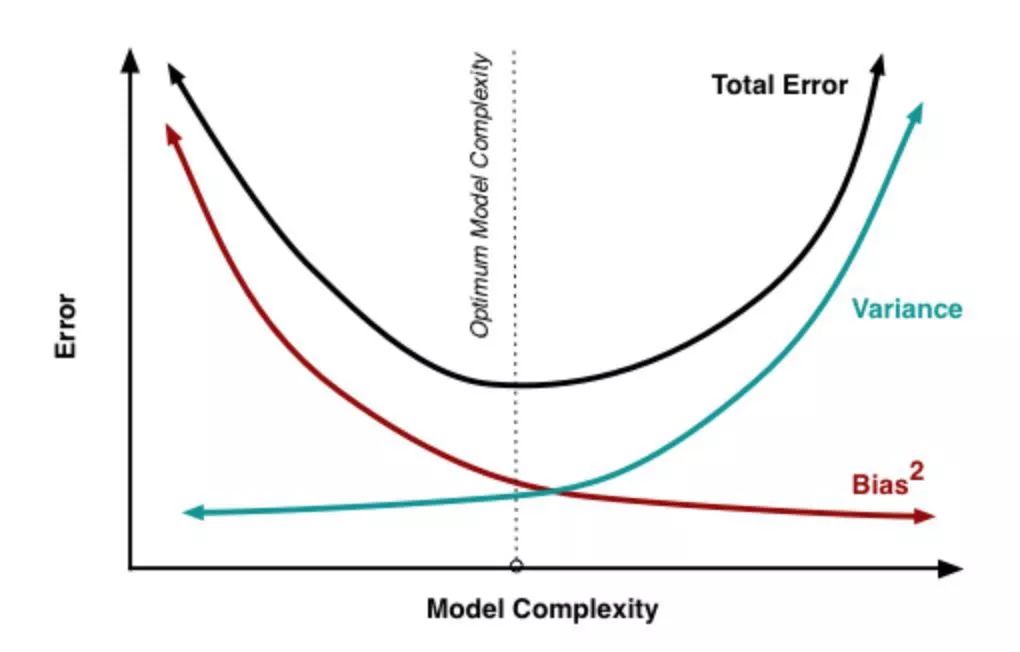

那么以前的“养生之道”是怎么玩的呢?以预测任务为例,我们的目标是希望学习到的模型在预测未知目标时越精确越好。但放在统计学习框架下,我们会碰到模型复杂性问题。这一问题的来源在于,设计的每个模型离真实的模型之间总会有偏差的存在,同时,模型的参数会导致其模型自身在寻优时存在波动,即会产生方差。因此,从统计意义来讲,一个好的模型需要在偏差和方差之间寻找平衡,如图1所示。在深度学习未包打天下之前的年代,这种平衡往往是通过控制模型的复杂性来获得的。对于复杂性的认识,这几十年来一直在变迁中。有通过控制模型的参数数量来实现的,如贝叶斯信息准则、Akaike信息准则;有从信息论的编码长度角度出发的,如Kolmogrov引出的最小描述长度,面向聚类的最小信息长度;有从数据几何结构出发的,如限束空间光滑性的流形约束;有从稀疏性角度出发的,如惩罚模型系数总量的L1范数;还有从模型结构的推广能力进行惩罚的,如统计机器学习中曾经盛行一时的VC维、最大边缘等约束。

图1:横坐标:模型复杂性;纵坐标:误差;红线:偏差;绿线:方差;黑线:总体误差;虚线:最优模型复杂性

不管是哪种复杂性,都是希望在统计意义下,从某个侧面去逼近真实世界的局部甚至整体,获得在其假设下的理论最优解。因为是归纳求解,解通常是稳定的,不会出现多少异类。

那么,深度学习又是怎么玩的呢?不管采用什么样的结构,深度学习最明显的特点就是模型深,参数多。自2006年深度伯兹曼机的提出至今,残差网、稠密网、Inception网等各种深度学习模型的可调整参数的数量都在百万级甚至百万级的百倍以上。这带来一个好处,即他能表达一个远大于原有空间的空间,学术上称之为过完备空间。一般来说,在这个过完备空间上寻找不符合统计规律、但却具有优良品质的个例的机会就显著增大了。

那么为什么以前不做呢?一方面之前没有那么大规模的数据量,另一方面以前的工程技术也不支持考虑这么大规模的模型。目前多数已知的传感器成本降了不少、各种类型的数据获取成本也下来了,所以能看到PB级甚至ZB级的数据,如图像、语音、文本等。实在找不到数据的领域,还可以通过14年提出的生成式对抗网络来生成足够逼真的、海量的大数据。这两者都使得训练好的模型在刻画这个过完备空间的能力上增强了不少。

其次,工程技术上的革新也推动了深度学习的成功。深度学习的前身如多层感知器或其它神经网络模型在利用经典的反向传播算法调整模型的参数时,往往会陷入局部极小、过度拟合、会存在调参停滞的梯度消失、梯度爆炸等问题,还缺乏处理大规模数据需要的并行计算能力。这些问题,在近10年的深度学习发展中或多或少都得到了部分解决,比如通过规一化来防止梯度消失的Batch Normalization(批规范化)技术,考虑增强网络的稳定性、对网络层进行百分比随机采样的Drop Out技术,还有数据增广技术等。这使得深度学习在这个过完备空间搜索具有优良品质的个例的算力得到了显著增强。

那么,能找到这些个例吗?当然可以,只要足够耐心,模型的参数空间能够过完备的超过原任务空间的大小,总有办法通过精细调整模型的参数去幸运地找到这些个例,而且这些个例显然不会只止一个。现有的深度学习在软硬件两方面都可以以大概率保证找到一群“116岁的长寿老太太”。这对于产业界来说,是件好事。因为产业界追求最优性能,而非统计意义上的平均性能。所以,不管你是白猫还是黑猫,只要能捉老鼠都是好猫。这大概就是现在深度学习成功的原因之一。

但是,有得必有失。既然寻找的是个例,过完备空间又不小,寻找的过程自然多少需要点运气。另外,它也不是纯粹的统计或归纳,也就没办法形成稳定性的、具有共识的“养生之道”,甚至从中归纳出一套类似于“模型复杂性”的合理理论都有可能难以下手。如果硬要找的话,也许可以考虑下墨菲定律。

所以,从统计角度来看,尽管是追求共识之道,但统计也并不排斥特例的存在。喜欢找特例的,就找好了。但需要注意,我们可能很难通过这些老太太的、比较随机的“养生之道”,告诉人工智能研究者或相关领域的从业人员比较普适性的准则的。

张军平

2018年5月18日写于从上海去南京的高铁上

张军平教授简介

张军平教授是复旦大学计算机科学技术学院,教授、博士生导师,中国自动化学会混合智能专委会副主任。主要研究方向包括人工智能、机器学习、图像处理、生物认证及智能交通。曾于2007.9-2008.3年作为访问学者访问加州大学圣地亚哥校,2014.8-2015.8年作为访问学者和Research Associate访问宾夕法尼亚州立大学。曾主持3个国家自然科学基金、863项目和教育部博士点基金各一项,参与国家自然基金重点一项,也是973项目“数字媒体理解的理论和方法研究”的主要参加人之一。目前主持国家自然基金面上项目一项和浦江人才计划一项。张教授发表论文近100篇,包括TPAMI,TNNLS,ToC,PR,ICML,ECCV等高档次期刊和会议,学术谷歌引用2400余次。

【扫码进入德先生学术交流群,定期推送干货文章,解读学术动态,助力登顶学术科研高峰】

扫描二维码,即刻报名参与IV2018

📚往期文章推荐

🔗加拿大滑铁卢大学Amir Khajepour教授即将做客“钱学森国际杰出科学家系列讲座”

🔗还用PDF读论文你就out了:打破传统的“互动式论文”已经登上舞台

🔗Ian Goodfellow:生成对抗网络GAN的公式是怎样推导出来的

🔗【YAC2018】第33届中国自动化学会青年学术年会在南京召开

德先生公众号 | 往期精选

在公众号会话位置回复以下关键词,查看德先生往期文章!

人工智能|机器崛起|区块链|名人堂

虚拟现实|智能制造|专家智库|科技快讯

名人轶事|峥嵘岁月|专题探讨|学术活动

……

更多精彩文章正在赶来,敬请期待!

点击“阅读原文”,移步求知书店,可查阅选购德先生推荐书籍。